FlashMLA

DeepSeek开源周五大兵器

FlashMLA发布首日即引发广泛关注,通过智能调度大幅提升GPU利用率;DeepEP优化MoE模型通信效率;DeepGEMM实现高效FP8矩阵乘法,性能接近专家调优库;DualPipe+EPLB双剑合璧提升并行计算效率至30%以上;3FS文件系统进一步加速AI数据访问速度。

DeepSeek一口气开源3个项目,还有梁文锋亲自参与,昨晚API大降价

DeepSeek 发布了DualPipe和EPLB两个新工具以及训练和推理框架的分析数据,旨在帮助社区更好地理解通信-计算重叠策略和底层实现细节。

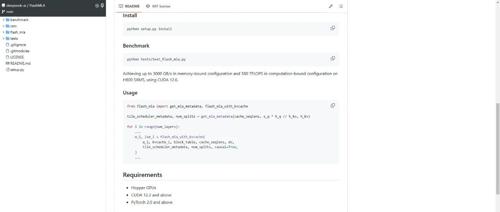

DeepSeek开源周[1]:FlashMLA,Hopper GPU推理性能狂飙

DeepSeek AI 团队发布了 FlashMLA,针对 Hopper GPU 优化的 MLA 解码内核,支持 BF16 和分页 KV 缓存,实现高达 3000 GB/s 内存带宽和 580 TFLOPS 计算性能。

FlashMLA,这是DeepSeek专为英伟达Hopper GPU打造的高效MLA解码内核

FlashMLA是DeepSeek专为英伟达Hopper GPU打造的高效MLA解码内核,已在多个配置下实现高吞吐量和峰值性能。

DeepSeek开源周Day1,硬核发布…

DeepSeek开源了FlashMLA,这是一个为Hopper GPU开发的高效MLA解码内核,已投入生产使用,支持BF16和分页KV缓存(块大小64),在H800上可实现高达580 TFLOPS的计算性能。

刚刚,DeepSeek开源MoE训练、推理EP通信库DeepEP,真太Open了!

DeepSeek 开源首个用于MoE模型训练和推理的EP通信库 DeepEP,优化高效通信和并行处理,支持FP8精度,并提供灵活资源调度。