今天是2025年02月08日,星期六,北京,天气晴。

昨天,老刘说NLP技术社区第37讲《Deepseek R1类推理大模型的习得过程、认知误区、场景机会及技术风险》 顺利结束,我们一起通读了Deeseek R1论文,回顾了推理大模型的习得过程以及一些认知上的误区,推理大模型的场景机会以及一些技术风险。

在接近2个半小时中,我们梳理出了很多有趣的东西,回放量也不错(欢迎社区成员查看全文)。

直白得说,最近Deepseek-R1受到广泛关注,开工这几天,大家大多数算法从业者都被其裹挟,开启部署以及场景脑洞等热潮,这其实引申出了许多误区。而加之这段时间的内容特别多,也特别乱,苦的是一线落地研发人员,感觉已经偏离了其技术本身的东西,所以,社区想着说,还是从技术根本逻辑出发,来看看里面的一些东西,以正视听。

其实,无论谁去讲都并不稳妥,讲的也不一定对,因为每个人的角度不一样,所看到的点也不同,大家都是更多的基于现有的一手信息源(比如论文,techreport),然后做推断。所以,大家还是辩证的去看,批判性的去看。还是干活,做出好的东西,用产品和东西说事,避免空谈,而且还有bias的。

所以,我们不好评价其技术以及其他本身(techreport已经够多了),只需来关注落地方面的事情(这是大家所关心的,要吃饭)。因此,本文也做几个简单总结,供大家一起思考。

专题化,体系化,会有更多深度思考。大家一起加油。

一、落地角度看推理类大模型的支撑逻辑与风险

现在有大批的公司或者个人在部署或者用这个,但实际上,需要考虑到风险,因为基本面并没有发生改变。o1出来都快一年了,r1是和o1的复现,其实并没有发生本质改变。

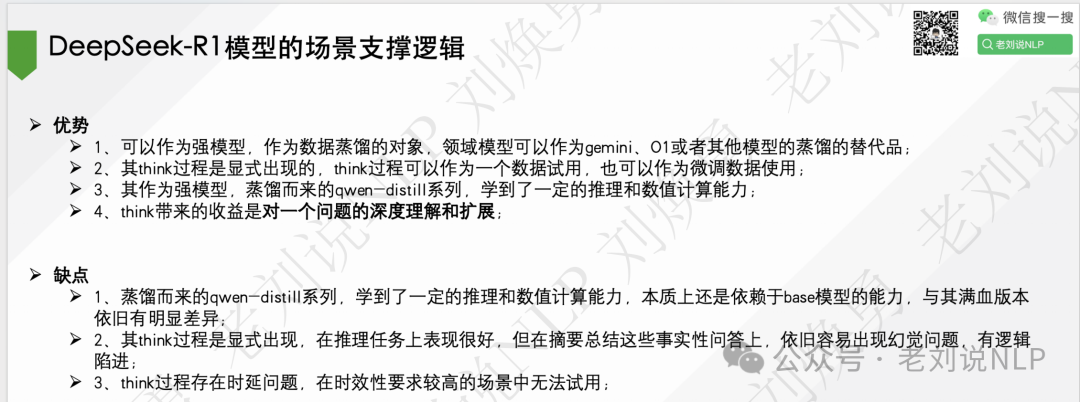

当我们谈论一个事情的时候,要从优势和缺点两个角度去看,才能更平静的对待。

在优势方面,可以作为强模型,作为数据蒸馏的对象,领域模型可以作为gemini、O1或者其他模型的蒸馏的替代品;其think过程是显式出现的,think过程可以作为一个数据试用,也可以作为微调数据使用(但这个,其实之前SFT模型其实也可以进行think);其作为强模型,蒸馏而来的qwen-distill系列,学到了一定的推理和数值计算能力;think带来的收益是对一个问题的深度理解和扩展;

所以,最直接的方式,就是去和RAG做结合,这个已经是2024年大家验证过的方案。怎么结合进去,想了下,其实有几个路可以走。例如,直接替换原有llm,利用其thinking过程,可自行reflection去噪;召回后接R1,生成think过程,或者再把答案也生成出来,然后拼接prompt,送原有llm;做成pot那种,让R1参与到agentic RAG中的步骤,利用自己的反思、规划能力,例如现在chain of rag、DeepRAG那套;或者在1或者2的基础上,去优先处理数值计算、深度分析等需要推理能力的领域,这是推理大模型的优势;但RAG 本身已经够慢了,加进去,增益是什么?是否划得来?,我们需要考虑这些问题。

在缺陷方面,蒸馏而来的qwen-distill系列,学到了一定的推理和数值计算能力,本质上还是依赖于base模型的能力,与其满血版本依旧有明显差异;其think过程是显式出现,在推理任务上表现很好,但在摘要总结这些事实性问答上,依旧容易出现幻觉问题,有逻辑陷进;think过程存在时延问题,在时效性要求较高的场景中无法试用;

这里可能会讲说,跟Agent做结合,做任务拆解会更为鲁棒。但很难办的是,它还没有改变Agent的基本面,因为其拆解的不确定性问题并没有解决。2024年,我们已经有一个很明确的结论,就是Agent本身就是workflow,taskflow,流程编排,流程编排好了,让大模型去做具体执行。

此外,虽然可以做蒸馏,但对于长尾的行业领域,其能否cover住,其实也很难讲,大家可以想想,肯定会有,领域行业R1模型的概念出来,之前都在做行业大模型。这个可以蒸馏,但很难,为啥,因为蒸馏的前提是,你的被蒸馏对象具备行业知识,它得超强。但deepseek R1是否具备行业知识,是否能cover住,很难办。所以这个时候,RAG又派上用场了,用之前RAG合成数据的套路又回来了。兜兜转转,不变始终,还是那些事儿,还是那些流程,还是那些故事,没有变化。

二、总结性看这波热潮下坚持投入的更深层次意义

做总结,总是很难得,以为我们总会有bias偏差,因为作为一个旁观者看一个已经发生的事情,其实是事后诸葛亮。但有些东西是一直有的,那就是长期主义,长期坚持。任凭外面风吹雨打,俯下身去,把事情做好,把产品做好,这总是不会错的。

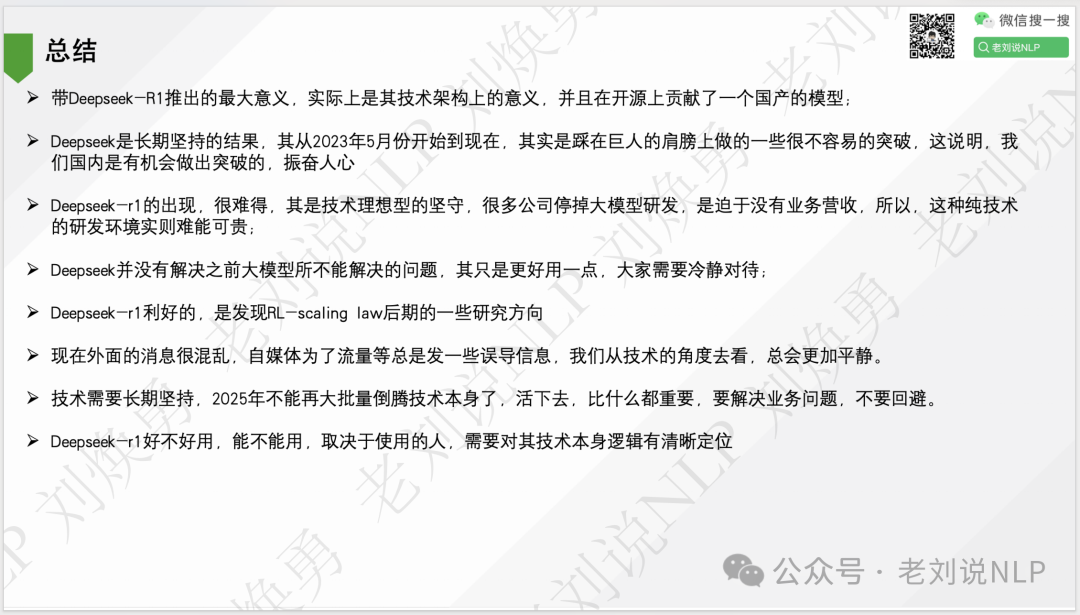

其一,Deepseek-R1推出的最大意义,实际上是其技术架构上的意义,并且在开源上贡献了一个国产的模型;

其二,是长期坚持的结果,其从2023年5月份开始到现在,其实是踩在巨人的肩膀上做的一些很不容易的突破,这说明,我们国内是有机会做出突破的,振奋人心

其三,Deepseek-r1的出现,很难得,其是技术理想型的坚守,很多公司停掉大模型研发,是迫于没有业务营收,所以,这种纯技术的研发环境实则难能可贵;

其四,Deepseek-r1并没有解决之前大模型所不能解决的问题,其只是更好用一点,大家需要冷静对待;

其五,Deepseek-r1利好的,是发现RL-scaling law后期的一些研究方向

其六,现在外面的消息很混乱,自媒体为了流量等总是发一些误导信息,我们从技术的角度去看,总会更加平静。

其七,技术需要长期坚持,2025年不能再大批量倒腾技术本身了,活下去,比什么都重要,要解决业务问题,不要回避。

其八,Deepseek-r1好不好用,能不能用,取决于使用的人,需要对其技术本身逻辑有清晰定位。

(文:老刘说NLP)