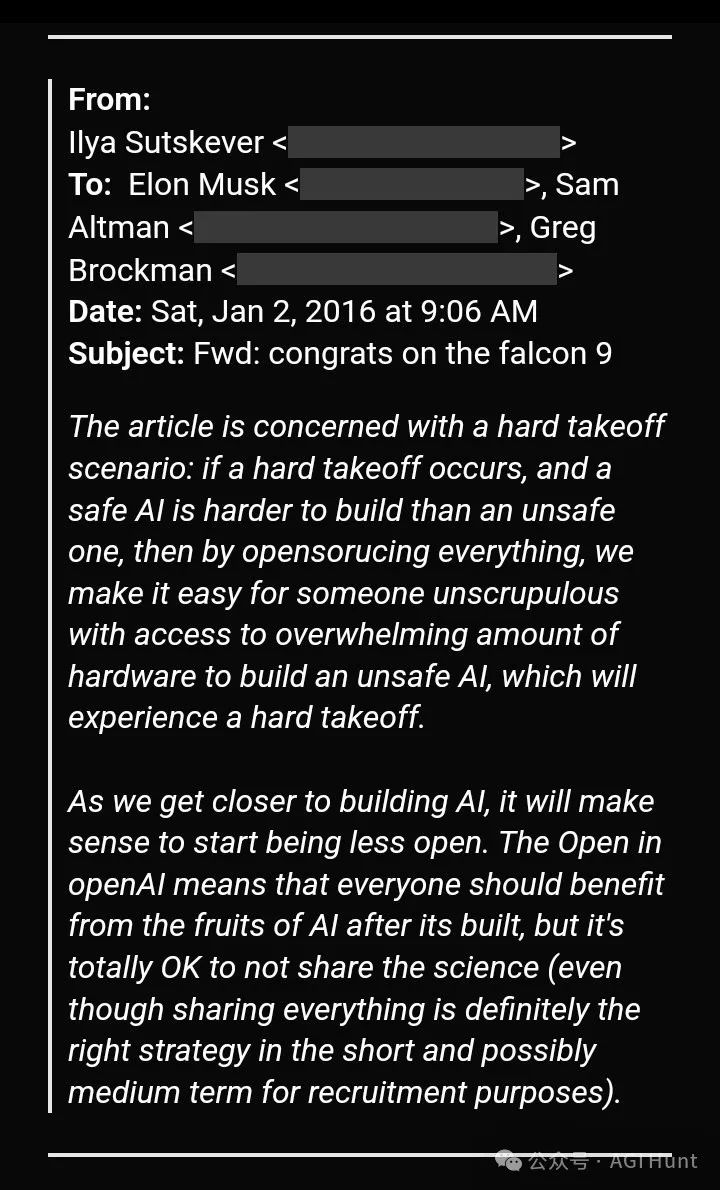

一封2016年的邮件揭示了OpenAI「开源」到「闭源」转变的幕后推手!

最近,一封来自2016年的邮件在网上流传,揭示了一个令人意外的事实:让OpenAI放弃开源路线的,居然是Ilya Sutskever和Elon Musk!

这封邮件来自Ilya Sutskever,收件人包括Elon Musk、Sam Altman和Greg Brockman。

邮件中,Ilya明确表示:

「随着我们越来越接近构建AI,减少开放是有意义的」。

开源的隐忧

在这封邮件中,Ilya提出了一个严重的担忧:如果安全的AI比不安全的AI更难构建,那么完全开源可能会带来灾难性后果。

他的逻辑是这样的:

「如果发生硬启动(hard takeoff)场景,而且构建安全的AI比不安全的AI更难,那么通过开源一切,我们可能会让一些不道德的人利用海量硬件轻松构建不安全的AI」

这种担忧似乎预见了今天的现实。

如Nicolas Serna 所说:

「开源模型经常被剥离安全措施,我们已经在野外看到了未经审查的变体。残酷的事实是:我们无法可靠地保护那些我们几乎不了解其内部机制的系统」

从理念到实践

有趣的是,这种谨慎的态度不仅体现在OpenAI身上,而是传承到了OpenAI 的「后人」们身上。

mkurman指出:

「这就是为什么SSI没有发布任何东西。他们决定尽可能保持封闭」

Ilya 本人,似乎也在用行动践行着这种理念。

有网友表示「厌倦了Ilya的这些说辞」:

安全vs 开放

ThruTheFog(@HyperSapient) 对此有更深的思考:

「他主张开源,直到AI强大到足以威胁物种。镜子中的物体比看起来更近」

事实上,Ilya在邮件中就明确表示:OpenAI中的『Open』意味着每个人都应该在AI构建完成后从中受益,但不分享科学研究是完全可以的。

这种态度在当时就引发了内部分歧。

有趣的是,虽然Elon Musk后来多次批评OpenAI 变得不再开放,但这封邮件显示,他可能早在2016年就知道这一发展趋势。

开源or 闭源?

但这种观点也引发了争议。

martin(@martin_0x029A) 认为事情没那么复杂:

事实证明,构建安全的AI其实很容易,所以没有理由不开源

Bartłomiej Skolasiński(@Bart_Skol) 则指出:

这只有在你计划分享『成果』的情况下才有意义

寻找平衡

如今,OpenAI确实如当年的Ilya 所说,逐渐减少了开放程度。不过他们仍在寻找平衡——在最近发布o3-mini 后的AMA 中Sam Altman 就坦言对未能坚持开源的遗憾。

而在DeepSeek 的冲击下,OpenAI 刚刚还开放了o3-mini 的thinking 部分过程。

Artificially Inclined™ 则趁机起哄:

「通过发布像o3-mini这样强大的模型,他们确实在逐步开放。如果能再给免费账户每月20次深度研究的机会,那就更有意义了」

想得倒是挺好……

Disarm.AGI.UBI 倒是认真地提出了自己的思考:

「超级人工智能的危险似乎仍未被明确定义。我们需要一个清晰的说明:它将如何发生,有什么危险」

透过这封OpenAI 的早期决策邮件,或许让我们看到了AI发展中「开放」与「安全」这对永恒矛盾的初始形态。

或许,我们也应该少一些对Sam Altman 的责怪。

无论你是支持开源还是赞同封闭,这些早期的思考都在今天的AI 发展中得到了印证。

而开源与闭源,也仍将继续争议不断。

最后的问题是:你支持开源还是闭源呢?

(文:AGI Hunt)

Ilya的邮件揭示了开源与安全AI之间的潜在危险,这种 early warning系统的重要性不言而喻。