昨天给小伙伴们整理了DeepSeek-R1的15个官方平替,详情看这里:DeepSeek-R1的15个官方平替,总有一个适合你!

今天我们继续。

话接上文,如何使用上稳定可靠不繁忙、不跑路、不卡顿、不截断的DeepSeek-R1是AI冲浪的一切前提。今天出一期DeepSeek-R1本地部署的手把手教程。仅需3步,低代码,尽量用最简单的方式教会你在自己的电脑上部署属于你自己的DeepSeek-R1模型。

话不多说,直接开整,集合!

第1步:安装 Ollama

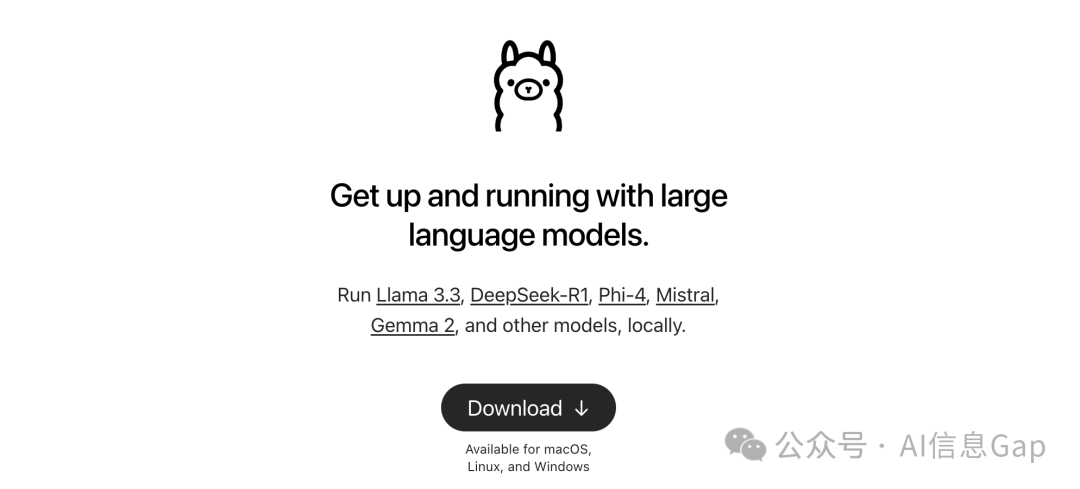

https://ollama.com/

本地部署推荐使用开源工具Ollama,对小白极其友好——既提供命令行界面,又提供图形界面,让你能够方便地管理和使用本地的AI模型。

打开上面那个Ollama官网,点击下载,按照你的电脑类型下载对应的客户端。Ollama支持macOS、Windows和Linux。

接下来的操作以macOS为例。

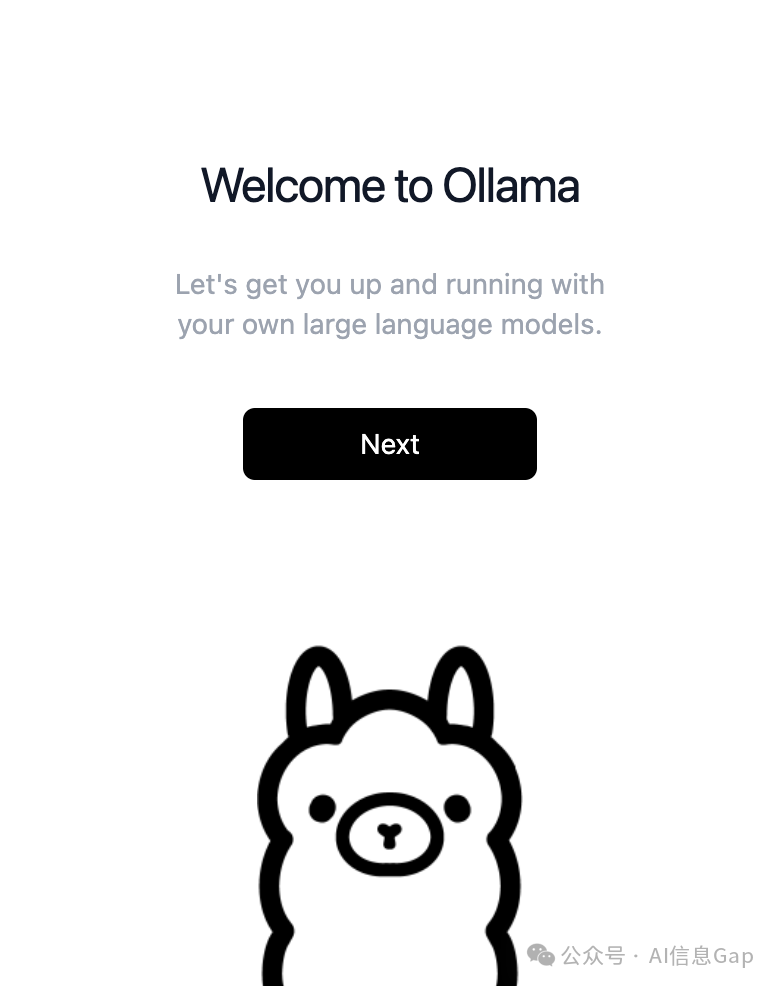

双击打开Ollama客户端安装包,点击Next。

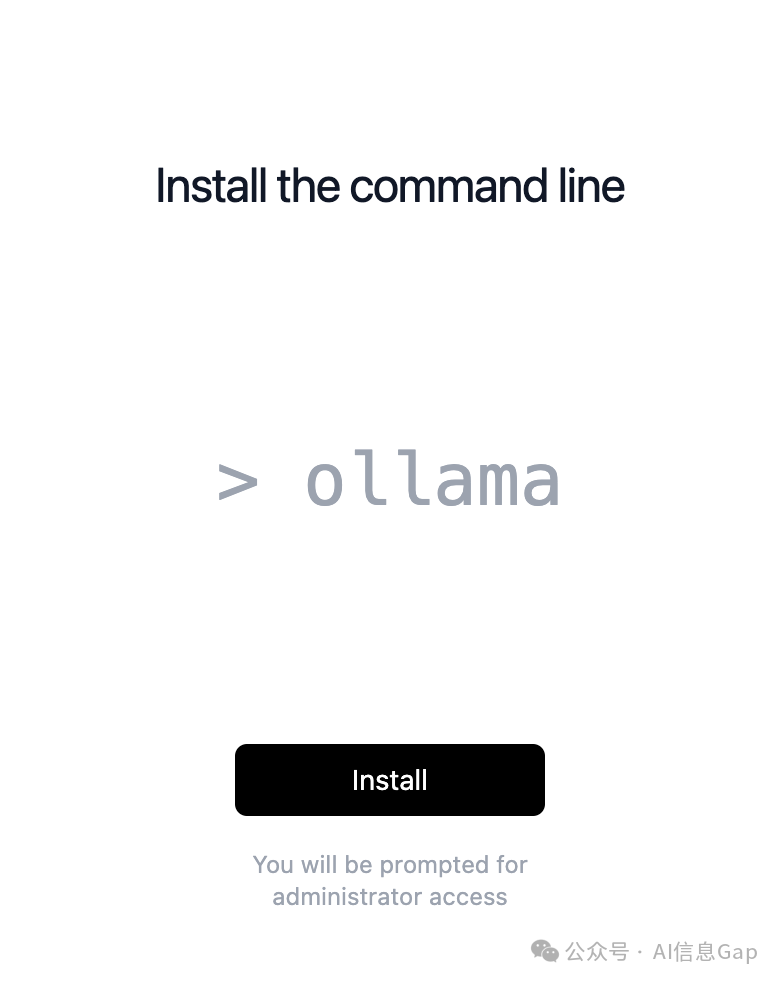

点击Install安装Ollama的命令行工具(CLI)。这一步可能会让你输入系统密码。

点击Finish,安装完成。到这里,这一步就大功告成了。

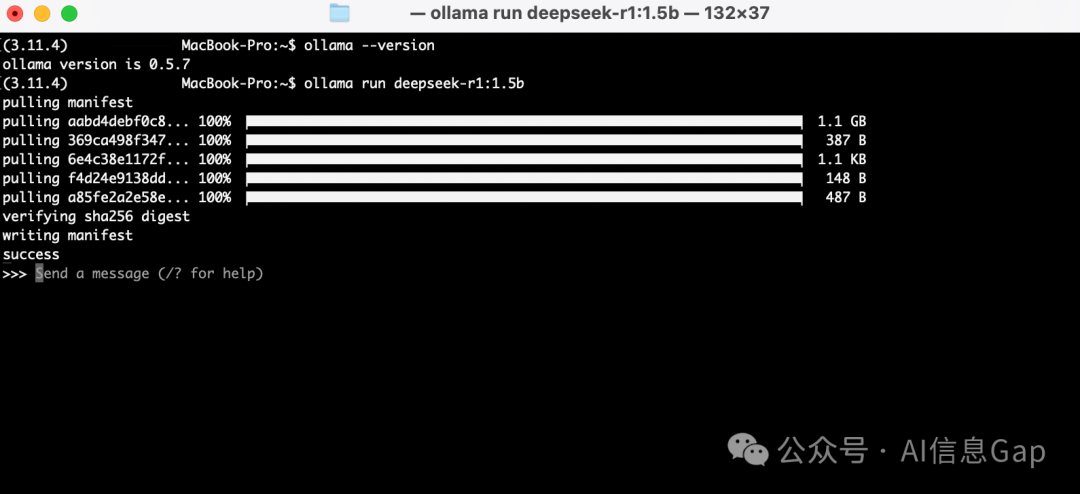

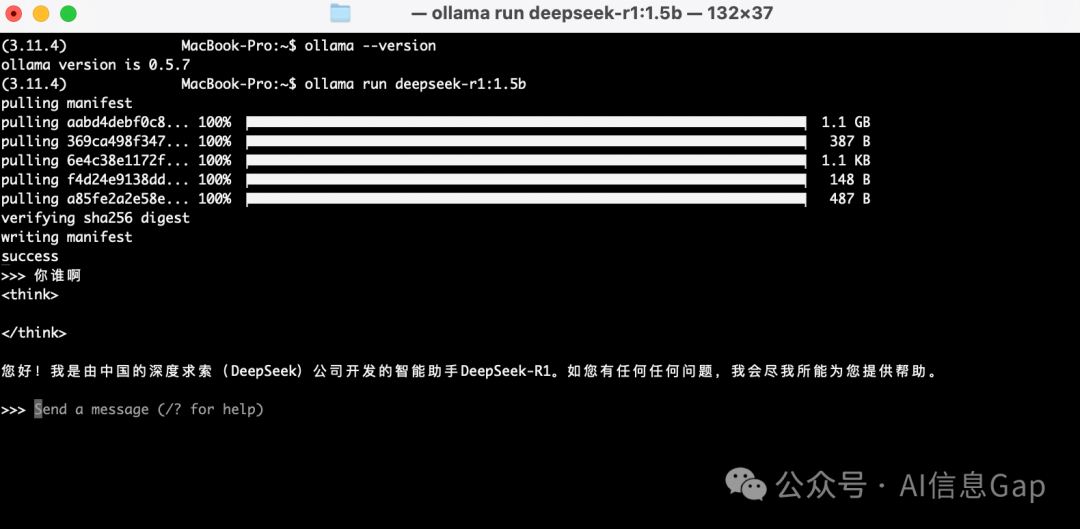

不放心的小伙伴可以双重验证一下Ollama是不是真正安装完成了。打开终端运行下面这个命令。正常来说会输出Ollama的版本号,如“ollama version is 0.5.7”。

# 验证安装

ollama --version

第2步:下载 DeepSeek-R1 模型

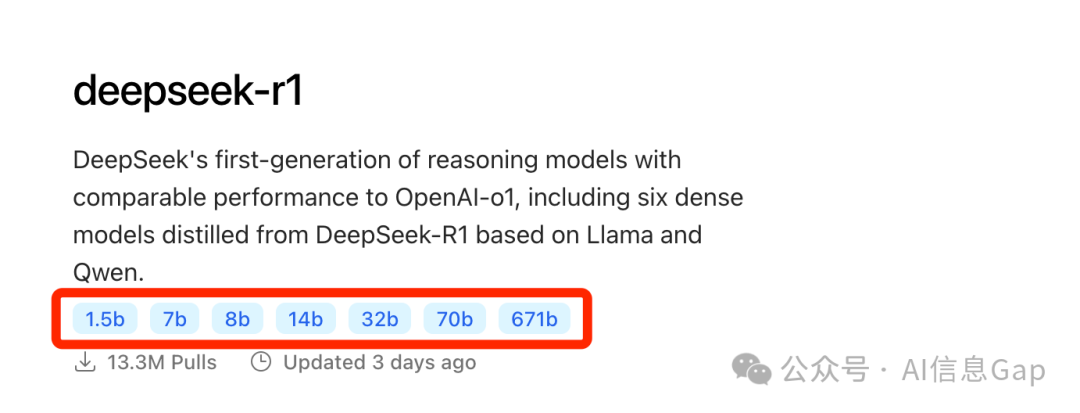

有了Ollama,就可以通过Ollama方便地下载DeepSeek-R1模型了。Ollama共提供7个不同参数量的DeepSeek-R1模型。

参数量越大,代表模型推理能力越强,满血版的DeepSeek-R1参数量为671B。

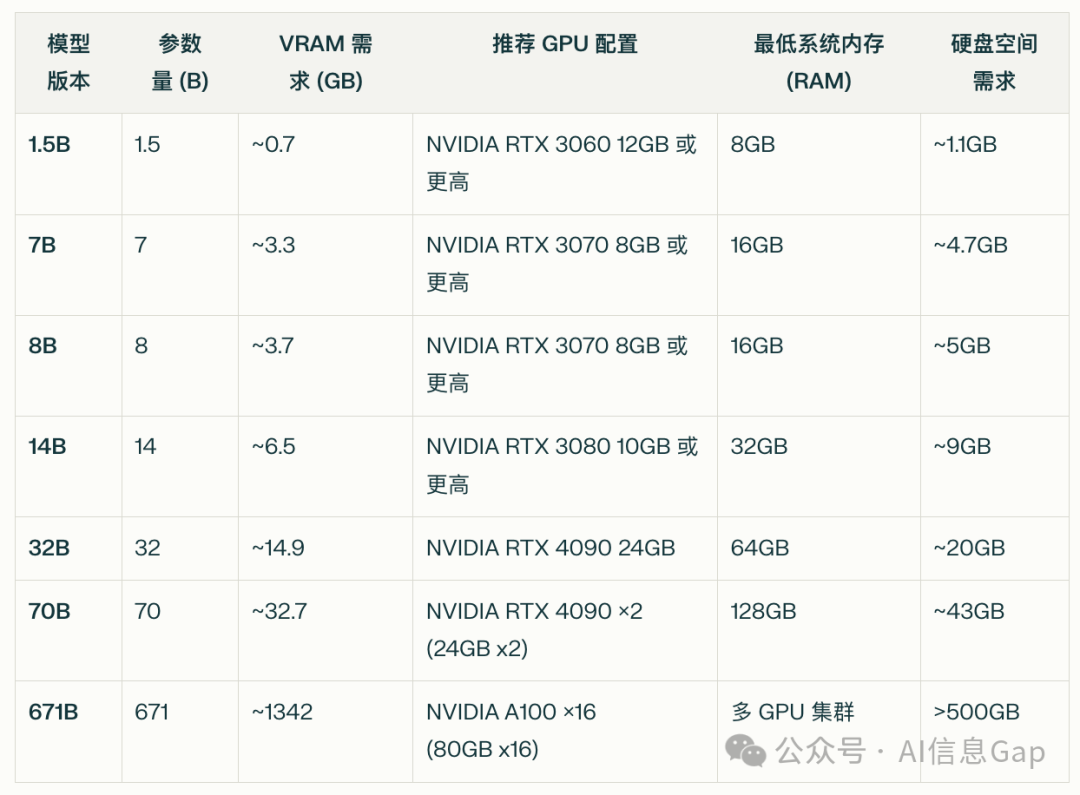

同时,每个参数量的模型所需的计算资源也各不相同,这里我总结了一份这7个模型各自所需的配置,供参考。其中,deepseek-r1:1.5b仅靠CPU也能跑起来,不放心的可以先从这个最小的模型玩起。

打开终端,输入下面这行代码下载模型。注意,把代码里的“1.5b”替换成你想要安装的模型,比如“7b”,“8b”。

# 入门推荐(1.5B,资源占用最低)

ollama pull deepseek-r1:1.5b

下载进度显示100%即完成,1.5B模型大小约1.1GB,7B模型大约4.7GB,8B为4.9GB。因为下载速度受限,我这里以1.5B模型为例。

安装完成后会自动进入模型会话模式,意味着你已经可以开始和你的专属模型聊天了!

比如下面这样。

-

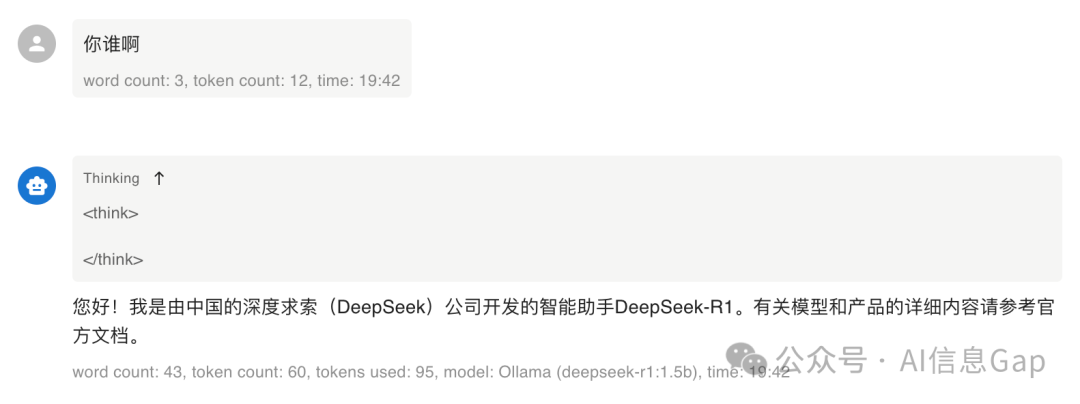

测试:你谁啊

-

回答:您好!我是由中国的深度求索(DeepSeek)公司开发的智能助手DeepSeek-R1。如您有任何任何问题,我会尽我所能为您提供帮助。

其实到这里,整个本地部署的过程就已经完成了,是不是超级简单,有手就行!

但这还只是第2步,接下来还有第3步。为什么?因为图形界面!总不能让小伙伴们一直在终端里使用DeepSeek-R1吧,我们需要一个客户端。

第3步:在Chatbox里使用本地部署的模型

https://chatboxai.app/zh

之前在《DeepSeek R1 + 个人知识库,直接起飞!》介绍过了第三方客户端Cherry Studio,今天趁着这个机会介绍另一款也很好用的客户端:Chatbox。

相比Cherry Studio,Chatbox支持的客户端类型更多更全,从桌面客户端到手机app,都支持。按照上面的Chatbox官网链接下载安装即可。

接下来重点讲怎么把部署在本地电脑上的DeepSeek-R1集成到Chatbox里使用。

打开Chatbox,点击左下角的设置,在模型提供方里找到Ollama API。API连接点直接用默认的http://localhost:11434,然后选择你安装好的DeepSeek-R1模型,比如我这里就是deepseek-r1:1.5b。最后点击保存,大功告成。

设置好,就可以和你自己部署的模型聊起来了!

写在最后

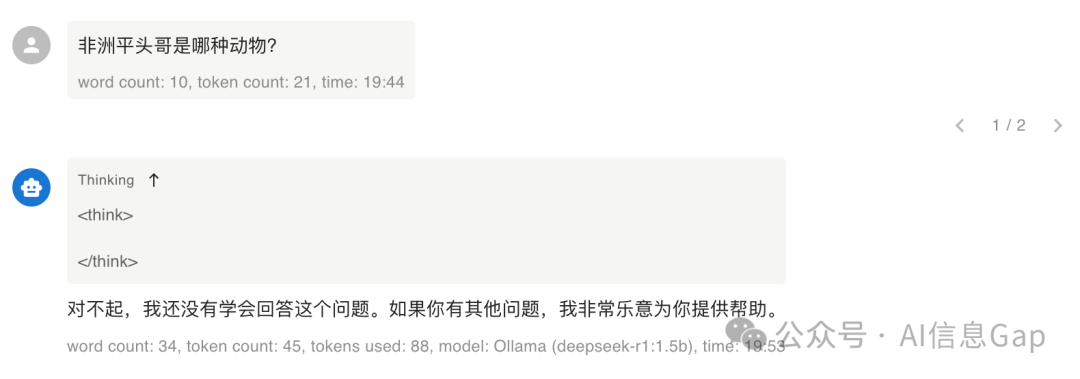

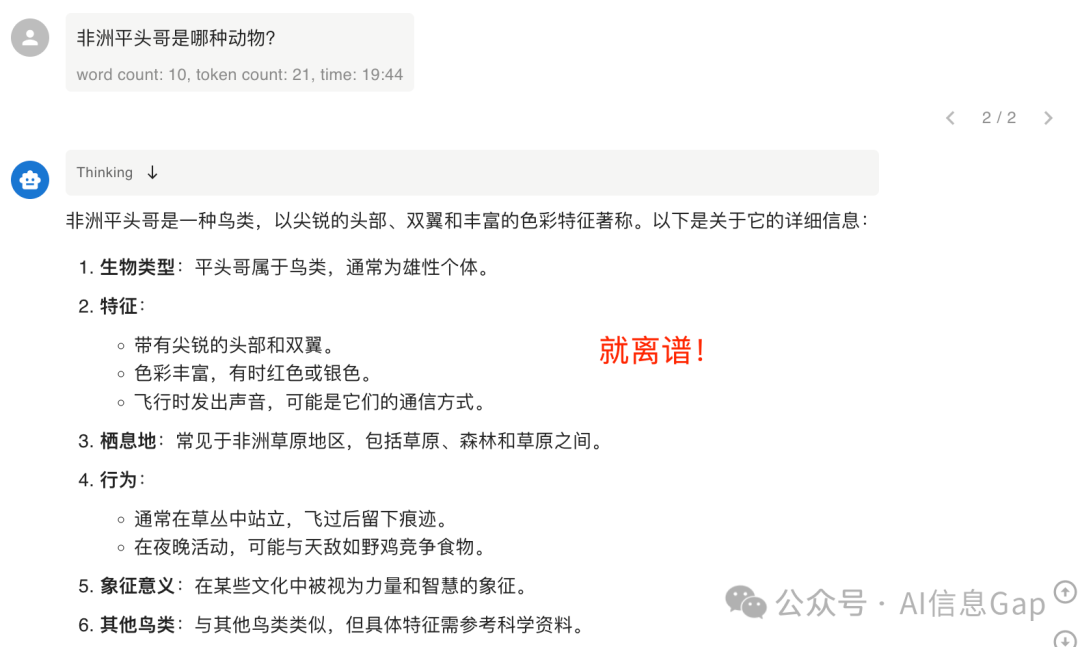

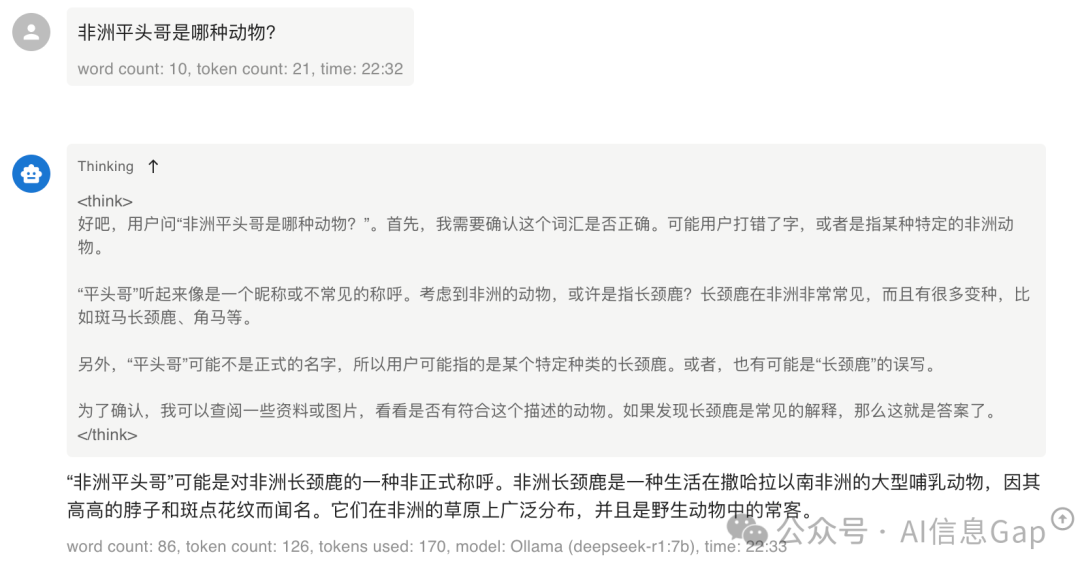

小参数模型的优势是需要的算力资源小,便于本地部署使用;但随之而来的是推理能力的“骤降”。比如下面这样。

再尝试一次,虽然能回答了,但答案属实很离谱。

写文章的过程中,我又下载安装了一个7B版本的DeepSeek-R1,思考比1.5B好了不少,但仍然回答不对“平头哥问题”。

所以,如果想要进行比较复杂的任务,比如科研、数学、代码等等,还是去寻求满血版DeepSeek-R1的API服务更合适。

如果只是进行一些普通任务,或者对数据隐私和数据安全有很高的要求,那么毫无疑问,本地部署更合适。

我是木易,一个专注AI领域的技术产品经理,国内Top2本科+美国Top10 CS硕士。

相信AI是普通人的“外挂”,致力于分享AI全维度知识。这里有最新的AI科普、工具测评、效率秘籍与行业洞察。

欢迎关注“AI信息Gap”,用AI为你的未来加速。

(文:AI信息Gap)