跳至内容

盲人科学家——Geerat J. Vermeij,他于1968年和1971年先后从普林斯顿大学和耶鲁大学获得学士及博士学位;1992年荣获麦克阿瑟“天才奖”(MacArthur Fellow);2000年荣获美国科学院颁发的“Daniel Giraud Elliott” 奖。从他的励志故事中我们看见了视障人士在科研道路的艰辛与不易。

在当今社会,信息获取和知识传播已成为推动个人成长与社会进步的重要工具。尽管信息技术的飞速发展使知识获取的途径变得多元,但在某些特定人群中,特别是对于视障人士来说,知识的获取仍然面临诸多挑战。盲文作为视障人士阅读与学习的主要方式,其学习与教学方法亟待创新与改进。

近期,方斌教授团队发表的A braille detection system based on visuo-tactile sensing一种基于视觉触觉传感的盲文检测系统论文,提出了一种指尖形视觉-触觉传感器 TIRgel 2.0,并集成交互式盲文教学系统,优化了盲文信息提取和交互体验。研究基于全内反射(TIR)机制,提升触觉特征的光学对比度,从而降低盲文识别难度。通过 静态与动态检测算法结合 大语言模型(LLM),提高了检测准确性(>95%),减少了重复识别,并能对翻译结果进行语义纠正和解释。该系统为盲文教学、触觉交互与智能感知 领域提供了新的技术方案,有助于提升视觉-触觉传感器(VTS) 在辅助盲人学习中的应用价值。

a. 系统设计与模块化:VTS TIRgel 2.0系统包含多个功能模块,包括语音模块、触觉传感模块和大型语言模型。每个模块都承担着不同的功能,以确保系统的多样性和灵活性。

b. 互动教学机制:通过语音模块设计人机交互方式,用户可以通过语音命令与系统进行交流,选择学习内容和模式。系统根据用户需求进行智能响应,提升参与感和学习动机。

c. 触觉反馈:触觉传感模块结合了静态和动态检测算法,根据用户的触摸输入进行实时反馈。这一设计在提高识别稳定性和减少重复识别方面发挥了重要作用。

d. 使用大型语言模型:针对盲文翻译过程中常见的重复、遗漏和错误问题,本研究引入了大型语言模型来优化翻译质量和用户体验。该模型能够根据上下文对用户的输入进行理解和纠正,为学习者提供即时、准确的反馈。

图 1. 交互式教学系统流程图。该系统由语音模块(控制系统的模式转换和教学功能)、触觉传感模块(支持教学和翻译模式下的静态和动态检测)和 LLM 模块(对翻译结果进行纠正和解释)组成。

在降低对比度和曝光后,盲文和背景之间的差异进一步突出。我们使用RGB通道的差异作为阈值来分离接触区域。然后,使用Hough圆变换检测圆点并定位圆心。对于VTS,每一帧都伴随着盲文检测。在这项工作中,我们使用帧差算法和最小中心距离算法来防止重复识别的问题和检测波动。

帧差异算法:我们计算两幅图像之间的每像素差,利用平均值来判断两幅图像之间的平均变化程度,同时将平均差与设定的阈值进行比较。当小于阈值时,图像变化稳定。之后,系统执行检测和平移操作。

最小中心距离算法:我们计算两帧之间所有检测到的点的最小中心距离,以定量表示运动趋势,利用小阈值设置来跟踪抖动状态。当达到相对静止状态时,系统暂时停止盲文检测,减少了由于背景噪声或小范围振动造成的误识别。

基于上述算法,系统仅在图像稳定后的瞬间检测盲文。随后的轻微抖动不会触发检测操作,以确保每个盲文仅检测一次。

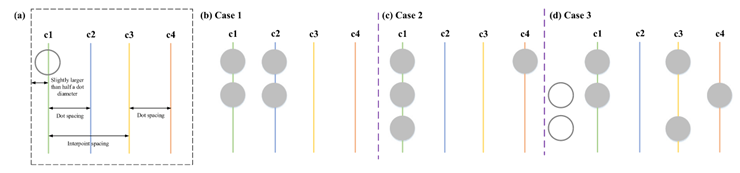

动态检测面临两个挑战:盲文字母的连续跟踪和重复识别。首先,将所有盲文字母按x坐标排序,以计算它们的中心距离。然后,根据点和点间距对盲文字母进行分组。每个已处理的组被标记为一个序列,以区分未处理的组。接下来,同一组的盲文字母基于x坐标分为两列。每列的最小y坐标用作锚点,以确定盲文字母的位置。最后,根据编码规则对盲文进行编码并存储在字典中。为了减少重复识别,我们设置了四列阈值线c1、c2、c3、c4来控制检测状态。在图7中,根据相邻两组盲文字母的空间关系(C1-C2和C3-C4除以点距离,C1-C3除以点间距)设置阈值线,其中加入波动范围以应对图像检测的噪声。c1和c2在图像的左侧区域中,用于处理当前检测的组。c3和c4在图像的右侧区域,以限制输出条件并处理下一组。

图2. 监测状态限制的阈值线。(a)根据相邻两组盲文字母的空间关系设置阈值线,其中C1-C2和C3-C4除以点距离,C1-C3除以点间距。(b)当在c1和c2中检测到盲文时,系统确定c1和c2是同一组的第一列和第二列。(c)当在c1和c4中检测到盲文而在c2中未检测到盲文时,系统确定c1是盲文组的第一(仅)列。(d)当在c1和c3中检测到盲文而在c2中未检测到盲文时,系统确定c1是盲文组的第二列。

当盲文字母满足情况1和2时,系统将继续在阈值区间内执行检测和翻译操作。因此,我们使用flag(flag=0)在单次成功检测后锁定系统,以避免重复转换。当系统在c3中重新检测到新的盲文字母时,标志被设置为1以激活系统检测和翻译功能。

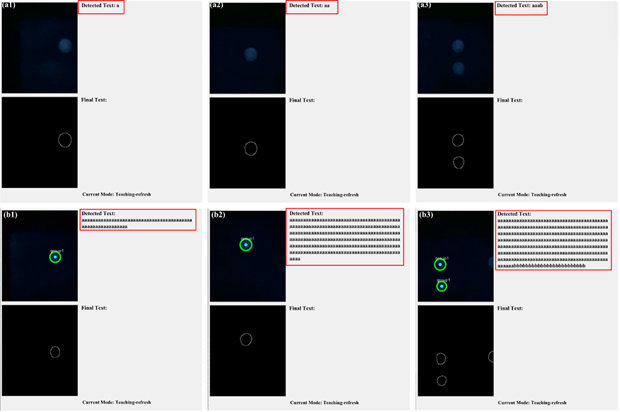

我们测试了所提出的静态检测和常规检测算法。在教学模式下,TIRgel 2.0在按下盲文板后仍保持相对稳定。如图8所示,传统的检测算法不限制检测次数和运动状态,并且默认为针对每一帧重复检测-平移的操作。从可视化界面可以看出,单个字母被重复识别,直到TIRgel 2.0与盲文板脱离接触。提出的静态检测算法可以固定盲文字母的识别状态,在预设范围内不受接触波动的影响。当大范围移动或重新接触时,静态检测算法才会实现新一轮的检测操作。

图3.(a)和(b)呈现了静态检测和常规检测的检测效果。(a1)TIRgel 2.0按压盲文板并保持相对稳定。静态检测仅检测盲文一次。(a2)在移动期间,静态检测保持在原来的检测状态。(a3)与另一盲文接触后,静态检测开始新一轮检测。相比之下,即使检测到新的盲文(b3),常规检测也继续输出检测结果((b1)和(b2))。

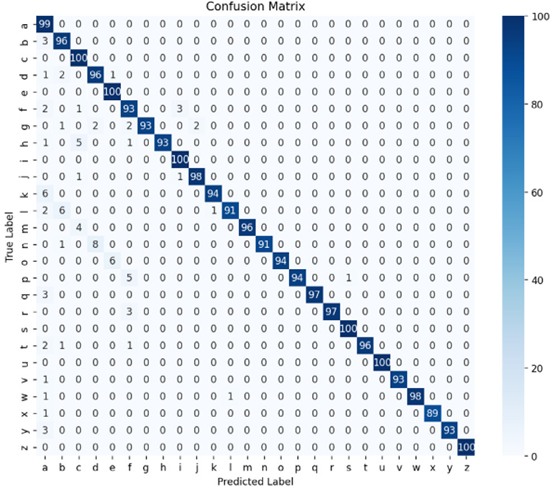

常规检测依赖于多次检测来确定结果。静态检测算法虽然避免了重复检测,但对检测精度提出了更高的要求。为了测试静态识别的准确性,我们为每个字母手动收集了100个触觉图像,总共2600个图像。随机数据采集可以尽可能再现静压情况。在检测之后,我们生成混淆矩阵并分析误差源(在图10中)。错误集中在丢失部分盲文触觉信息的弱接触样本中,导致不正确和无效的翻译。图10中未标记错误源的样本是无效翻译。结果表明,总体识别准确率大于95%,高于文献[29]中目标检测算法的准确率(87.5%)。在不考虑无效结果的情况下,静态检测准确率可达96.7%。我们认为涂层型VTS下盲文字母的形态和颜色特征在滑动检测过程中变化不规则,因此深度学习方法很难保证准确提取每帧中的所有盲文字母。TIRgel 2.0在接触区域和背景之间产生显著差异,以降低接触信息提取的难度,从而提高检测准确性。

图4 静态检测结果混淆矩阵。总体准确率在95%以上。主要误差来自于由于压力不足而导致触觉信息不清晰的样品。

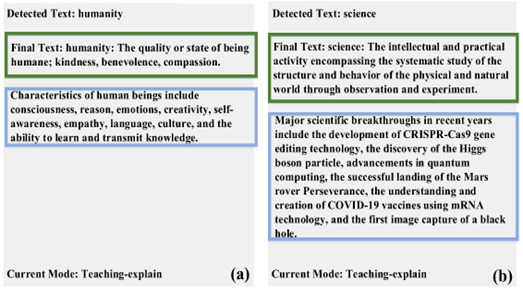

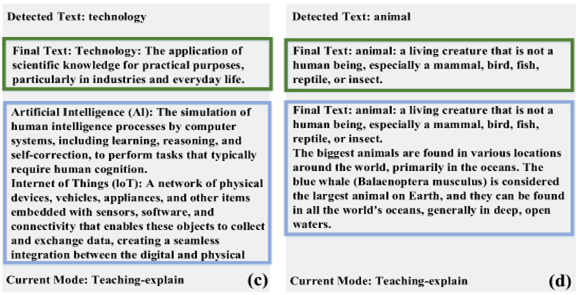

讲解功能对于加深用户对盲文的理解至关重要。本节选择几个有代表性的词来演示交互系统的解释功能,如“人性”、“科学”、“技术”、“动物”和“创新”(在图12中)。界面可视化解释结果,如绿色框所示,然后语音模块播放它们。用户可以根据对解释的理解与系统进行交互,例如”人类的特征是什么?”,”近年来有哪些重大科学突破?”,”最新的技术发展是什么?最大的动物在哪里?”和”创新的意义是什么?’’.系统回答用户的问题,如蓝框所示,回复内容真实详细。正如LLM在生成式内容创作上独具优势,结合语音交互,其教学特色进一步凸显。

图5 可视化界面显示的说明测试结果。我们以“人类”、“科学”、“技术”、“动物”和“创新”作为测试样本((a)-(e)),并通过语音模块与系统交互。系统提供解释(绿色框)并回答我们的问题(蓝色框)

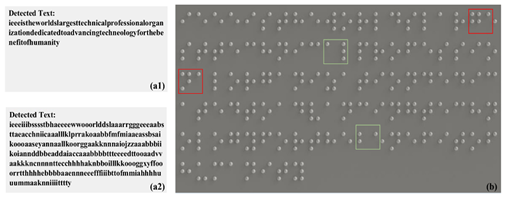

在盲文板上,我们用英文盲文((IEEE

is the world’s largest technical professional

organization dedicated to advancing technology for the benefit of humanity.)作为动态检测测试样本。接下来,本节以静态检测算法为参考,验证动态检测算法对减少重复识别的有效性。前面我们证明了静态检测算法在稳态压力下的识别稳定性。然而,在滑动检测期间,盲文字母移动超出了用于目标运动的静态检测算法的限制。该条件刺激静态检测算法执行新一轮的连续检测操作。在图6(a2)中,可视化界面示出了重复识别相同的盲文,直到出现下一个盲文。因此,我们为教学和翻译模式下的两种检测算法开发了盲文检测模块。结果表明,动态检测算法显著减少了识别重复(在图6(a1)中)。动态检测算法也存在部分重复识别的现象,因为弹性体与盲文板的相对滑动产生阻力,导致用户推动TIRgel 2.0时出现局部往复运动。最初,动态检测算法假设VTS仅执行单向滑动,因此不涉及波动情况。这个问题需要LLM提供辅助校正。

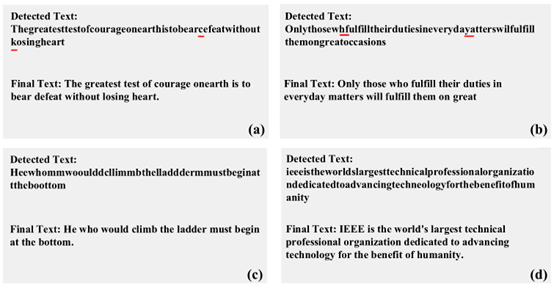

图7示出了LLM模块处理翻译结果。LLM根据上下文语义信息对单词进行重新分类并重组句子。基于先验知识,预测缺失信息,修正错误信息。因此,输出是一个完整的句子,其中不正确/缺失的字母被纠正/补充,并且重复的翻译被去除。

图7. 翻译纠正测试结果。(a)和(b)盲文字母的遗漏检测导致的翻译错误和失败。(c)重复检测。(d)翻译结果不是句子。LLM模块有效地解决了上述问题。

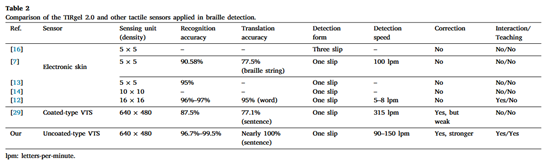

TIRgel 2.0与其他触觉传感器在盲文检测中的应用比较。

本文提出的 TIRgel

2.0 是一种便携式、可穿戴的指尖形 视觉-触觉传感器(VTS),结合 全内反射(TIR)机制 和 智能交互系统,优化了盲文信息提取和交互体验。研究表明,该系统在静态检测模式下,通过 帧差算法和最小中心距离算法,有效避免了重复识别,识别准确率达到 95%以上,明显优于传统深度学习方法(如 YOLO V8 的 87.5%)。在 动态检测模式下,通过滑动检测与四列检测阈值策略(c1、c2、c3、c4),减少了滑动过程中盲文字符的重复识别和误识别。此外,系统集成的大语言模型(LLM) 能够有效修正 检测遗漏、重复翻译和语法混乱 等问题,提高翻译准确性和语义理解能力。

实验表明,TIRgel 2.0 可实现 100-150 字母/分钟 的盲文检测速率,适用于盲文教学、辅助阅读等场景。相比于电子皮肤传感器需要多次滑动检测、传统 VTS 识别稳定性差等问题,TIRgel 2.0 通过硬件结构优化和智能算法提升,提供了一种更稳定、高效的触觉-视觉融合盲文识别方案,为触觉感知、智能交互和盲人辅助学习领域提供了新的技术支撑。

该成果参加2024世界机器人大赛共融机器人挑战赛,获得了创新创意组的三等奖。未来研究将进一步优化检测速率,提高语音交互的鲁棒性,并探索更广泛的应用场景。

文献:Shixin Zhang, Jiatong Du, Yuhao

Sun, Fuchun Sun, Huaping Liu, Yiyong Yang, Bin Fang, A braille detection system

based on visuo-tactile sensing, Measurement, Volume 247,2025,116827, ISSN

0263-2241,

https://doi.org/10.1016/j.measurement.2025.116827

通讯作者邮箱:fangbin1120@bupt.edu.cn

(文:机器人大讲堂)