极市导读

本文撰写路径比较清晰,意在初步梳理DeepSeek技术的演进及进化之路,主要包括三大方向:大语言模型、视觉语言理解模型、多模态统一模型。 >>加入极市CV技术交流群,走在计算机视觉的最前沿

写在前面

-

大语言模型系列论文:DeepSeek-LLM -> DeepSeek-V2 -> DeepSeek-V3 -> DeepSeek-R1 -

视觉语言理解模型系列论文包括:DeepSeek-VL -> DeepSeek-VL2 -

多模态统一模型系列论文包括:JanusFlow -> Janus -> Janus-Pro

关于本文的迭代更新版本将放在知乎上

猫先生知乎主页:https://www.zhihu.com/people/m_aigc2022/posts

正文开始

大语言模型技术演进:DeepSeek-LLM、DeepSeek-V2、DeepSeek-V3、DeepSeek-R1

-

初始阶段: DeepSeek LLM通过扩展模型规模和引入多阶段训练,提升了模型在多个领域的表现。 -

MoE架构引入: DeepSeek-V2引入MoE架构,通过MLA和DeepSeekMoE实现高效推理和经济训练。 -

高性能和经济性: DeepSeek-V3进一步扩展模型规模,引入多令牌预测和无辅助损失的负载均衡策略,实现了更高的性能和更低的训练成本。 -

推理能力提升: DeepSeek-R1通过强化学习和冷启动数据,显著提升了模型的推理能力,并通过蒸馏技术将推理能力扩展到小型模型。

DeepSeek LLM

论文题目:《DeepSeek LLM:Scaling Open-Source Language Models with Longtermism》

发表时间:2024年1月

论文地址:https://arxiv.org/pdf/2401.02954v1

在2024年1月前后的时间,基于解码器的Transformer大型语言模型(LLMs)的发展迅速,成为实现人工智能(AGI)的重要途径。尽管闭源产品如ChatGPT、Claude和Bard在计算资源和标注成本上具有优势,但开源LLMs的性能仍需提升。

本项目主要探索模型的缩放定律(scaling laws),并在两个广泛使用的模型配置(7B和67B)上进行扩展。通过预训练、监督微调(SFT)和直接偏好优化(DPO),提升模型在代码、数学和推理等领域的性能。

scaling laws:即模型性能与其规模(如参数数量)、训练数据集大小以及用于训练的计算资源之间存在的一种可预测的关系。这种关系通常表现为随着这些因素的增长,模型性能会按照一定的幂律进行改善。

DeepSeek LLM 67B在一系列基准测试中超越了LLaMA-2 70B,特别是在代码、数学和推理领域表现突出。此外,开放式评估揭示出DeepSeek LLM 67B聊天模型与GPT-3.5相比展现出更优的性能。

方法概述

DeepSeekLLM,旨在通过长期视角推动开源语言模型的发展。

数据收集与预处理: 首先,开发了一个包含2万亿token的数据集,并对其进行去重、过滤和重新混合。去重阶段通过跨多个dump进行去重,过滤阶段通过详细的语义和语言学评估来增强数据密度,重新混合阶段则通过增加代表性不足领域的存在来平衡数据。

模型架构: DeepSeek LLM的微观设计主要遵循LLaMA的设计,采用Pre-Norm结构和RMSNorm函数,使用SwiGLU作为前馈网络的激活函数。宏设计上,DeepSeek LLM 7B有30层,而67B有95层,以优化训练和推理。

超参数选择: 初始标准差为0.006,使用AdamW优化器,超参数为_β_1=0.9,_β_2=0.95,权重衰减为0.1。采用多步学习率调度器,学习率在2000个预热步后达到最大值,然后逐步降低。

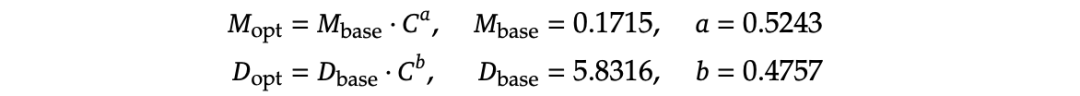

缩放定律: 通过实验建模了计算预算C与最佳批量大小和学习率之间的幂律关系,公式如下:

模型和数据缩放: 采用IsoFLOP剖面方法拟合扩展曲线,公式如下:

DeepSeek-V2

论文题目:《DeepSeek-V2: A Strong, Economical, and Efficient Mixture-of-Experts Language Model》

发表时间:2024年5月

论文地址:https://arxiv.org/pdf/2405.04434v5

在2024年5月前后的时间,大语言模型(LLMs)的快速发展,展示了人工智能(AGI)的曙光。然而,随着参数量的增加,模型的智能提升带来了更大的计算资源需求和推理吞吐量的潜在下降,限制了LLMs的广泛应用。

本项目主要目标是解决LLMs在训练和推理过程中资源消耗大的问题,通过创新架构(包括多头潜在注意力(MLA)和DeepSeekMoE)实现经济高效的训练和高效的推理。

方法概述

DeepSeek-V2,一种强大的MoE语言模型,通过创新的架构实现了经济和高效的训练和推理。

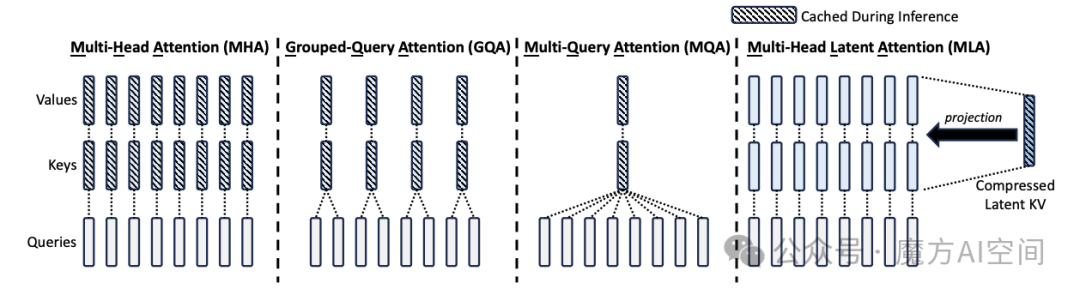

多头潜在注意力(MLA): 一种新的注意力机制,通过低秩键值联合压缩来显著减少推理时的键值缓存,从而提高推理效率。MLA的计算过程如下:

-

标准多头注意力(MHA) 首先通过三个矩阵计算查询(q)、键(k)和值(v):

-

然后,将q、k、v切片成多个头进行多头注意力计算:

-

最后,通过softmax函数计算权重并进行加权和:

-

MLA通过低秩联合压缩键值对:

DeepSeekMoE: 通过细粒度的专家分割和共享专家隔离来实现更高效的模型训练。DeepSeekMoE的基本思想是将专家分割成更细的粒度以提高专家的专业化,并通过隔离一些共享专家来缓解路由专家之间的知识冗余。具体计算过程如下:

-

对于每个token,计算其FFN输出:

-

通过设备限制路由机制来控制MoE相关的通信成本,确保每个token的专家分布在最多M个设备上。 -

设计了三种辅助损失来控制专家级负载平衡、设备级负载平衡和通信平衡。 -

采用设备级token丢弃策略来进一步缓解计算浪费。

DeepSeek-V3

论文题目:《DeepSeek-V3 Technical Report》

发表时间:2024年12月

论文地址:https://arxiv.org/pdf/2412.19437v1

近年来,大语言模型(LLMs)的快速发展,逐步缩小了向人工智能(AGI)迈进的差距。除了闭源模型外,开源模型如DeepSeek系列、LLaMA系列、Qwen系列和Mistral系列也在努力缩小与闭源模型的差距。

DeepSeek-V3,一个具有671B总参数的MoE语言模型,采用多头潜在注意力(MLA)和DeepSeekMoE架构(在DeepSeek-V2中已得到充分验证,展示了其在保持强大模型性能的同时实现高效训练和推理的能力),并引入无辅助损失的负载均衡策略和多令牌预测训练目标以提高性能。

方法概述

DeepSeek-V3,自研 MoE 模型,671B 参数,激活 37B,在 14.8T token 上进行了预训练,用于解决大语言模型的高效推理和训练问题。

-

多头潜在注意力(MLA): MLA架构通过低秩联合压缩注意力键和值来减少推理过程中的KV缓存,从而提高推理效率。 -

DeepSeekMoE架构: DeepSeekMoE架构使用细粒度的专家并行和隔离一些专家作为共享专家,以提高训练效率。 -

无辅助损失的负载均衡策略: 为了最小化辅助损失对模型性能的影响,提出了一种无辅助损失的负载均衡策略,通过引入偏置项来动态调整专家负载。其公式如下:

-

多令牌预测(MTP)目标: 通过在每个位置预测多个未来token,增加训练信号的密度,从而提高模型性能。其训练目标如下:

性能对齐

DeepSeek-V3 多项评测成绩超越了 Qwen2.5-72B 和 Llama-3.1-405B 等其他开源模型,并在性能上和世界顶尖的闭源模型 GPT-4o 以及 Claude-3.5-Sonnet 不分伯仲。

-

百科知识: DeepSeek-V3 在知识类任务(MMLU, MMLU-Pro, GPQA, SimpleQA)上的水平相比前代 DeepSeek-V2.5 显著提升,接近当前表现最好的模型 Claude-3.5-Sonnet-1022。 -

长文本: 在长文本测评中,DROP、FRAMES 和 LongBench v2 上,DeepSeek-V3 平均表现超越其他模型。 -

代码: DeepSeek-V3 在算法类代码场景(Codeforces),远远领先于市面上已有的全部非 o1 类模型;并在工程类代码场景(SWE-Bench Verified)逼近 Claude-3.5-Sonnet-1022。 -

数学: 在美国数学竞赛(AIME 2024, MATH)和全国高中数学联赛(CNMO 2024)上,DeepSeek-V3 大幅超过了所有开源闭源模型。 -

中文能力: DeepSeek-V3 与 Qwen2.5-72B 在教育类测评 C-Eval 和代词消歧等评测集上表现相近,但在事实知识 C-SimpleQA 上更为领先。

DeepSeek-R1

论文题目:《DeepSeek-R1: Incentivizing Reasoning Capability in LLMs via Reinforcement Learning》

发表时间:2025年1月

论文地址:https://arxiv.org/pdf/2501.12948v1

近年来,大语言模型(LLMs)的快速发展,逐渐缩小了与通用人工智能(AGI)的差距。推理能力作为LLMs的重要组成部分,通过后训练(post-training)可以显著提高模型在各种任务上的表现。然而,如何在不依赖监督数据的情况下提升模型的推理能力仍然是一个挑战。

本文主要研究内容:通过纯强化学习(RL) 提升LLMs的推理能力,特别是通过DeepSeek-R1-Zero和DeepSeek-R1两个模型来实现这一目标。DeepSeek-R1-Zero是通过大规模RL训练而不依赖于监督微调(SFT)的初步模型,而DeepSeek-R1则结合了多阶段训练和冷启动数据来进一步提升性能。

DeepSeek团队已将 DeepSeek-R1-Zero、DeepSeek-R1 以及基于 Qwen 和 Llama 从 DeepSeek-R1 蒸馏出的六个密集模型(1.5B、7B、8B、14B、32B、70B)开源。

方法概述

DeepSeek-R1系列模型,通过大规模强化学习和多阶段训练来提高LLMs的推理能力。

DeepSeek-R1-Zero: 该模型直接对基础模型进行强化学习训练,不依赖任何监督微调数据。采用Group Relative Policy Optimization(GRPO)算法进行优化,公式如下:

DeepSeek-R1: 该模型在DeepSeek-R1-Zero的基础上,引入冷启动数据和多阶段训练管道。具体步骤包括:

-

收集数千条冷启动数据,用于微调基础模型。 -

在冷启动数据微调后的模型上进行推理导向的强化学习。 -

通过拒绝采样和SFT生成新的SFT数据,并结合DeepSeek-V3的监督数据进行再训练。 -

最终通过额外的RL过程,结合所有场景的提示,得到DeepSeek-R1模型。

蒸馏小模型超越 OpenAI o1-mini: 从DeepSeek-R1中蒸馏推理能力到更小的密集模型。使用Qwen2.5和Llama系列模型作为基础模型,通过简单的SFT蒸馏方法显著提升推理能力。

性能对齐 OpenAI-o1 正式版

DeepSeek-R1 在后训练阶段大规模使用了强化学习技术,在仅有极少标注数据的情况下,极大提升了模型推理能力。在数学、代码、自然语言推理等任务上,性能比肩 OpenAI o1 正式版。

视觉语言大模型技术演进:DeepSeek-VL、DeepSeek-VL2

DeepSeek-VL

论文题目:《DeepSeek-VL: Towards Real-World Vision-Language Understanding》

发表时间:2024年3月

论文地址:https://arxiv.org/pdf/2403.05525v2

大语言模型(LLMs)的成功推动了多模态模型的需求,这些模型能够处理多种模态的信息,如视觉和语言。现有的多模态模型在基准测试中表现良好,但在现实世界的应用中仍存在差距。开源模型在现实世界性能和用户体验方面与专有模型存在显著差距。

DeepSeek-VL,旨在通过数据构建、模型架构和训练策略来提高模型在现实世界中的应用性能。设计一个能够在现实世界场景中进行视觉-语言理解的模型。

方法概述

DeepSeek-VL,用于解决视觉语言理解问题。

数据构建: 数据集分为视觉语言预训练数据和视觉语言监督微调数据。预训练数据来自多个公共数据源,包括MMC4、Wiki、wikihow、Ebook教科书、Capsfusion、TaiSu和Detailed Caption等。微调数据则包括ShareGPT4V、LAION-GPTV、LVIS-Instruct4V等开源数据集,以及部分表格和图表数据。

模型架构: 系统包含三个模块:混合视觉编码器、视觉适配器和大语言模型。混合视觉编码器结合了SAM-B和SigLIP-L两个编码器,分别处理高分辨率和低分辨率图像。视觉适配器通过两层混合MLP连接视觉编码器和LLM。大语言模型基于DeepSeek LLM,采用Pre-Norm结构和SwiGLU激活函数。

训练流程: 训练分为三个阶段:视觉语言适配器预热、联合视觉语言预训练和监督微调。在第一阶段,仅训练视觉语言适配器;在第二阶段,联合优化语言模型和视觉适配器;在第三阶段,使用监督数据进行微调。

DeepSeek-VL2

论文题目:《DeepSeek-VL2: Mixture-of-Experts Vision-Language Models for Advanced Multimodal Understanding》

发表时间:2024年12月

论文地址:https://arxiv.org/pdf/2412.10302v1

视觉-语言大模型(VLMs)在人工智能领域迅速崛起,这些模型能够无缝处理视觉和文本信息,扩展了大语言模型(LLMs)的能力。然而,现有的模型在处理高分辨率图像和复杂任务时存在局限性。

DeepSeek-VL2,一种基于MoE架构的视觉-语言模型,通过动态瓦片视觉编码策略和优化的多头潜在注意力机制来提高模型的性能和效率。

方法概述

DeepSeek-VL2,用于解决大规模混合专家视觉语言模型的多模态理解问题。

动态切片视觉编码策略: 为了高效处理高分辨率图像的不同宽高比,DeepSeek-VL2采用了一种动态切片策略。该策略将高分辨率图像分割成多个局部切片,每个切片通过共享的视觉变换器进行处理,然后将提取的特征集成到语言模型中。这种方法避免了固定大小编码器的限制,提升了超高分辨率图像处理能力。

多头潜在注意力机制: 在语言组件中,DeepSeek-VL2利用了DeepSeekMoE模型,并采用了多头潜在注意力(MLA)机制。MLA通过将键值缓存压缩为潜在向量,显著降低了计算成本,提高了推理速度和吞吐量。此外,DeepSeekMoE框架还采用了稀疏计算技术,进一步提升了效率。

数据集构建: 为了提升模型性能,DeepSeek-VL2构建了一个综合的视觉语言数据集。该数据集包括视觉语言对齐数据、视觉语言预训练数据和监督微调数据。 通过对多种开源数据集进行混合和扩充,数据集在质量、数量和多样性方面得到了显著提升。

多模态能力

DeepSeek-VL2在一般视觉问答、模因理解、多图像对话和视觉故事讲述等方面展示了其强大的能力。模型能够准确识别地标、理解图表、描述模因中的幽默,并生成连贯的故事。

视觉定位: 在视觉定位基准测试中,DeepSeek-VL2在不同规模的模型中都取得了最佳结果。模型能够准确定位对象,甚至在模糊图像和未见过的对象上也能表现出色。

上下文视觉定位: DeepSeek-VL2展示了其在上下文视觉定位中的能力,能够在给定一个图像的情况下,在另一个图像中找到相同类别的对象。

多模态统一模型技术演进:JanusFlow、Janus、Janus-Pro

Janus

论文题目:《Janus: Decoupling Visual Encoding for Unified Multimodal Understanding and Generation》

发表时间:2024年10月

论文地址:https://arxiv.org/pdf/2410.13848

近年来多模态大模型在理解和生成领域取得了显著进展。然而,现有的多模态模型通常依赖于单一的视觉编码器来处理理解和生成任务,这导致了性能上的妥协,特别是在多模态理解方面。

Janus框架,通过解耦视觉编码来解决多模态理解和生成之间的冲突,从而提高模型的灵活性和性能。

方法概述

Janus,一种自回归框架,用于统一多模态理解和生成。

视觉编码解耦: 首先,论文引入了两个独立的视觉编码路径:一个用于多模态理解,另一个用于多模态生成。这两个路径通过相同的变换器架构进行统一处理。解耦不仅缓解了视觉编码器在理解和生成任务中的冲突,还增强了框架的灵活性。

训练过程: Janus的训练分为三个阶段:

-

阶段I: 训练适配器和图像头,创建视觉和语言元素在嵌入空间中的概念连接,使LLM能够理解图像并具有初步的视觉生成能力。 -

阶段II: 统一预训练,使用多模态语料库进行预训练,使Janus能够学习多模态理解和生成。 -

阶段III: 监督微调,使用指令调优数据对预训练模型进行微调,增强其指令跟随和对话能力。

损失函数: Janus是一个自回归模型,训练时采用交叉熵损失函数:

JanusFlow

论文题目:《JanusFlow: Harmonizing Autoregression and Rectified Flow for Unified Multimodal Understanding and Generation》

发表时间:2024年11月

论文地址:https://arxiv.org/pdf/2411.07975

大语言模型(LLMs)在学习和泛化新场景方面表现出色。研究人员开发了专门用于图像理解和文本到图像生成的复杂模型。最近的研究方向是创建能够同时处理这两种任务的统一系统。

JanusFlow,通过结合整流流和LLM架构来实现多模态理解和生成。JanusFlow的关键在于能够在大语言模型框架内直接训练整流流,消除了复杂的架构修改需求。

方法概述

JanusFlow,用于解决在单一模型中统一图像理解和生成任务的问题。

自回归语言模型: 首先,JanusFlow利用大语言模型(LLM)进行自回归预测。LLM处理输入序列中的文本和图像数据,文本被转换为离散令牌,图像被编码为特征映射。然后,LLM自回归地预测下一个令牌。

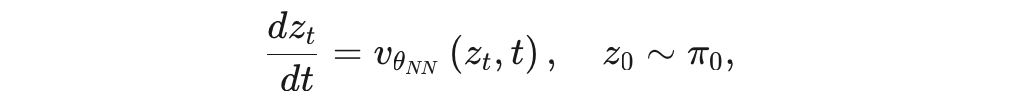

修正流模型: 其次,JanusFlow使用修正流模型进行图像生成。生成过程从高斯噪声开始,LLM迭代更新噪声向量,直到达到时间步1。修正流的数学表达式为:

解耦编码器: 为了提高模型性能,JanusFlow采用了解耦编码器设计。视觉编码器用于图像理解任务,而生成编码器和解码器则专门用于生成任务。这种设计避免了任务间的干扰,增强了理解能力。

表示对齐正则化: 此外,JanusFlow引入了表示对齐正则化项,通过将理解编码器的特征与LLM的中间特征对齐,提高了生成质量。

Janus-Pro

论文题目:《Janus-Pro: Unified Multimodal Understanding and Generation with Data and Model Scaling》

发表时间:2025年1月

论文地址:https://arxiv.org/pdf/2501.17811v1

近年来统一的多模态理解和生成模型取得了显著进展,这些模型在视觉生成任务中增强了指令跟随能力,同时减少了模型冗余。然而,现有的方法通常使用相同的视觉编码器处理多模态理解和生成任务,导致在这两个任务上的性能不理想。

Janus-Pro,通过优化训练策略、扩展训练数据和增加模型规模来提升多模态理解和文本到图像指令跟随的能力。

方法概述

Janus-Pro,用于解决多模态理解和文本到图像生成任务中的性能问题。

架构设计: Janus-Pro的架构与Janus相同,核心思想是将多模态理解的视觉编码与生成任务的视觉编码解耦。对于多模态理解,使用SigLIP编码器从图像中提取高维语义特征;对于生成任务,使用VQ tokenizer将图像转换为离散ID。然后将这些特征序列拼接形成多模态特征序列,输入到LLM中进行处理。

优化训练策略: 修改了Janus的三阶段训练过程。第一阶段增加训练步数,充分利用ImageNet数据进行像素依赖性建模;第二阶段直接使用正常文本到图像数据进行训练,提高训练效率;第三阶段调整数据比例,增加多模态数据的比例,提升多模态理解性能。

数据扩展: 在多模态理解方面,增加了约9000万样本,包括图像字幕数据、表格、图表和文档理解数据;在生成任务方面,增加了约7200万合成美学数据,使真实数据和合成数据的比例达到1:1,提高生成稳定性。

模型扩展: 将模型规模扩展到7B参数,验证了视觉编码解码方法的可扩展性。

实验设计

数据收集: 使用了DeepSeek-VL2数据集作为多模态理解预训练数据,并添加了约9000万样本;使用DeepSeek-VL2数据集中的其他数据集作为多模态理解微调数据;使用合成美学数据和平衡的真实数据作为生成任务的预训练数据。

实验设置: 使用DeepSeek-LLM(1.5B和7B)作为基础语言模型,SigLIP-Large-Patch16-384作为理解任务的视觉编码器,生成任务的编码器具有16384的词汇表大小。所有图像均调整为384×384像素。

训练过程: 在第二阶段使用早期停止策略,训练至270K步。使用HAI-LLM框架进行分布式训练,整个训练过程在16/32节点集群上进行,分别配备8个Nvidia A100(40GB)GPU。

性能分析

多模态理解性能: 在MMBench基准测试中,Janus-Pro-7B取得了79.2分的成绩,超过了现有的统一多模态模型如Janus(69.4分)、TokenFlow(68.9分)和MetaMorph(75.2分)。

文本到图像生成性能: 在GenEval基准测试中,Janus-Pro-7B取得了0.80的整体准确率,超过了Janus(0.61分)、DALL-E3(0.67分)和Stable Diffusion 3 Medium(0.74分)。在DPG-Bench基准测试中,Janus-Pro取得了84.19分的成绩,超过了所有其他方法。

定性结果: Janus-Pro在处理多模态理解任务时表现出强大的理解能力,生成的文本到图像高度逼真,细节丰富,能够准确捕捉提示中的语义信息。

(文:极市干货)