DeepSeek 又上大分!

英伟达使用 DeepSeek-R1 让 AI 自动生成 GPU 内核代码,结果效果超越人类工程师,更离谱的是在 KernelBench Level 1 上实现了 100% 的数值正确性

我们一起来扒一扒事情原委:

随着 AI 模型越来越强大,要解决的问题也越来越复杂。这时候,一种叫做 “推理时序 scaling” (inference-time scaling) 的新技巧就火了起来,听起来高大上,其实说白了,就是给 AI 更多的时间去思考!

就像我们人类解难题一样,难题太复杂?那就多花点时间,多想想不同的解法,最终选出最优方案!“推理时序 scaling” 就是让 AI 在推理过程中,分配更多的计算资源,尝试更多可能性,最终找到最佳答案。这也被称为 AI 的“reasoning” 或 “long-thinking” (长思考) 能力

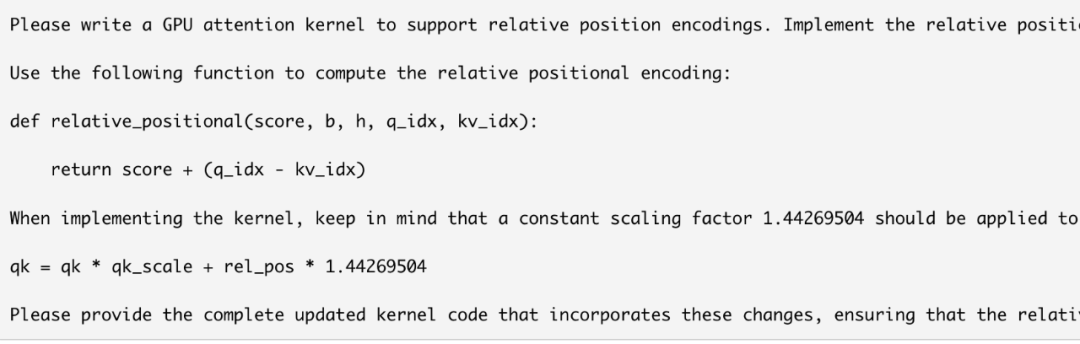

这次 Nvidia 的工程师们就用 DeepSeek-R1 模型,加上 “推理时序 scaling” 技术,搞了个实验,结果让人惊掉下巴!他们想让 AI 自动生成 GPU 上的 Attention (注意力机制) 内核代码

要知道,Attention 机制可是大语言模型的基石,但是它的计算量巨大,尤其是处理长文本的时候,简直是性能杀手!所以,优化 Attention 内核代码 就显得尤为重要。这活儿非常考验技术,经验丰富的工程师也要花费大量时间和精力

更麻烦的是,Attention 机制还有各种变体 (比如 causal, relative positional embeddings 等等),多模态模型 (比如 vision transformers) 还会引入更复杂的 Attention 机制 (Spatial Neighborhood Attention), 人工优化简直要命!

但是!Nvidia 这次直接让 DeepSeek-R1 模型上阵,自动生成这些复杂的 GPU 内核代码! 而且还用上了 “推理时序 scaling” 的大招!

⚙️ “闭环验证” + “长时间推理” = 超强 AI 代码生成器!

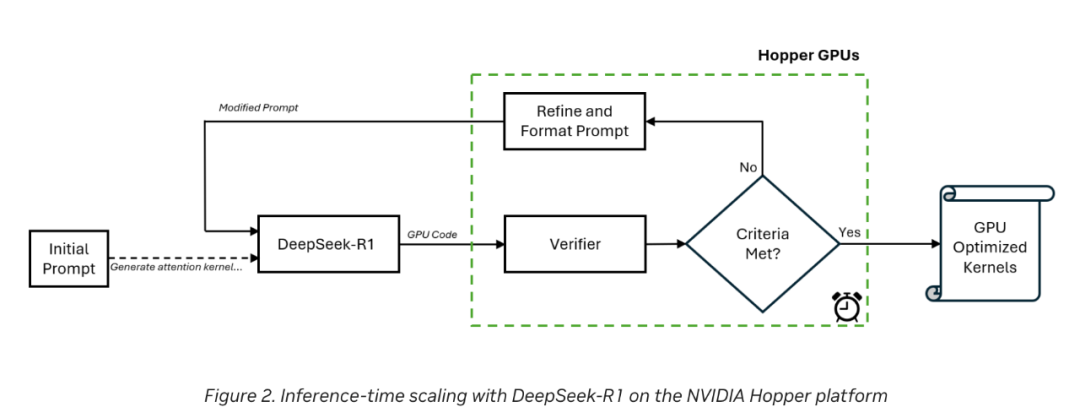

Nvidia 的工程师们设计了一个巧妙的 “闭环验证” (closed-loop) 工作流程。简单来说就是:

-

1. 人工给 DeepSeek-R1 模型一个初始 prompt (指令),告诉它要生成什么样的 GPU 内核代码

-

-

2. DeepSeek-R1 生成第一版代码

-

3. “验证器” (verifier) 在 Nvidia H100 GPU 上运行生成的代码,并进行分析

-

4. 验证器根据分析结果,生成新的 prompt,反馈给 DeepSeek-R1 模型

-

5. DeepSeek-R1 模型根据新的 prompt,继续优化代码

这个过程就像一个 AI 程序员和 AI 代码评审员之间的持续对话,不断迭代优化代码。更厉害的是,Nvidia 工程师们让这个过程 持续了 15 分钟!这就是 “推理时序 scaling” 的威力!给 AI 足够的时间,它就能不断改进,最终达到惊人的效果!

💪 KernelBench 权威评测:100% Level-1 问题搞定!96% Level-2 问题拿下!

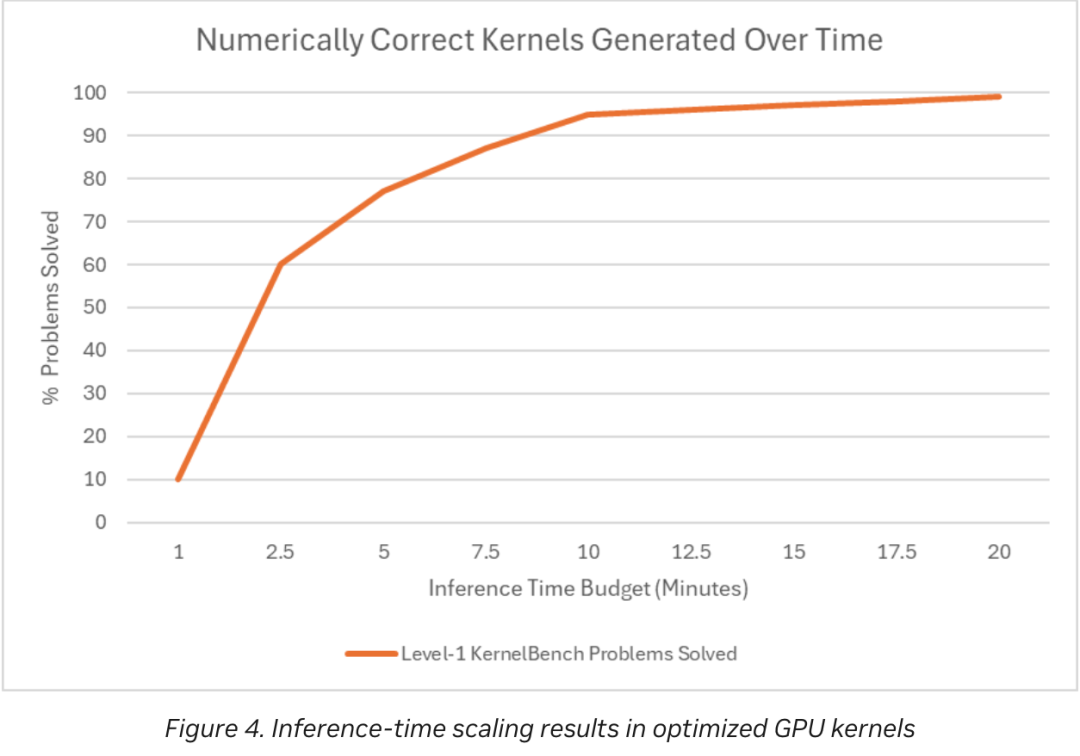

效果怎么样呢?数据说话!Nvidia 用 Stanford 的 KernelBench 基准测试 来评估生成的内核代码。结果显示,对于 Level-1 难度的问题,DeepSeek-R1 生成的代码 100% 数值正确!对于 Level-2 难度的问题,也达到了 96% 的正确率!

在某些情况下,DeepSeek-R1 生成的内核代码,性能甚至超过了经验丰富的工程师手工优化的代码!

📈 推理时间越长,效果越好!

英伟达还展示了 “推理时间预算” (inference-time budget) 对模型性能的影响。 分配给 AI 更多的时间 (超过 10 分钟),就能显著提高代码的正确率!这再次证明了 “推理时序 scaling” 的有效性

写在最后:

Nvidia 这次实验,无疑展示了 DeepSeek-R1 模型 和 “推理时序 scaling” 技术在 GPU 内核自动生成 领域的巨大潜力

未来 AI 可以自动优化各种底层代码,程序员可以把更多精力放在更高层次的创新上,这将极大地加速 AI 技术的发展!

当然,Nvidia 也承认,这还只是一个开始,要实现更广泛、更稳定的应用,还需要更多的研究和努力。但无论如何,这都是一个 激动人心的开端!

参考:

Automating GPU Kernel Generation with DeepSeek-R1 and Inference Time Scaling

(文:AI寒武纪)