当我们使用计算机时,界面上的各种按钮、图标、文本框,几乎都成了我们与软件“对话”的媒介。

然而,每当你需要自动化完成一项任务,或者依赖AI帮助你处理繁琐的操作时,往往面临一个问题:这些看似简单的界面元素,往往让AI束手无策。

AI能“读懂”文字,但却常常无法理解复杂的界面布局,也无法精准地执行你期望的任务。这不仅让开发者头疼,也让很多普通用户感到无从下手。

不过微软前两天发布了 OmniParser V2 版本,彻底打破了这一局限。

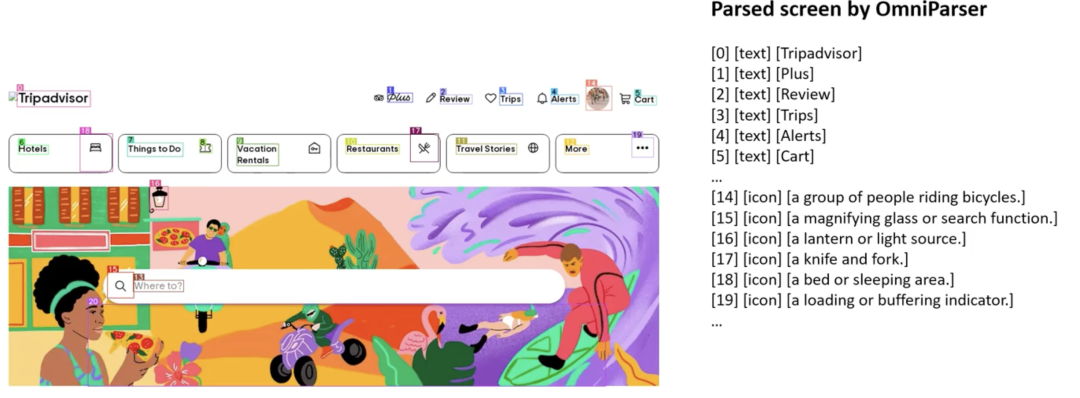

可开箱即用的把 OmniParser 与各种 LLM(OpenAI、DeepSeek、Qwen、Anthropic等) 结合使用,能够将屏幕截图转化为 LLM 可读懂的结构化元素,提高多模态大模型的视觉识别准确度。

适合自动化测试、自动化操作等场景任务。

项目简介

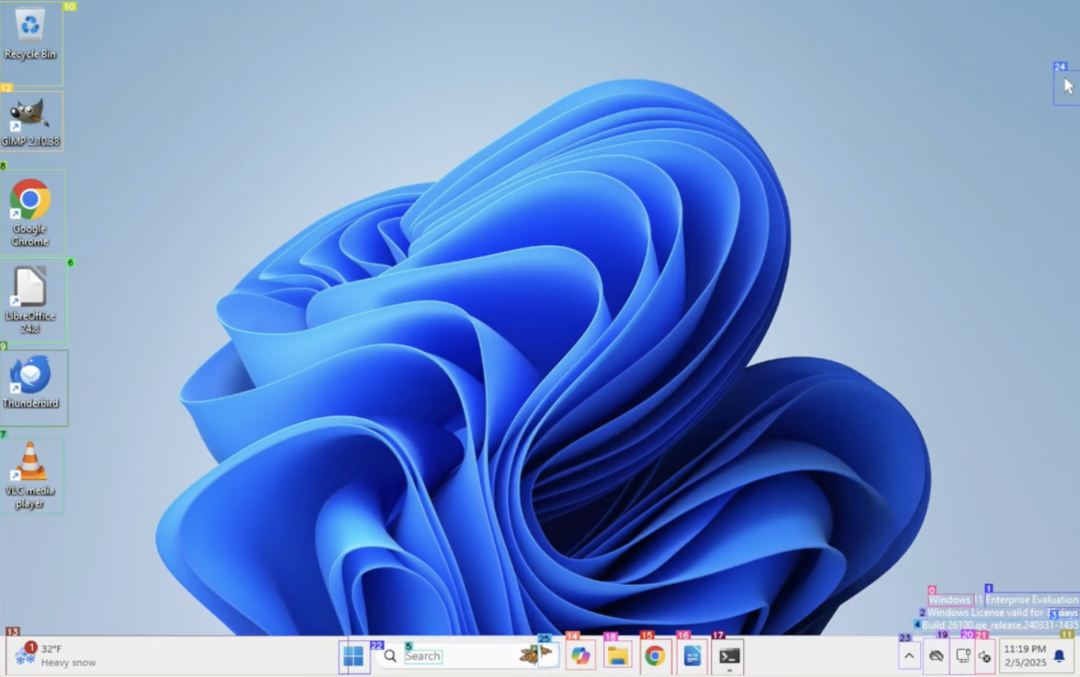

OmniParser V2 是微软推出的一款全新升级的界面解析工具,用于将用户界面截图解析为结构化和易于理解的元素,让 AI 能够更准确的操作相应界面。

本质是一个基于纯视觉的GUI代理。说白了,就是通过它,帮助AI更好地理解和操作计算机界面。

与前一代Omniparser相比,V2在多个方面进行了显著的优化,尤其是在图标和可交互元素的检测上,让其具备了像素级的屏幕理解能力。

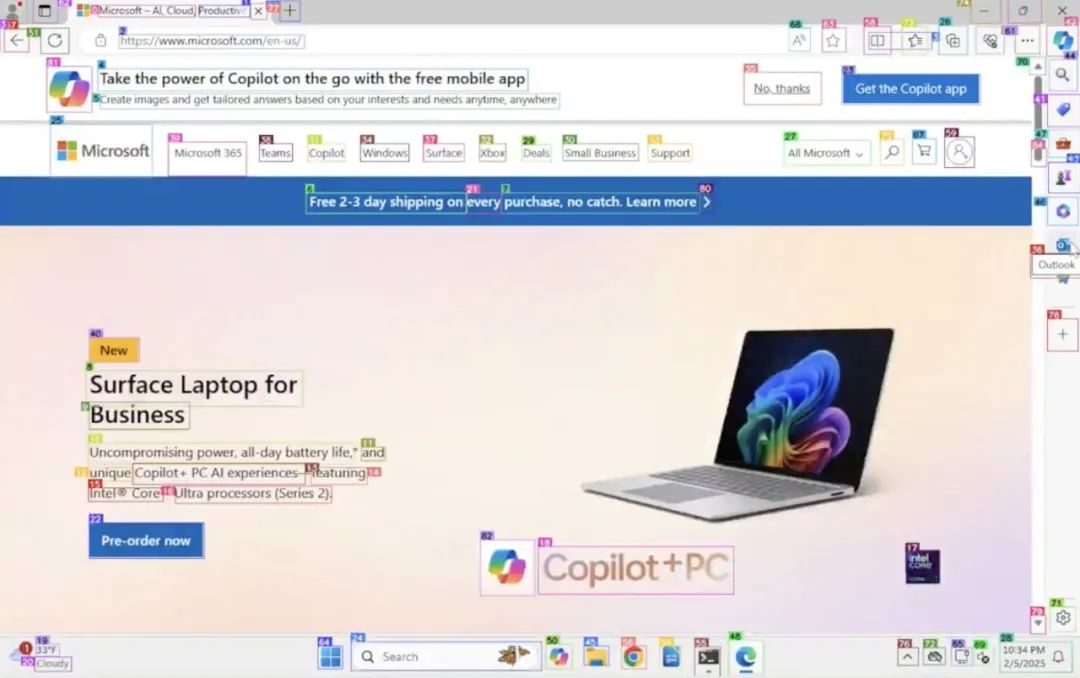

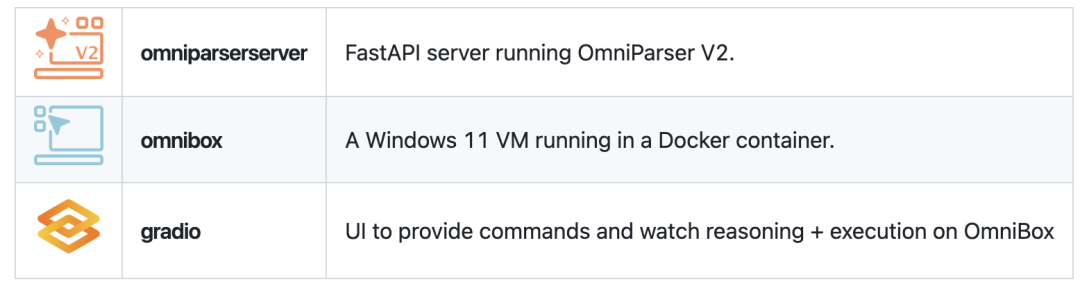

还有一大亮点功能:同步开源了 OmniTool 全能工具,集成在 OmniParser 项目中。

这是个基于 Docke r的 Windows 11 虚拟机,将屏幕解析、动作规划和指令执行熔铸成完整的工作流。

OmniTool 开箱即用地支持以下大型语言模型:OpenAI、DeepSeek (R1) 、Qwen (2.5VL)、Anthropic 。

核心亮点

-

• 提高了对小型可交互元素的识别准确性 -

• 优化了图标描述模型,较v1降低延迟60% -

• 平均精确度显著提升,在ScreenSpot Pro上达到了39.6

快速使用

OmniParser 作为一个简单的纯视觉屏幕解析工具,只需要 2 个重要步骤即可开始使用。

步骤一:本地部署依赖环境

先将项目代码下载到本地并解压,进入到解压目录后,执行以下命令:

conda create -n "omni" python==3.12

conda activate omni

pip install -r requirements.txt步骤二:下载模型权重

确保在 weights 文件夹中下载了V2权重(确保字幕权重文件夹名为icon_caption_florence)。如果没有,请使用以下命令下载:

rm -rf weights/icon_detect weights/icon_caption weights/icon_caption_florence

for f in icon_detect/{train_args.yaml,model.pt,model.yaml} icon_caption/{config.json,generation_config.json,model.safetensors}; do huggingface-cli download microsoft/OmniParser-v2.0 "$f" --local-dir weights; done

mv weights/icon_caption weights/icon_caption_florence要运行 gradio 演示,只需运行:

python gradio_demo.py从开发者到普通用户的应用

OmniParser V2 和 OmniTool 的推出,显然是面向多个应用场景的。这些工具不仅对开发者友好,同样也能让普通用户受益。

以下是几个潜在的应用场景:

-

• 自动化操作:例如,在一些重复性较强的工作中,OmniParser V2能够帮助AI理解和操作界面,执行一系列操作。对于日常的办公自动化、批量操作等任务,V2都能显著提高效率。 -

• UI测试:在UI开发和测试过程中,OmniParser V2能够快速识别界面元素,帮助开发人员检测和修复界面问题。 -

• 智能助手:OmniParser V2结合大型语言模型后,可以作为智能助手,帮助用户更高效地与软件进行交互,例如通过语音命令控制计算机界面。 -

• 无障碍应用:对于视力障碍或行动不便的用户,OmniParser V2可以通过AI理解界面,并提供语音反馈或自动化操作,提升用户体验。

写在最后

Omniparser V2 的发布意味着 AI 与用户界面操作的融合进入了一个新的阶段,它适用于各种截图,包括PC和手机,以及各种应用程序。

它不仅提升了UI解析的精度和速度,还通过结合强大的LLM,打破了传统界面交互的局限。

微软的这一进展,不仅为开发者提供了更强大的工具,也为普通用户带来了更便捷的操作体验。无论是自动化办公、UI测试,还是智能助手应用,Omniparser V2都能为我们打开全新的可能性。

GitHub 项目地址:https://github.com/microsoft/OmniParser

模型地址:https://huggingface.co/microsoft/OmniParser-v2.0

● 一款改变你视频下载体验的神器:MediaGo

● 新一代开源语音库CoQui TTS冲到了GitHub 20.5k Star

● 最新最全 VSCODE 插件推荐(2023版)

● Star 50.3k!超棒的国产远程桌面开源应用火了!

● 超牛的AI物理引擎项目,刚开源不到一天,就飙升到超9K Star!突破物理仿真极限!

(文:开源星探)