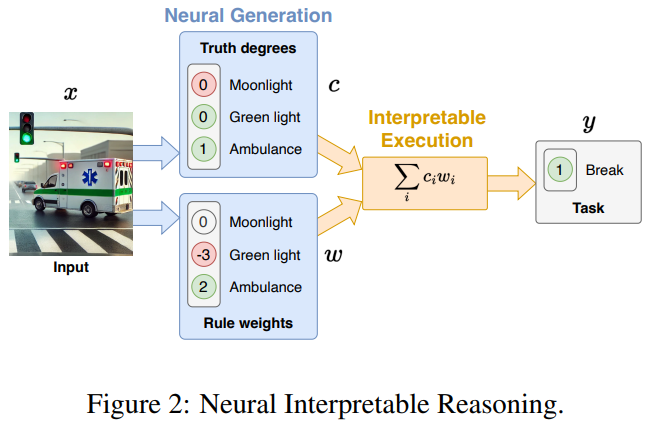

本文创新性地提出基于“推理等变性”原则的神经可解释推理 (NIR) 框架,通过“神经生成与可解释执行”范式和神经重参数化技术,在保证深度学习模型表达能力的同时,实现了可扩展的可解释性验证,并为内在可解释的深度学习模型设计开辟了新路径,其核心思想在于将可解释性从后验解释转向模型设计本身,并以用户可预测的行为作为可解释性的客观评估标准,为构建更透明、可信的 AI 系统提供了重要的理论和方法论支撑。

参考文献:

[1] https://arxiv.org/abs/2502.11639

(文:NLP工程化)