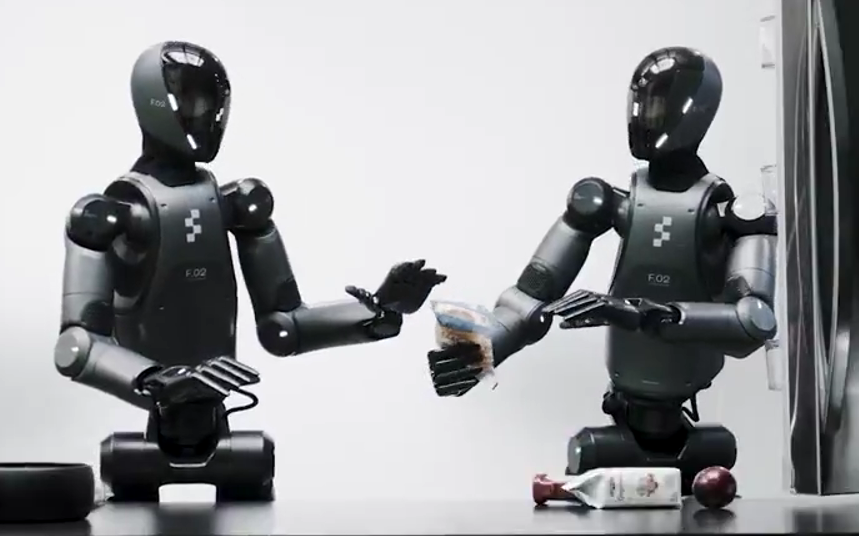

一款端到端的通用模型,真正意义上的“机器人通用大脑”,它能让两台搭载Helix的机器人共享同一模型,通过语言指令进行分工合作。

和其他机器人不同的是,Figure这款大脑(Helix)更聪明。

它能让Figure具备协作的能力。例如一台识别需冷藏的食品并传递给另一台,另一台则是接住并放到冰箱里面。

同时Figure的AI能通过摄像头实时观察环境,它会把冷藏的物品和不需冷藏的物品分类,即使没人教过它。

除此之外,Figure还有一个显著的特点,那就是不用训练。

传统机器人每学一个新任务(比如抓杯子),都需要工程师重新编程。

但Figure的AI系统(Helix模型)只需学会“抓取”的逻辑,就能直接处理成千上万种不同形状的物体,甚至包括从未见过的物品。

比如面对从未接触过的物品(如玻璃杯、积木),Helix也可以通过自然语言指令轻松抓取。

据介绍,Figure搭载的Helix模型可以像人类一样思考,处理任何家具用品。

看到这里,不禁好奇,它到底是怎么能听懂人话并能快速得干活的。

这其实得归公于Figure自研的Helix模型,其采用了双系统架构,“系统 1、系统 2”VLA 模型。

以前的方法会面临一个问题:VLM主干网络具有通用性但速度慢,机器人视觉运动策略速度快但通用性又不足。

而Helix通过两个配合的系统解决了这个难题:

-

系统 2 (S2):一个机载互联网预训练的 VLM,可以以7-9 Hz 的频率运行,用于场景理解和语言理解,从而实现跨对象和上下文的广泛概括。

-

系统 1 (S1):一种快速反应的视觉运动策略,将 S2 产生的潜在语义表征转化为 200 Hz 的精确连续机器人动作。

这种设计让两个系统各司其职:S2负责接受任务并思考,S1则是负责快速执行,从而让机器人在复杂环境中能够灵活操作。

不过,目前 Helix 仍还处在比较早期的阶段。

Helix主要是用于Figure上半身控制,包括机器人手腕、躯干、头部及单根手指的200Hz高速连续控制,协调动作如人类般流畅。

值得一提的是,Helix 是史上第一个在本地 GPU 运行的机器人 VLA 模型,无需云端算力支持,就能直接部署。

而且,新款模型采用单一神经网络权重学习所有行为,无需任何特定的微调。

在发布Helix之前,Figure和OpenAI上演了一场分手戏码。

在两周之前,Figure AI的创始人Brett Adcock在X平台上单方面发文称:决定和OpenAI分手。

分手的理由很简单,发现彼此并不般配。

相关阅读:Figure抛弃OpenAI,“通用大模型+机器人”似成断头路

值得一提的是,几天前有消息传出,Figure AI正在洽谈新一轮15亿美元的融资,预计由Align Ventures和Parkway Venture Capital领投。

如果交易完成,公司估值将达到395亿美元,Figure AI将跻身全球估值最高的十大未上市初创公司之列。

(文:AI先锋官)