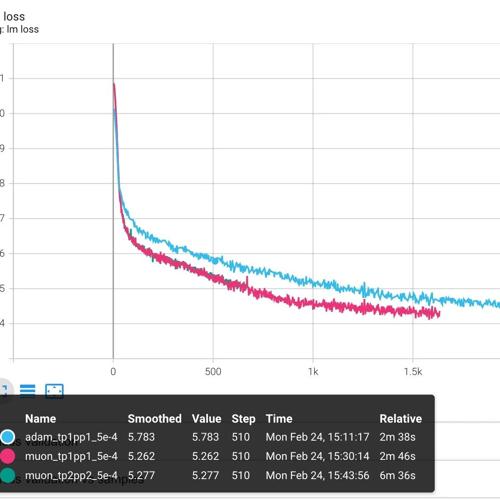

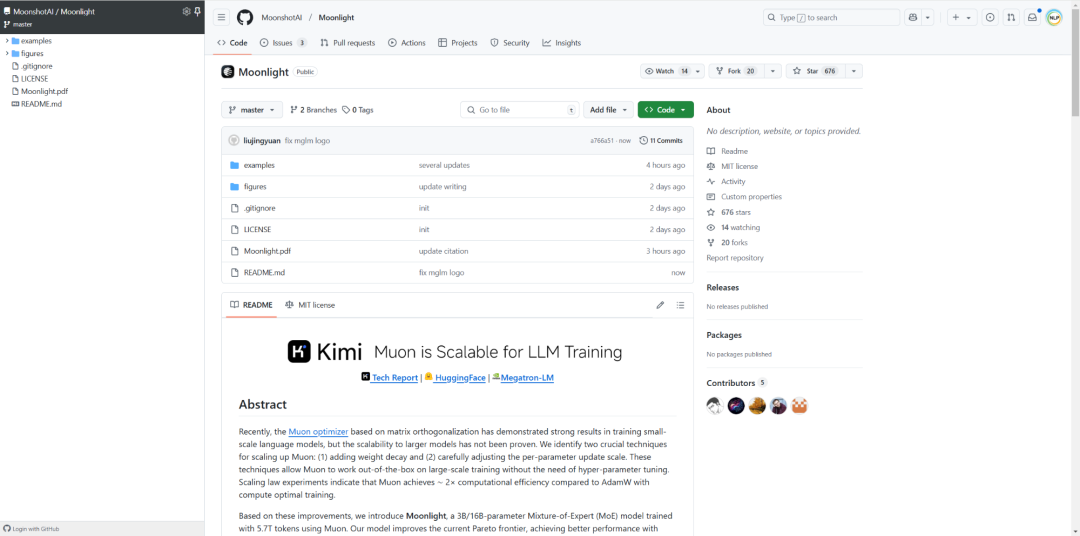

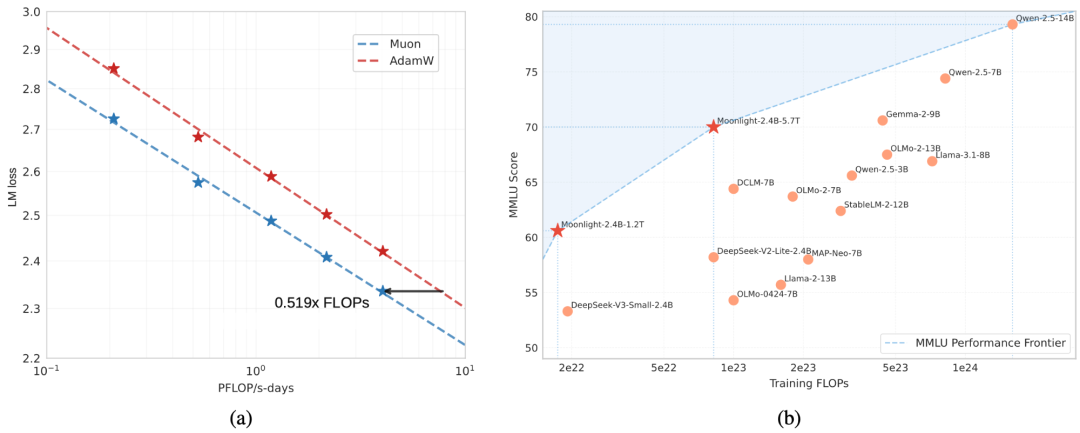

Kimi首次开源了其一个16B参数的MoE模型:Moonlight-16B,它通过采用改进Muon优化器策略,比使用AdamW达到相同性能所需计算量减少了一半,总参数16B,激活3B。性能: 1、英文能力,在MMLU、BBH等任务上优于LLAMA3-3B、 Qwen2.5-3B

2、中文能力,在C-Eval、CMMLU等任务上优于Deepseek-v2-Lite

3、代码生成能力,在HumanEval、MBPP 等任务上优于 LLAMA3-3B、Deepseek-v2-Lite

参考文献:

[1] github:https://github.com/MoonshotAI/Moonlight

[2] 论文:https://github.com/MoonshotAI/Moonlight/blob/master/Moonlight.pdf

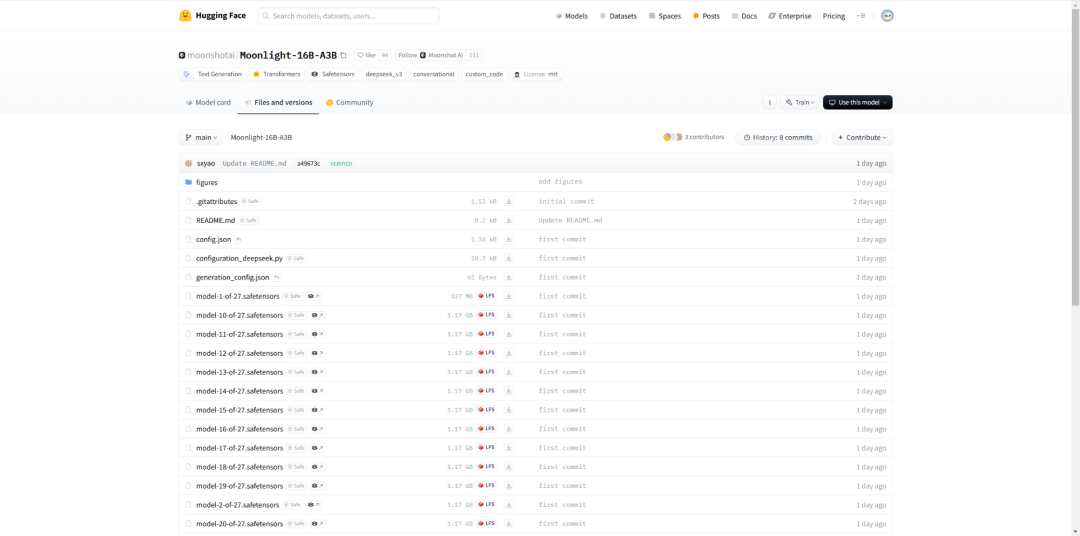

[3] https://huggingface.co/moonshotai/Moonlight-16B-A3B

[4] https://github.com/NVIDIA/Megatron-LM/pull/1428

(文:NLP工程化)