AIxiv专栏是机器之心发布学术、技术内容的栏目。过去数年,机器之心AIxiv专栏接收报道了2000多篇内容,覆盖全球各大高校与企业的顶级实验室,有效促进了学术交流与传播。如果您有优秀的工作想要分享,欢迎投稿或者联系报道。投稿邮箱:liyazhou@jiqizhixin.com;zhaoyunfeng@jiqizhixin.com

本文一作汤轶文本科毕业于上海科技大学,导师是李学龙教授,在上海人工智能实验室实习。他的研究兴趣是 3D 视觉,大模型高效迁移,多模态大模型和具身智能等。主要工作有 Any2Point, Point-PEFT, ViewRefer 等。

-

论文标题: Exploring the Potential of Encoder-free Architectures in 3D LMMs -

作者单位:上海人工智能实验室,西北工业大学,香港中文大学,清华大学 -

代码链接:https://github.com/Ivan-Tang-3D/ENEL -

论文链接:https://arxiv.org/pdf/2502.09620v1

-

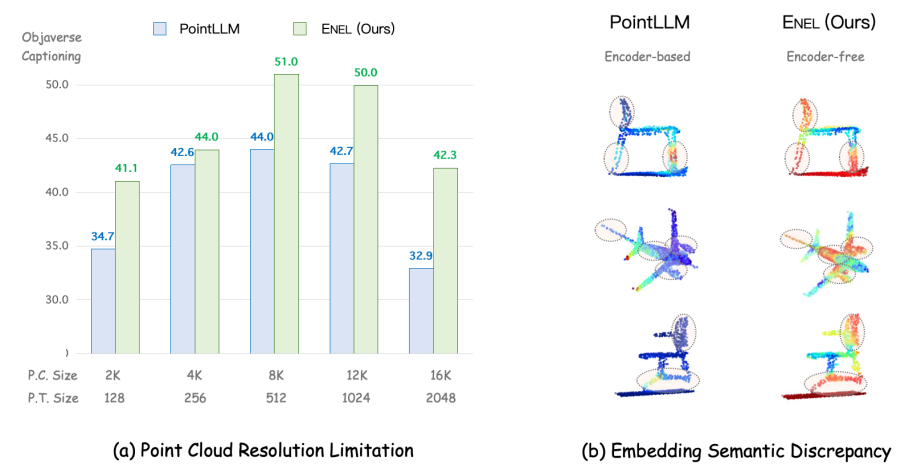

点云分辨率限制:3D 编码器通常在固定分辨率的点云数据上进行预训练,例如 PointLLM 的编码器 Point-BERT 使用 1,024 个点。然而,在推理过程中,输入点云的分辨率可能会有所不同(例如,8,192 个点或 512 个点)。训练和推理分辨率之间的差异可能导致在提取 3D 嵌入时丢失空间信息,从而使 LLMs 理解变得困难。如(a)所示,PointLLM 在不同的点云分辨率输入下性能差异过大,而我们提出的 ENEL 显示出了一定的鲁棒性。 -

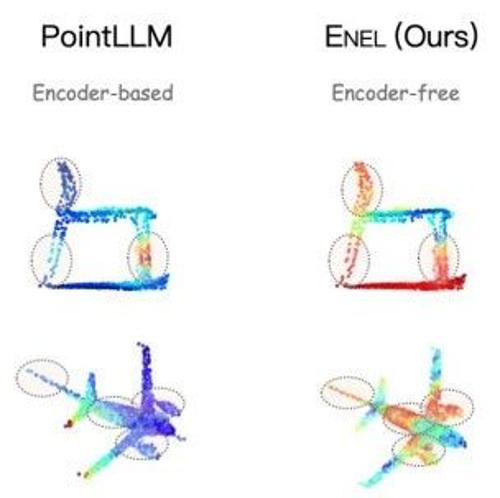

嵌入语义差异:3D 编码器通常采用自监督方法(如掩码学习和对比学习)进行预训练,但 3D 编码器和大语言模型的训练分离导致训练目标可能与 LLMs 的特定语义需求不一致,无法捕捉到 LLMs 理解 3D 物体所需的最相关语义。即使使用投影层将 3D 编码器与 LLMs 连接,简单的 MLP 也往往不足以进行完全的语义转换。如图(b)所示,ENEL 架构中 text token 更能关注到点云物体的关键部位,如椅脚和机翼。

-

如何弥补 3D 编码器最初提取的高层次 3D 语义?在 3D LMMs 中,完全跳过编码器会导致难以捕捉 3D 点云的复杂空间结构。 -

如何将归纳偏置整合到 LLM 中,以便更好地感知 3D 几何结构?传统的 3D 编码器通常将显式的归纳偏置嵌入到其架构中,以逐步捕捉多层次的 3D 几何。例如,像 Point-M2AE 这样的模型使用局部到全局的层次结构,这一概念在 2D 图像处理的卷积层中也很常见。

-

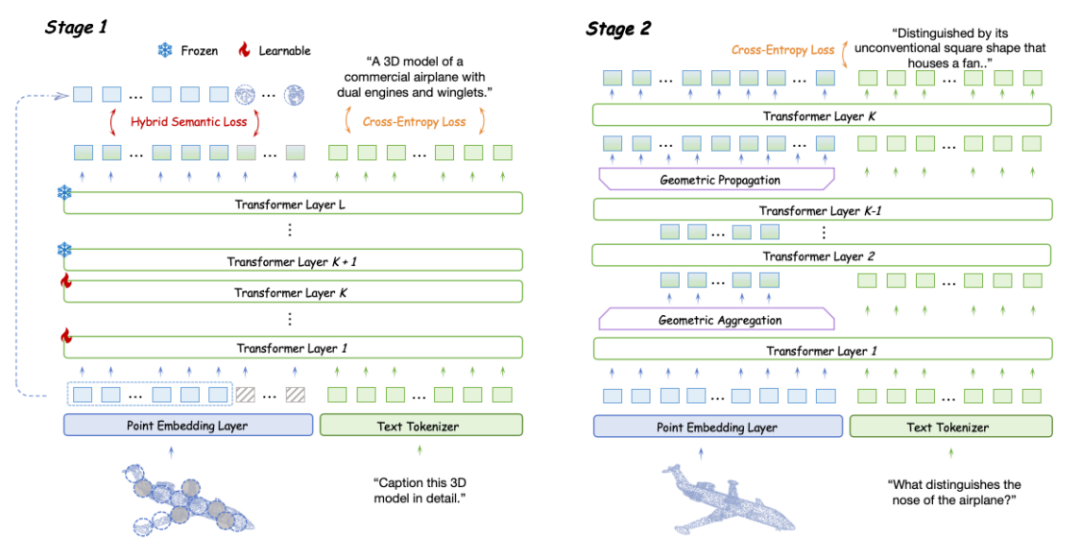

点云自监督学习损失通常有助于无编码器 3D LMM。自监督学习损失通过特定的任务设计对复杂的点云进行变换,促使 LLM 学习潜在的几何关系和高层次的语义信息。 -

在这些自监督学习损失中,掩蔽建模损失展示了最强的性能提升。掩蔽比率与训练优化难度直接相关,从 30% 增加到 60% 会导致性能下降。此外,显式重建点云 patch 不如掩蔽建模有效,但有助于 LLM 学习点云中的复杂模式。相比前两种损失,知识蒸馏损失的效果较差。最后,对比损失未能提取详细的语义信息,表现最差。 -

基于上述实验结果,作者提出混合语义损失 (Hybrid Semantic Loss),他们对于掩蔽部分采用掩蔽建模,而对于可见部分,他们使用重建策略。这种方法不仅将高层次的语义嵌入 LLM 中,而且确保在整个点云学习过程中保持几何一致性。

-

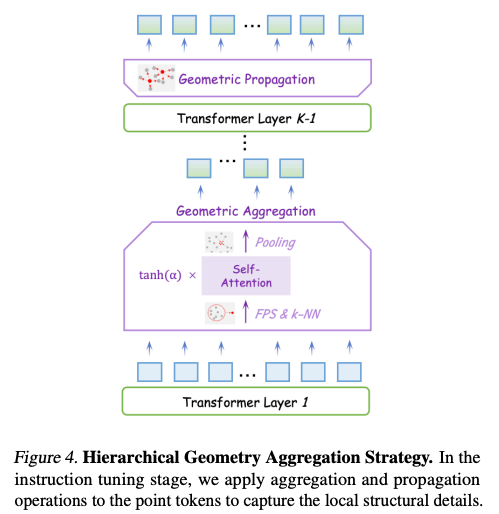

从 LLM 的第二层开始,输入的点云 token 基于它们对应的坐标使用最远点采样进行下采样,将 token 数量从 M 减少到𝑀/2, 作为局部中心。然后,使用 k-NN 算法获得邻近点。针对邻近点他们采用门控自注意力机制进行组内交互,捕捉局部几何结构。最后,他们应用池化操作融合每个邻居的特征,结果特征长度为 M/2。总共进行 l-1 次几何聚合。 -

为了确保 LLM 充分提取局部信息,作者选择在聚合操作后经过多层 LLM 层进行进一步的语义建模,避免丢失细粒度的几何细节。 -

随后,他们进行 l 次几何传播。按照 PointNet++ 的方法,他们将聚合后的特征从局部中心点传播到它们周围的 k 个邻近点,经过 l 次后重新得到长度为 M 的点云特征。

-

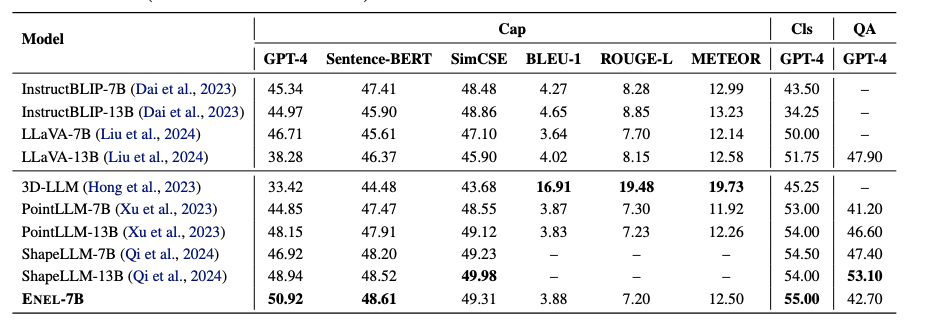

在 Objaverse 基准测试中,ENEL-7B 在 3D 物体描述任务中取得了 50.92% 的 GPT-4 得分,创下了新的 SOTA 性能。在传统指标中,SentenceBERT 和 SimCSE 分别达到了 48.61% 和 49.31% 的得分,表现与 ShapeLLM-13B 相当。对于 3D 物体分类任务,ENEL-7B 超越了先前基于编码器的 3D LMMs,取得了 55% 的 GPT 得分。 -

此外,在 3D MM-Vet 数据集的 3D-VQA 任务上,尽管训练集中缺乏空间和具身交互相关的数据,ENEL 仍取得了 42.7% 的 GPT 得分,超过了 PointLLM-7B 1.5%。 -

考虑到与 PointLLM 相同的训练数据集,这些结果验证了作者提出的 LLM 嵌入式语义编码和层次几何聚合策略在无编码器架构中的有效性。

(文:机器之心)