Gemma 3 横空发布,单卡AI性能显著提升! 128K超长上下文,多语言多模态进化,量化技术加持。Gemma 3 重新定义轻量级 AI 模型。

Gemma 3:轻量级AI性能新高度

Gemma 家族迎来一周年,Google DeepMind 发布 Gemma 3。 Gemma 3 源于 Gemini 2.0 技术,更 先进、便携、负责任,旨在 降低AI应用门槛,助力开发者在 各类设备 上构建强大 AI 应用。

Gemma 3 提供 1B, 4B, 12B 和 27B 多尺寸版本,灵活适配不同硬件及应用需求。

Gemma 3 如何实现 “轻量级 AI 性能新高度”? 其单卡 AI 性能突破体现在哪些关键技术? 本文将深入解析 Gemma 3 的核心技术。

Gemma 3 核心技术解析

Gemma 3 性能提升源于多项技术创新,在模型架构、多模态能力、量化技术和长上下文处理等方面均有突破。

创新架构:Local/Global Attention 提升效率

为解决 Transformer 模型处理长文本时的 KV-cache 内存瓶颈,Gemma 3 创新性地采用了 Local/Global Attention 混合机制。 模型结构上,Gemma 3 由 交替堆叠的 Local Attention 层与 Global Attention 层 构成,其中 Local Attention 层的滑动窗口大小被限制为 1024 tokens。

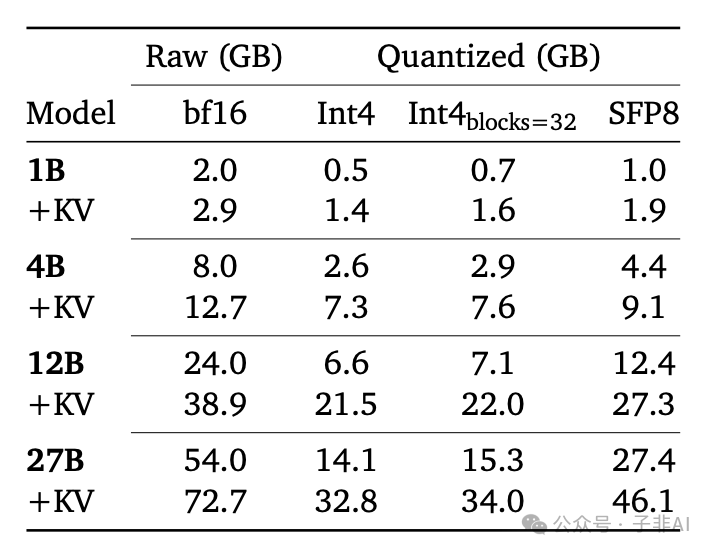

图 2: 模型与 KV 缓存内存对比 (Figure 5)。在 32k 上下文长度下,Gemma 3 配置显著降低 KV 缓存内存占用。

得益于 Local/Global Attention 机制,Gemma 3 有效降低了 KV-cache 内存开销,实测在 32k 上下文长度下,内存占用 降低超过 45%。 同时,实验表明该架构对模型性能影响甚微,实现了 效率与性能的平衡,为模型长上下文应用奠定基础。

多模态视觉:SigLIP 与 Pan & Scan 融合

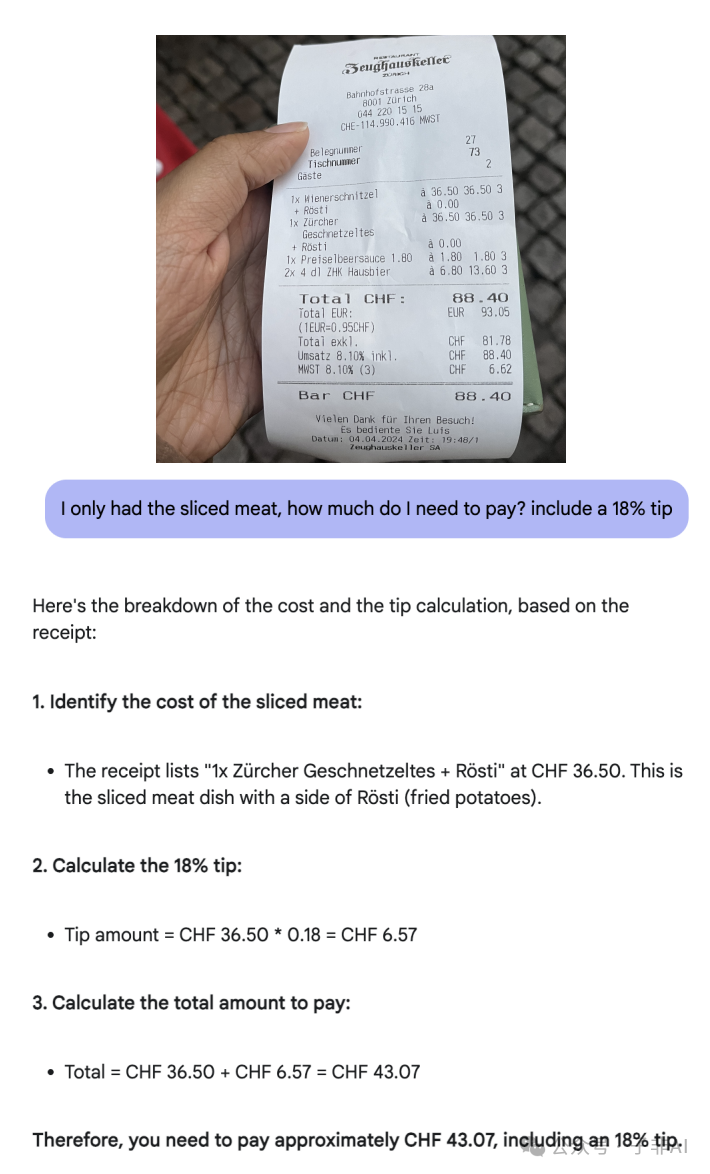

Gemma 3 集成了 SigLIP Vision Encoder,从而具备 多模态视觉理解能力。 Gemma 3 选用 400M 参数的 SigLIP 变体 作为视觉编码器,可将图像编码为 soft tokens,并融入语言模型进行 多模态信息处理与推理。

为提升模型对不同图像分辨率和长宽比的适应性,Gemma 3 采用了 Pan & Scan (P&S) 技术。 P&S 技术支持模型 自适应处理不同尺寸图像,保证视觉输入质量,提升多模态应用的灵活性。

量化技术:QAT 实现轻量高效

Gemma 3 采用了 Quantization Aware Training (QAT) 量化感知训练 技术,并官方发布了 量化模型版本。 QAT 技术的核心在于 在模型训练阶段即引入量化考量,优化模型参数,从而在量化压缩模型体积的同时,最大限度降低精度损失,实现模型 轻量化与高性能的平衡。

Gemma 3 提供 per-channel int4, per-block int4, 和 switched fp8 等多种量化格式,满足不同部署需求。 量化后的 Gemma 3 模型,在 模型体积和内存占用显著降低 的同时,依然能够 保持较高精度,使得 消费级硬件上部署高性能 AI 模型成为可能。

超长上下文:128K tokens 扩展应用场景

Gemma 3 的上下文窗口长度 扩展至 128K tokens (1B 模型为 32K),这意味着模型可以 单次处理约 9.6 万汉字 的长文本内容。

图 : KV 缓存内存与上下文长度关系 。Gemma 3 架构在长上下文下具备显著内存优势。

128K 超长上下文 为 Gemma 3 带来了更广阔的应用前景,使其能够胜任 长篇问答、文档摘要、复杂推理 等需要处理大量上下文信息的任务。 RoPE 频率调整 等技术为 Gemma 3 实现 128K 长上下文 提供了有力支撑。

Function Calling:构建智能 Agent 的基石

Gemma 3 支持 Function Calling 功能,允许模型 调用外部函数或 API,拓展模型功能,实现与外部数据和系统的联动。 例如,开发者可以利用 Function Calling 功能,让 Gemma 3 调用搜索引擎 API 获取实时信息,或调用日历、天气 API 等工具。

此外,Gemma 3 还 支持 structured output (结构化输出),能够 输出 JSON, XML 等结构化数据,为开发者 构建智能 Agent 和自动化工作流 提供了便捷支持。

Gemma 3 的全球化与多场景应用

Gemma 3 凭借其技术优势,将在全球化和多场景应用中展现巨大潜力。

140+ 语言支持:打造全球通用AI

Gemma 3 具备 强大的多语言能力,支持超过 140 种语言,并对 35 种以上语言提供开箱即用支持,语言覆盖范围十分广泛。 这得益于训练数据中 多语言数据的占比提升 以及 高效的语言采样策略。 同时,Gemma 3 采用的 SentencePiece tokenizer 也 更好地兼顾了非英语语言的处理。

多语言支持 赋予 Gemma 3 服务全球用户的能力,使其能够应用于 跨语言交流、内容本地化 等多种场景。

完善的工具链与开放生态

Gemma 3 致力于构建开放的生态系统,提供 完善的工具链支持,能够 无缝集成到开发者现有工作流中。 Gemma 3 兼容 Hugging Face Transformers, Ollama, JAX, Keras, PyTorch 等主流开发工具和框架,方便开发者快速上手。

Gemma 3 提供 灵活多样的部署选项,并针对 NVIDIA GPUs, Google Cloud TPUs, AMD GPUs, CPUs 等多种硬件平台进行了优化。

蓬勃发展的 Gemmaverse 社区

Gemmaverse 是由社区驱动的 Gemma 模型及工具生态,为开发者提供丰富的资源和灵感。 SEA-LION v3, BgGPT, OmniAudio 等社区项目 Gemma 3 在不同领域的应用潜力。 Gemma 3 Academic Program 则旨在鼓励和支持学术界基于 Gemma 3 进行研究创新。

Gemma 3:引领单卡AI发展浪潮

Gemma 3 的发布是 轻量级 AI 发展的重要里程碑。 Gemma 3 集 高性能、多模态、长上下文和高安全性 于一身,打破了 AI 模型对算力的过度依赖,开启了单卡 AI 应用的黄金时代。

Gemma 3 的意义不仅在于提供了一款强大的 AI 模型,更在于 降低了 AI 技术的使用门槛,让更多开发者能够参与到 AI 创新中来。 轻量化的 Gemma 3 有望 加速 AI 技术的普及和应用,推动 AI 在各行各业的深度融合。

Gemma 3 有望成为推动 AI 技术去中心化和边缘化的关键力量,引领单卡 AI 应用的蓬勃发展。

📚 推荐阅读

-

• Gemma 3 官方博客: https://blog.google/technology/developers/gemma-3/ -

• Gemma 3 技术报告: https://storage.googleapis.com/deepmind-media/gemma/Gemma3Report.pdf

(文:子非AI)