阿里对这个方向的项目比较执着。

前前后后感觉开源了三四个项目了,最初阿里吊大家胃口不开源,现在脱胎换骨了,有项目就开源出来给大家一起玩玩。

这才是现阶段AI技术应该做的,没到终极形态之前,现有的技术总是会被推翻的,与其挨骂,还不如格局一些。

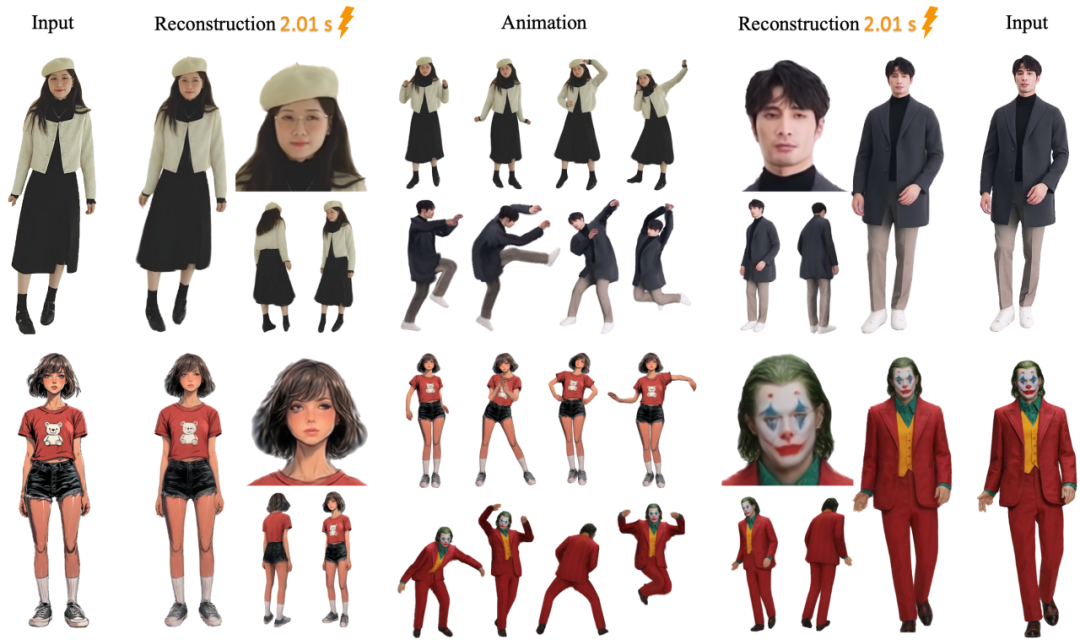

这次的提升还是很大的。

一方面是时间上,只需要几秒钟搞定。

再就是效果上,真的很不错了,非常稳定。

扫码加入AI交流群

获得更多技术支持和交流

(请注明自己的职业)

项目简介

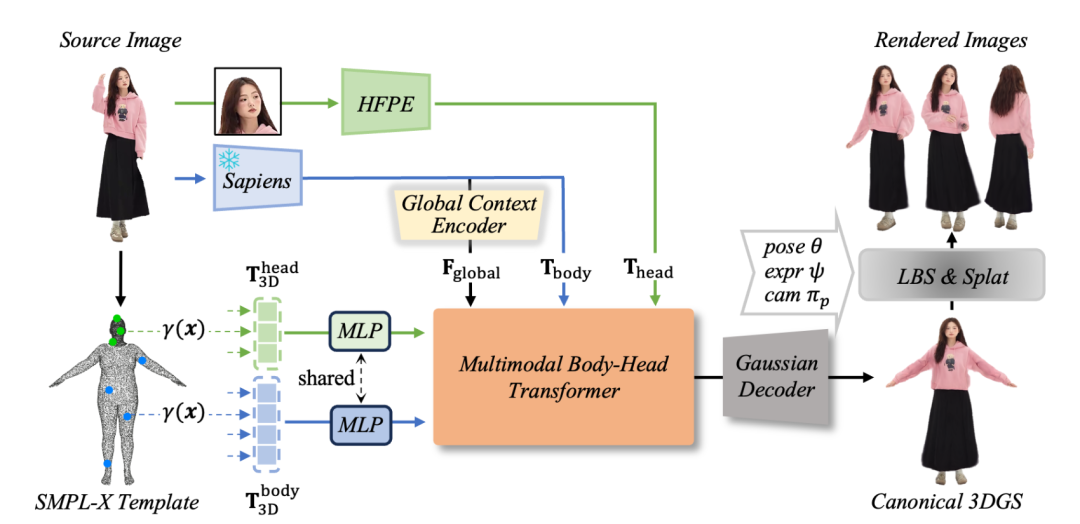

LHM 是一个基于 transformer 的模型,能够从单张图像在几秒内重建高保真、可动画的 3D 人体模型。它使用多模态 transformer 架构融合 3D 位置特征和 2D 图像特征,通过注意力机制保持服装几何、纹理和面部细节。采用 3D 高斯点云技术实现实时光线真实渲染,训练于大规模视频数据集上,无需对面部和手部进行后期处理。 LHM 在重建准确性、泛化能力和动画一致性方面表现优异,时间和内存使用效率高。

DEMO

技术特点

多模态 Transformer 架构

采用 Multimodal Body-Head Transformer ,通过注意力机制融合 3D 几何特征(基于 SMPL-X 模板网格采样点)和 2D 图像特征(来自预训练视觉模型),实现几何与视觉信息的联合推理。

头部特征金字塔编码

提出多尺度特征聚合方案,利用 DINOv2 模型提取不同层级的头部特征,有效保留面部细节和纹理。

3D 高斯点云表示

将人体表示为 3D 高斯点云,支持实时渲染和基于线性蒙皮的动态姿态控制,同时通过扩散体素蒙皮优化衣物变形。

自监督训练策略

结合视频数据和合成数据增强,通过渲染损失和正则化约束(如形状正则化和位置锚定)学习可泛化的人体先验,无需标注 3D 数据。

高效推理与性能优势

单张图像输入即可在秒级完成 3D 重建和动画生成,在静态重建和动态动画任务中均优于现有方法,且内存占用低,仅需18-24GB。

项目链接

https://github.com/aigc3d/LHM

关注「开源AI项目落地」公众号

(文:开源AI项目落地)