阿里巴巴通义实验室的研究人员开源了多模态情感识别模型R1-Omni,并首次将强化学习与可验证奖励应用在多模态大模型,显著提升了模型在情感识别任务中的推理能力、准确性和泛化能力。

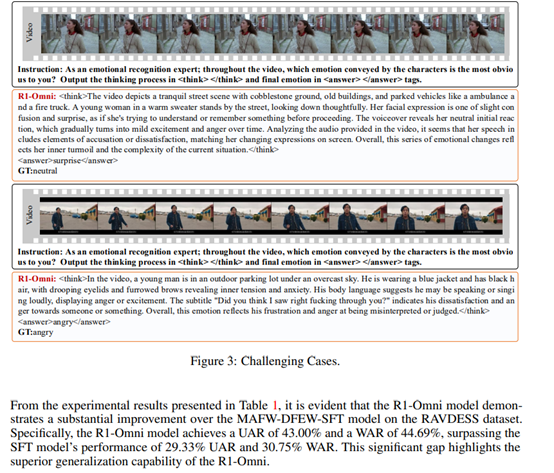

根据测试数据显示R1-Omni的识别能力非常优秀,在MAFW数据集上,R1-Omni模型的加权平均召回率达到了40.04%,无加权平均召回率达到了57.68%;在DFEW数据集上,WAR达到了56.27%,UAR达到了65.83%。

开源地址:https://github.com/HumanMLLM/R1-Omni

在传统强化学习中,奖励信号的设计往往需要依赖于复杂的奖励模型,这些模型通常需要大量的标注数据来训练,并且在多模态任务中难以精确地捕捉到视觉、音频和文本等多种模态之间的复杂关系。不仅增加了训练的复杂性和计算成本,还可能导致奖励信号的不准确,从而影响模型的学习效果。

为了解决这些问题,R1-Omni模型引入了全新的强化学习方法——强化学习与可验证奖励(RLVR)。

相比之下,RLVR能直接利用任务的内在正确性标准来设计奖励函数,避免了对中间奖励模型的依赖。在多模态情感识别任务中,这意味着模型可以直接根据情感预测的准确性来获得奖励,而无需通过一个复杂的奖励模型来间接评估。

对于一个输入的多模态样本q(包含视频帧、音频流等信息),模型生成一个情感预测响应o,随后通过可验证奖励函数R(q, o)来判断o是否与真实情感标签一致。

如果预测正确,模型获得奖励值1,表示其输出与真实结果匹配;如果预测错误,则获得奖励值0,表示输出不正确。

此外,RLVR的奖励机制还为模型的优化目标提供了清晰的方向。能够明确地知道哪些预测是正确的,哪些是错误的,从而更加有针对性地调整模型参数,优化其对多模态信息的处理和融合能力,提高情感识别的准确性和可靠性。

训练方面,受到DeepSeek-R1的启发,R1-Omni也使用了类似的方法。多模态情感识别任务涉及到对视觉、音频等多种信息的综合处理和分析,其复杂性远超单一模态的任务。

如果模型在训练初期没有得到有效的引导和初始化,直接进入常规训练阶段,可能会在面对海量且复杂的多模态数据时陷入混乱,无法准确提取关键信息,导致训练效率低下,最终的模型性能也难以达到预期。

研究人员挑选了可解释多模态情感推理(EMER)数据集和手动标注的 HumanOmni 数据集。从 EMER 数据集中选取的 232 个样本,包含了丰富的多模态数据。这些样本中的视频片段记录了人物丰富多样的表情、动作以及场景变化等视觉信息,与之匹配的音频则涵盖了语音的语调、语速、音色等丰富细节。

例如,在一个 EMER 样本中,视频展示了一位女性在室内场景中,先是眼神游离、眉头微蹙,随后嘴角微微下撇,同时音频中她的声音带有一丝颤抖,语气较为低沉,字幕显示 “我真的不知道该怎么办了”。注释会引导模型理解这些视觉、音频和文本信息之间的联系,帮助模型推断出人物此刻的焦虑情绪。

手动标注的HumanOmni数据集有348个高质量样本。这些样本是基于实际场景和研究需求进行人工标注的,具有较高的针对性和可靠性。它们与 EMER 数据集的样本相互补充,共同为模型的冷启动训练提供了丰富的数据资源。

在这两个高质量数据的微调下,模型开始接触并学习多模态情感识别的相关知识。它逐渐掌握如何从视频中的人物表情、动作,音频的音色、语调,以及文本的语义内容等多模态信息中提取关键线索,并尝试将这些线索进行整合和分析,进而做出关于情感类别的准确判断。

根据RAVDESS测试数据显示,R1-Omni模型的WAR达到44.69%,UAR达到了43.00%,其泛化能力也明显优于其他模型。

(文:AIGC开放社区)