新智元报道

新智元报道

【新智元导读】路由LLM是指一种通过router动态分配请求到若干候选LLM的机制。论文提出且开源了针对router设计的全面RouterEval基准,通过整合8500+个LLM在12个主流Benchmark上的2亿条性能记录。将大模型路由问题转化为标准的分类任务,使研究者可在单卡甚至笔记本电脑上开展前沿研究。这一突破不仅为学术界提供了低门槛的研究工具,更为大模型性能优化提供了新的思路:通过智能调度实现异构模型的协同增效,以极低的计算成本突破单一模型的性能上限。

为突破这些限制,路由LLM(Routing LLM)范式应运而生——通过智能调度实现多个开源小模型的协同增效,以「组合创新」替代「规模竞赛」。

代码:https://github.com/MilkThink-Lab/RouterEval

论文: https://arxiv.org/abs/2503.10657

论文合集:https://github.com/MilkThink-Lab/Awesome-Routing-LLMs

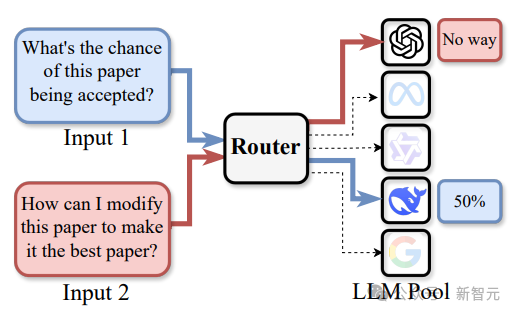

路由LLM实际上是model level的MoE(Mixture-of-Experts),传统MoE通过在模型内部扩展专家网络(如稀疏激活的FFN层)提升性能,而路由LLM将完整LLM视为独立「专家」,通过预训练Router动态分配任务输入。

三个大模型=OpenAI

这种范式具有三重优势:

-

异构兼容性:支持闭源模型(如GPT-4)、开源模型(如Llama系列)及专用微调模型的混合部署。

-

多目标优化:可根据场景需求,在性能、成本、风险控制等维度实现动态权衡

-

灵活部署:可根据实际需求动态调整候选模型池,针对特定场景(如代码生成、医疗问答)快速定制专属解决方案,而无需从头训练大模型

-

输入层:接收多样化的用户请求,包括文本生成、文本摘要、代码补全等任务

-

路由层:通过预训练Router对输入进行深度分析,基于多维度特征选择最优LLM执行器

-

执行层:由候选LLM池中被选定的模型完成实际推理,并将结果返回给用户

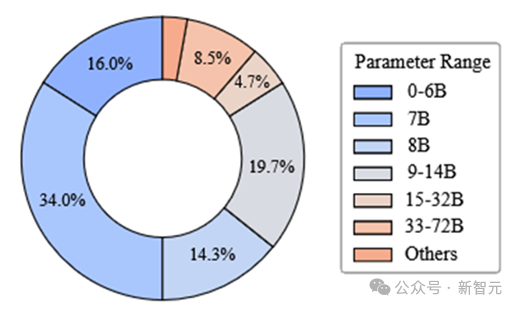

研究人员系统性收集、整理并开源了涵盖8567个不同LLM在12个主流评测基准(包括MMLU、GSM8K等)下的2亿条性能记录,基于这些数据构建了面向 router的基准测试平台RouterEval,创新性体现在:

-

数据完备性:覆盖从7B到数百B参数规模的LLM,涵盖通用能力、领域专长等多维度的 Benchmark,为router设计提供了全面的训练与验证数据

-

研究低门槛化:所有性能记录均已预处理完成,研究者只需训练一个分类器(即router)即可开展实验,支持在单卡GPU甚至笔记本电脑上运行,极大降低了参与门槛

-

问题范式转化:将复杂的路由LLM问题转化为标准的分类任务,使研究者可复用成熟的机器学习方法(如few-shot learning、对比学习等)快速切入

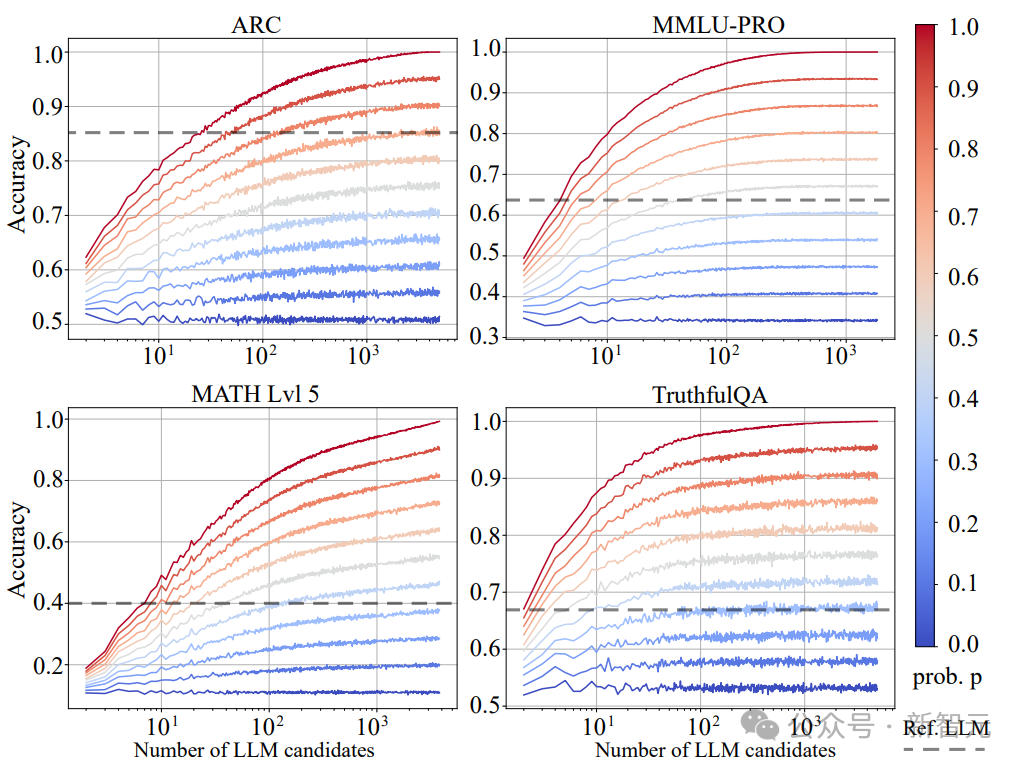

Model level scaling up现象

-

当p→1时,r_o(p)趋近于Oracle Router,代表分类性能接近理论上限 -

当p→0时,r_o(p)退化为随机router,即随机选择候选LLM -

中间状态r_o(p)(0<p<1)模拟了不同能力水平的 router

-

强router的scaling up效应:当p>0.3时,系统性能随候选LLM数量呈明显快速上升

-

弱router的性能瓶颈:随机router(p=0)几乎未表现出scaling up现象

-

超越参考模型:一般候选LLM数量在3~10且p在0.5~0.7时,系统性能可以接近甚至超过参考模型(参考模型一般是GPT-4)

弱模型逆袭效应

候选池规模阈值

-

3-5个候选LLM:可覆盖大部分常见任务需求,部署成本相比单一顶级模型低。

-

5-10个候选LLM:性能进入稳定提升期,在多数基准上可超越GPT-4等顶级单体模型

-

多于10个候选LLM:性能增益存在边际效应,每增加1个模型带来的性能提升并不大

数据壁垒

多候选分类挑战

多目标权衡局限

虽然路由LLM理论上可以同时优化性能、计算成本和幻觉风险等多个目标,但RouterEval目前仅聚焦于性能优化。这是因为当前router的性能水平尚未达到理想状态,过早引入多目标优化可能会分散研究重点。此外,计算成本和幻觉风险等指标的数据采集难度较大,需要社区共同推动相关数据集的构建;

部署复杂度

(文:新智元)