如果在短视频或者社交媒体上,刷到这条视频,我大概会津津有味看完,然后回想这是《猫和老鼠》哪一集。

哪一集都不是,这不仅完全是 AI 生成的,而且是一次性完成。

视频生成一直以来都有一道「天堑」:时长。市面上主流的生成式视频产品,都是以秒为单位,能超过 10 秒就相当不错了,还暂且不谈这十秒里画面崩不崩。

这使得在实际使用中,还是需要剪辑、拼接那些几秒几秒的短镜头。这是目前的技术上限所致,没办法。

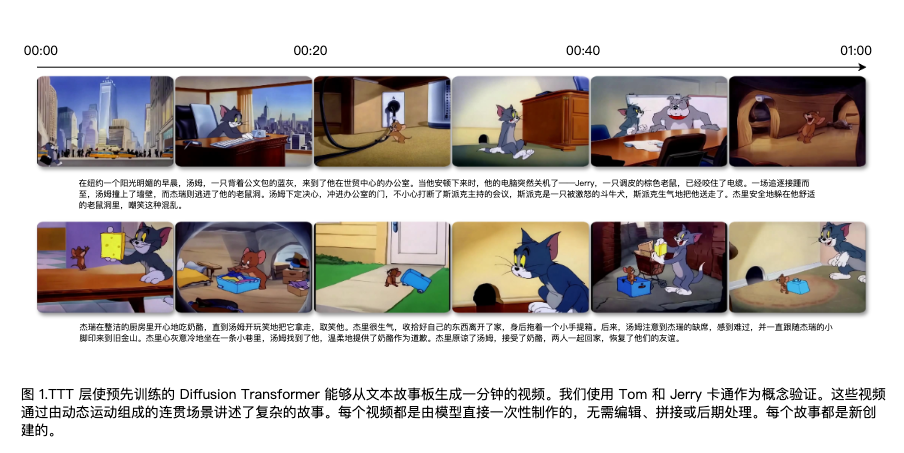

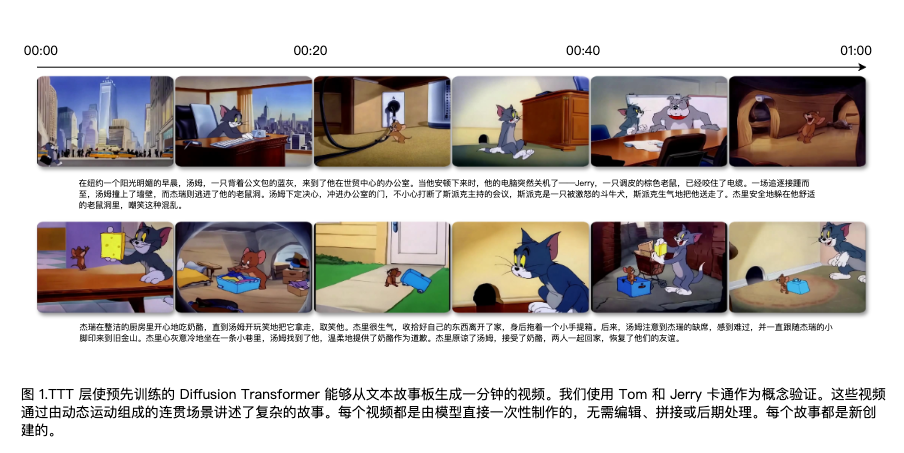

伯克利、斯坦福联合英伟达的最新研究,惊人地把一次性生成时长推到了 1 分钟,无剪辑,却仍然保持逆天的一致性。

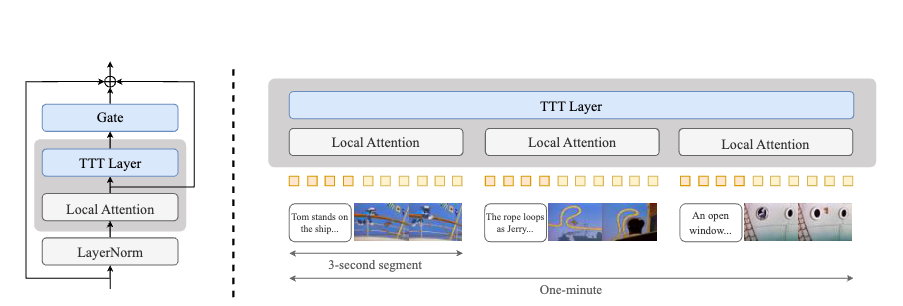

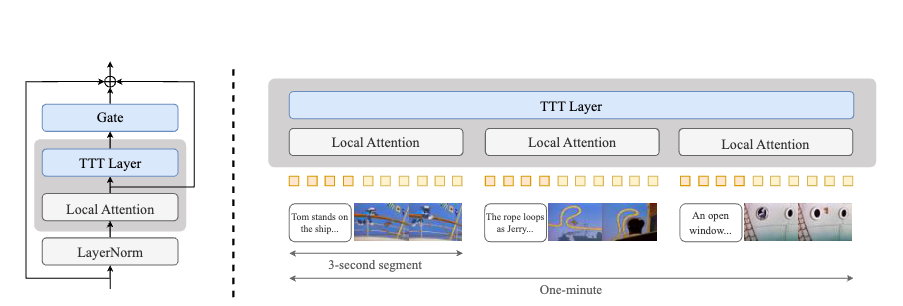

通过引入测试时训练(Test-Time Training, TTT)层,显著提升了扩散 Transformer 模型生成长视频的能力,使其能够生成长达一分钟、具有复杂多场景故事的连贯视频。

传统 RNN 层(如 Mamba、DeltaNet)的隐藏状态为固定大小的矩阵(例如线性投影),rank 限制了压缩长序列信息的能力。当处理包含数十万视频令牌的上下文时,矩阵的线性表达能力不足以捕捉复杂的时空依赖关系。

聚焦在 TTT 层的创新之处有于,以隐藏状态作为神经网络。在传统的 RNN 中,隐藏状态是用来存储过去信息的,比如之前的输入如何影响当前输出。

通常,这个记忆是一个固定大小的表格(比如数字矩阵),只能简单记录过去的信息,可能不够灵活。但在这项研究中,作者将隐藏状态设计成了一个神经网络,这意味着这个「存储空间」本身具有学习能力。

每当处理新的视频片段时,这个程序会通过练习来调整自己。比如,它会尝试修复模糊的画面(自监督任务),根据修复的效果修改自己的内部参数(用梯度下降法)。

同时,处理每一段视频时,神经网络都会根据当前内容调整参数。就像人在做数学题时,每做一题都会总结方法,下一题用改进后的方法一样。

这样,模型就能记住更复杂的场景变化(比如猫追老鼠的连贯动作),生成长达一分钟的流畅视频。

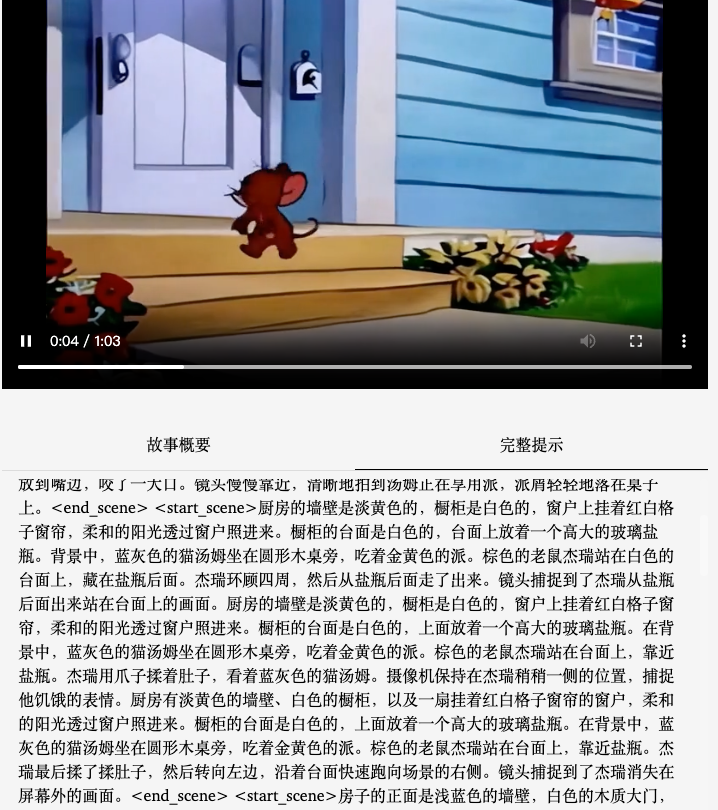

为了检验成果,研究人员用了《猫和老鼠》作为材料。他们收集了 1940-1948 年间,发布的 81 集原版动画,总共超过 400 分钟。扫描原胶片,保留手绘动画的线条和抖动特征。

人工标注团队依据镜头连续性,将平均每 5 分钟的剧集,分割为 8-12 个场景。并且在这个环节,通过切割和标注的方式,模拟人类编剧从分镜到剧本的创作过程,使模型学习叙事层次结构。

整整一分钟的视频,基本完成了剧本中所要求的情节,除了一些转折处有不自然,整个故事的完整性没有问题。

场景一致性、运动自然性都有惊人的表现。如追逐的场景,各个物体的属性、颜色、形状,以及和空间布局一致性都没有崩坏,证明了模型长期记忆的能力。

想象一下动画片里汤姆追逐杰瑞的经典场面:汤姆可不是简单地直线跑,他会急刹车、猛转弯、跳起来躲避障碍,甚至被砸扁后像弹簧一样恢复。

这些看似夸张混乱的动作,其实也包含物理逻辑。但要让 AI 理解这种复杂的动态场景并不容易。

过去 AI 模型(比如用到MLP技术的)需要学会描绘这种「不走直线」的运动轨迹。

现在 AI 有了一支灵活的「画笔」(MLP的隐藏状态),让它能捕捉汤姆突然加速、变向、摔倒滚成球等各种非线性的、但又符合物理规律的运动变化,而不是只能画直线。

前面提到的 TTT 层,核心创新就像给汤姆加了一个「外挂」,让他拥有超强的「临场反应」能力,能根据实时路况(新数据)微调自己的动作。

比如汤姆能看到香蕉皮的那个瞬间(测试时),立刻调整自己的脚步和姿势(动态调整神经网络参数),试图躲开或者以一种夸张的方式滑倒(上下文自适应)。

他不再靠以前摔倒的经验(静态训练好的模型),而是当场学习和反应(测试时自监督学习)

不过,基础模型,本身对复杂动作的学习不够完美,即使加了 TTT 层,有些错误还是会出现。

对于模型能力而言,如何提高视觉处理能力,始终是一个「长期主义」任务。

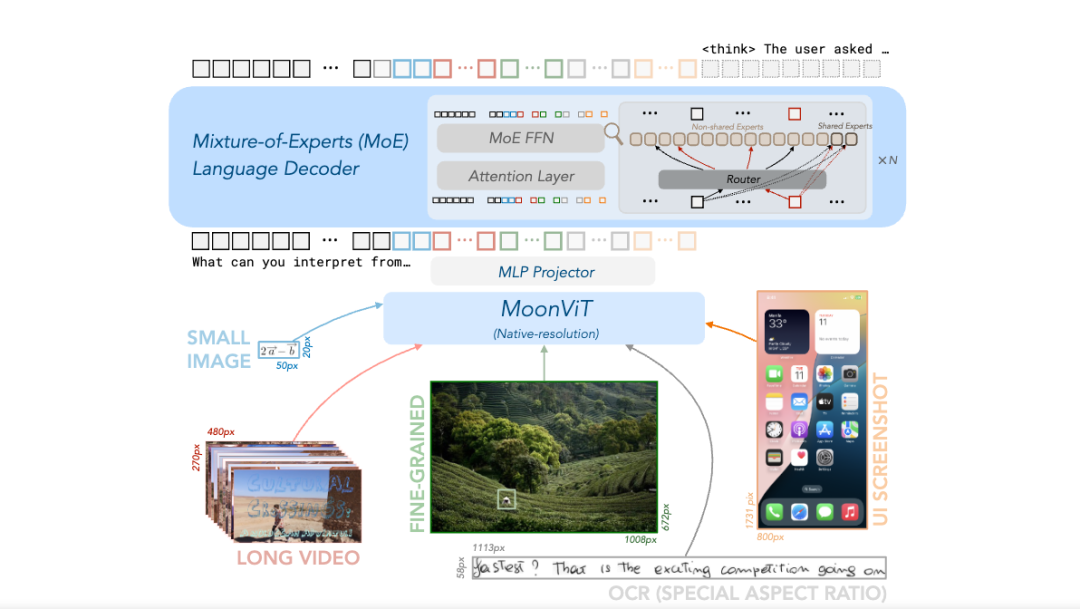

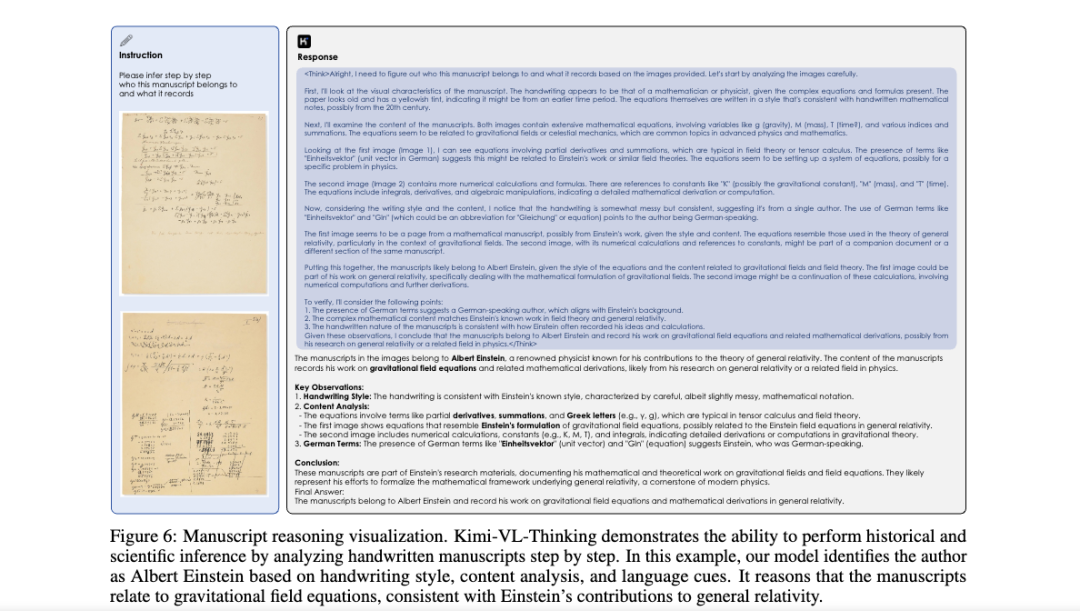

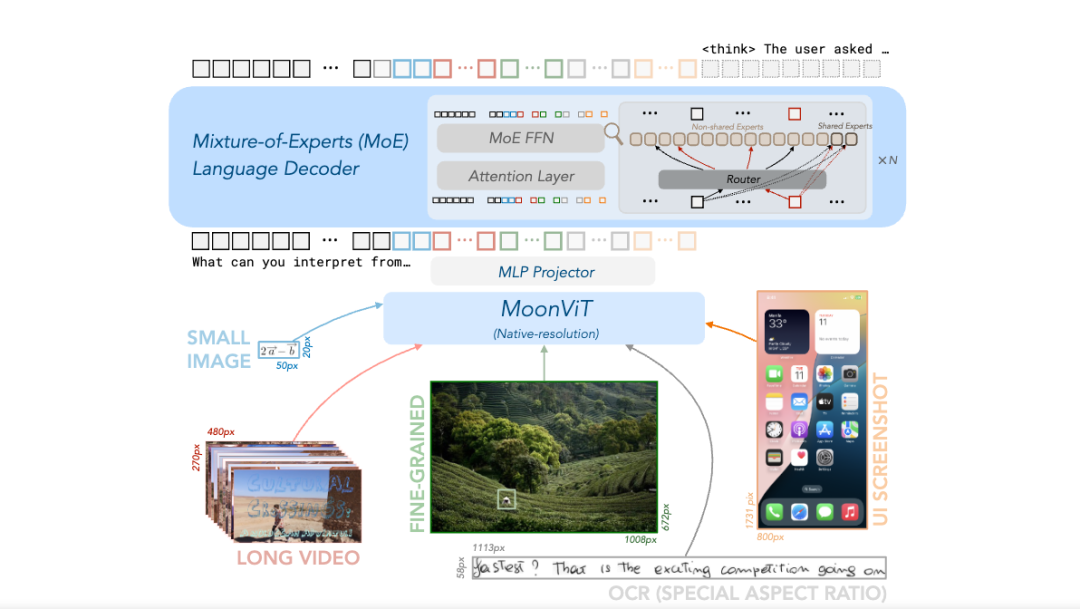

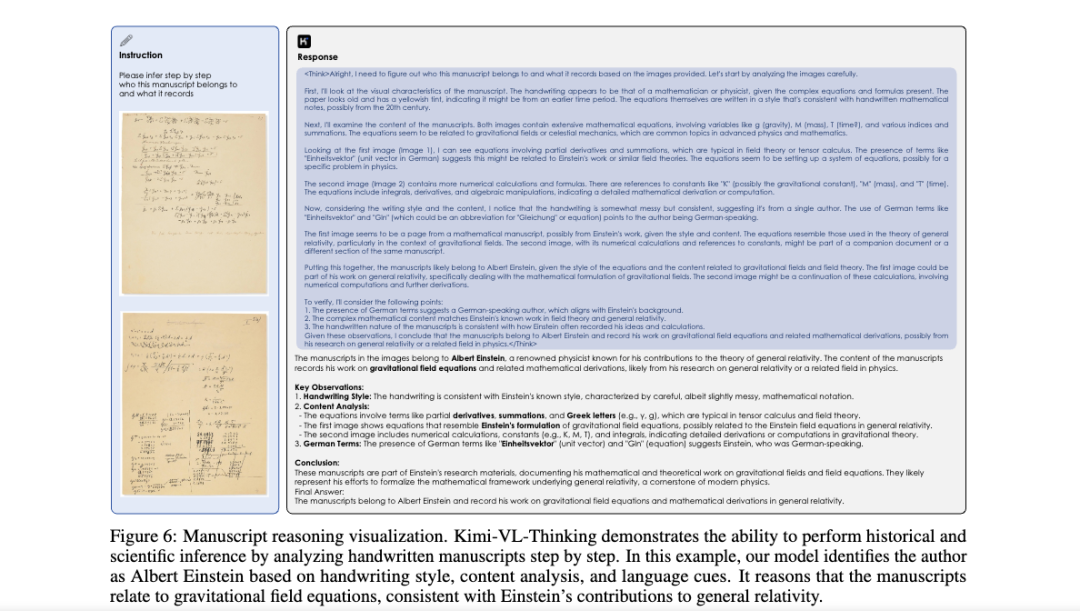

Kimi 新开源的 Kimi-VL,就是在模型的视觉能力上继续钻研提高。在这次开源的论文中可以看到,Kimi 用原生高分辨率视觉编码器 MoonViT,来突破传统视觉编码的限制。

传统方法(如 LLaVA-OneVision)需将高分辨率图像分割为子图再拼接,导致信息丢失和计算冗余。

MoonViT 基于 NaViT 的打包策略,将不同分辨率的图像拆分为块并展平为序列,结合 2D 旋转位置编码(RoPE),直接处理原生分辨率图像,保留细粒度视觉信息。

用人话来说,汤姆过去想抓住杰瑞,只能通过好几个小窗户去看一个大房间( LLaVA-OneVision)。

MoonViT 就像给汤姆换上了一副超高清、广角、还能自动变焦的「超级眼镜」。

他可以直接看到整个房间(处理原生高分辨率图像),无论是墙上的小洞还是桌上的面包屑都一清二楚(保留细粒度信息),而且看得又快又好。

同时,Kimi 首次将 MoE 深度整合到视觉语言模型,跨模态的专家协作,能让语言模型在保留纯文本能力(如代码生成)的同时,激活视觉专家处理图像、视频等多模态输入。

对于视觉-语言的多模态任务而言,模型架构层的研究至关重要,因为多模态数据的异质性、交互复杂性以及任务多样性对模型的表示能力、计算效率和泛化性提出了独特挑战。

想让 AI 能看、能听、能跑、能思考,它的内部模型架构就至关重要。

你不能简单地把眼睛(视觉模块)和耳朵(音频模块)、大脑(语言处理)零件堆在一起。

必须精心设计它们如何连接、如何协同工作(融合异构数据、跨模态关联),才能让 AI 流畅地根据看到的画面和听到的声音做出反应,甚至理解一个包含画面和对话的故事。

更复杂的是,当我们要让 AI 生成长视频时,它不仅要保证画面好看,还得让整个故事情节前后连贯,讲一个完整的故事而不是随意堆砌场景,一分钟的 AI版《猫和老鼠》还是一个雏形。

未来,随着 3D 视觉、音频等多模态扩展,架构研究需进一步探索,跨模态动态路由,结合 TTT 思想设计跨模态交互层,或进一步优化隐藏状态的表达能力(如引入 Transformer 作为隐藏网络),或许是多模态模型架构研究的重要方向。

当大模型拥有了这全套「感官」,那些能帮我们干活但稍显愚蠢的通用 AI Agent ,可用性也将大大提升。

✉️ 邮件标题「姓名+岗位名称」(请随简历附上项目/作品或相关链接)

✉️ 邮件标题「姓名+岗位名称」(请随简历附上项目/作品或相关链接)