📢本周AI快讯 | 1分钟速览🚀

1️⃣ 🧠 ChatGPT 全局记忆上线 :OpenAI 为付费用户推出全局记忆功能,模型可自动调用历史对话,增强个性化体验。

2️⃣ 🚫 GPT-4 即将退役 :4 月 30 日起,OpenAI 将在 ChatGPT 中停用 GPT-4,全新升级至更高效的 GPT-4o 模型。

3️⃣ ✨ 新模型 GPT-4.1 与 o 系列即将发布 :OpenAI 下周拟发布 GPT-4.1、o3 推理模型及轻量级 o4 mini 系列,强化实时推理与多云部署能力。

4️⃣ ⚠️ AI 安全测试大幅缩短 :OpenAI 将 LLM 安全审查周期从数月压缩至数天,引发业界对 AI 安全风险担忧。

5️⃣ 💻 xAI Grok 3 API 正式开放 :马斯克旗下 xAI 推出 Grok 3 与 Grok 3 Mini API,支持 128K 上下文窗口,定价公开。

6️⃣ 🛠️ 谷歌发布 Firebase Studio 云端 IDE :整合 Gemini AI 模型,一键生成代码、快速搭建并部署全栈应用。

7️⃣ 🤖 谷歌开源 Agent2Agent 智能体协议 :发布 A2A 标准,推动多个 AI 智能体跨平台协作,目前已获 50 多家厂商支持。

8️⃣ 🔗 谷歌 Gemini 模型接入 MCP 协议 :Gemini 全面支持 Anthropic 推出的 MCP 协议,标准化模型与外部工具连接方式。

9️⃣ 💎 Anthropic 推出高端订阅 Claude Max :月费最高 200 美元,提供高达 20 倍使用额度及最新功能优先访问权。

🔟 🐫 Meta 发布 Llama 4 系列模型 :首次引入混合专家架构,发布 Scout 与 Maverick,参数规模突破 4000 亿。

1️⃣1️⃣ ❗ Meta Llama 4 Maverick 测试成绩遭质疑 :公开版与测试版模型不一致,开发者质疑 Meta 存在“刷榜”行为。

1️⃣2️⃣ ⚡ 英伟达发布 2530 亿参数大模型 :开源 Llama-3.1-Nemotron Ultra 模型,推理效率直逼 DeepSeek-R1,适合 AI Agent 部署。

1️⃣3️⃣ 📑 WordPress AI 快速建站工具发布 :数分钟内即可生成完整博客或网站,目前处于早期访问阶段。

1️⃣4️⃣ 📊 斯坦福 AI 指数报告出炉 :中美模型质量差距缩小至 0.3%,AI 全球竞争持续加剧。

1️⃣5️⃣ 🔧 字节跳动发布 VAPO 强化学习框架 :显著提升大型模型复杂任务推理能力,Qwen2.5-32B 模型提升推理性能 12 倍,超越 DeepSeek-R1。

1️⃣6️⃣ 🌟 商汤发布 SenseNova V6 多模态大模型 :具备长思维链和全局记忆功能,参数量超 6000 亿,多模态推理能力突出。

1. ChatGPT 全局记忆功能上线

4 月 11 日,OpenAI 宣布为 ChatGPT Plus 和 Pro 订阅用户推出增强版 “全局对话内容记忆” 功能。该功能允许模型自动参考用户过往的所有对话记录,从而提供更贴合用户偏好和兴趣的个性化回应。无论是文本、语音还是图像交互,ChatGPT 现在都能在新对话中调用历史信息,提升整体交互的连贯性和效率。

此次更新在全球范围内逐步推送,但暂不包括英国、欧盟、冰岛、列支敦士登、挪威和瑞士等地区,原因是这些地区需通过额外合规审查以满足当地法规。OpenAI 表示,未来将逐步实现服务覆盖。对于免费用户,OpenAI 尚未公布该功能的上线时间。

用户可在设置中启用或关闭此功能,并通过“管理记忆”选项查看、编辑或删除特定记忆内容。此外,用户还可以使用“临时对话”模式进行无痕交流,确保对话内容不会被存储。OpenAI 强调,用户拥有对记忆功能的完全控制权,以保障隐私和数据安全。

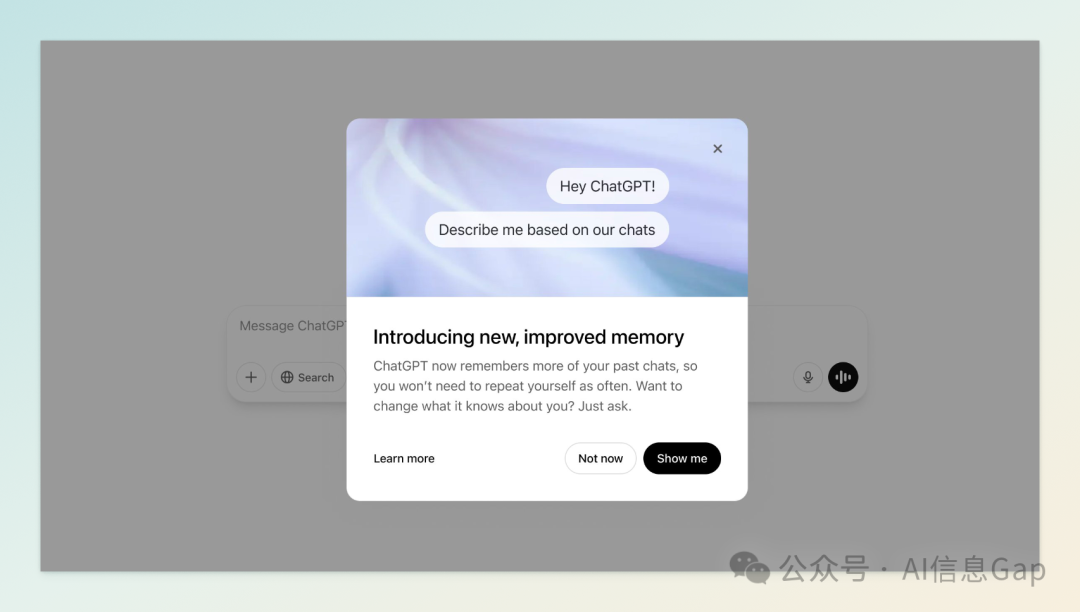

2. OpenAI 宣布自 4 月 30 日起停用 GPT-4 模型

4 月 11 日,OpenAI 宣布,将于 4 月 30 日起从 ChatGPT 中移除原有的 GPT-4 模型,全面升级至新一代多模态模型 GPT-4o。GPT-4o 具备处理文本、图像和音频的能力,响应速度是 GPT-4 Turbo 的两倍,且成本降低了 50%。

GPT-4o 在性能上实现了显著提升,支持更长的上下文窗口(128K tokens),并在多语言处理、视觉理解和语音识别等方面表现优异。此外,GPT-4o 在推理能力、响应速度和计算效率上均优于前代模型,适用于更广泛的应用场景。

值得注意的是,GPT-4 模型仍将继续在 API 中提供,供开发者和企业使用。

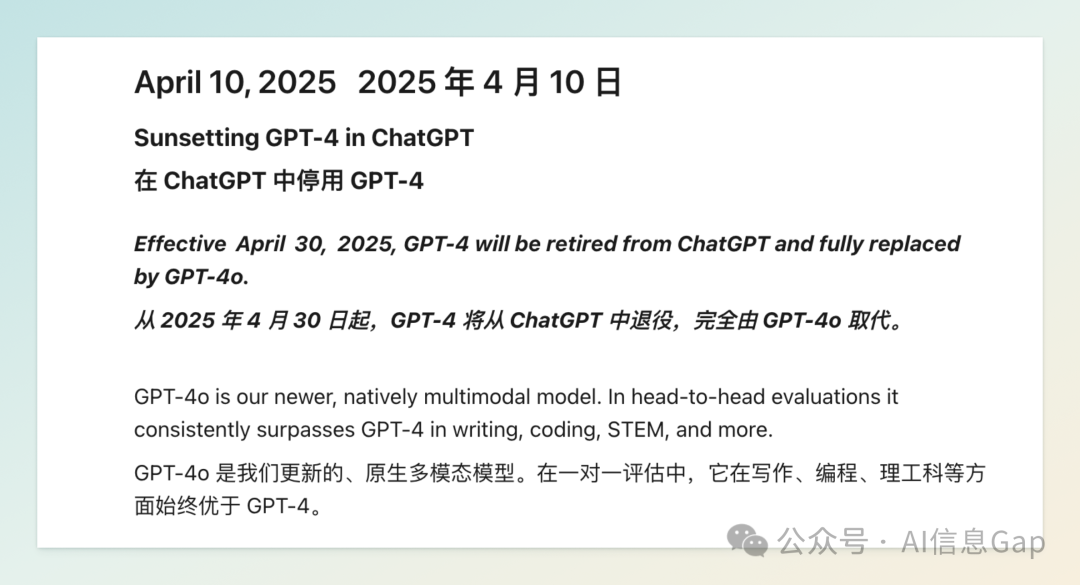

3. OpenAI 多款新模型即将发布:GPT-4.1 与 o 系列

4 月 10 日,OpenAI 被曝计划于下周推出多款全新 AI 模型,包括升级版的 GPT-4.1、完整版的 o3 推理模型以及轻量级的 o4 mini 系列。其中,GPT-4.1 被视为现有多模态模型 GPT-4o 的增强版本,预计在音频、视觉和文本的实时处理能力上进一步提升。此外,OpenAI 还计划同步推出更小型的 GPT-4.1 mini 和 nano 版本,以满足不同设备和应用场景的需求。

AI 工程师 Tibor Blaho 近日在新版 ChatGPT 网页代码中发现了 o3、o4 mini 和 o4 mini high 的相关引用,暗示这些模型的发布已进入最后阶段。o3 模型被认为是 OpenAI 在推理能力上的重大突破,旨在提升模型在复杂逻辑任务中的表现。而 o4 mini 系列则主打轻量化和多云部署,适用于资源受限的设备和场景。

值得注意的是,由于近期 OpenAI 面临算力资源紧张的问题,部分新模型的发布可能会有所延迟。Sam Altman 此前也提醒用户,未来的产品发布可能会遇到服务延迟或功能不稳定的情况。

4. OpenAI 安全测试时间大幅缩短,AI 风险隐患加剧

4 月 11 日,《金融时报》报道,OpenAI 最近将其大型语言模型(LLM)o3 的安全测试时间从以往的数月缩短至仅几天。此举引发了业界对模型安全性和潜在风险的广泛关注。

长期以来,AI 安全专家和监管机构一直强调,类似药品和航空器的安全性,LLM 的安全性也应通过严格的独立测试来确保。然而,OpenAI 的这一做法被批评为“以速度取代安全”,可能导致模型在发布前未经过充分的安全验证,增加了被滥用或产生不良后果的风险。

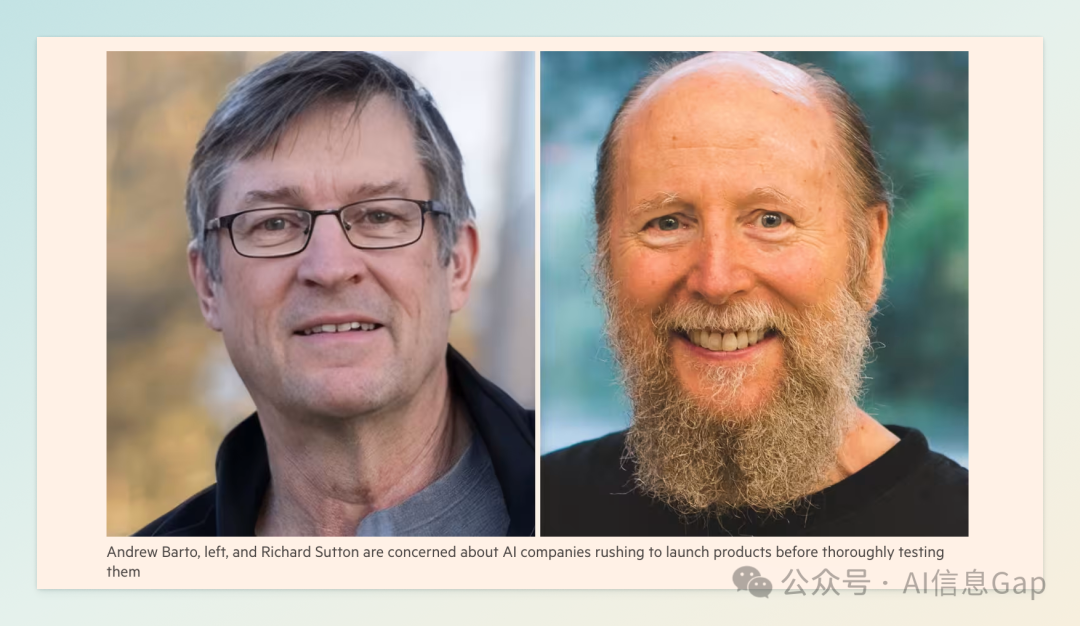

此外,强化学习领域的两位图灵奖得主 Andrew Barto 和 Richard Sutton 也对 AI 模型的快速部署表示担忧。他们指出,科技公司在追求商业利益的驱动下,往往忽视了充分测试和安全保障的重要性,可能导致严重的社会风险。

5. xAI 推出 Grok 3 API 接口

4 月 10 日,马斯克旗下人工智能公司 xAI 正式开放了其旗舰模型 Grok 3 及轻量版 Grok 3 Mini 的 API 接口,实际上早在 2 月 17 日 xAI 就正式发布了 Grok 3 模型。此次发布的 API 提供标准版和加速版两种选择,分别适用于高性能需求和成本敏感型场景。

定价与上下文窗口

-

Grok 3: -

标准版:输入每百万词元(token)3 美元,输出 15 美元 -

加速版:输入 5 美元,输出 25 美元 -

Grok 3 Mini: -

标准版:输入 0.3 美元,输出 0.5 美元 -

加速版:输入 0.6 美元,输出 4 美元

两者均支持最大 131,072(128K)tokens 的上下文窗口,约合 9.75 万字,虽未达到此前宣称的百万 token 处理能力,但已处于行业领先水平。

模型能力与应用场景

Grok 3 主打高阶推理能力,适用于数据提取、编程、文本摘要等复杂任务;而 Grok 3 Mini 则更适合处理逻辑清晰、领域知识要求较低的任务。加速版则进一步降低了响应延迟,提升了交互体验。

6. 谷歌发布 Firebase Studio:AI 驱动的云端 IDE

4 月 9 日,谷歌在 Cloud Next 大会上正式推出了全新的云端集成开发环境(IDE)——Firebase Studio。这款工具旨在通过集成生成式 AI 技术,简化全栈应用的开发与部署流程,帮助开发者在浏览器中高效完成从原型设计到上线的全过程。

Firebase Studio 的核心亮点在于深度集成了谷歌的 Gemini AI 模型,提供自然语言生成代码、代码解释、调试建议等功能。开发者可以通过描述需求或上传草图,快速生成基于 Next.js 的 Web 应用原型,并利用内置的代码编辑器进行实时修改。此外,平台支持从 GitHub、GitLab 等代码仓库导入项目,兼容多种技术栈,包括 Flutter、Node.js、Python Flask 等。

在部署方面,Firebase Studio 提供了一键发布功能,支持将应用部署到 Firebase App Hosting 或 Cloud Run,自动配置 CDN、SSL 证书等基础设施。目前,该工具处于预览阶段,免费提供 3 个工作空间,加入 Google 开发者计划可扩展至 10 个,付费计划最高支持 30 个工作空间。对于希望快速构建 AI 应用的个人开发者和小型团队而言,Firebase Studio 无疑是一个值得关注的新选择。

7. 谷歌发布 Agent2Agent 智能体互联协议

4 月 9 日,谷歌在 Cloud Next 大会上正式发布并开源了 Agent2Agent(A2A)协议。这一开放标准旨在打破不同 AI 智能体之间的壁垒,实现跨平台、跨框架的无缝协作。A2A 协议基于 HTTP、JSON-RPC 和 SSE 等成熟技术,支持文本、音频、视频等多种交互模式,并内置企业级身份验证与授权机制,确保通信的安全性和可靠性。

A2A 的核心组件包括“Agent Card”(代理卡片),用于描述智能体的能力和接口,以及任务管理机制,支持任务的创建、执行、状态更新和结果反馈。通过这些标准化的定义,不同的智能体可以自动发现彼此的功能,协商任务分配,并协同完成复杂的工作流程。例如,在企业场景中,招聘智能体可以通过 A2A 协议与日程安排智能体和背景调查智能体协作,自动完成候选人的筛选、面试安排和背景核查等流程。

值得注意的是,A2A 协议并非孤立存在,而是与 Anthropic 提出的 Model Context Protocol(MCP)形成互补。MCP 主要解决单个智能体如何调用外部工具和获取上下文的问题,而 A2A 则关注多个智能体之间的直接通信与协作。谷歌表示,这两者的结合将为构建更强大、通用的 AI 系统提供坚实的基础。

目前,已有包括 Salesforce、SAP、ServiceNow、MongoDB 等在内的 50 多家技术合作伙伴支持 A2A 协议。谷歌已将该协议以 Apache 2.0 许可证开源,开发者可以通过 GitHub 获取相关文档和示例代码。A2A 的推出标志着 AI 智能体从孤立系统迈向开放协作生态的重要一步,预示着一个更加互联、协同的智能体时代的到来。

8. 谷歌官宣 Gemini 模型接入 MCP 协议

继 OpenAI 宣布支持竞争对手 Anthropic 推出的 Model Context Protocol(MCP)后,谷歌也迅速跟进。4 月 10 日,谷歌 DeepMind CEO Demis Hassabis 在 X 平台发文,确认 Gemini 模型及其 SDK 将集成 MCP 协议,旨在提升 AI 智能体与外部工具和数据源的互操作性。

MCP 是由 Anthropic 于 2024 年底推出的开放协议,旨在标准化大语言模型(LLM)与外部资源的连接方式。通过 MCP,开发者可以为 AI 模型提供统一的接口,简化与各种数据源和工具的集成过程。这一协议被业界誉为“AI 应用的 USB-C 接口”,其核心优势在于提供通用的连接标准,降低集成复杂度。

谷歌的快速响应显示出对开放标准的高度重视。此前,OpenAI 已在其 Agents SDK 中添加对 MCP 的支持,并计划将其扩展至 ChatGPT 桌面应用和 Responses API。随着两大 AI 巨头的加入,MCP 有望成为 AI 代理生态系统中的事实标准,推动智能体从“孤岛”走向“互联”。

目前,开发者已可在 Gemini API 文档中找到集成 MCP 的示例代码。

9. Anthropic 推出 Claude Max 高端订阅:月费最高达 200 美元

4 月 9 日,Anthropic 正式推出了 Claude Max 订阅计划,旨在满足专业用户对更高使用额度和优先功能访问的需求。该计划分为两个层级:每月 100 美元的方案提供比 Pro 计划高出 5 倍的使用额度,而每月 200 美元的方案则将使用额度提升至 Pro 计划的 20 倍。订阅者还将获得对最新功能和模型的优先访问权,以及在高峰时段的流量优先级。

此次推出的 Max 计划正值 Anthropic 发布其最新模型 Claude 3.7 Sonnet 之际,该模型具备“扩展思维”能力,能够处理更复杂的任务。Anthropic 表示,Max 计划旨在为那些将 Claude 深度集成到工作流程中的专业用户提供更大的灵活性和支持。这一举措也被视为对 OpenAI 的 ChatGPT Pro 计划的直接回应,后者同样定价为每月 200 美元。

目前,Claude Max 计划已在所有支持 Claude 的地区上线,用户可通过 Claude 官方网站进行订阅。Anthropic 还表示,未来可能会根据用户反馈,推出更多层级的订阅选项,以满足不同用户的需求。

10. Meta 发布 Llama 4 系列模型

4 月 6 日,Meta 正式发布了其最新的 Llama 4 系列 AI 模型,包括 Llama 4 Scout、Llama 4 Maverick 和仍在训练中的 Llama 4 Behemoth。这是 Meta 首次在其模型中引入混合专家(Mixture of Experts,MoE)架构,旨在提升模型在训练和推理过程中的效率。

混合专家架构通过将模型划分为多个专注于特定任务的“专家”子模型,使得在处理用户查询时,仅激活相关的专家子模型,从而提高计算效率并降低资源消耗。例如,Llama 4 Maverick 拥有 128 个专家子模型,总参数量为 4000 亿,但在推理时仅激活约 170 亿个参数;而 Llama 4 Scout 配备了 16 个专家子模型,总参数量为 1090 亿,活跃参数同样为 170 亿。

在性能方面,Llama 4 Maverick 在图像定位、推理和编码等任务中表现出色,超越了 OpenAI 的 GPT-4o 和谷歌的 Gemini 2.0 Flash 等模型。而 Llama 4 Scout 则在文档总结和基于大型代码库的推理任务中展现了强大的能力,支持处理高达 1000 万个词元的上下文窗口。

此外,Meta 还预告了正在训练中的 Llama 4 Behemoth 模型,该模型拥有 16 个专家子模型,总参数量接近 2 万亿,活跃参数为 2880 亿。根据 Meta 的内部基准测试,Behemoth 在解决数学问题等 STEM 领域的评估中,表现优于 GPT-4.5、Claude 3.7 Sonnet 和 Gemini 2.0 Pro,但略逊于 Gemini 2.5 Pro。

目前,Llama 4 Scout 和 Llama 4 Maverick 已在 Hugging Face 平台上线,供开发者和研究人员使用。

11. Meta 新旗舰模型 Llama 4 Maverick 测试成绩遭质疑

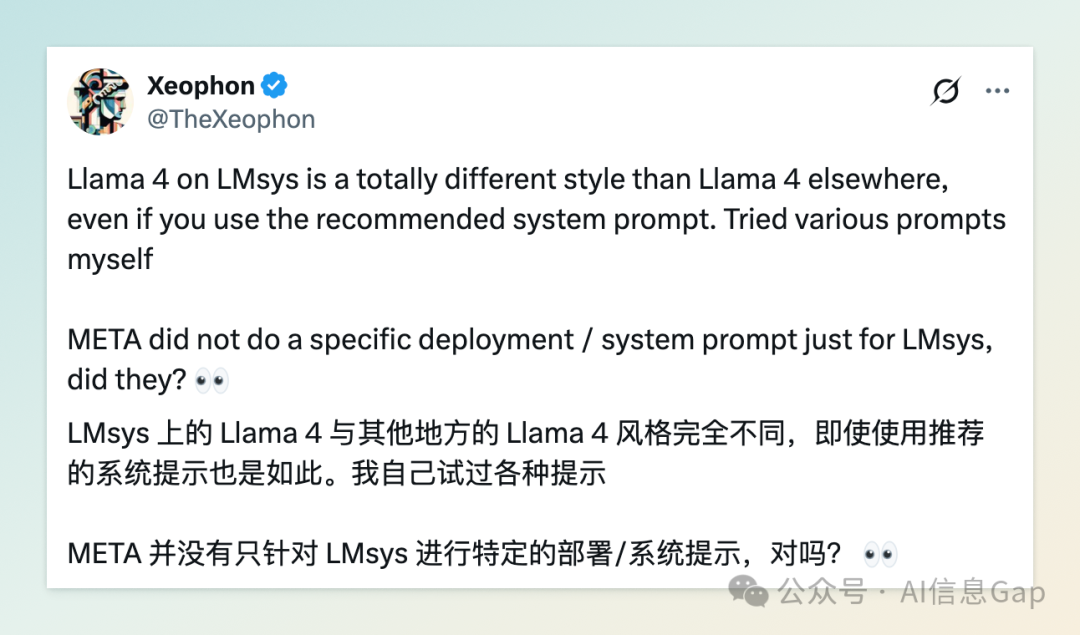

4 月 6 日,Meta 发布了其新一代开源大模型 Llama 4 系列,其中的旗舰模型 Maverick 在 LM Arena 测试中取得了第二名的成绩。然而,这一成绩的含金量引发了广泛质疑。

多位 AI 研究人员指出,Meta 在 LM Arena 上部署的 Maverick 版本与公开提供给开发者的版本并不一致。具体而言,LM Arena 使用的是一个名为 Llama-4-Maverick-03-26-Experimental 的实验性聊天版本,经过专门优化,以适应 LM Arena 的测试环境和评分标准。该版本在回答时更倾向于使用大量表情符号,且回答内容冗长,风格更贴近真人对话。

LM Arena 官方在社交媒体上回应称,Meta 对其政策的理解与平台对模型提供商的预期不符,Meta 本应更明确地说明该版本是一个针对人类偏好优化的定制模型。LM Arena 表示,将会添加 Maverick 的公开版本,并更新排行榜政策,以强化公平、可重复评估性。

此外,开发者实测发现,Llama 4 Maverick 在实际应用中的表现并不如宣传中那么出色,甚至问题百出。在专注于编程任务的基准测试中,Llama 4 Maverick 表现欠佳,落后于 GPT-4o、Grok 3、DeepSeek-V3 等模型。这一现象进一步加剧了对其“刷榜”行为的质疑。

Meta 生成式 AI 副总裁 Ahmad Al-Dahle 在社交平台上公开回应,否认了在测试集上进行模型训练的说法,称相关说法毫无事实依据。他表示,用户感知到的质量差异是由于稳定性还没有完全调整到位。

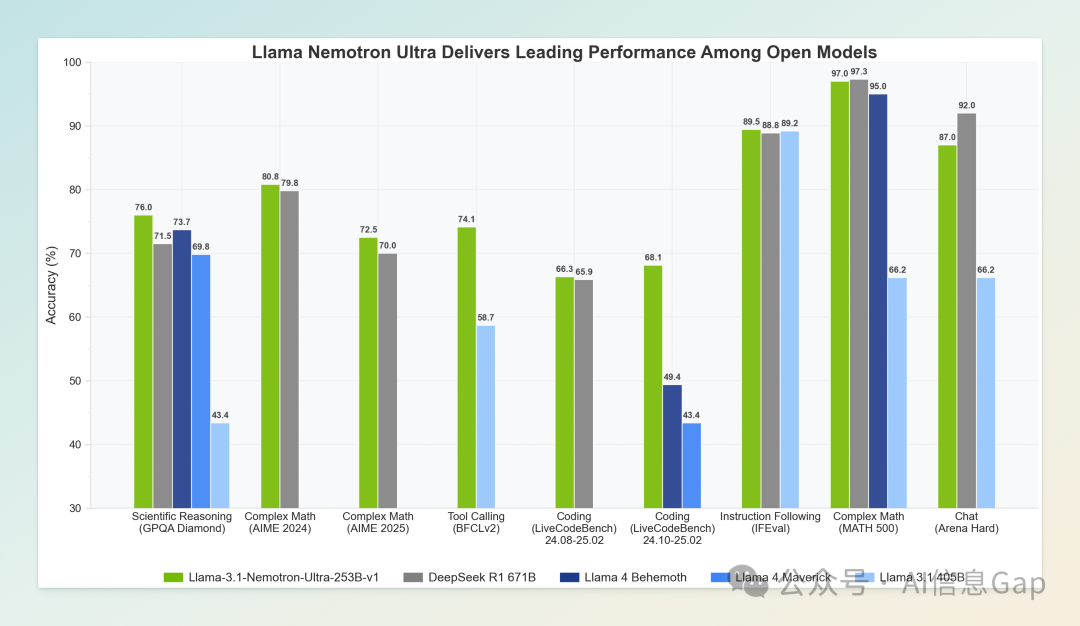

12. 英伟达发布 2530 亿参数大模型,推理效率直逼 DeepSeek-R1

4 月 8 日,英伟达正式开源了其 Llama Nemotron 系列中规模最大的推理模型 Llama-3.1-Nemotron-Ultra-253B-v1(简称 Ultra),该模型拥有 2530 亿参数,基于 Meta 的 Llama-3.1-405B-Instruct 蒸馏而来,专为推理、对话、RAG(检索增强生成)和工具调用等任务设计。得益于神经架构搜索(NAS)优化,Ultra 模型引入了跳跃注意力机制、前馈网络融合(FFN Fusion)等创新结构,在保持高性能的同时显著降低了内存占用和计算需求。该模型支持最长 128K 的上下文窗口,可在单个 8x H100 节点上高效部署,适配 Hopper 和 B100 架构,支持 BF16 和 FP8 精度。

在多项基准测试中,Ultra 模型表现出色:在 GPQA、IFEval 指令遵循和 LiveCodeBench 编码任务中超越了参数量高达 6710 亿的 DeepSeek-R1,推理吞吐量更是后者的四倍。值得注意的是,Ultra 模型支持通过系统提示词控制推理模式的开启与否,提升了模型的灵活性。目前,该模型已在 Hugging Face 平台开源,采用英伟达开放模型许可证,允许商业用途,适用于 AI Agent 系统、聊天机器人、RAG 系统等多种场景。

13. WordPress 推出 AI 网站构建器:几分钟生成完整博客

4 月 10 日,WordPress.com 推出了一款全新的 AI 网站构建器,用户只需通过聊天式界面输入几句话,即可在数分钟内生成包含完整内容、布局和图像的 WordPress 网站。该工具目前处于早期访问阶段,旨在帮助用户快速搭建个人博客、作品集或小型企业网站。

用户在使用时,只需描述网站类型、配色方案、业务名称等基本信息,AI 即可生成包含首页、图像和文本内容的完整网站。生成后,用户可以继续通过 AI 或手动方式对网站进行调整。目前,该工具仅支持新建网站,尚不支持电子商务功能或复杂集成。虽然试用免费,但要将网站上线,需订阅起价为每月 18 美元的 WordPress.com 主机计划。

14. 斯坦福《2025 年人工智能指数报告》:中美模型质量差距缩小至 0.3%

4 月 7 日,斯坦福大学以人为本人工智能研究所(Stanford HAI)发布了第八版《人工智能指数报告》(AI Index Report 2025),全面追踪了全球 AI 领域的技术进展、产业动态和政策趋势。报告显示,美国依然在顶尖 AI 模型数量上领先,2024 年共推出 40 个“值得关注的模型”,中国为 15 个,欧洲为 3 个。然而,在模型质量方面,中美差距显著缩小,顶级模型在 MMLU 和 HumanEval 等基准测试中的性能差异已从 2023 年的两位数降至 2024 年的 0.3%。

报告还指出,AI 研发的全球化趋势日益明显,中东、拉丁美洲和东南亚等地区也开始推出有影响力的新模型。此外,AI 在科学、医疗和教育等领域的应用不断扩展,推动了技术的多元化发展。尽管美国在私营部门 AI 投资方面仍占据主导地位,但全球范围内的竞争日益激烈,AI 技术的未来发展将更加依赖于国际合作与创新生态系统的建设。

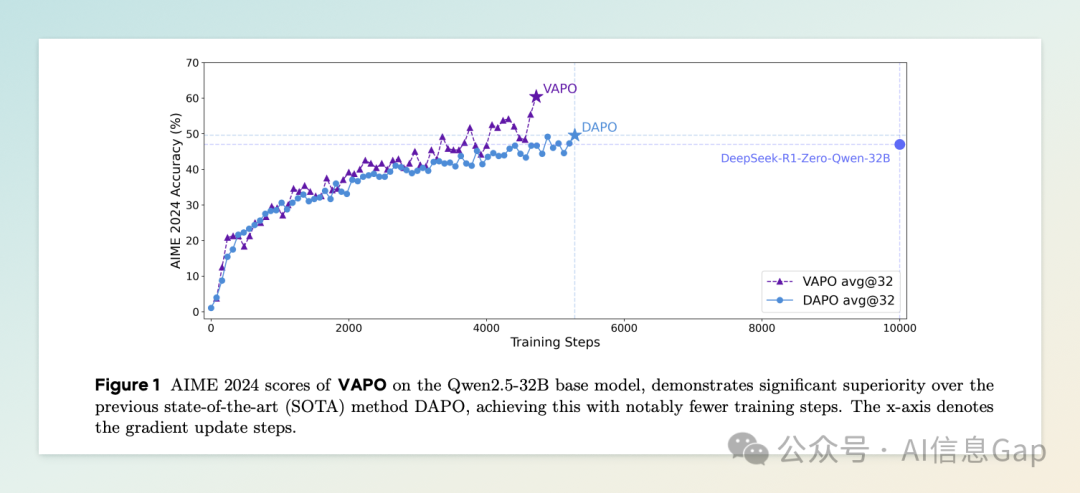

15. 字节跳动发布 VAPO 框架,提升模型推理能力

4 月 8 日,字节跳动旗下 Seed 研究团队正式发布了全新强化学习训练框架 VAPO(Value-based Augmented Proximal Policy Optimization),旨在提升大型语言模型在复杂、冗长任务中的推理能力。该框架通过引入基于价值的强化学习方法,优化了模型在长思维链(Long-CoT)任务中的表现,解决了传统强化学习在推理任务中面临的稳定性和泛化能力不足的问题。

在实际应用中,VAPO 框架被应用于 Qwen2.5-32B 模型的训练,显著提升了其在多个推理基准测试中的表现。例如,在 AIME 2024 数据集上,Qwen2.5-32B 模型的得分提升了 12 倍,超越了参数量高达 6710 亿的 DeepSeek-R1 模型。此外,VAPO 框架还引入了 Seed-Verifier 和 Seed-Thinking-Verifier 两种奖励建模机制,分别针对可验证和不可验证的问题,进一步增强了模型的推理能力和稳定性。

16. 商汤发布 SenseNova V6 多模态大模型

2025 年 4 月 10 日,商汤科技在技术交流日活动中正式发布了全新升级的多模态大模型体系 —— SenseNova V6(简称“日日新 V6”)。该模型在多模态推理、长思维链、全局记忆等核心能力上实现突破,标志着国内 AI 大模型在复杂任务处理能力上的新高度。

SenseNova V6 是一款原生多模态 MoE(混合专家)大模型,拥有超过 6000 亿参数,支持文本、图像、语音和视频的统一处理。其多模态推理能力对标 OpenAI 的 o1 模型,数据分析能力领先于 GPT-4o。在多项权威评测中,SenseNova V6 在纯文本和多模态任务中均表现出色,达到国际一流水平。

该模型支持最长 64K 的多模态思维链,能够处理长达 10 分钟的视频内容,并进行深度理解和推理。通过自研的视频压缩技术,SenseNova V6 将视频、语音、文字等信息对齐,形成统一的上下文表达,实现高效的多模态信息处理。

此外,商汤还发布了轻量级全模态交互模型 SenseNova V6 Omni,具备更强的感知和表达能力,已在角色扮演、翻译点读、文旅导游等场景中实现应用。同时,整合 SenseNova V6 全部能力的“商量”APP也已启动内测,用户可通过 Web 端体验文字、图像、视频等多模态交互功能。

商汤科技董事长兼 CEO 徐立表示:“AI 之道,在于百姓之日用。SenseNova V6 将跨越多模态边界,释放推理与智能的无限可能。”

我是木易,一个专注AI领域的技术产品经理,国内Top2本科+美国Top10 CS硕士。

相信AI是普通人的“外挂”,致力于分享AI全维度知识。这里有最新的AI科普、工具测评、效率秘籍与行业洞察。

欢迎关注“AI信息Gap”,用AI为你的未来加速。

(文:AI信息Gap)