于是,研究人员的主要目标是创建一个新系统,该系统可以根据用户提供的书面指令编辑所有人体动作,而无需特定任务的输入或身体部位规范。

他们希望该系统能够支持特定身体部位的变化(即空间编辑)和随时间变化的动作调整(即时间编辑),即使在有限的注释数据上进行训练,也能很好地推广到各种场景。

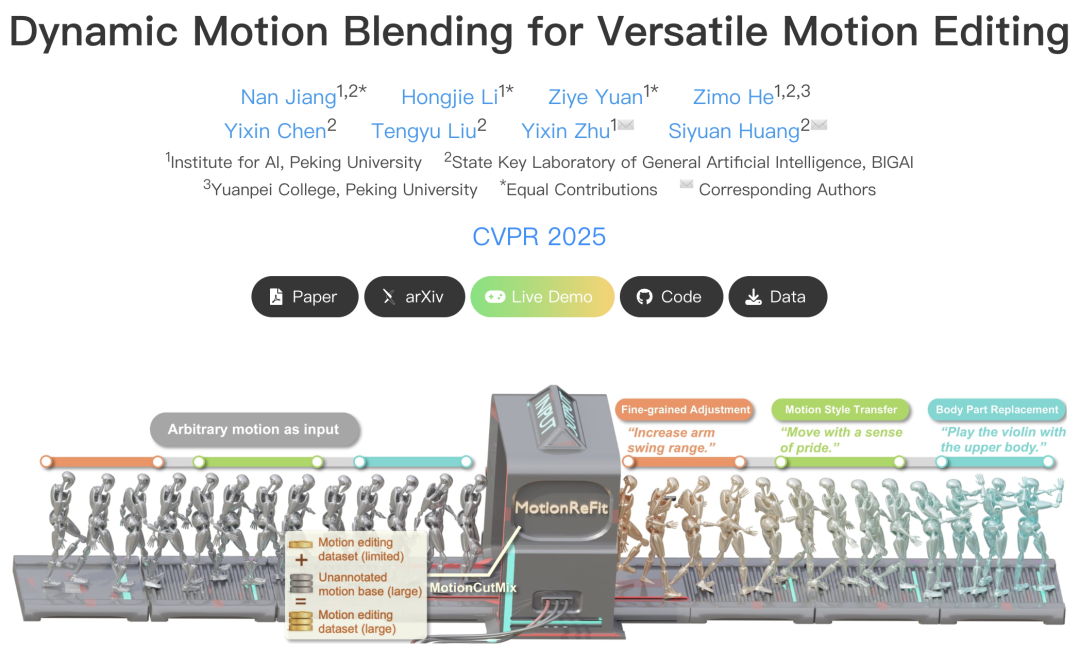

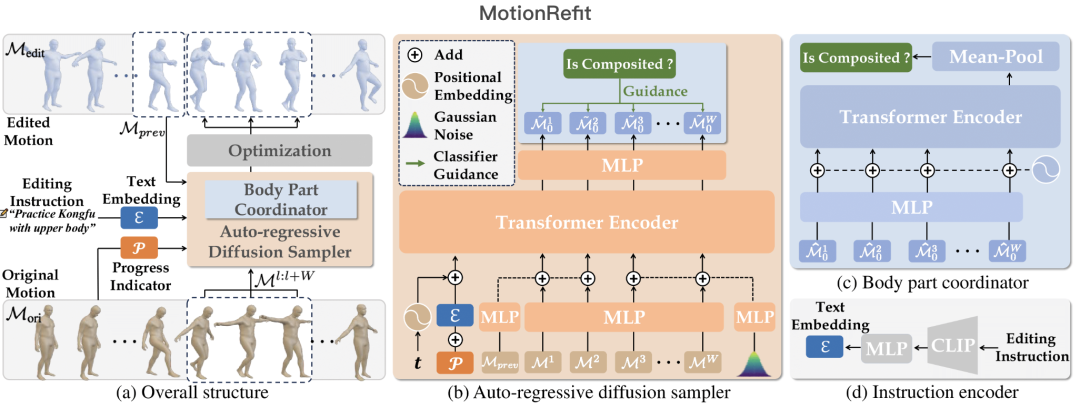

基于这样的目标,研究人员引入了一种名为MotionCutMix的数据增强技术和一种名为MotionReFit的扩散模型,MotionCutMix通过根据输入文本混合身体部位的动作来动态生成训练三元组,MotionReFit则是一种带有动作协调器的自回归扩散模型,自回归架构通过分解长序列来助力学习,而动作协调器则减轻了动作合成产生的瑕疵。

该方法可以直接依据高级别的人类指令来处理空间和时间上的动作编辑,且无需依赖额外的具体说明或大语言模型(LLM)。

简单来说,这类似于厨师通过混合和搭配不同食材来烹制菜肴,该模型能通过混合来自不同运动序列的身体部位来创建不同的训练示例。

研究人员在实验中证明了MotionReFit在文本引导的动作编辑方面达到了当前最先进的性能水平,消融实验也证实,MotionCutMix在保持训练收敛性的同时,也显著提升了模型的泛化能力。

MotionReFit的自回归方法通过滑动窗口处理原始动作,在这个过程中,对人体关键点进行编码,以便输入到基于Transformer的动作扩散模型中。

为确保动作的连续性,在保留前两帧的前提下,系统从第三帧开始添加噪声,该模型还纳入了一个额外的标记,它整合了编辑指令、扩散步骤和进度指示器信息。

生成的关键点会经过SMPL-X优化和合并操作,从而创建出最终编辑后的动作,为了提升身体各部位的协调性,研究人员使用了一个经过训练的鉴别器,用于识别由多个源动作组成的动作片段,该鉴别器通过分类器引导来指导去噪过程。

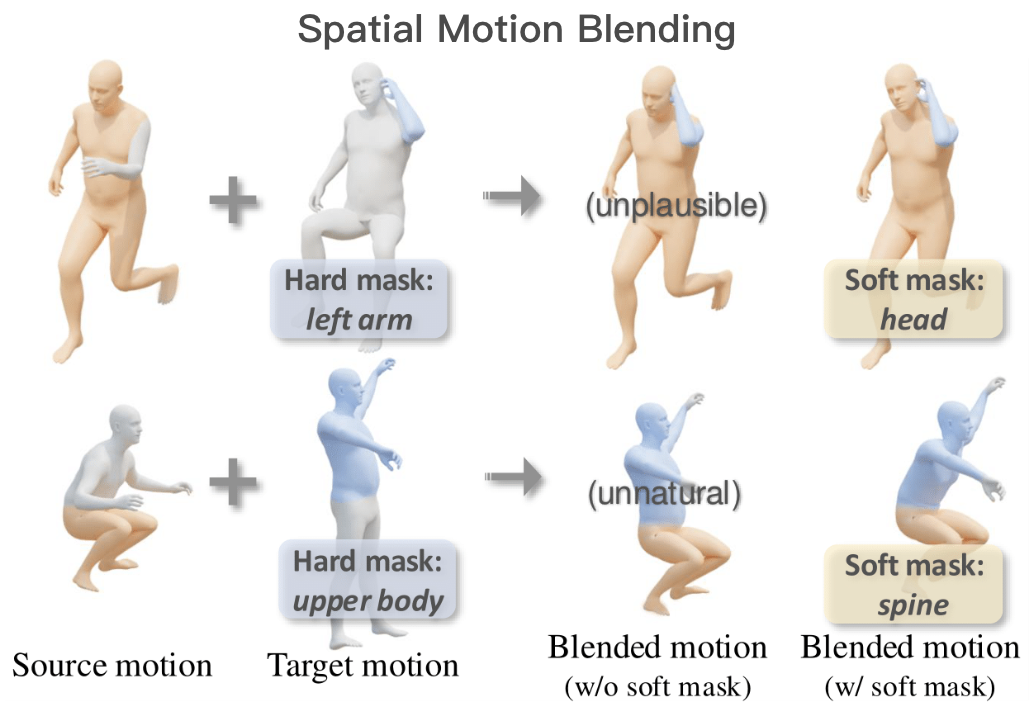

此外,空间动作混合能够实现身体不同部位之间不同动作的无缝融合,研究人员对硬掩膜和软掩膜技术进行了比较,结果表明,软掩膜可实现更平滑的过渡,并消除了边界瑕疵。

这项研究还创建了一个名为STANCE的数据集,包含三种互补的子集:

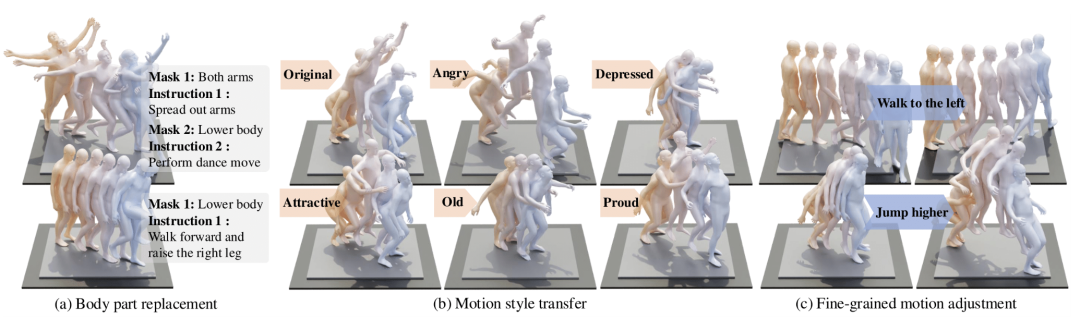

1、一个身体部位替换数据集,该数据集由来自HumanML3D的13000条序列组成,平均每条序列标注有2.1个身体掩码以及相应的动作描述;

2、一个动作风格转换数据集,包含2小时的新动作捕捉(MoCap)记录,这些记录以各种风格重现了HumanML3D的序列;

3、一个细粒度动作调整数据集,其特色是有16000个经过标注的三元组,每个三元组由生成的动作对及其相应描述构成。

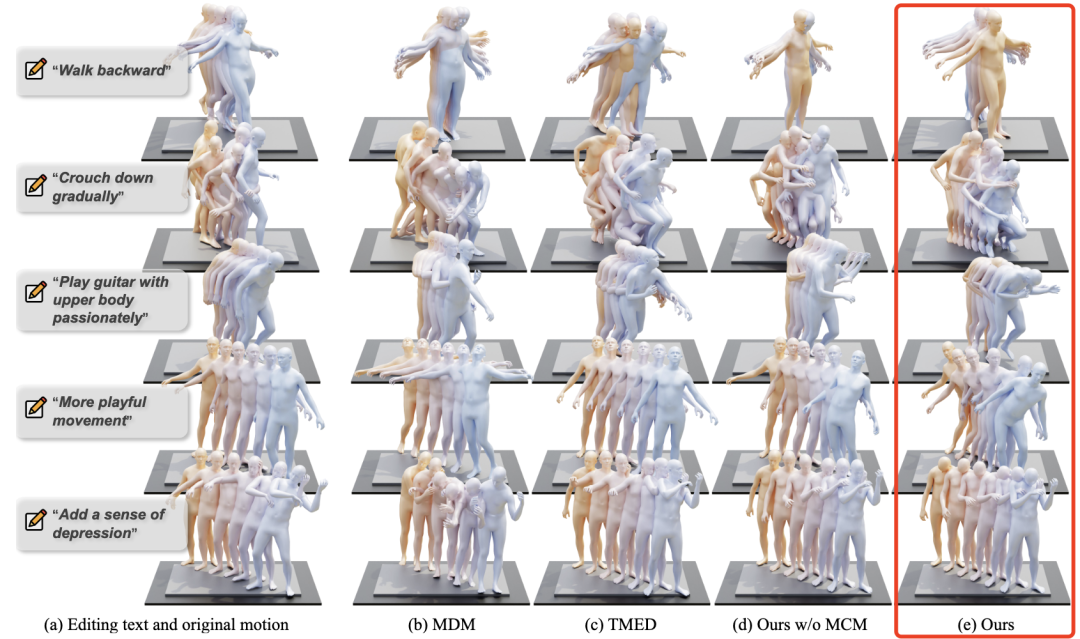

研究人员对文本引导的动作编辑结果进行了定性比较。每个序列展示了原始动作,以及通过MotionReFit和其他基线方法编辑后的动作。动作轨迹通过从橙色(起始位置)到蓝色(结束位置)的颜色渐变来可视化呈现,并且应用了空间偏移以突出动作差异。

基于论文提出的新方法,在风格编辑和语义编辑的大多数指标上都取得了更优异的表现,检索分数显示在保留原始情境的同时进行了精确的编辑。

即使没有使用MotionCutMix数据增强技术,MotionReFit的自回归方法在所有指标上也优于TMED和MDM-BP等其他模型,证明了自回归架构相对于业内的单步方法更具有效性。

同时,MotionCutMix方法显著提升了TMED等其他模型的性能,证明它在动作编辑任务中具有广泛的适用性。

另外,与基线模型相比,使用了MotionCutMix的模型即使在数据规模减少的情况下仍能保持良好的性能,这可以降低对带注释数据量的依赖程度,以及减少对高质量数据(如真人动作捕捉)的需求。

最后值得关注的是,论文作者表示,所有的变体都能在80万步内收敛,这表明新的模型和技术并不会产生额外显著的计算开销。

未来,这种创新的数据增强技术和人体动作生成模型可用于创建和编辑各种类人角色内容。

对于动画师、电子游戏开发者和其他视频内容创作者来说,可能会是一个特别有价值的工具,游戏开发者可以从有限的捕捉数据中生成大量的动作变体,从而创造出多样的非玩家角色(NPC)行为和玩家动画。

另外,也可以被应用于机器人研究领域,作为一种改善类人服务机器人动作协调性的工具。通过让机器人根据自然语言反馈调整动作,人机交互可以得到改善;在智能制造场景中,无需重新编程就可以微调机器人的动作模式。

开发更先进的动作表征技术,以更好地捕捉较长序列之间的依赖关系,对于处理更复杂的动作生成至关重要。

下一步,研究人员计划继续扩展他们系统的功能,例如,开发对于非专业用户的产品界面,让系统能够使用上传的图像作为视觉参考,并根据用户提供的演示进行编辑,他们还希望增强系统的其他能力,使其能够根据环境限制以及动作执行的情境来编辑动作。

总之,又一种得力的AI生产力工具要来了。

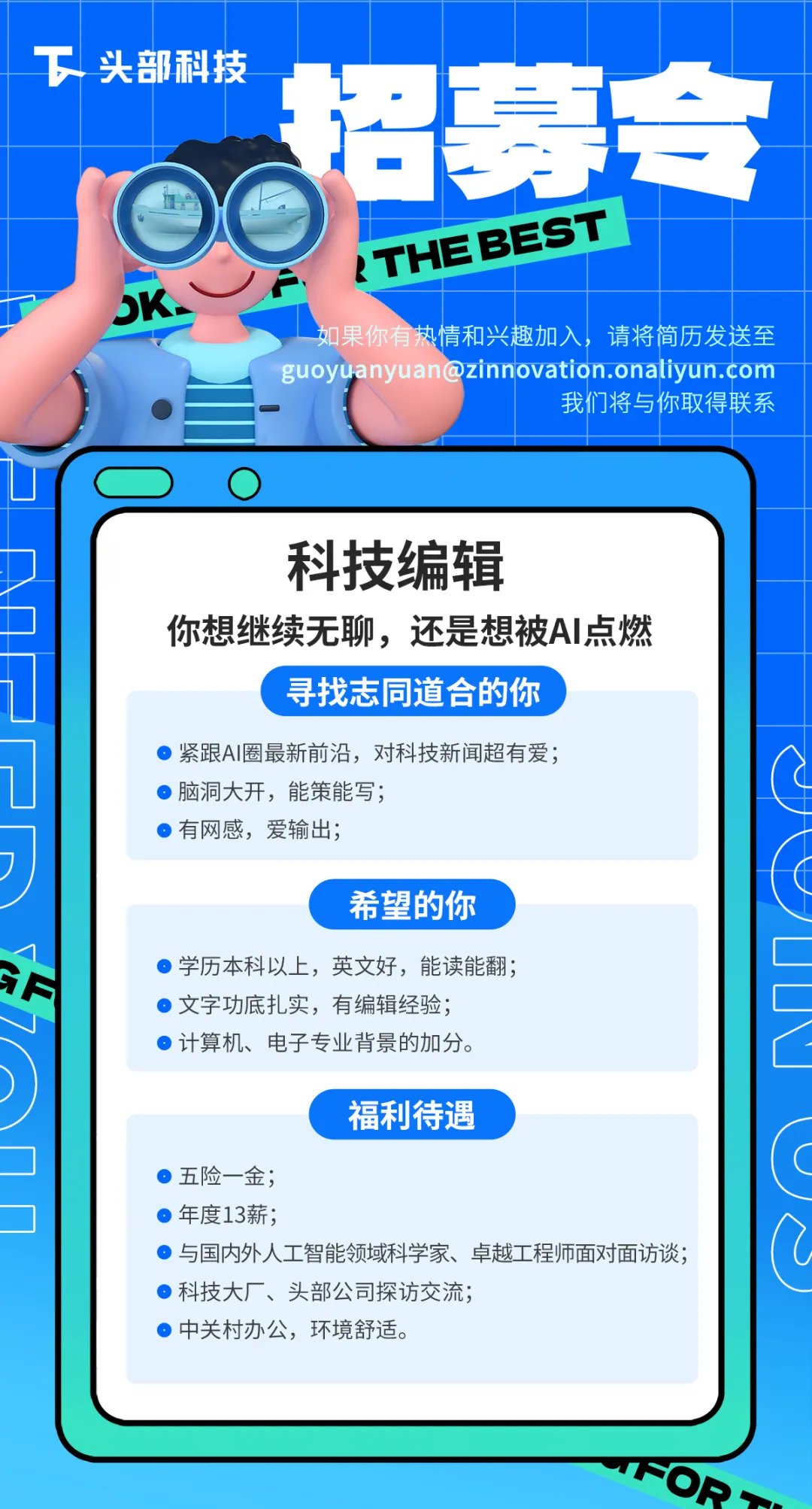

(文:头部科技)