作者|沐风

来源|AI先锋官

就在今天凌晨,OpenAI以一场20分钟的极简直播发布了满血版o3和o4-mini。

o3满血版和o4-min的登场,堪称视觉推理领域的一次革命。

它首次实现了“用图像思考”,将图像推理与思维链相结合,这种能力使得模型可以像人类一样从图表、图形,甚至是对图像中提取信息、进行深度推理并解决问题。

据最新测试结果,o3和o4-mini(无工具版本)在AIME 2024数学竞赛题目中的准确率分别达91.6%和93.4%。

一旦允许它调用Python,o3准确率就飙到95.2%,而o4-mini则冲到98.7%。

另外,在AIME 2025中,o4-mini配合Python解释器取得了99.5%高分,几乎满分拿下这项基准测试。

在Codeforces编程竞赛评分中,o3和o4-mini得分均超2700分,显示出在复杂数学与代码任务中的强大推理与执行能力。

再来看PhD级科学题(GPQA Diamond)和专家级综合测试(Humanity’s Last Exam),无需额外工具时,o3在科学题上能以 83.3%稍微领先于o4-mini的81.4%。

而面对专家综合考题,不带插件的o3准确率约为20.3%,添上Python、网络浏览甚至调用多种工具后能推到24.9%。

相比之下,不带插件的o4-mini为14.3%,但借助插件也仅为17.7%,不及o3。

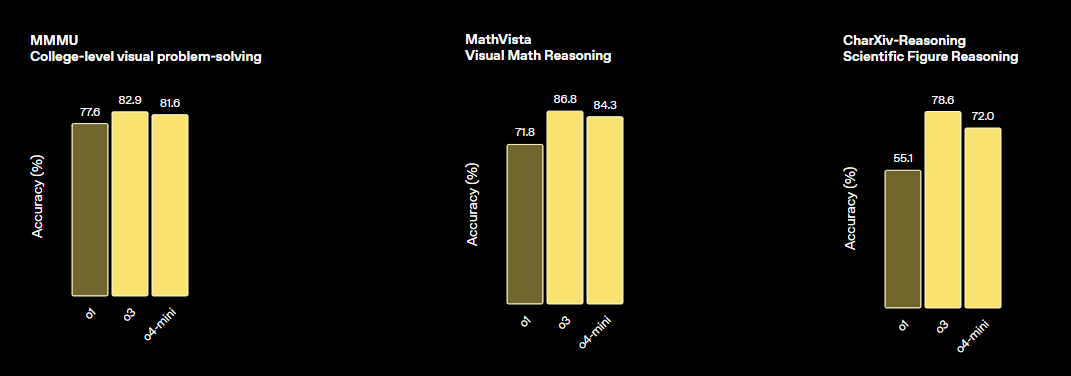

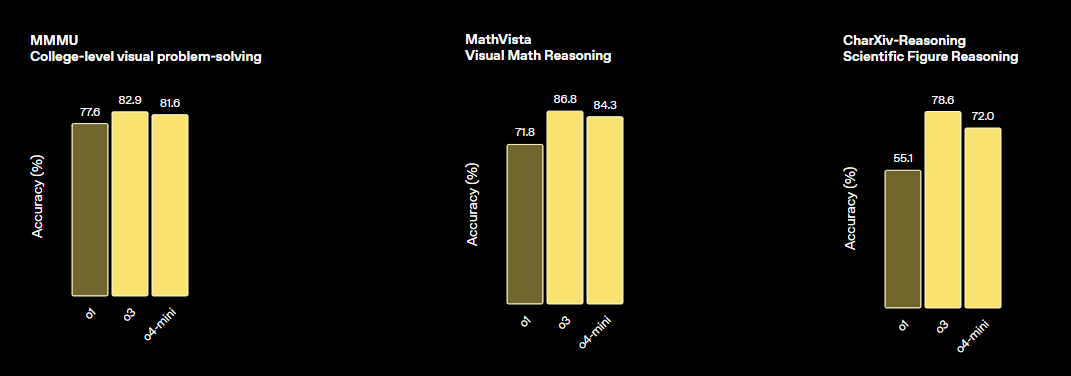

我们再来看看MMMU、MathVista、CharXiv-Reasoning三个数据集。

在大学级别的MMMU数据集上,o3直接达到了82.9%,o4-mini为81.6%,而o1在只拿到了77.6%,

面对直观的MathVista,o1只有71.8%,o3则直接冲到87.5%。

在CharXiv-Reasoning上,o3更是远超o1的55.1%,拿到了75.4%。

不得不说,这次o3满血版和o4-mini将视觉推理能力推到了一个全新的高度。

不过,这个成绩的代价是,需要投入o1十倍以上的算力。

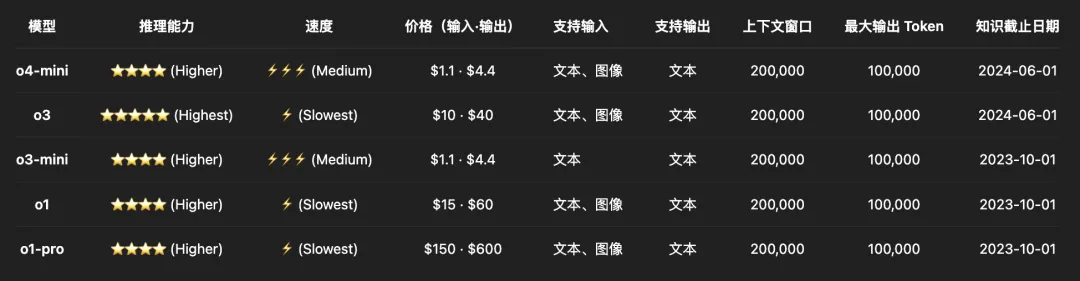

从今天起,Plus、Pro和Team用户将第一时间体验到o3、o4-mini和o4-mini-high,它们将取代o1、o3-mini和o3-mini-high。

同时,这两款模型也将通过Chat Completions API和Responses API,向所有开发者提供。

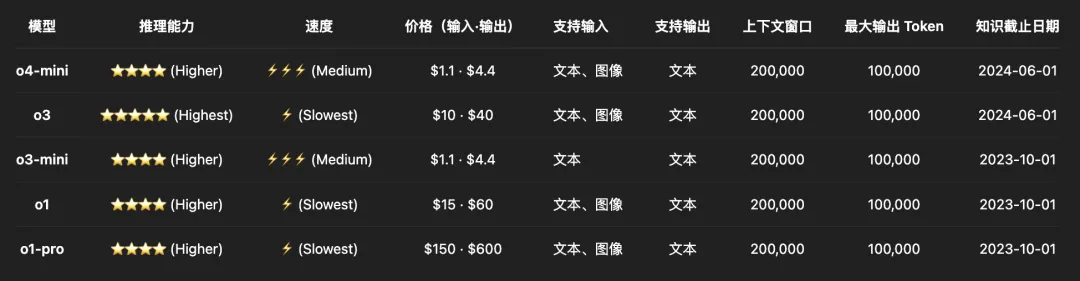

在定价上,o3比o1的定价便宜了三分之一,o4-mini相比o3-mini没涨价。

与o1相比,o3和o4-mini不仅支持了OpenAI的所有工具,还新添了一个特性“视觉推理”。

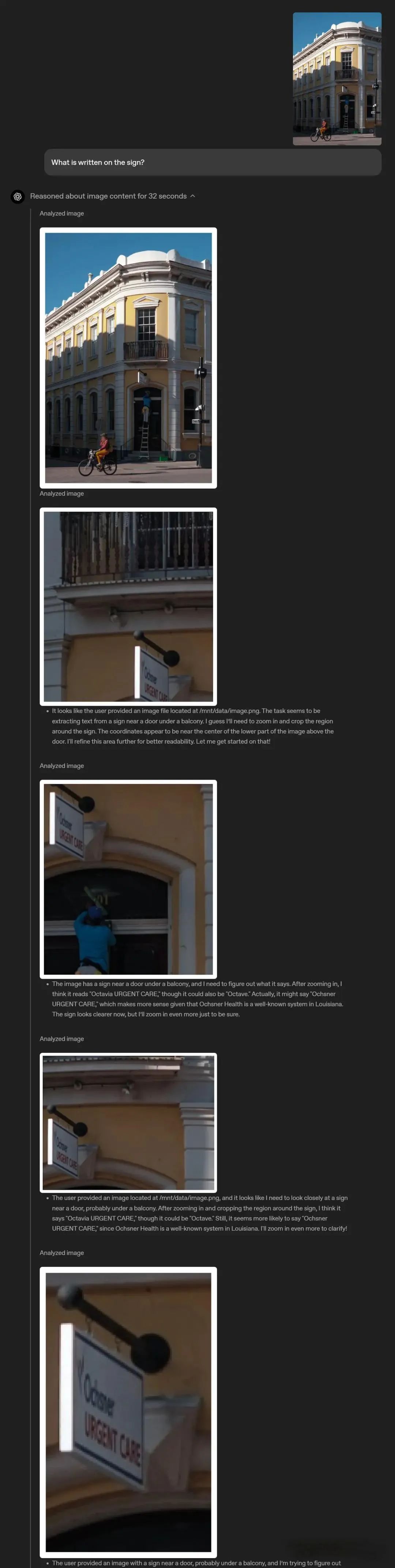

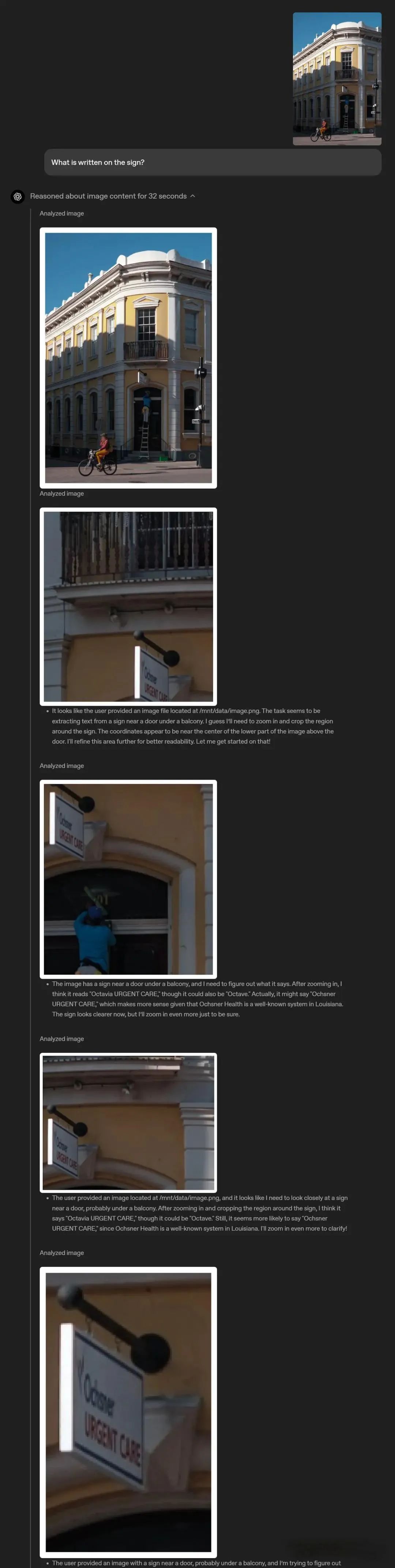

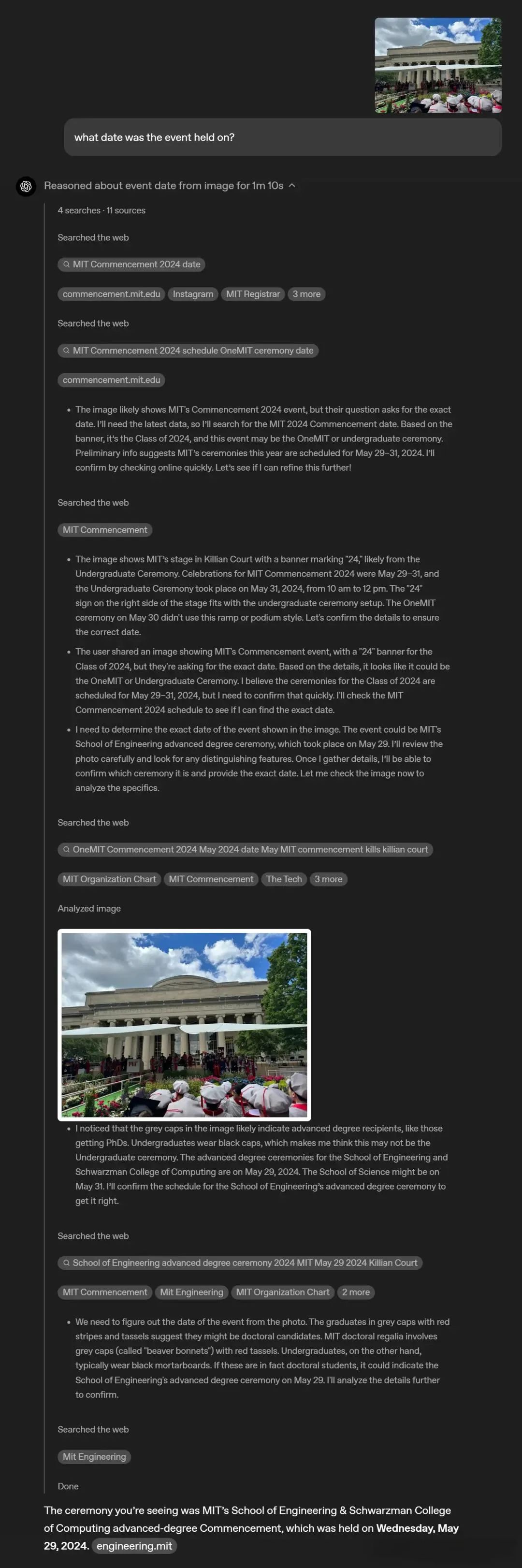

o3和o4-mini可以将图像直接整合到他们的思维链中。

他们不仅看到图像,还可以随图像一起思考。它融合了视觉和文本推理,解锁了一类新的问题解决方式。

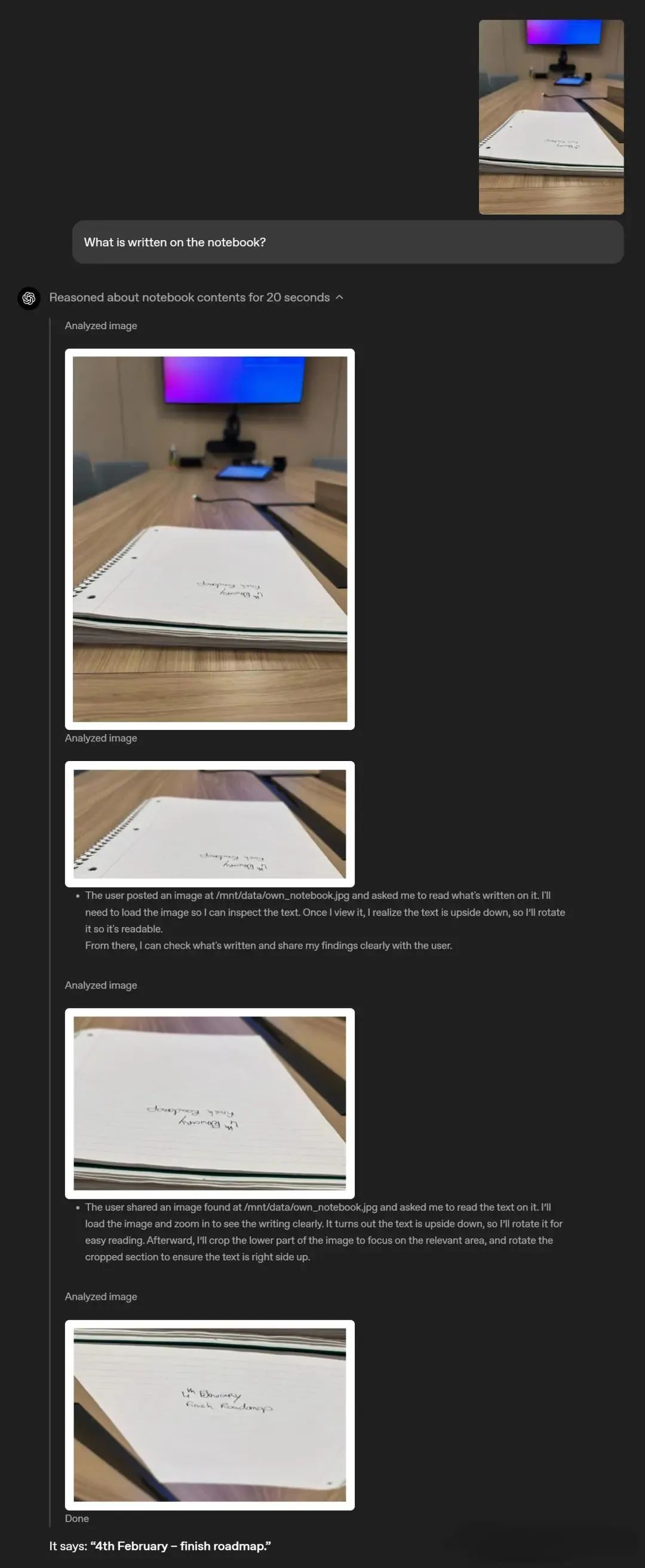

用户上传照片、教科书图表或手绘草图后,模型可以对其进行解释,即使图像模糊、颠倒或质量低下,模型也能放大看清细节。

比如,一个放在桌子上几乎与视线平行的笔记本,上面有两行倒置且模糊的字,问他“笔记本上写了什么?”

另外,最新的视觉推理模型还可以与 Python 数据分析、网络搜索、图像生成等其他工具协同工作,以创造性和有效地解决更复杂的问题。

不难看出,视觉推理让AI具备了在一种专业场景下的观察力,这也意味着很多原本需要人眼判断的岗位,会被彻底改写。

除了模型本身,OpenAI 这次还开源了一个新工具“Codex CLI”。一个可以直接在终端(terminal)运行的轻量级AI编程助手,支持调用 o3 和 o4-mini 等模型。

https://github.com/openai/codex

OpenAI还透露将在数周内推出 o3-pro,提供更全面的工具支持。

(文:AI先锋官)