在构建RAG(检索增强生成,Retrieval-Augmented Generation)系统时,想要实现“问有所答、答之有理”,一份高质量的嵌入模型远比你想象的重要。

而在一些专业领域,比如医疗、法律或金融,通用嵌入模型往往难以捕捉专业术语的细微差别,检索表现就会大打折扣。此时,嵌入微调(Embedding Fine-tuning)成为提升系统准确率的关键一步。

本篇文章将为你详细拆解:为何嵌入微调是RAG系统的“质变点”?从什么样的数据集起步?选用哪种损失函数更合适?是否有更轻量高效的模型可以使用?

读完这篇,你将获得一整套面向特定领域的嵌入微调实操指南。

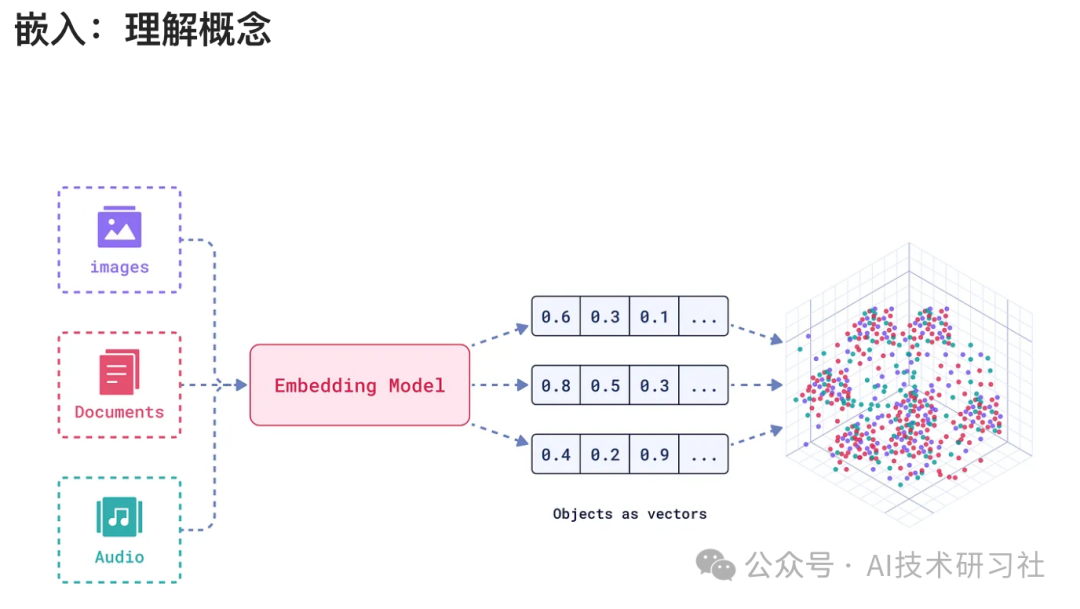

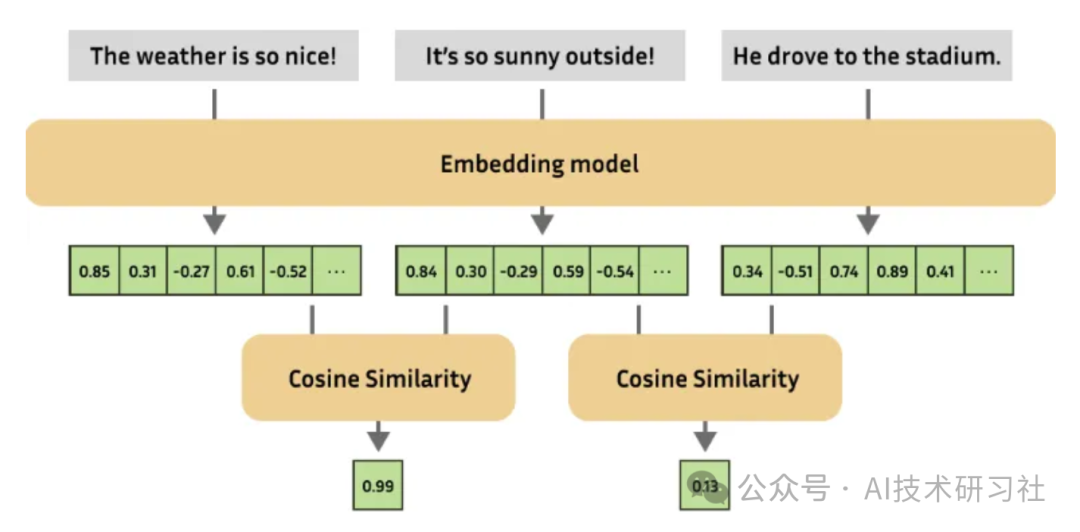

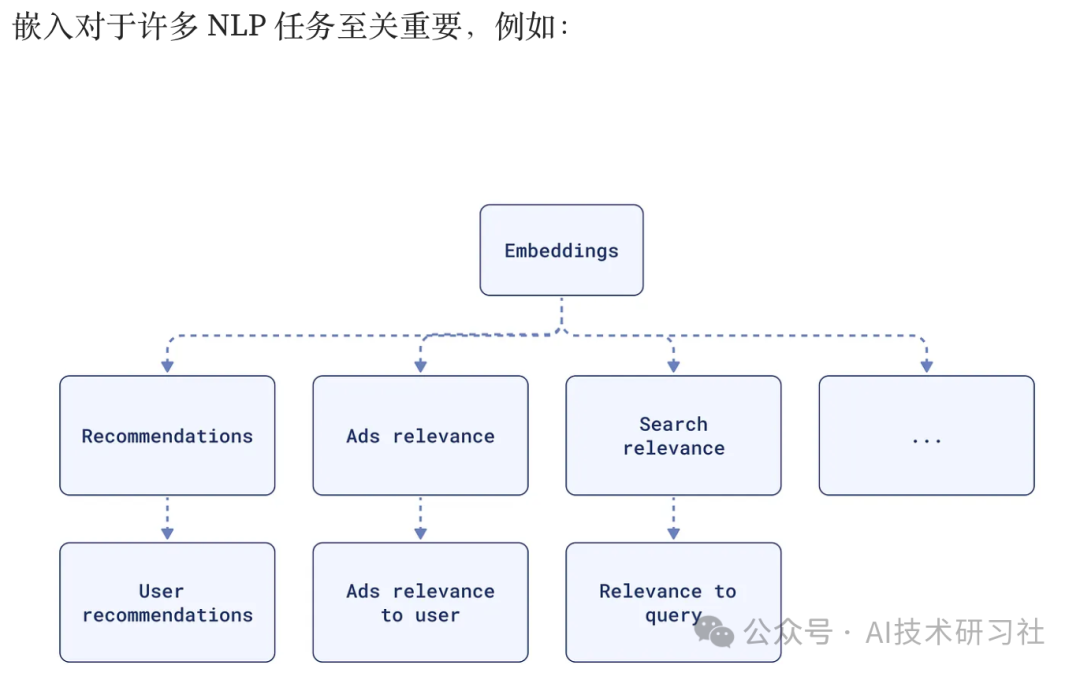

嵌入(Embedding)可以看作是将文本转化为向量的“翻译器”,它把语义关系编码成多维空间中的位置。相似的句子在空间中相距更近,不相似的则更远。这种机制支撑着文本分类、语义搜索、问答系统等核心任务,也为RAG提供了“检索基础设施”。

而嵌入模型的效果,取决于它是否“懂行”。一个通用模型也许能理解“买机票”和“订酒店”之间的关系,但未必能区分“类风湿性关节炎”与“系统性红斑狼疮”的细微差异。嵌入微调的目的,就是用领域内的专业语料重新训练模型,让它“入行”,从而精准建模你关心的知识边界。

一个残酷的真相浮出水面:未经微调的嵌入模型,就像拿着手术刀的外科医生突然改行修家电——看似智能,实则处处“外行”。

我们在这篇文章中将以 bge-base-en-v1.5 模型为例,它由北京人工智能研究院(BAAI)发布,支持轻量部署,适合计算资源有限的场景。该模型在多项嵌入任务中表现优异,是当前开源领域的主力选择之一。

在数据集构建方面,你可以采用以下几种格式:

-

正向配对:如问答对、定义与术语,适用于对比损失或余弦相似度损失;

{"query": "What is hypertension?", "answer": "Hypertension is high blood pressure."}{"query": "How to treat diabetes?", "answer": "Treatment includes insulin and dietary control."}{"query": "Symptoms of anemia?", "answer": "Fatigue and pale skin are common symptoms."}{"query": "Causes of migraine?", "answer": "Stress and hormonal changes are common causes."}{"query": "What is ECG?", "answer": "ECG is a test that records the electrical activity of the heart."} -

-

-

-

-

-

三元组(anchor, positive, negative):适用于triplet loss,引导模型拉近正例、远离负例;

{"anchor": "What is hypertension?", "positive": "Hypertension is high blood pressure.", "negative": "Diabetes is managed with insulin."}{"anchor": "Symptoms of anemia?", "positive": "Fatigue and pale skin are common symptoms.", "negative": "Fever is a symptom of infection."} -

-

-

相似度评分:为每对句子打分,引导模型学习相似度的连续分布;

-

类别标签:适合用作分类任务的辅助监督信号。

我们建议从问答对数据集入手,简单且直观,适合大多数垂直领域。

在训练过程中,损失函数(Loss Function)决定了模型如何“学会相似性”。

三元组损失(Triplet Loss)适合构建相对关系;对比损失(Contrastive Loss)适合引导模型对正负样本分界清晰;而余弦相似度损失(Cosine Similarity Loss)则更适合数值回归场景。

我们首先安装必要的库。我们将使用datasets、sentence-transformers和google-generativeai来处理数据集、嵌入模型和文本生成。

apt-get -qq install poppler-utils tesseract-ocrpip install datasets sentence-transformers google-generativeaipip install -q --user --upgrade pillowpip install -q unstructured["all-docs"] pi_heifpip install -q --upgrade unstructuredpip install --upgrade nltk

我们将使用unstructured库从 PDF 文件中提取文本和表格。

使用process_text_chunks函数,我们使用 Gemini 模型为每个文本块生成 QA 对。

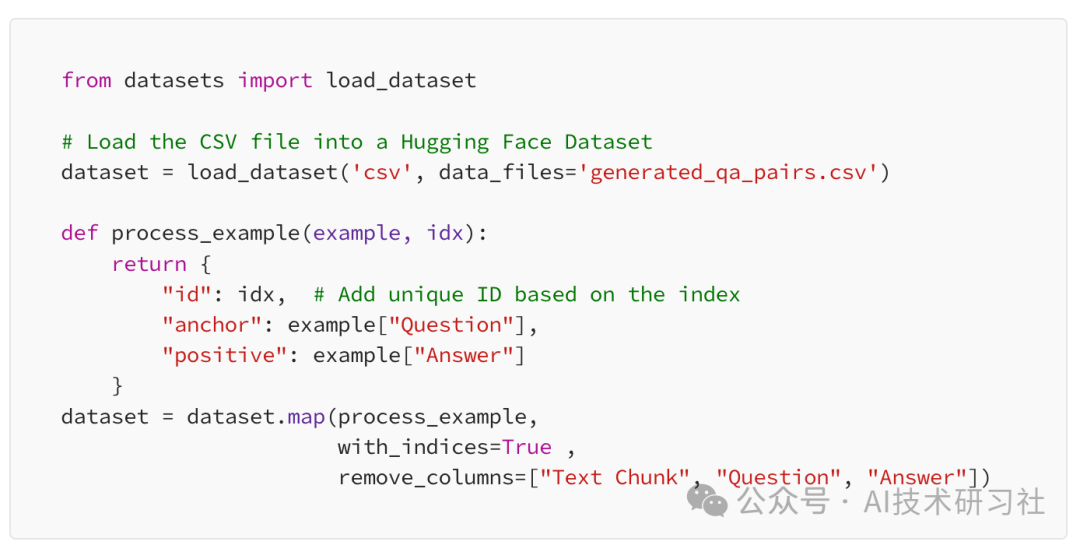

接下来,我们将生成的 QA 对从 CSV 文件加载到 HuggingFace 数据集中。我们确保数据格式正确以进行微调。

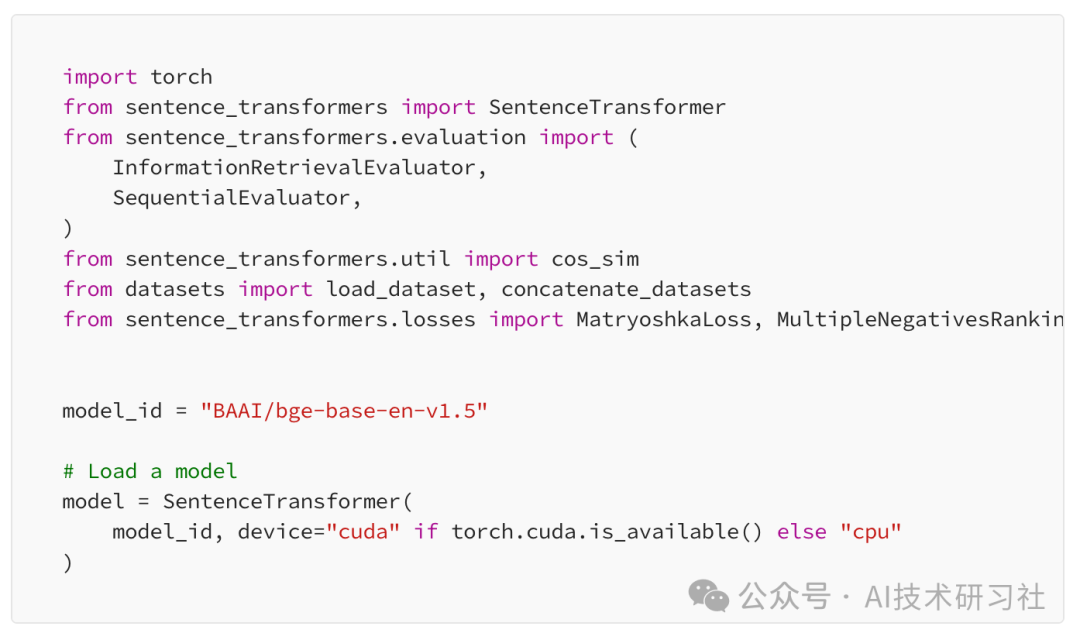

我们从 HuggingFace 加载BAAI/bge-base-en-v1.5模型,确保选择合适的执行设备(CPU 或 GPU)。

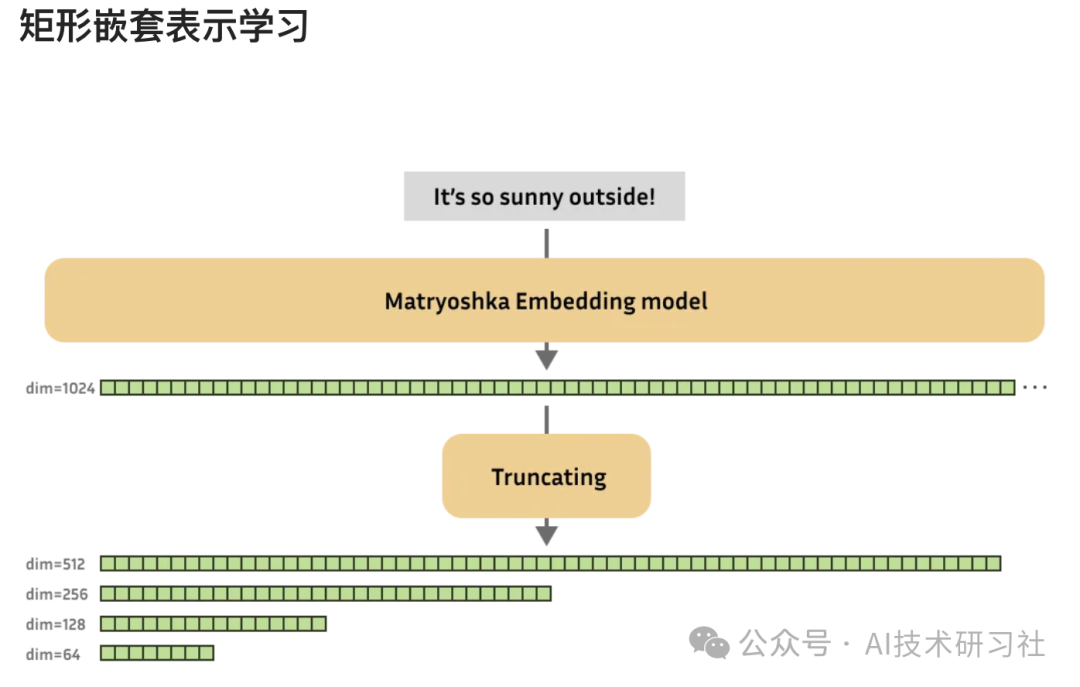

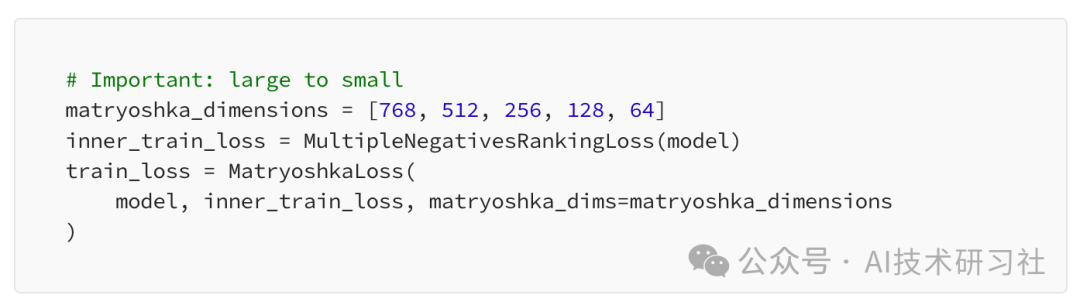

这里,我们配置了套娃损失函数,指定用于截断嵌入的维度。

内部损失函数MultipleNegativesRankingLoss有助于模型生成适合检索任务的嵌入。

我们使用SentenceTransformerTrainingArguments来定义训练参数。这包括输出目录、训练轮数、批大小、学习率和评估策略。

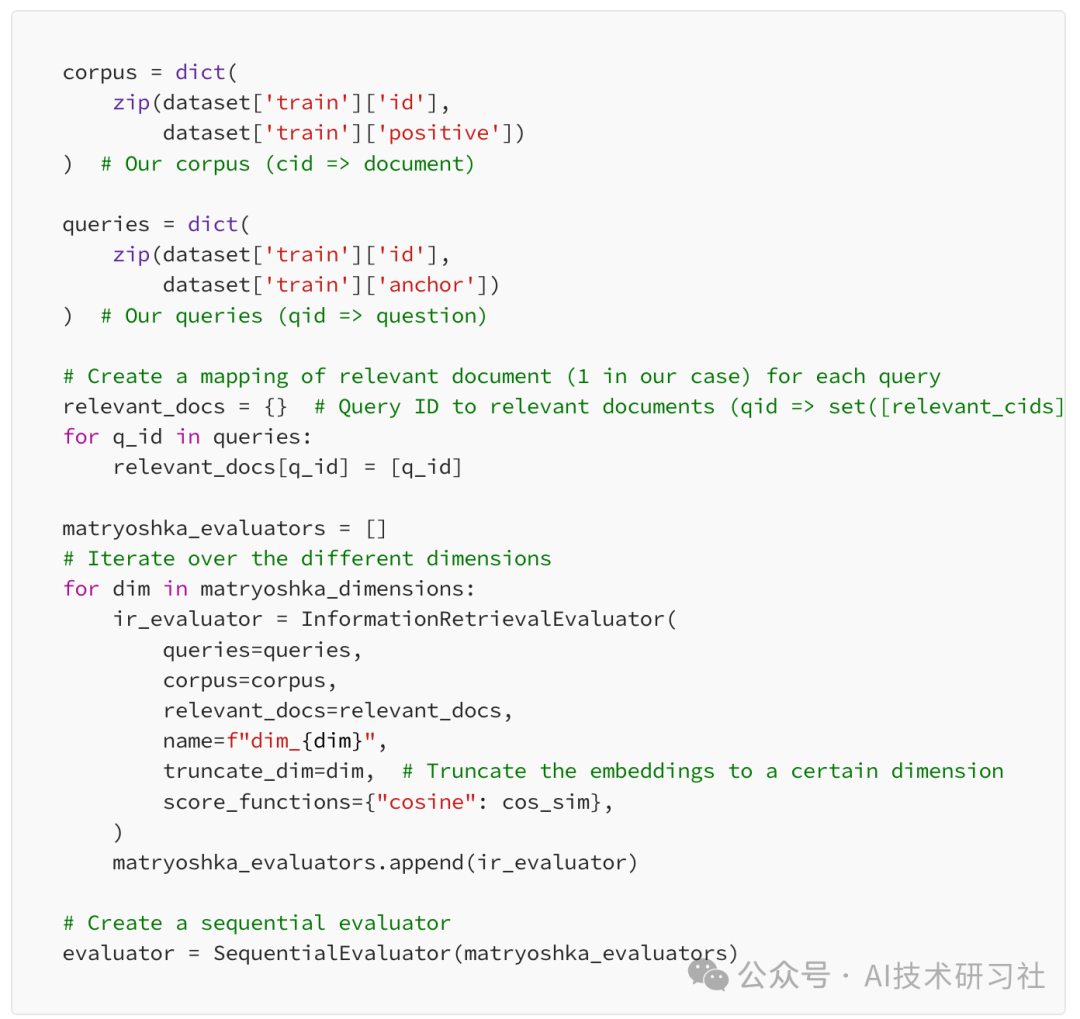

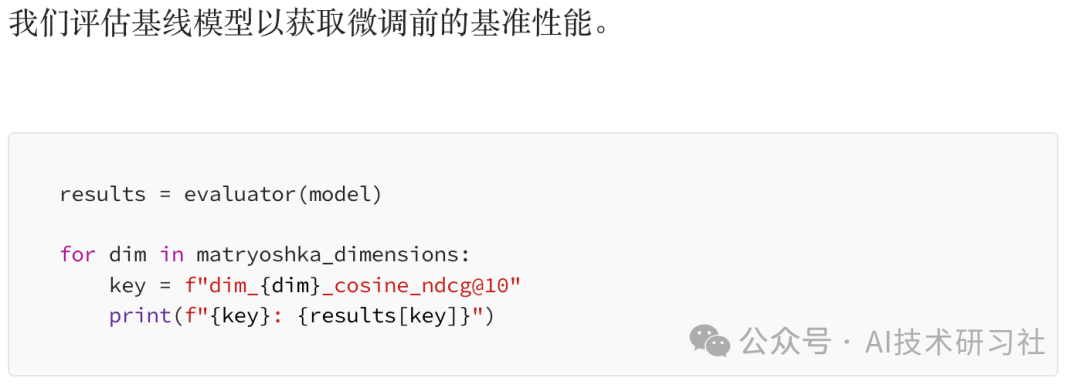

我们创建一个评估器来衡量模型在训练过程中的性能。评估器使用InformationRetrievalEvaluator对 Matryoshka 损失中的每个维度进行模型检索性能评估。

完成微调后,你会获得一个真正“领域通”的嵌入模型。它不仅能显著提升RAG系统的检索准确率,还能在摘要、问答、信息提取等任务中获得更可靠的结果。

而最棒的一点是:将微调后的嵌入结果传递给大语言模型(LLM)非常简单!因为嵌入后的JSON本身就是结构化、干净的数据格式,GPT、DeepSeek、文心一言等主流模型都能直接使用,无需复杂转换。这种结构化嵌入还能帮助LLM更精准地聚焦语义核心,让每一次调用都更高效、更靠谱。

嵌入微调,不仅是“模型性能优化”,更是一种让知识与模型真正对齐的方式。别再把通用嵌入模型硬塞进RAG管道,也别再忽视数据结构对模型表现的影响——当你在处理“专业知识”的时候,你的模型也应该是“专业选手”。

如果你正准备为自己的垂直领域打造一套更聪明的知识系统,现在,就是重新训练你的向量理解力的最佳时机。

参考资料:https://blog.gopenai.com/fine-tuning-embeddings-for-specific-domains-a-comprehensive-guide-5e4298b42185

(文:AI技术研习社)