新智元报道

新智元报道

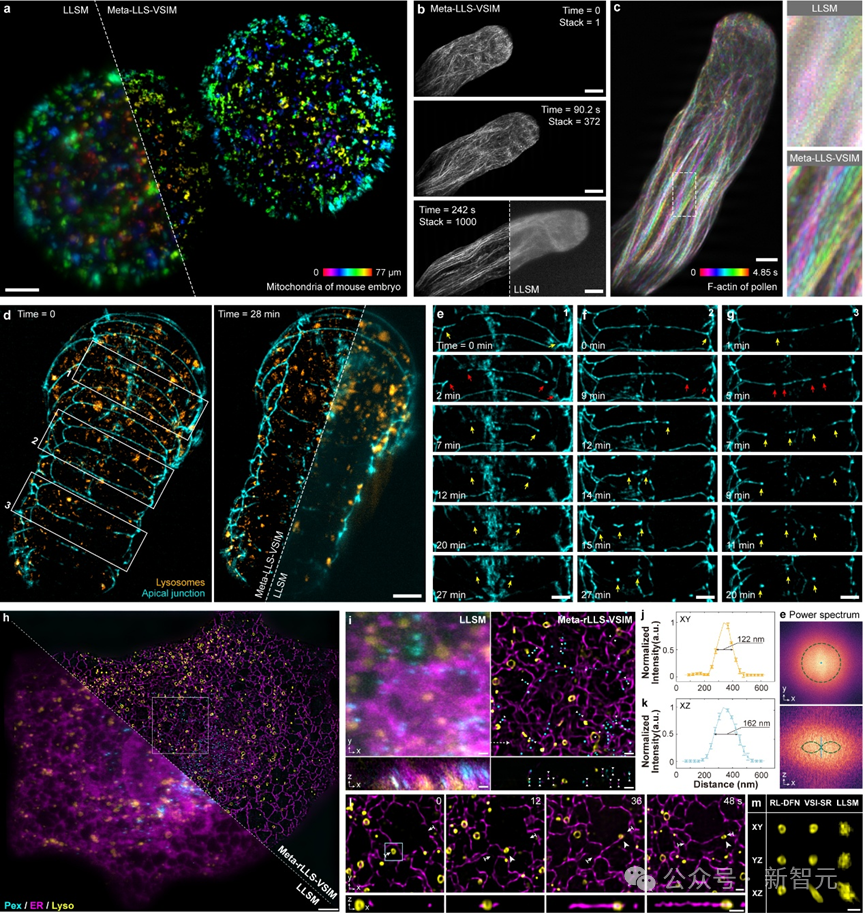

【新智元导读】清华大学团队通过AI for Optics创新赋能超分辨光学显微镜,将活细胞成像体积分辨率提升15.4倍!借助这一工具,研究人员可为癌细胞分裂、胚胎发育等精密生命过程拍摄「4K高清电影」,从而撬动生物医药领域的重大突破。

近年来,以深度学习为代表的智能计算方法对光学显微镜发展产生变革性影响。通过光学成像系统与智能算法的联合优化,可在极大程度上突破光学系统设计的时空带宽固有局限。

如何基于光学系统与人工智能的交叉创新突破性能瓶颈,以三维视角和亚细胞级各向同性分辨率观测动态生物过程,是光学显微成像领域的前沿重要挑战。

近日,清华大学生命学院李栋课题组与自动化系戴琼海团队合作提出一款全新的「AI+」显微镜:元学习驱动的反射式晶格光片虚拟结构光照明显微镜(Meta-rLLS-VSIM)。合作团队利用AI赋能超分辨光学显微镜,硬件软件协同优化,实现「1+1>2」的成像效果,开启了生物医学活体观测的全新视角。

论文链接:https://www.nature.com/articles/s41592-025-02678-3

在诸多三维光学显微成像的技术方案中,光片显微镜(LSM)是当前最适宜进行多细胞、大体积样本三维成像的模态之一。

2014年,诺贝尔化学奖得主Eric Betzig在传统LSM的基础上发明了晶格光片显微镜(LLSM),并通过与结构光照明(SIM)相结合,形成晶格光片结构光照明显微镜(LLS-SIM)解决方案。

LLS-SIM可在结构光照明方向上将分辨率提升至150纳米左右,这也是当前最新的前沿技术方法。然而,LLS-SIM仅能产生单一方向的结构光照明,导致空间分辨率各向异性,未超分辨方向易产生畸变,限制了对三维亚细胞动态的精准探测。

针对这一难题,Meta-rLLS-VSIM通过AI与光学交叉创新,在不牺牲成像速度、光子代价等核心成像指标的前提下,将LLS-SIM 的一维超分辨能力扩展至XYZ三个维度,实现横向 120 nm、轴向 160 nm 的近各向同性成像分辨率,相比于LLSM,体积成像分辨率提升15.4倍!

特别地,该工作将元学习策略与系统数据采集过程深度融合,仅需3分钟就可以完成从训练数据采集到深度学习模型的自适应部署过程,让AI工具在实际生物实验中的应用达到近乎「零门槛」。

合作团队在植物花粉管、小鼠胚胎、秀丽隐杆线虫胚胎及真核有丝分裂或分裂间期的其他真核生物等从单细胞到胚胎尺度的多种生物样本上进行了实验,验证了 Meta-LLS-VSIM 在快速、长时程、多色三维超分辨成像任务中的能力。

Meta-rLLS-VSIM可实现从细胞到胚胎的跨尺度五维活体超分辨观测

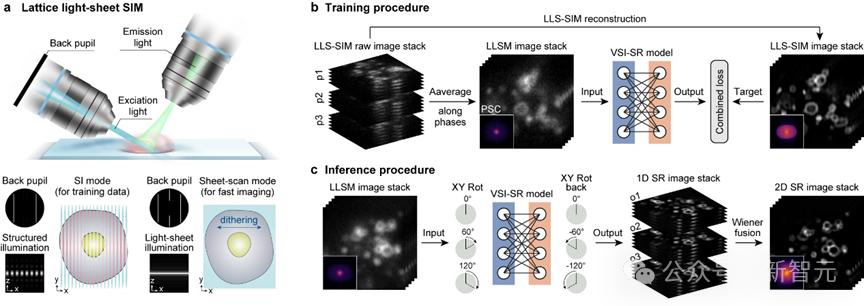

受限于特殊的双物镜垂直安装的光学系统设计方案,LLS-SIM只能产生固定方向的结构光,而只有结构光照明的方向才能具备超分辨能力。

研究团队注意到,由于生物样本生长方向的随机性,LLS-SIM采集到的单一方向超分辨信息实则涵盖了各个不同方向上的样本结构特征。因而,如果使用深度神经网络(DNN)可以学习到单一维度超分辨能力,就有潜力将其拓展至其他方向。

于是研究团队利用自主搭建的成像系统,采集了不同生物样本的LLSM/LLS-SIM图像对作为训练集,并训练了一个精心设计的DNN模型用以学习单一维度超分辨能力。

在推理阶段,只需将LLSM低分辨率图像以特定取向输入到DNN模型中,就可以得到这一方向分辨率提升的结果。DNN模型就像是可以任意改变取向的「虚拟结构光」,弥补了LLS-SIM系统的固有缺陷。

最后,通过维纳解卷积等方式将不同方向的一维超分辨图像进行融合,使它们不同方向的超分辨率信息互补,即可获得在平面内分辨率一致的各向同性超分辨图像。

虚拟结构光照明超分辨DNN模型数据采集、训练与推理

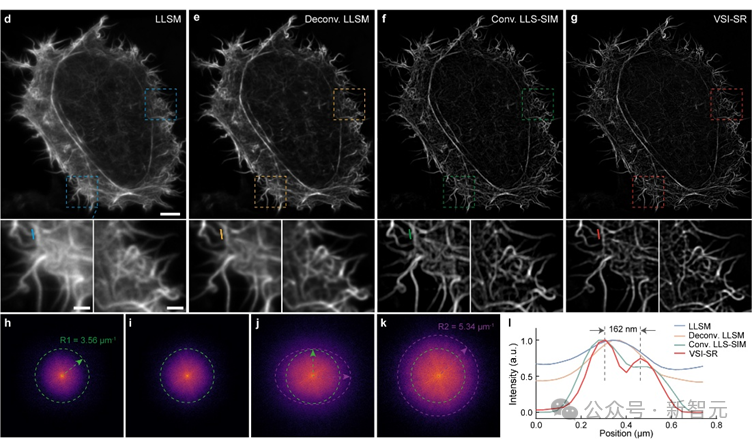

研究团队在亚细胞结构肌动蛋白微丝上测试了虚拟结构光照明成像(VSI-SR)的效果,发现相比于其它方法,虚拟结构光照明图像更加清晰,在频域上不仅包含更多高频信息,而且保持各向同性。

虚拟结构光照明成像效果展示

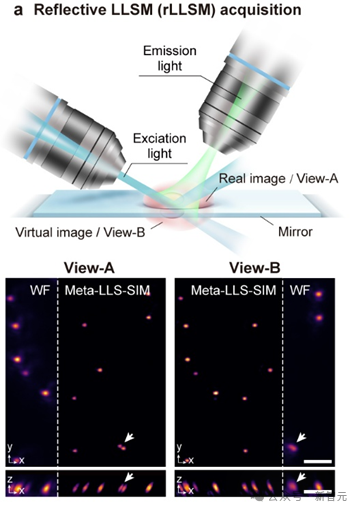

尽管虚拟结构光照明可将LLS-SIM超分辨能力拓展到整个二维平面,但无法提升与这一平面垂直方向上的分辨率(即轴向分辨率)。

为解决这一问题,研究团队将承载生物样本的盖玻片替换为一个反射镜,在进行三维成像时,镜面上方的实像和下方的虚像被同时拍摄,并且二者的空间视角不同。

双视角之于单视角类似于双目视觉之于单目视觉,两个视角的分辨率空间取向不同,意味着两个视角横向与轴向分辨率互补,融合两个视角图像的信息可在空间信息采集的本质上提升轴向分辨率。

Meta-rLLS-VSIM基于镜面反射的双视角成像原理

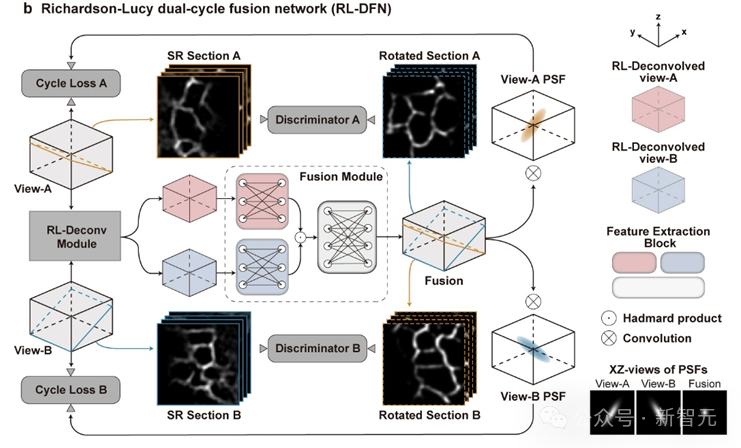

为了更好的融合两个视角信息,研究团队提出了光学成像模型启发的Richardson-Lucy双循环融合网络架构(RL-DFN)。

RL-DFN融合了多视角Richardson-Lucy迭代公式,使用可训练卷积层替代前向和反向传播算子,在保证信息融合符合统计学规律的前提下,提升融合效果。

随后,将融合得到的高分辨率结果与光学系统的点扩散函数(PSF)进行卷积,并与输入图像体栈计算循环损失(Cycle Loss)。这一Cycle Loss将RL-DFN约束为满足物理先验条件的解卷积模型,使轴向分辨率的提升在物理上可靠。

为进一步提升融合结果保真度,研究团队在RL-DFN设计中引入了判别器。判别器通过分辨RL-DFN输出的任意二维切面图与虚拟结构光成像得到的各向同性超分辨平面图,与RL-DFN相互竞争。

而RL-DFN为了骗过判别器,会努力提升信息融合效果,使任意方向的切面都达到各向同性超分辨,最后实现在三维空间上的各向同性分辨率。

RL-DFN的模型结构示意

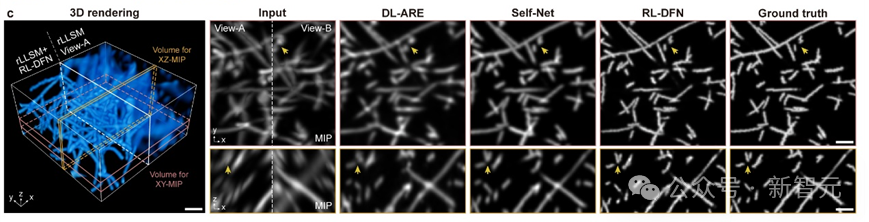

在双视角循环Cycle Loss的约束和判别器的对抗下,RL-DFN可以充分利用双视角互补分辨率信息,合理提升轴向分辨率。

研究团队将RL-DFN与其他无监督方法在仿真数据上进行对比,发现RL-DFN能够实现各向同性的超分辨信息融合,并且更精确地恢复出样本细节。

RL-DFN与其它方法重建效果对比

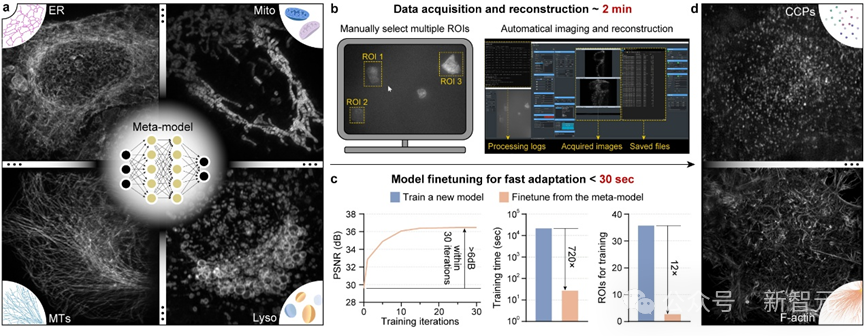

在实际生物成像实验当中,由于DNN泛化性和表征能力受限,通常需要为每一种不同的生物结构、甚至不同信噪比训练专用模型,以得到最佳的模型推理效果。

而亚细胞结构成百上千,且形态各异,为每一种结构训练模型需采集海量训练数据,并消耗大量计算成本和时间成本,导致AI工具在实际成像实验中难以被广泛应用。

为了解决这一难题,研究团队将「元学习」与光学显微系统的数据采集时序深度融合,将模型训练所需的数据量降低12倍,训练时间降低720倍,实现了AI模型的快速自适应部署。

元学习的核心思想是在训练过程中不仅关注单一任务的性能优化,而是希望使训练模型在面对新任务时,快速地调整自身参数,以实现模型的快速迁移。

元学习训练得到的通用元模型虽然无法在单个任务上达到最佳的推理效果,但是它可以通过在少量子任务数据的少量训练,快速收敛到子任务的最佳模型。通用元模型相当于「交通枢纽」,有着到达所有子任务最佳模型的「快速路径」。

在Meta-rLLS-VSIM中,研究团队将不同生物样本和信噪比的超分辨重建问题视为单独的子任务,训练单方向超分辨任务的通用元模型。

当在新的子任务部署时,仅需采集3对高低分辨率图像对,并进行30 次微调迭代,就可以快速得到针对这一新任务的最优DNN模型。

元学习驱动的模型快速自适应部署实现流程

为了简化操作流程,研究团队还在显微镜控制程序上实现了通用元模型部署流程的全自动化。使用者只需要在图形界面点击几个待采集区域,后续从数据采集、到训练集超分辨重建、再到元模型微调,全部流程都可在后端自动实现,且仅需不到3分钟时间。

元学习驱动的模型快速自适应部署过程视频展示

借助元学习构建的「交通枢纽」和全自动化部署流程,研究团队实现了AI模型在不同生物样本场景下的快速自适应部署,大大降低了AI模型在实际生物成像实验中的使用门槛,让AI真正可以辅助生命科学新发现。

综上,Meta-rLLS-VSIM通过反射增强双视角晶格光片显微镜与元学习快速自适应部署模式的成像系统硬件升级,与虚拟结构光照明和RL双循环融合网络的人工智能算法创新,展现了软硬件协同优化带来的光学显微镜成像能力巨大提升。

Meta-rLLS-VSIM的出现为细胞生物学、神经科学等基础学科发展提供了新的技术路径,有望帮助生命科学研究人员从更全面的多维视角发现、理解、探究丰富多彩的生物现象。

(文:新智元)