聪明不够,还要够快。SearchAgent-X的核心使命是——让复杂思维路径的智能体不再“慢半拍”,真正迈入高效、实用的新纪元。

论文: https://arxiv.org/abs/2505.12065

开源: https://github.com/tiannuo-yang/SearchAgent-X

借助大型语言模型(LLM),AI搜索智能体能够边思考边查询,从外部信息中不断迭代自己的推理路径,被视为新一代自主智能体的核心范式之一——被称为 RAG 2.0。

但这类系统在现实应用中却面临“跑不动”的难题。想象一下,当你需要反复翻阅资料才能理清一个复杂问题,而翻一页书都要加载十几秒,效率自然堪忧。类似地,AI搜索智能体的高频信息交互和逻辑推理流程,一旦缺乏系统优化,也将陷入卡顿、低效甚至资源浪费。

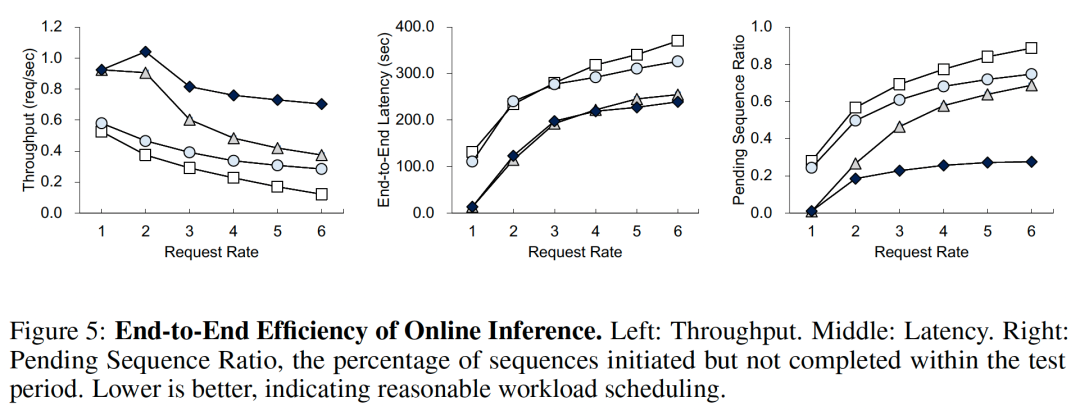

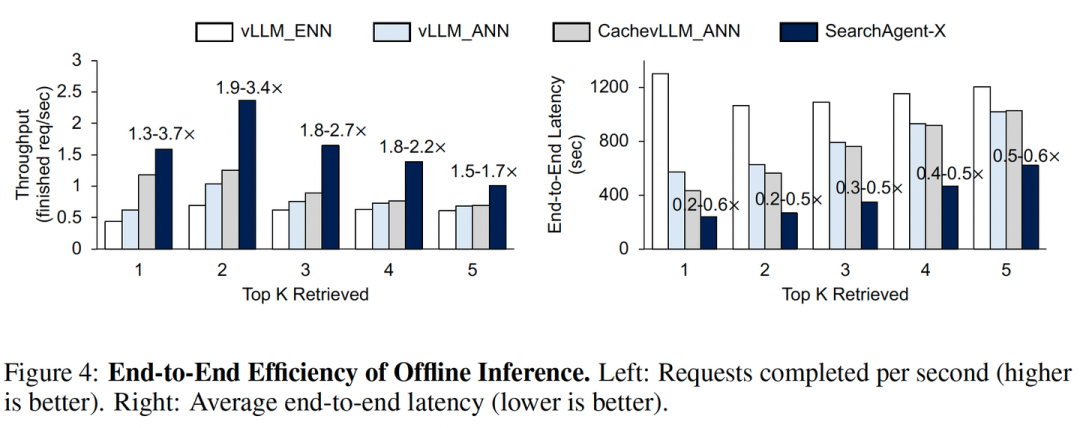

这项来自南开大学和伊利诺伊大学厄巴纳-香槟分校的研究,深入剖析了这些效率瓶颈,并提出了一套名为 SearchAgent-X 的高效推理框架。实践表明,SearchAgent-X 实现了 1.3至3.4倍 的吞吐量提升和 1.7至5倍 的延迟降低,同时不牺牲最终的答案质量。

一、 低效真相:搜索智能体性能困局的两大根源

研究发现,影响此类系统性能的关键,并不只是模型本身的速度,而在于“检索”这一流程中两个容易被忽视的成本陷阱。

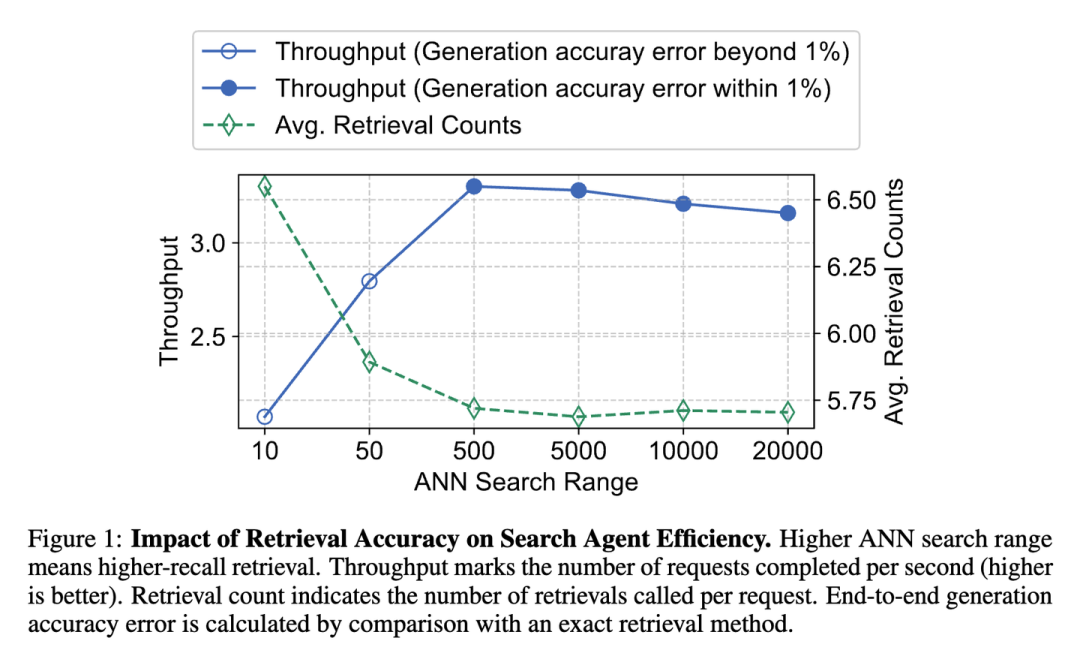

1. 精度悖论:检索越准越好吗?

我们通常认为:检索越精准,模型获取的信息越有效,效率就越高。但实际情况呈现出一种非单调关系:

-

• 过低精度:检索很快,但信息质量不足,LLM需要进行更多轮次的检索和推理来弥补,导致总时间增加。 -

• 过高精度:虽然信息质量好,但检索本身消耗巨大计算资源,拖慢整体速度。就像为了找一根针,把整个草堆都翻了个底朝天,得不偿失。

研究表明,随着近似检索的精度提升,系统吞吐量会先上升后下降。当搜索范围超过某个最佳点后,检索成本的增加开始反噬整体效率。

核心洞察:搜索智能体系统更青睐高召回率的近似搜索,它既能有效支撑推理,又避免了不必要的检索开销。

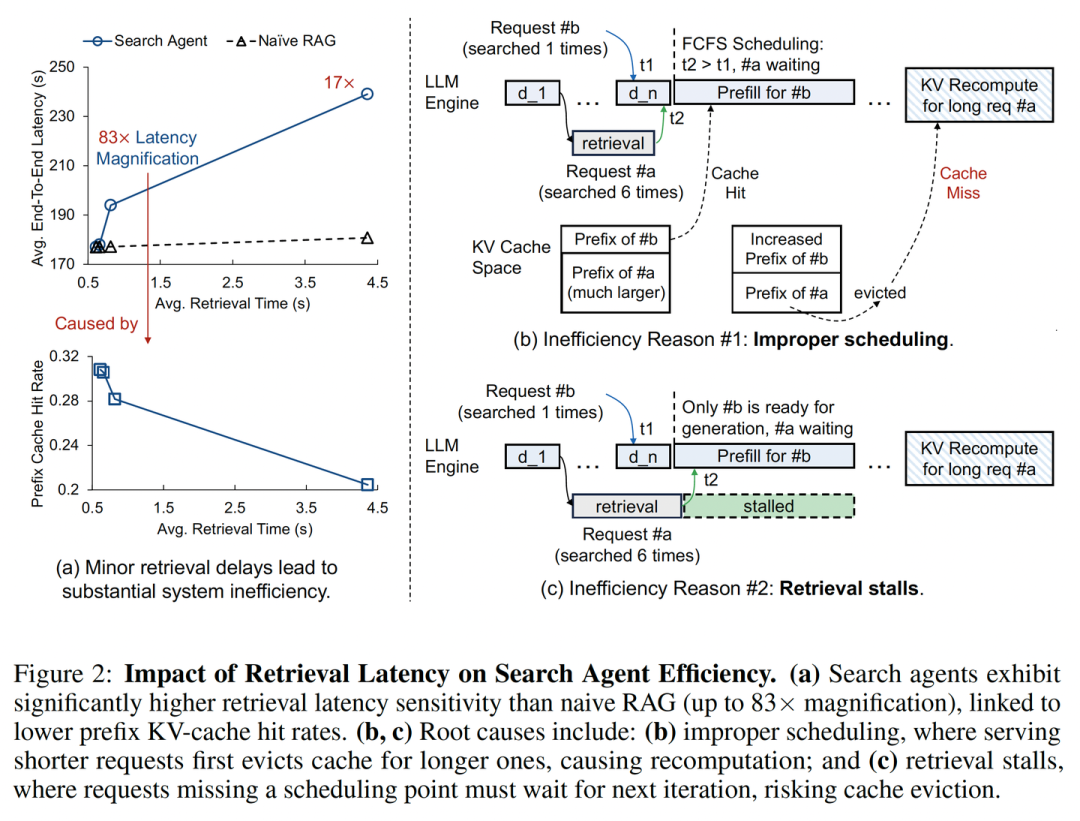

2. 延迟放大:看似细微的等待,实际带来灾难

不同于传统RAG系统,搜索智能体的推理流程高度依赖异步检索结果,其执行效率极易受到延迟影响。研究发现,即使检索延迟仅有微小增加,也可能导致搜索智能体的端到端延迟被急剧放大(高达83倍)。

这种现象与 KV-cache(一种关键的计算缓存)命中率的骤降 密切相关,迫使系统频繁进行代价高昂的重计算。根源主要在于两个系统层面的设计问题:

-

• 不当调度(Improper Scheduling): -

• 现象:现有系统普遍采用“先到先服务”策略,反而会让高价值计算被低优先级任务中断,从而浪费缓存资源。 -

• 恶果:任务A宝贵的KV-cache被任务B“挤掉”。当任务A恢复执行时,不得不从头重算,造成巨大浪费。数据显示,不当调度可能导致高达 55.9% 的token被不必要地重计算。 -

• 检索停滞(Retrieval Stalls): -

• 现象:检索和生成的时间不同步,导致生成任务错过批处理窗口,只能等待下一轮,从而再次触发缓存失效与延迟放大。 -

• 恶果:任务A错过了当前的调度批次,被迫等待。在此期间,它的KV-cache可能被其他就绪的任务挤占。平均而言,超过 25% 的序列在完成检索后会经历此类停滞。

二、 系统突围:SearchAgent-X 的两项关键技术

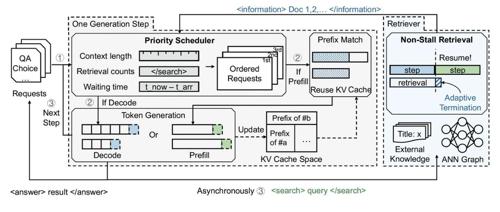

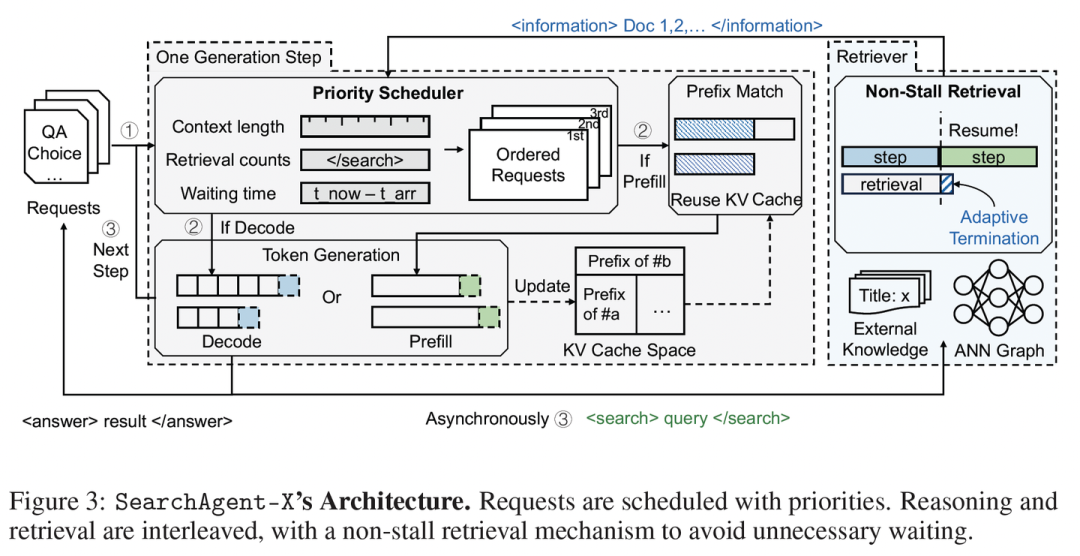

基于上述洞察,SearchAgent-X 通过智能调度与自适应检索,最大限度减少延迟,最大化GPU资源利用率,尤其提升KV-cache的有效利用。

1. 利器一:优先级感知调度 (Priority-Aware Scheduling)

为解决不当调度问题,SearchAgent-X 构建了一种优先级感知的任务排序机制,避免高价值任务被意外打断。

-

• 调度依据:不再“先来后到”,而是综合考虑三个指标来决定谁更重要: a. 已完成的检索次数:检索越多,越可能有高缓存复用价值;

b. 当前序列的上下文长度:同样指向更长的、可复用的缓存。

c. 请求的等待时间:确保公平,避免“饿死”老请求。 -

• 核心理念:这种策略旨在“让最有价值的计算优先”,优先服务那些能最大化GPU与缓存利用率的任务,以减少资源浪费。

2. 利器二:无停顿检索 (Non-Stall Retrieval)

为缓解检索停滞,SearchAgent-X 引入了“非阻塞检索”机制。

-

• 执行逻辑:检索模块会动态判断: a. 检索结果的成熟度:当新找到的资料带来的质量提升甚微,即达到“收益递减点”时,认为结果已足够好。

b. LLM引擎的就绪状态:判断LLM是否已准备好进行下一轮计算。 -

• 核心理念:当检索结果足够成熟 且 LLM引擎就绪时, SearchAgent-X便停止检索。

这种机制是“合适时机,果断放手”,从而让生成无需等待,实现检索-推理间的自适应同步,实现了异步检索与生成流程的自适应对齐。

三、全面评估:速度更快,答案稳定

研究者在Qwen-7B/14B等模型上,对SearchAgent-X与多种基线系统进行了全面对比。

1. 端到端性能:吞吐与延迟的显著优化

-

• 离线推理 (所有请求一次性到达):在Musique数据集上, SearchAgent-X的吞吐量比基线系统高出 1.3 至 3.4 倍,平均延迟降低至基线系统的 20% 至 60%。 -

• 在线推理 (请求持续到达): SearchAgent-X完成的请求数量比基线系统多 1.5 至 3.5 倍。请求速率越高,其优势越明显,最多时是某些基线的5.8倍。

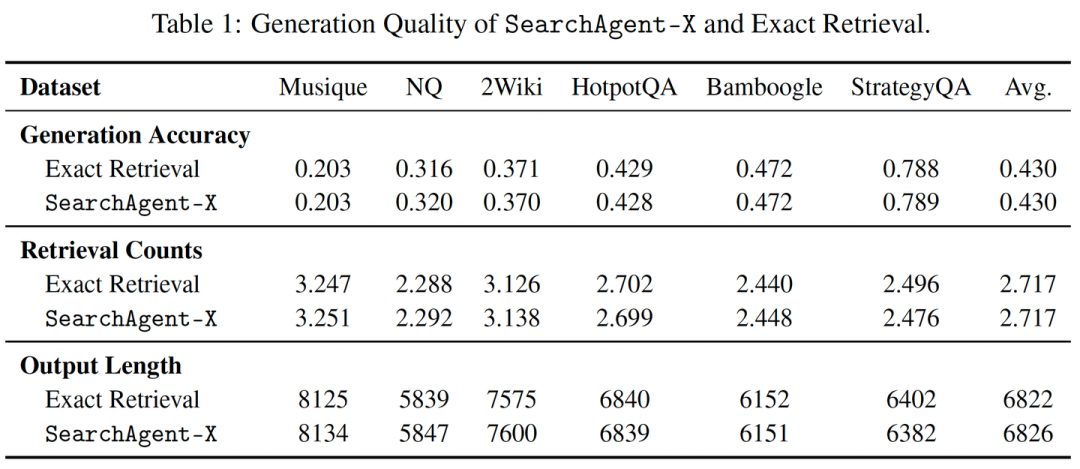

2. 生成质量:生成准确率保持稳定

在Musique, NQ, HotpotQA等六个代表性数据集上的评估表明,SearchAgent-X 在生成准确率上,与采用精确检索的基线系统表现相当。有趣的是,在某些数据集上,由于近似检索带来的轻微扰动促使模型进行额外推理,其准确率甚至略有提升。

3. 技术拆解:每一项优化都“功不可没”

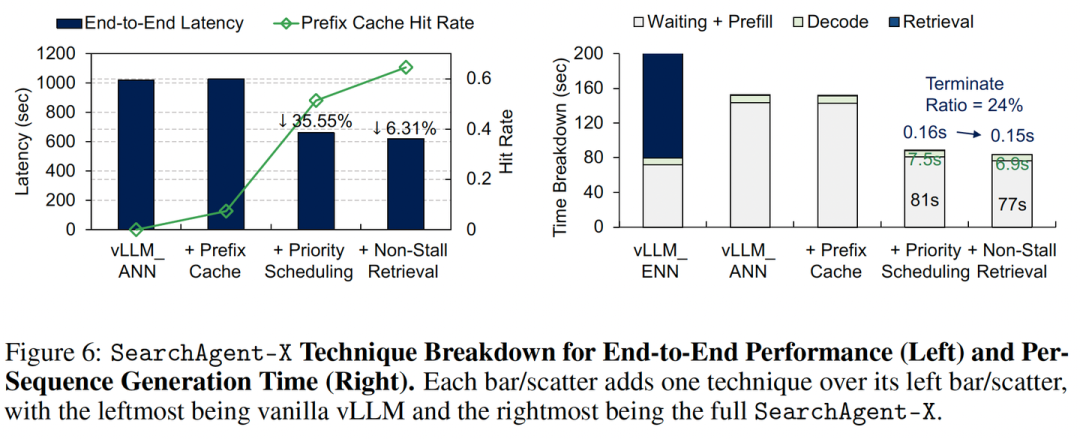

消融实验揭示了各组件的贡献:

-

• 优先级调度:在引入缓存的基础上,将端到端延迟降低了 35.55%,并将KV-cache命中率从可怜的 0.07 提升至 0.51。 -

• 无停顿检索:在前两者基础上,进一步将KV-cache命中率提升至 0.65。有趣的是,该机制平均仅使检索时间减少0.01秒,却显著降低了端到端延迟。这再次印证了“差之毫厘的等待,影响深远”:通过自适应地提前终止少量检索,避免了关键的调度延迟,从而大幅提升了系统效率。

四、 总结与展望

这项研究为所有复杂、多步骤的搜索智能体的效率问题提供了一个重要的解决范本。随着AI系统日益复杂、任务日趋开放,仅靠模型变“大”已难以应对真实场景需求。SearchAgent-X 通过系统级优化为搜索智能体注入新动能。

SearchAgent-X展示了AI算法与底层系统“协同设计”的巨大潜力。AI的进步不应仅仅依赖于更大的模型,更需要能高效运行这些复杂模型的智能系统。SearchAgent-X 所揭示的:

-

• 工具单点优化到系统全局协同:在AI智能体中,任何单一工具(如检索)的性能并非越高越好,需要与智能体的整体工作流相匹配。 -

• 从单次执行效率到批量并发响应能力的质变:在由多个异步组件构成的复杂AI系统中,微小的延迟和不当的资源调度会被急剧放大,造成雪崩效应。

通过优先级感知调度和无停滞检索两大创新,SearchAgent-X 这样兼顾推理质量与执行性能的系统,将成为构建企业级知识中枢、AI搜索引擎与智能助手的基石,助力AI真正走向高效、可落地的智能体时代。

(文:PaperAgent)