🚀企业AI部署专题⚡

FastAI Stack | OpenStation团队

DeepSeek-R1-0528新版本模型最新开源 。

这版模型在数学推理、代码生成这些硬核领域,性能又往前迈了一大步,而且幻觉问题也改善了不少。核心性能指标达到领先闭源模型水平。

如果你想在本地部署 DeepSeek 模型,用这个 0528 版替换掉原来的 R1,业务能力能再上一个台阶。

今天给大家安利一个开源工具:OpenStation。

它已经适配了 DeepSeek-R1-0528 新版模型,让你不用写一行代码,就能在集群里快速把新模型部署起来,还能分发服务。

这工具还带了简单高效的服务管理和资源管理功能,帮企业用户在本地服务器上安全、方便地部署和使用最新的 DeepSeek-R1-0528。

想尝鲜的,直接去 Gitee 翻翻 OpenStation 的开源主页,下载、看详情都行。有啥问题,还能通过项目主页的“用户交流”模块加群,跟技术大佬们直接聊。

OpenStation开源主页:

https://gitee.com/fastaistack/OpenStation

OpenStation 是个啥?

简单说,OpenStation 就是个一站式的大模型部署管理平台,专为企业和开发者设计,让你快速、方便地把大模型服务跑起来。

平台提供完整的模型管理、服务部署与用户协作功能,兼容标准 OpenAI API 接口,内置高效推理引擎,并提供灵活的资源扩缩容和精细的权限管理机制。

OpenStation的主要特点包括:

简单易用: 通过页面化的操作,仅需几步点击即可快速完成DeepSeek等大模型的部署

标准接口: 部署的服务提供标准的OpenAI API兼容接口,方便多种客户端工具快速接入

高性能: 支持SGLang、vLLM及CPU部署方式,支持单机及分布式部署,提供高效灵活的推理引擎能力

便捷资源管理: 通过页面化的操作,实现平台节点资源的快速添加与删除

负载均衡: 提供统一推理服务入口,支持服务无感知的快速扩容和缩容能力

用户鉴权管理: 支持用户维度的API-key鉴权管理,实现推理服务的访问权限控制

怎么用?

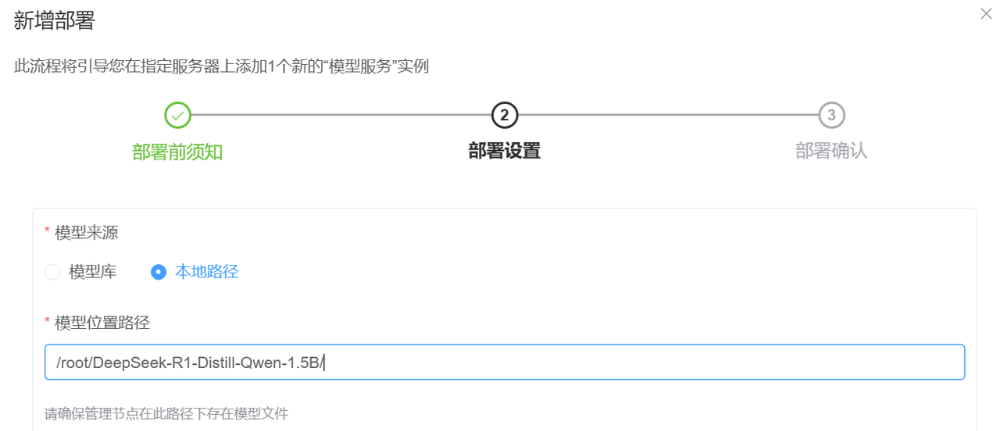

1、部署模型

在OpenStation内可以便捷地部署DeepSeek和Qwen3大模型,点击模型的对应版本名称即可自动化下载模型,其中DeepSeek-R1-0528最新版本模板已经完成适配。

OpenStation也支持传入用户指定的其他本地模型进行部署。根据部署过程中选择的计算资源,OpenStation会使用vLLM、SGLang等不同的框架对推理服务提供CPU、GPU加速。

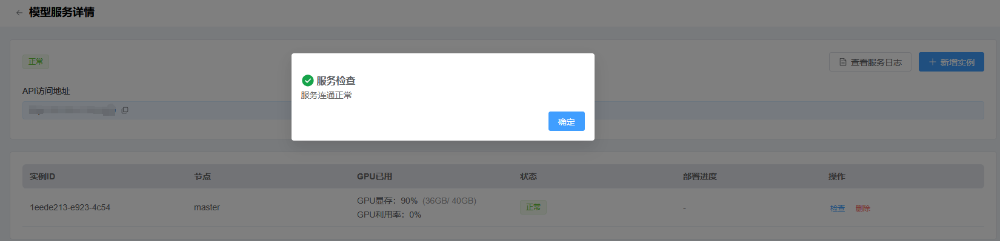

服务部署之后,即可获得大模型的推理服务API。在界面内可以查看推理服务的资源占用量和健康状况、查看服务日志信息。

2、分发服务

OpenStation可以配置邮箱服务器,并将推理服务访问信息分发给指定用户,简化大模型服务的批量管理。

根据配置信息,在上线服务后会将新服务的使用方法以邮件形式通知OpenStation的用户。

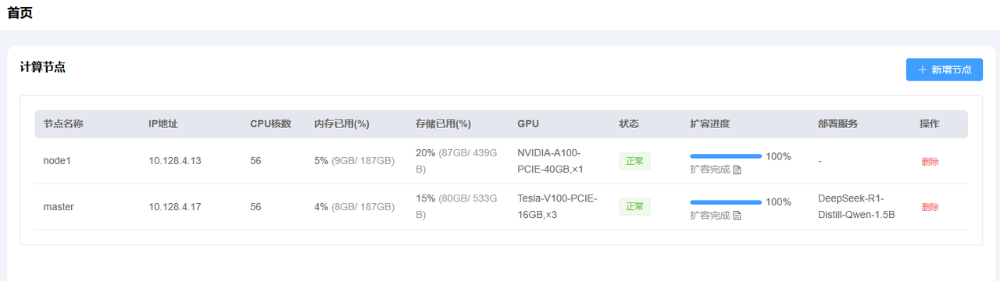

3、资源管理

OpenStation能够统一管理多个服务器上的计算资源和服务调度,在界面内可以直观查看资源占用信息和运维信息,并对服务部署情况进行总览。

OpenStation提供了便捷的集群节点扩容和缩容能力,在界面内填入指定服务器的基础信息后,OpenStation即可将对应服务器纳入到服务部署管理范围内。

获取软件

直接去开源社区拿 OpenStation 的下载包或者下载脚本,详细用法里面都有。同时,在“用户交流”模块,还能加专家群聊,实时问问题、提建议:

https://gitee.com/fastaistack/OpenStation

🚀 OpenStation让企业级AI部署变得简单高效,助力您快速构建本地化AI服务能力。

(文:AI进修生)