今天凌晨,苹果召开了“WWDC 2025”全球开发者大会,并宣布在iPhone、iPad、Mac、Apple Watch和 Apple Vision Pro中集成全新Apple Intelligence功能,以提升用户体验。

这些功能包括ChatGPT图像生成、实时翻译、AI视觉、生成表情符号、快捷指令、Workout Buddy等众多实用AI功能。最让人惊喜的一个就是苹果开放了Intelligence基础模型访问权,开发者可以开发适配苹果生态的AI应用了。

苹果公司软件工程高级副总裁Craig Federighi表示,去年,我们迈出了第一步,为用户提供既实用又相关、易于使用且在用户需要的地方随时可用的智能体验,同时保护他们的隐私。今年,驱动 Apple Intelligence 的模型变得更加强大和高效,我们将其整合到各个操作系统的更多地方。

我们还向开发者开放驱动 Apple Intelligence 的设备端基础模型的直接访问权限,让他们能够利用这种强大、快速、注重隐私且离线可用的智能功能。我们相信这将激发开发者在用户日常依赖的应用中创造全新的智能体验。

ChatGPT图像生成和表情符号

Genmoji和Image Playground 为用户提供了更多自我表达的途径。除了可以将文本描述生成Genmoji外,用户现在还可以混合不同的表情符号,并结合文字描述创造新的内容。

当用户使用Genmoji 和Image Playground 创作以家人和朋友为灵感的图像时,还能更改表情或调整发型等个人特征,以匹配朋友的最新造型。

在Image Playground中,用户可以通过ChatGPT 使用全新风格,例如,油画风格、矢量以及火爆全球的吉卜力风格。如果用户有特定的创意想法,可以点击 “任意风格”并描述需求。

Image Playground 会将用户的描述或照片发送给 ChatGPT,生成独特的图像。所有操作均由用户掌控,未经许可不会向ChatGPT分享任何内容。

实时翻译打破语言障碍

当语言障碍成为交流阻碍时,实时翻译功能可以帮助用户在消息传递或语音交流中进行跨语言沟通。该功能集成在信息、FaceTime 和Phone应用中,由完全在设备端运行的苹果自研模型支持,确保用户的私人对话保持私密性。

在信息应用中,实时翻译可以自动翻译消息。例如,用户在国外旅行时与新朋友制定计划,输入消息时即可进行翻译,并以收件人偏好的语言发送;

收到回复时,每条消息都能即时翻译。在 FaceTime 通话中,用户可以一边聆听发言者的声音,一边查看实时翻译字幕。在电话通话中,翻译内容会在整个对话过程中语音播报。

AI视觉助力用户搜索和操作

基于 Apple Intelligence,视觉智能功能扩展到用户的 iPhone 屏幕,使他们能够对应用中正在查看的任何内容进行搜索和操作。

视觉智能此前已通过 iPhone 摄像头帮助用户了解周围的物体和地点,现在更能让用户对屏幕内容进行更快捷的操作。

用户可以针对屏幕上的内容向ChatGPT 提问以获取更多信息,还能通过 Google、Etsy 或其他支持的应用搜索相似图片和商品。如果用户对某个物体(如台灯)特别感兴趣,可以通过高亮该物体搜索特定商品或类似物品。

视觉智能还能识别用户正在查看的事件,并建议将其添加到日历中。Apple Intelligence 会提取日期、时间和地点等关键信息,自动填充到事件中。

用户只需按下与截取屏幕相同的按钮,即可访问屏幕内容的视觉智能功能。用户可以选择保存或分享屏幕截图,或通过视觉智能进一步探索内容。

Apple Watch上新体验Workout Buddy

Workout Buddy 是Apple Watch 上首款集成 Apple Intelligence 的健身体验功能,它结合用户的锻炼数据和健身历史,在锻炼过程中生成个性化的激励性洞察。

为了实时提供有意义的激励,Workout Buddy 会分析用户当前锻炼数据及健身历史,包括心率、配速、距离、活动圆环、个人健身里程碑等数据。全新的文本转语音模型会将洞察转化为动态生成的语音,该语音基于 Fitness + 教练的语音数据构建,具备适合锻炼场景的活力、风格和语调。Workout Buddy 通过 Apple Intelligence 对数据进行私密且安全的处理。

Workout Buddy 将在配备蓝牙耳机的 Apple Watch 上使用,且需要附近有支持 Apple Intelligence的 iPhone。该功能首发支持英语,适用于多种热门锻炼类型:户外和室内跑步、户外和室内步行、户外骑行、高强度间歇训练(HIIT)以及功能性和传统力量训练。

Intelligence内置模型现已向开发者开放

苹果正开放对 Apple Intelligence 核心设备端基础模型的访问权限,任何应用都能直接调用该模型。

通过基础模型框架Foundation Models framework,开发者可以基于 Apple Intelligence 构建新体验,为用户带来智能、离线可用且保护隐私的功能,同时使用免费的 AI 推理服务。

例如,教育类应用可以利用设备端模型从用户笔记中生成个性化测验,无需支付云API费用;户外类应用可以添加即使在离线状态下也能使用的自然语言搜索功能。

该框架原生支持Swift 语言,开发者只需三行代码即可轻松访问 Apple Intelligence模型。框架内置引导式生成、工具调用等功能,让开发者能更便捷地将生成式功能集成到现有应用中。

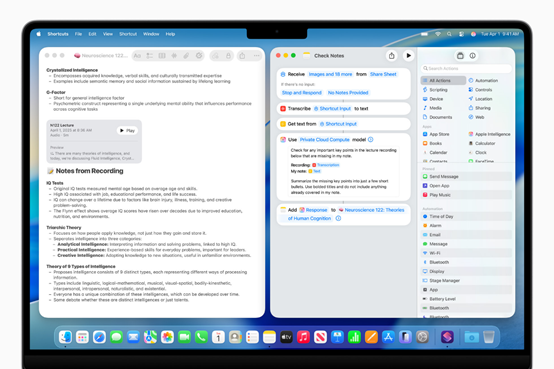

更智能快捷指令

快捷指令现在比以往任何时候都更强大、更智能。用户可以使用由 Apple Intelligence 支持的全新 “智能操作”。用户将看到专门用于写作工具文本总结或图像游乐场图像创建等功能的操作选项。

现在,用户可以直接调用 Apple Intelligence 模型(设备端或私有云计算)生成响应,并将其融入快捷指令的后续流程,同时确保快捷指令中使用的信息隐私。

例如,学生可以创建一个快捷指令,利用 Apple Intelligence 模型将课堂讲座的音频转录与自己的笔记进行对比,并添加可能遗漏的关键点。用户也可以选择调用 ChatGPT 生成响应并融入快捷指令。

Intelligence其他功能更新

提醒事项:现在可以识别电子邮件、网站、笔记或其他内容中的关键操作,并自动分类。

ChatGPT集成:在写作工具和 Siri 中可直接调用 ChatGPT,无需切换工具即可使用其图像和文档理解能力。

苹果钱包:可以识别并汇总商家或物流公司发送的电子邮件中的订单跟踪详情。用户可以在一个地方查看所有订单的完整详情、进度通知等信息。

信息应用:用户可以在信息应用中为任何事项创建投票,Apple Intelligence 会检测何时需要投票并提出建议。此外,信息应用中的“背景” 功能允许用户用精美的设计个性化聊天界面,还能通过Image Playground 创建适合对话主题的独特背景。

写作工具:帮助用户重写、校对和总结文本。通过 “描述修改”功能,用户可以描述具体修改需求,例如将晚宴邀请信改写为诗歌风格。

图像魔杖:将粗略的草图转化为精致图像,与用户的笔记相得益彰。

邮件摘要:点击 “总结” 即可查看电子邮件或长线程的关键信息。

智能回复:在邮件和信息应用中提供快速回复建议。

Siri:更自然、更智能,支持向 Siri 打字提问,利用其产品知识解答苹果设备的功能和设置问题;支持识别用户表述中的停顿,并保持请求之间的上下文连贯。

通话转录摘要:生成通话转录摘要,突出重要细节。

苹果还提供了很多其他好用的AI功能,总之非常多,有兴趣的小伙伴可以看官网公告。

何时可以使用这些功能

所有新功能从即日起通过 Apple Developer Program提供测试,下个月将通过 Apple Beta Software Program推出公开测试版。

今年秋季,使用支持语言的兼容设备用户将可使用这些功能,包括所有iPhone 16型号、iPhone 15 Pro、iPhone 15 Pro Max、配备A17 Pro 的 iPad mini,以及搭载 M1 及后续芯片的 iPad 和 Mac 设备,

且需将Siri 和设备语言设置为支持的语言,英语、法语、德语、意大利语、葡萄牙语(巴西)、西班牙语、日语、韩语或简体中文。

到今年年底还将新增支持丹麦语、荷兰语、挪威语、葡萄牙语、瑞典语、土耳其语、繁体中文和越南语。部分功能可能不适用于所有语言或地区,具体可用性可能因当地法律和法规而异。

(文:AIGC开放社区)