允中 发自 凹非寺

量子位 | 公众号 QbitAI

近年来,LLM Multi-Agent系统引起广泛关注。它们各显神通,协同作战解决复杂难题。然而,一顿操作猛如虎,最终结果却“惨不忍睹”,一整个任务失败。

这时候,你是不是头都大了:究竟是哪个环节的哪个Agent出了岔子?

在日益复杂的Multi-Agent系统中,由于Agent之间自主协作、信息链条长,失败不仅常见,而且诊断起来极其困难。如果我们不能快速定位失败的根源,系统的迭代和优化就无从谈起。

针对这个问题,宾夕法尼亚州立大学与杜克大学联合Google DeepMind等机构的研究者们首次提出了“自动化失败归因”这一全新研究课题,并为此构建了首个专用基准数据集Who&When,开发和评估了多种自动化归因方法。

这项工作不仅深刻揭示了该任务的复杂性,也为未来提升LLM Multi-Agent 系统的可靠性开辟了新的道路。

该论文获ICML 2025 Spotlight,代码与数据集已全部开源。

首次提出“自动化失败归因”课题

LLM驱动的Multi-Agent系统在很多领域展现出巨大潜力。然而,这些系统也存在着脆弱性:单个Agent的失误,Agent之间的误解,以及信息传递错误,都可能导致整体任务失败。

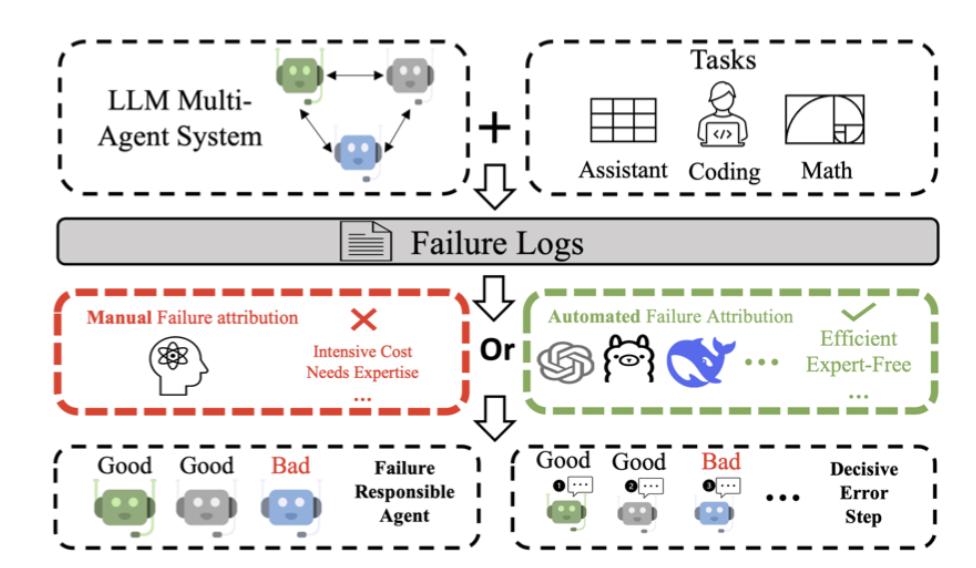

目前,一旦系统“翻车”,开发者往往只能:手动“考古”,逐条翻阅冗长的交互日志,试图找出问题所在;又或者依赖经验,这种调试过程高度依赖开发者对系统和任务的深入理解。

这种“大海捞针”式的排错方式,不仅效率低下,更严重阻碍了系统的快速迭代和可信赖度的提升。目前迫切需要一种自动化、系统化的方法来定位失败原因,将“评估结果”与“系统改进”有效连接起来。

针对上述挑战,这篇论文做出了开创性的贡献:

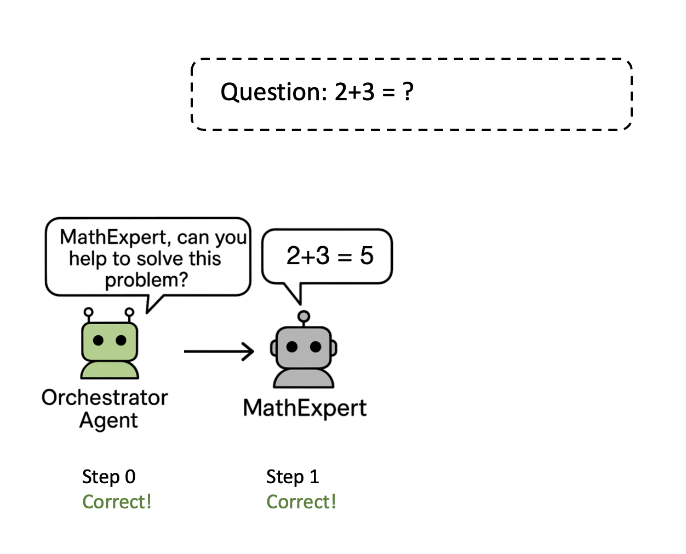

首先,提出并定义新问题,首次将“自动化失败归因”形式化为一个具体的研究任务,明确了要找出导致失败的责任Agent(failure-responsible agent)和决定性错误步骤(decisive error step)。

其次,他们构建首个数据集Who&When,该数据集包含了从127个LLMMulti-Agent系统中收集的广泛失败日志。这些系统既有算法自动生成的,也有人类专家精心打造的,确保了场景的真实性和多样性。

每条失败日志都配有细粒度的人工标注:

-

“谁”(Who):哪个Agent是“罪魁祸首”。 -

“何时”(When):决定性错误发生在交互的哪一步。 -

“为何”(Why):对失败原因的自然语言解释。

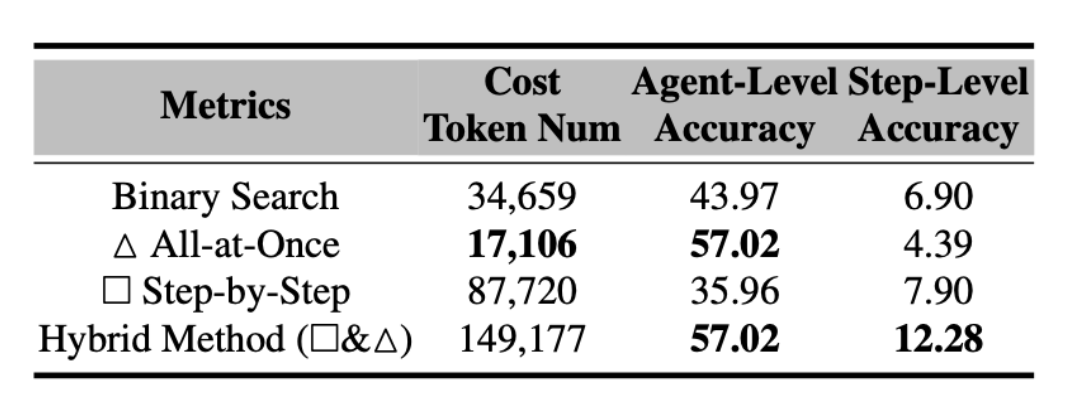

最后,他们初步探索了“自动化归因”方法。基于Who&When数据集,论文设计并评估了三种不同的自动化失败归因方法:全局审视法(All-at-Once),逐步侦查法(Step-by-Step),二分定位法(Binary Search)。

实验结果表明:这三种方法在准确性、成本和分析粒度上各有千秋,没有一种能在所有指标上完胜。它们共同构成了自动化失败归因任务的初步“解法库”。

All-at-Once:向LLM提供用户查询和完整的故障日志,要求其一次性识别出故障责任Agent以及发生决定性错误的具体步骤。它的优点是一步到位,成本较低,可能擅长宏观判断责任。但可能面临“大海捞针”问题,难以从长上下文中精确定位具体错误步骤。

Step-by-Step:模拟人工调试,让LLM从头开始,一步步检查交互日志,在每个环节判断当前是否出现错误,直到揪出“真凶”。它如同剥洋葱般细致,在定位具体错误环节上更具优势;不过需要多次询问模型,调用成本较高,且局部判断的累积误差可能导致“误判”。

Binary Search:这是一种折中策略。将日志对半切分,利用LLM判断错误发生在前半段还是后半段,然后不断在确定的半段中递归“二分”,最终锁定问题步骤和相关Agent。该方法总成本和效果介于前两者之间。

实验结果与主要发现

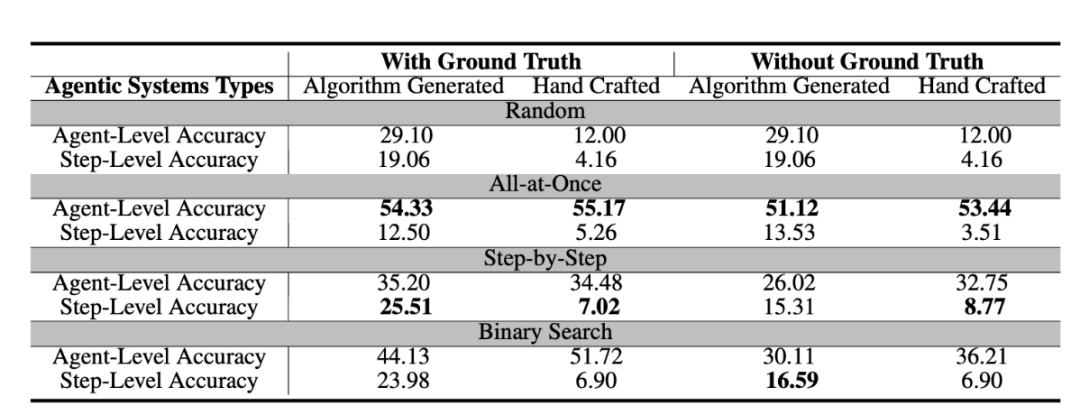

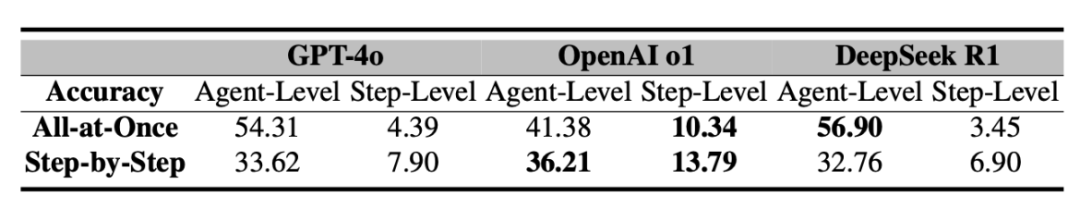

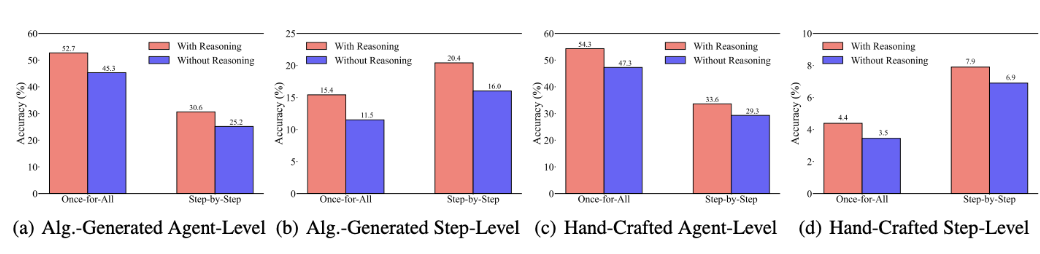

实验在两种设定下进行:LLM知道Multi-Agent系统需要解决的问题的真实答案(With Ground Truth)和不知道真实答案(Without Ground Truth)。主要使用GPT-4o,但也测试了其他模型(如Llama系列、Qwen系列、GPT系列、OpenAI o1、DeepSeek R1)

通过在Who&When数据集上对上述方法进行了系统评估,得到了许多重要的发现:

首先,目前的方法离完美还差得很远。即便是表现最好的单一方法,在识别“背锅Agent”上的准确率也仅有约53.5%,而在准确定位“错误步骤”上,准确率更是低至14.2%。这意味着,最牛的策略也只能勉强过半猜对谁是“内鬼”,至于错在哪一步,基本靠“蒙”。有些方法的表现甚至不如随机猜测,足见任务之艰巨。

其次,不同方法在不同子任务上表现各异,没有万能冠军。例如,All-at-Once方法对“Who”的判断相对最好,能够更准确地找出哪个Agent应该负责;而Step-by-Step方法在锁定具体错误步骤(“When”)上效果更胜一筹,细粒度检查带来了优势;Binary Search方法则各方面居中,表现中规中矩。由此体现出每种方案的权衡取舍:要么整体扫描擅长找“人”,要么逐步追查利于找“步骤”。

还有“组合拳”效果更优,但代价高昂:研究者尝试了组合不同方法的策略(例如,先使用“全局法”初步判断责任Agent,再运用“逐步法”精确定位错误步骤)。结果表明,这种混合方法确实能够提升整体的归因性能,但同时也带来了显著的计算成本增加。

最令人惊讶的是,即便是当前最先进的推理模型(如OpenAI o1和DeepSeek R1),在处理这一任务时也显得力不从心。这进一步凸显了“自动化失败归因”任务本身的固有难度,其对AI推理能力的要求超越了当前SOTA模型在常规任务上的表现。

此外,明确的推理提示至关重要:在All-at-Once和Step-by-Step的提示中明确要求LLM给出归因的理由,能起到提升性能的作用。

而上下文长度对性能构成制约,实验还发现,随着失败日志上下文长度的增加,所有归因方法的性能均呈现下降趋势,尤其是在错误步骤定位的准确性方面更为敏感。

总结

“自动化失败归因”是Multi-Agent系统开发流程中不可或缺的一环。它将帮助我们更深入地洞察Multi-Agent的失败模式,将“哪里出错、谁之过”从令人头疼的谜题,转变为可量化分析的问题。通过架起“评估”与“改进”之间的桥梁,我们终将能够打造出更可靠、更智能、更值得信赖的Multi-Agent协作系统。

论文机构:宾夕法尼亚州立大学,杜克大学,Google DeepMind,华盛顿大学,Meta,南洋理工大学,俄勒冈州立大学

论文的共同第一作者是宾夕法尼亚州立大学的Shaokun Zhang和杜克大学的Ming Yin。

论文传送门:https://arxiv.org/pdf/2505.00212

代码传送门:https://github.com/mingyin1/Agents_Failure_Attribution

数据集传送门:https://huggingface.co/datasets/Kevin355/Who_and_When

— 完 —

📪 量子位AI主题策划正在征集中!欢迎参与专题365行AI落地方案,一千零一个AI应用,或与我们分享你在寻找的AI产品,或发现的AI新动向。

💬 也欢迎你加入量子位每日AI交流群,一起来畅聊AI吧~

一键关注 👇 点亮星标

一键三连「点赞」「转发」「小心心」

欢迎在评论区留下你的想法!

(文:量子位)