Hume团队 投稿

量子位 | 公众号 QbitAI

机器人也能慢思考了!

上海交通大学携手智元机器人等团队推出了Hume——融合系统2(System-2)慢思考的双系统VLA模型。通过动作价值引导的动作采样与双系统级联动作去噪,实现深度推理与实时控制的完美结合。

在涵盖长时序规划、复杂柔性物体操作等多种任务场景的广泛实验中,Hume在多种机器人平台上均展露出了惊艳表现,显著超越当前的最先进模型。

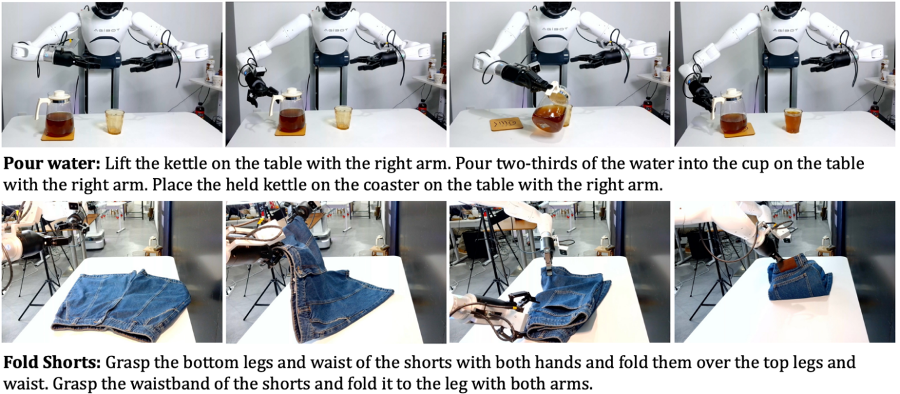

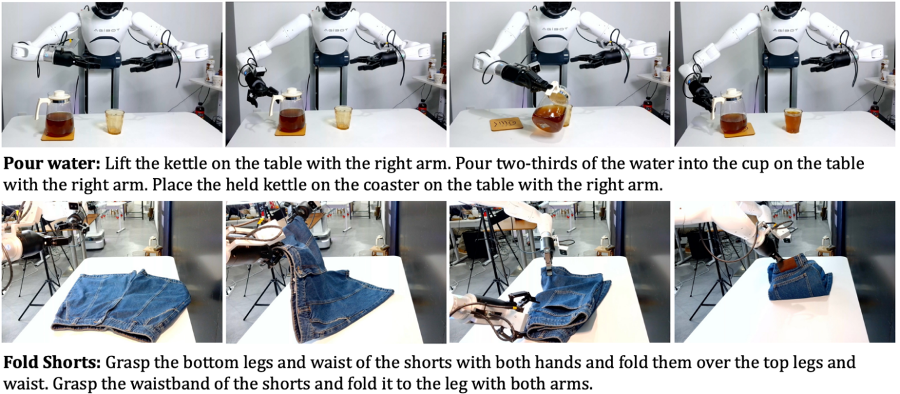

比如像折叠短裤、倒咖啡等操作,Hume加持下机器人也能得心应手。在各种复杂场景中达到了91%的平均成功率。

VLA模型缺失的慢思考能力

视觉-语言-动作(VLA)模型在构建通用机器人策略方面取得了显著进展,OpenVLA、π0、GR00T等最新研究已在不同任务中展示了较强的适应能力。

然而当前的VLA模型大多依赖于直觉反应模式,即根据当前环境“本能地”预测动作,这使得它们在解决复杂、长时序的决策任务时表现不佳。

与之相对的是,系统2慢思考已经通过测试时计算大幅提升了大语言模型(LLM)解决复杂逻辑推理问题的能力。但将这种思考范式应用在需要与物理世界交互的机器人上仍是一个巨大挑战。

首先,如何让VLA模型能够在高维连续的动作空间内进行系统2慢思考。大语言模型的输出是离散的词元,这使得大语言模型能够像人类一样用语言自然地进行系统2慢思考。然而VLA模型的输出是一组高维的连续动作值,如何有效利用这些高维连续动作进行系统2慢思考成为赋予VLA模型“慢思考”能力的首要挑战。

其次,系统2慢思考极大的推理时间开销与机器人的高频实时控制要求之间存在显著矛盾。系统2慢思考依赖于模型在推理时对不同输出的探索与重复采样,因此需要耗费大量时间,而机器人控制任务又需要模型快速地推理以产生流畅连续的运动轨迹。在平衡模型推理时间与机器人实时控制需求的问题上,Helix,GR00T等研究使用潜向量(latent vector)连接两个不同推理频率的系统,有效解决了大参数模型推理缓慢背景下的高频机器人控制问题。然而,使用潜向量连接两个系统不仅无法确保潜向量能在两个系统间传递恰当的信息,还会导致训练过程的复杂度增加。因此,使用一种适当的表征连接两个系统成为“慢思考”VLA模型迈向真实机器人部署的第二个挑战。

系统2慢思考赋能VLA模型

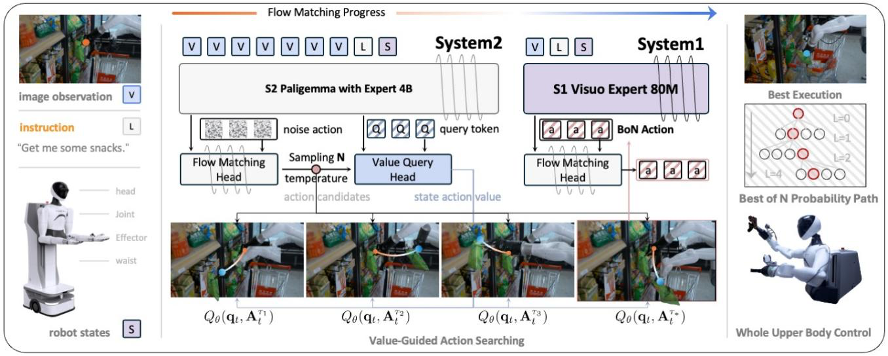

为应对以上挑战,本文提出Hume——引入系统2慢思考的双系统VLA模型,赋予机器人深度思考和长时规划的能力。给定视觉观察和语言任务指令,系统2首先通过动作去噪生成模块产生多个候选动作,随后使用动作价值估计模块预测所有候选动作的状态-动作价值(即Q值),并将Q值最高的候选动作传递给轻量级的系统1。之后系统1利用级联动作去噪根据实时观测对候选动作进一步细化,最终输出高频率的连续动作指令,实现机器人流畅且精准的控制。

-

动作价值引导的系统2慢思考:Hume通过动作价值估计模块,对具有不同噪声水平的候选动作估计其状态-动作价值,选择出价值最高的候选动作,实现深度思考和高质量动作选择,显著提升机器人对复杂任务的规划与决策能力。

-

级联动作去噪的系统1高频控制:系统1接收系统2选定的未完全去噪的动作片段,并根据实时观测去除动作片段上的剩余噪声,保证动作流畅、连续且精准,满足机器人对实时、高频控制的需求。

-

异步双系统协同架构:系统2以较低频率进行动作价值引导的深度慢思考,系统1以高频率快速推理执行动作,两者通过异步机制协同工作,兼顾推理精度和实时响应,解决了系统2思考速度较慢与机器人的高频实时控制要求之间的矛盾。

具体来说,给定视觉观察和语言任务指令L,模型首先通过预训练视觉语言模型处理输入,利用动作去噪生成模块生成多个候选动作。随后,动作价值估计模块输出每个候选动作的状态-动作价值,选出最优动作。接着,轻量级系统1接收该最优候选动作,采用级联动作去噪对动作序列进行细化处理,输出高频率的连续动作指令,以供机器人实时执行。

该模型包含三个关键组件: (1) 动作去噪生成模块基于预训练视觉语言模型生成候选动作,学习建模多模态输入与机器人动作的映射关系;(2) 动作价值估计模块负责估计候选动作的状态-动作价值,选择当前状态下的最优动作;(3) 系统1利用级联动作去噪实现动作细化与实时控制。

结果发现,得益于系统2深度慢思考与系统1高频快速推理的有机结合,Hume显著提升了机器人在长时序和复杂任务中的控制精度。

动作价值引导的系统2思考

在系统2中,团队设计了一种基于动作价值引导的慢思考机制,使模型能够从多个备选动作中选择最优方案。团队首先通过动作去噪生成模块学习映射函数F,从观测中生成候选的机器人动作。

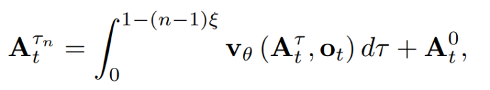

该过程基于流匹配去噪方法,预测”噪声动作”中的剩余噪声。去噪过程从随机噪声开始,通过前向欧拉方法逐步去噪。在推理阶段,基于相同观测,动作去噪生成模块产生N个不同噪声级别的候选动作片段:

其中ξ控制相邻候选间的噪声间隔,n为从1到N之间的整数,这意味着多数生成的候选动作均带有一定水平的噪声。

为了评估动作质量,团队设计了值查询头来估计状态-动作值。

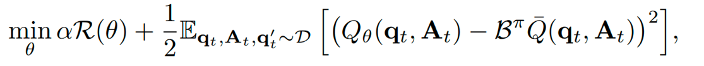

具体而言,团队引入特殊查询标记并将其附加到VLM输入序列末尾。在经过VLM的前向推理过程后,查询标记包含了当前状态下的环境观测信息。之后动作片段将与查询标记共同输入动作价值估计模块,根据输入估计对应动作片段的状态-动作价值。动作价值估计模块通过离线强化学习方法训练,其优化目标为:

其中,R(θ)是正则化项,用于防止Q值过度估计。

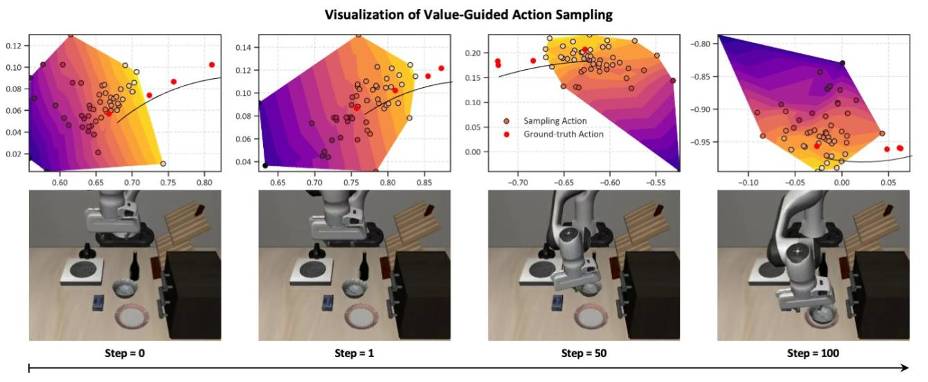

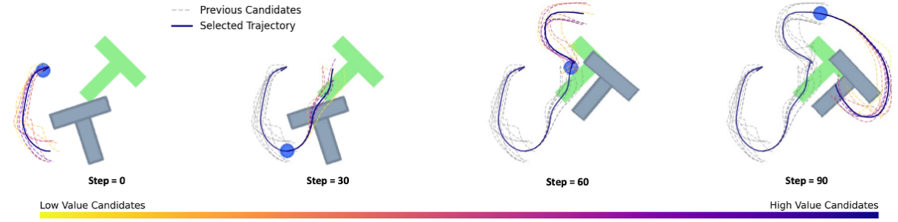

为了验证训练流程能有效优化动作价值估计模块,团队通过主成分分析法(PCA)将真值动作和候选动作及其对应的状态-动作值投影到同一二维空间中,生成如下图所示的值映射图。

该值映射图包含表示不同状态-动作值大小的区域,真值动作全部位于高值区域,这证明了值查询头能够估计合理的状态-动作值。

从下图中可以直观地看出,随着候选动作接近真值动作,其对应的Q值也随之增加,这为基于动作价值估计的动作选择提供了可靠基础。

紧接着,系统2通过Best-of-N选择策略,从N个候选中选择具有最高状态-动作值的动作作为最优候选。这种方法使模型能够模拟人类的深度慢思考过程,通过评估多个候选动作选择最佳动作轨迹。

双系统级联动作去噪

为了实现快速响应的机器人控制,系统1需要轻量化以实现高频快速推理。系统1由DINOv2-small视觉编码器和轻量级transformer组成,用于级联动作去噪。给定系统2选择的候选动作片段 ,系统1将当前观测的图像、机器人状态

,系统1将当前观测的图像、机器人状态 和从中分割的子动作片段

和从中分割的子动作片段 作为输入,通过对子动作片段继续去噪生成精细的机器人动作。

作为输入,通过对子动作片段继续去噪生成精细的机器人动作。

具体而言,在时间步t,系统2选择的动作片段 被分割成个子动作片段,系统1依次对这些子动作片段进行级联去噪。同时,由于系统2生成的候选动作片段未完全去噪,因此需要系统1继续去噪以获得准确的动作。系统1的去噪过程并不从随机噪声开始,而是从子动作片段

被分割成个子动作片段,系统1依次对这些子动作片段进行级联去噪。同时,由于系统2生成的候选动作片段未完全去噪,因此需要系统1继续去噪以获得准确的动作。系统1的去噪过程并不从随机噪声开始,而是从子动作片段 开始:

开始:

在推理阶段,系统2和系统1以异步机制协作,提高整体控制频率。具体而言,在初始时间步t,系统2的动作去噪生成模块以较低频率生成N个时间跨度H的动作作为候选。接着,从最优候选 的h步分割出子动作片段

的h步分割出子动作片段 并传递给系统1。系统1以较高的频率去除

并传递给系统1。系统1以较高的频率去除 中的剩余噪声,产生完全去噪的动作

中的剩余噪声,产生完全去噪的动作 并在机器人上执行。

并在机器人上执行。

这种双系统级联动作去噪架构使模型能够平衡深度慢思考与机器人控制的高实时性要求,为复杂任务执行提供了高效灵活的解决方案。

实验验证

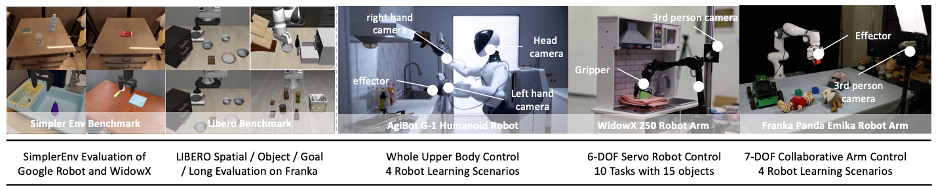

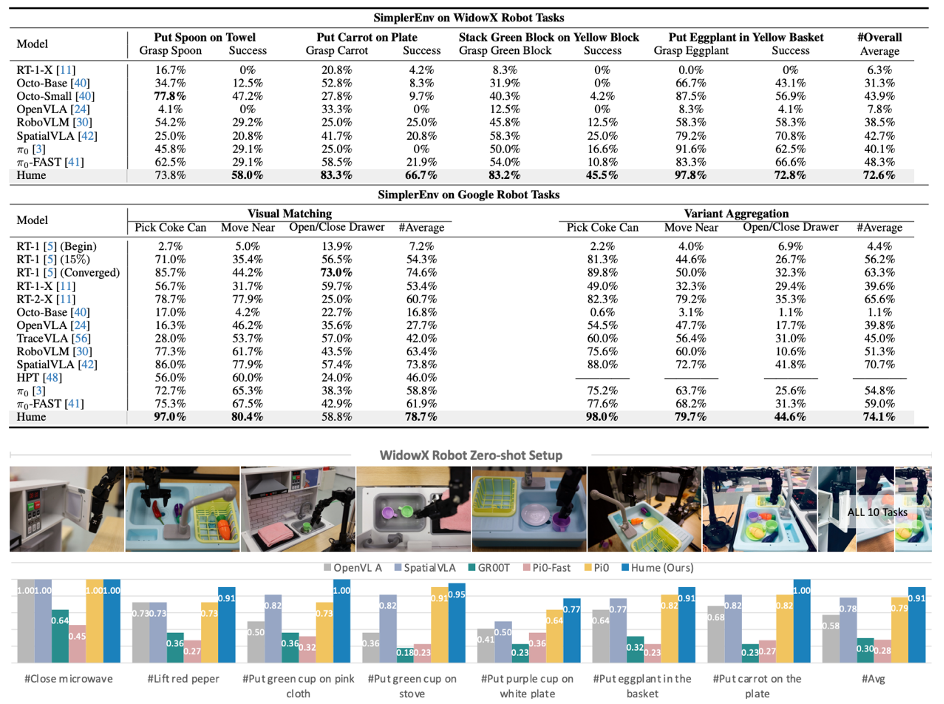

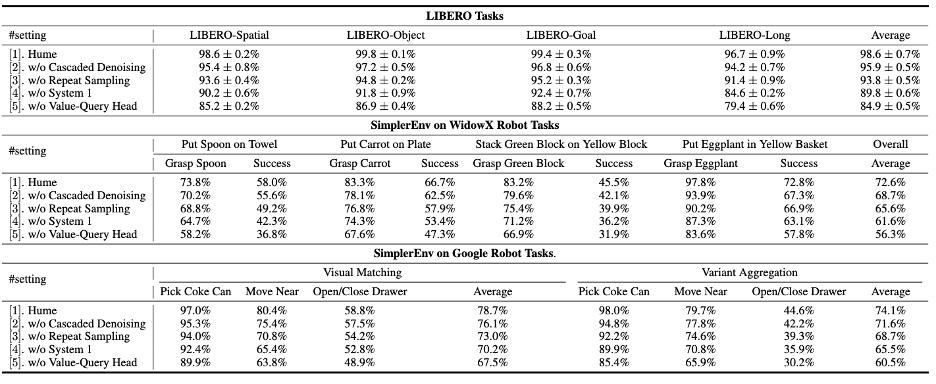

团队在多样化的机器人学习场景中评估Hume的能力,包括3种仿真环境和3个不同的真实机器人平台,涵盖了15个机器人学习场景和21个真实世界操作任务。团队在SimplerEnv和LIBERO仿真基准上验证了Hume的多任务学习能力,在WidowX、Franka和AgiBot G-1真实机器人平台上测试了其泛化能力。

同时,还进行了全面的消融研究,验证了动作价值引导的慢思考和双系统级联去噪等关键模块的有效性。

实验表明,Hume在各种评估中均取得了惊艳表现,在LIBERO上达到了98.6%的平均成功率,在真实WidowX任务中取得91%的平均成功率,显著超越了现有的通用机器人控制策略。

1. 系统2慢思考赋能VLA

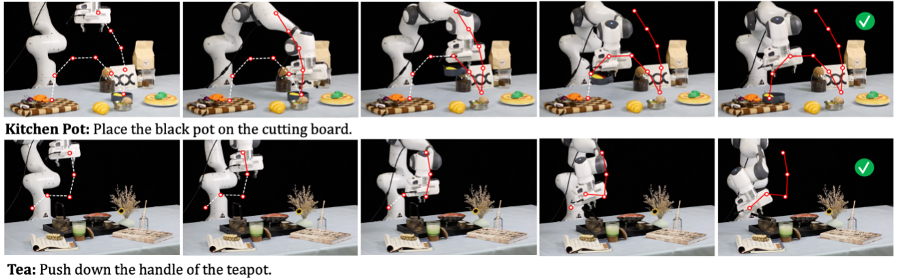

动作价值引导的慢思考能力:HUME通过系统2的动作价值估计模块实现了机器人操作的”慢思考”,使得机器人能够在面临复杂任务时进行长期规划。为了更有效的说明这一点,团队在Push-T任务中对Hume的推理过程进行了详细可视化,展示了系统2采样的多个候选动作轨迹和系统1最终执行的精确动作。如图所示,系统1去噪后的动作更平滑、更精确,有效完成了精细操作任务。

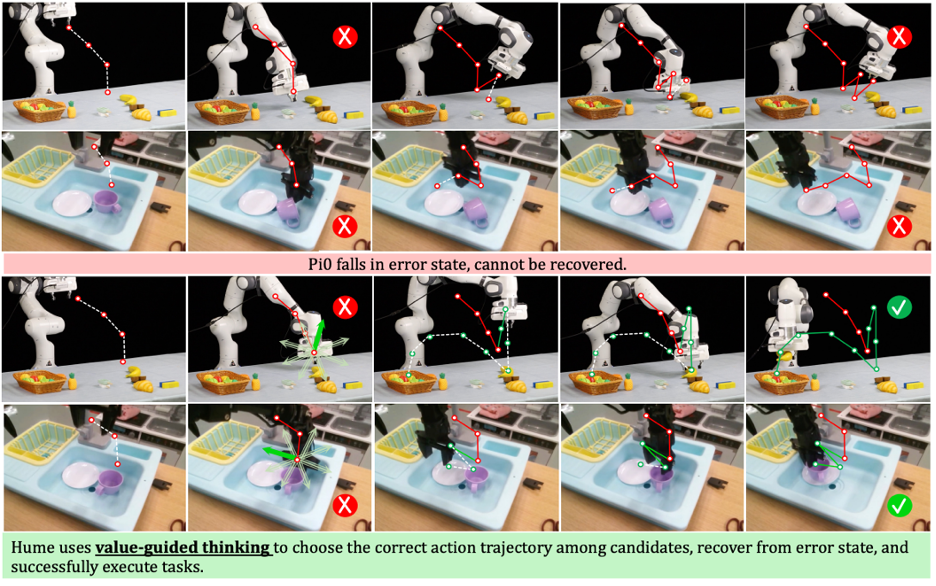

失败恢复能力:Hume展现了卓越的失败恢复能力,这是其系统2慢思考的重要体现。当机器人进入错误的state时,Hume能够通过动作价值引导的慢思考从多个候选动作中选择最佳方案引导机器人恢复。与之对比,常见的模仿策略如π₀和GR00T在遇到训练数据中未出现的错误状态时常常无法恢复。实验表明,即使在相同的错误状态下,Hume通过重复采样未完全去噪的候选动作,并基于动作价值估计选择最佳动作,成功率显著高于其他方法。在真实WidowX实验中,当其他模型因抓取失败而完全放弃任务时,Hume能够在多次尝试后调整轨迹并成功完成任务,展示了系统2慢思考能力在复杂环境中的适应性优势。

2. 仿真与真实世界机器人惊艳表现

多任务仿真评估:团队将Hume与最新的通用操作策略进行比较,包括RT-1、RT-1-X、RT-2-X、Octo、OpenVLA、HPT、TraceVLA、RoboVLM、SpatialVLA、GR00T和π₀等,在SimplerEnv和LIBERO仿真基准上评估了Hume的性能。

在SimplerEnv基准中,Hume在WidowX多任务上取得了72.6%的平均成功率,比π₀高出32.5%,比OpenVLA高64.8%;在Google机器人任务上,达到了76.4%的平均成功率,比π₀高出19.6%。在LIBERO基准测试中,Hume取得了98.6%的最高平均成功率,比π₀高出4.4%,比GR00T高出4.7%。

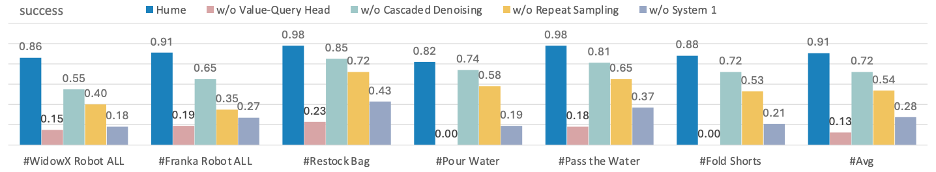

真实世界机器人控制:团队在三种不同的真实机器人平台包括WidowX、Franka及人型机器人AgiBot G-1上进行了广泛测试。任务设计涵盖了不同难度的操作,包括工具使用、柔性物体物体操作和长时序复杂任务等。在WidowX上,团队比较了代表性的单系统VLA模型和双系统VLA模型在多种任务中的表现。

结果显示,在简单任务场景中,大多数策略都表现出一定的泛化能力,但在更复杂的任务中,GR00T、π₀-FAST和OpenVLA等策略常常遇到抓取失败等问题。

相比之下,Hume利用动作价值引导的慢思考机制使得模型有效地从失败中恢复,在各种复杂场景中展示了卓越的性能,达到了91%的平均成功率。在Franka机械臂和人型机器人AgiBot G-1上,Hume在涉及日常长期任务、可变形物体操作等复杂场景中同样表现出色。特别是在AgiBot的折叠短裤这一任务中,Hume达到88%的成功率,比π₀高出15%。这些结果表明,Hume在真实环境中具有强大的适应性和操作精度,能够有效处理真实世界中复杂的机器人控制任务。

3. 系统1系统2协同框架的消融分析

双系统级联去噪的精细控制:团队通过严格的消融实验验证了双系统级联去噪在实现精确机器人控制中的关键作用。该机制允许系统1根据高频观察输入消除残余噪声,实现动作的精确执行。实验结果显示,当移除级联去噪机制时,模型性能在SimplerEnv基准上平均下降3.2%,在LIBERO基准上下降2.7%,在真实机器人任务中显著下降19%。更严峻的是,直接采用系统2输出的最高价值候选动作而不经系统1二次精细化的模型表现更为糟糕,在仿真环境中分别下降9.8%和8.8%,在真实机器人场景中甚至下降高达63%。这一结果有力证明了系统1在执行阶段对动作进行精细调整的不可或缺性。

动作价值引导的慢思维决策:动作价值引导的慢思考作为Hume的核心设计理念,在消融实验中展现出决定性作用。此机制使系统2能够通过多候选动作采样和动作价值估计,在复杂动态环境中做出最优决策。实验表明,去除动作价值引导的慢思考机制会导致模型在SimplerEnv和LIBERO基准上分别下降14.95%和13.7%,而在复杂多变的真实环境中,性能更是断崖式下降78%。这种极端退化源于随机候选选择无法应对复杂场景的不确定性。同样,限制系统2仅生成单一候选动作的模型也表现出了显著性能下降,分别在三种测试环境中下降6.2%、4.8%和37%。这组实验结果清晰揭示了多候选动作采样与动作价值估计相结合的慢思考机制在复杂任务中的核心价值,以及系统1与系统2协同工作框架的必要性与有效性。

项目主页:https://hume-vla.github.io

开源代码:https://github.com/hume-vla/hume

论文地址:https://arxiv.org/abs/2505.21432

一键三连「点赞」「转发」「小心心」

欢迎在评论区留下你的想法!

— 完 —

🌟 点亮星标 🌟

(文:量子位)