传统的大型模型往往需要高昂的计算资源和复杂的部署环境,限制了其在端侧设备上的应用。面壁智能推出的MiniCPM 4.0 端侧大模型,以其极致高效的性能和灵活的部署能力,为这一问题提供了全新的解决方案。

一、项目概述

MiniCPM 4.0 是面壁智能推出的一款极致高效的端侧大模型,旨在为端侧设备提供高性能、低资源消耗的语言模型解决方案。该模型分为 8B 和 0.5B 两种参数规模,其中 8B 版本采用创新的稀疏架构,能够高效处理长文本任务,而 0.5B 版本则以低计算资源消耗和高性能著称。MiniCPM 4.0 通过自研的 CPM.cu 推理框架,实现了在极限场景下最高 220 倍的提速,常规场景下也能达到 5 倍的速度提升。此外,该模型支持在 vLLM、SGLang、LlamaFactory 等开源框架上部署,并已适配 Intel、高通、MTK、华为昇腾等主流芯片,具备广泛的适用性。

二、技术原理

(一)稀疏注意力机制

MiniCPM 4.0-8B 采用创新的可训练稀疏注意力机制(InfLLM v2),在处理长文本时,每个词元仅需与不到 5% 的其他词元进行相关性计算,极大地降低了长文本处理的计算开销。这种稀疏注意力机制不仅提高了计算效率,还保持了模型的精度。

(二)高效双频换挡机制

MiniCPM 4.0 能够根据任务特征自动切换注意力模式。在处理长文本时启用稀疏注意力以降低计算复杂度,而在处理短文本时切换至稠密注意力以确保精度。这种机制使得模型在不同任务场景下都能发挥最佳性能。

(三)极致量化技术

BitCPM 是 MiniCPM 4.0 的量化版本,通过将模型参数压缩为三进制值,实现了 90% 的位宽减少,同时保持了卓越的性能。这种量化技术不仅减少了模型的存储需求,还进一步提升了推理速度。

(四)高效训练工程

MiniCPM 4.0 采用了 FP8 低精度计算技术,结合多词元预测(Multi-token Prediction)训练策略,进一步提升了训练效率。此外,模型风洞 2.0 技术通过引入下游任务的 Scaling 预测方法,能够更精准地搜索并确定最佳的模型训练配置。

三、主要功能

(一)高效推理速度提升

MiniCPM 4.0 通过自研的 CPM.cu 推理框架,在极限场景下实现了最高 220 倍的提速,常规场景下也能达到 5 倍的速度提升。这种速度提升使得模型在端侧设备上能够快速响应用户请求,极大地改善了用户体验。

(二)模型瘦身与高效部署

MiniCPM 4.0 采用创新的稀疏架构和极致低位宽量化技术,实现了模型体积缩小 90%,同时保持了卓越的性能。支持在 vLLM、SGLang、LlamaFactory 等开源框架上部署,适配多种主流芯片,可在多种端侧设备上流畅运行。

(三)多平台适配

MiniCPM 4.0 已适配 Intel、高通、MTK、华为昇腾等主流芯片,能够在多种端侧设备上高效运行。这种多平台适配能力使得模型能够广泛应用于不同的硬件环境,满足多样化的应用场景需求。

(四)多种版本选择

MiniCPM 4.0 提供 8B 和 0.5B 两种参数规模的版本,满足不同场景的需求。8B 版本适用于需要处理复杂长文本的任务,而 0.5B 版本则适合资源受限的设备,能够在低计算资源下实现高性能。

四、评测结果

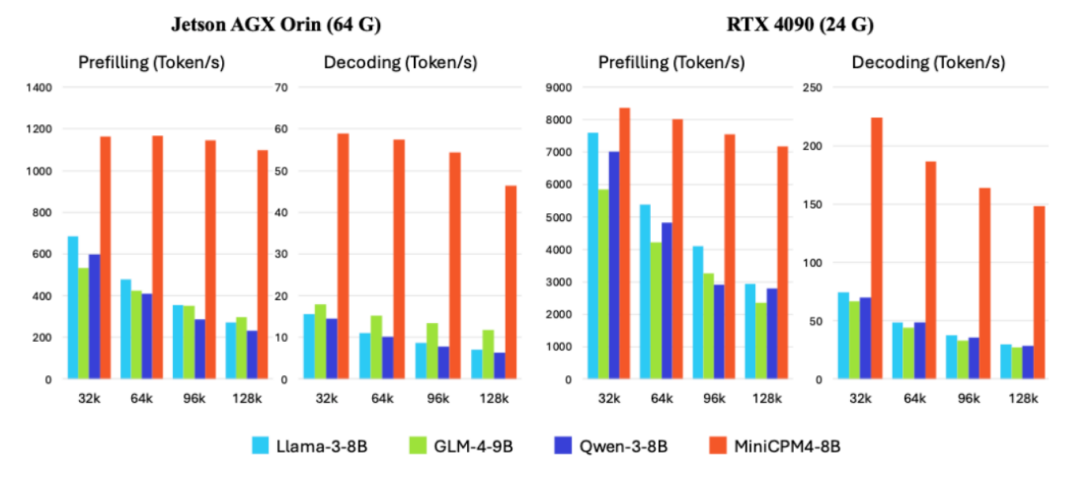

(一)效率评测

在Jetson AGX Orin 和 RTX 4090 两款典型端侧芯片上,MiniCPM 4.0 在长文本处理任务中展现出大幅领先同尺寸模型的处理速度。随着文本长度的增加,MiniCPM 4.0 的性能优势愈发显著。在 Jetson AGX Orin 平台上,相较于 Qwen3-8B,MiniCPM 4.0 实现了约 7 倍的生成速度提升。

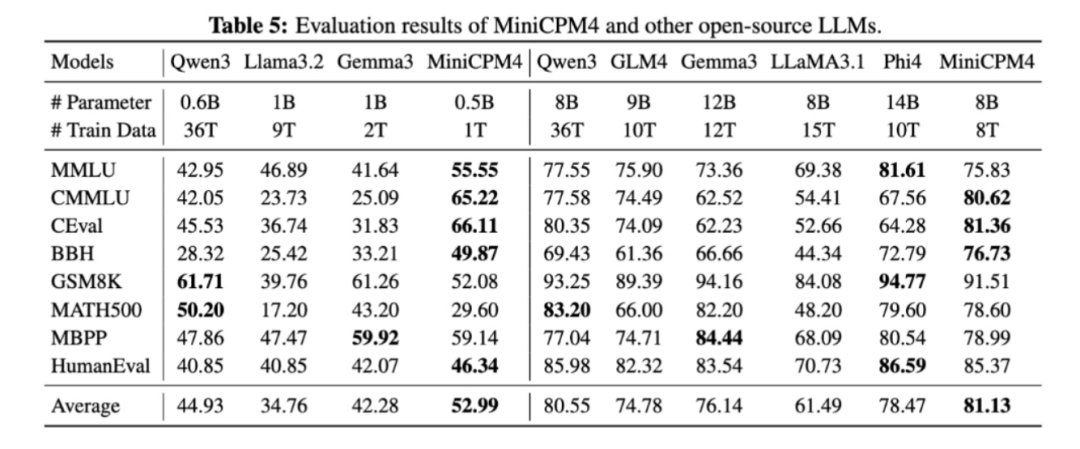

(二)综合评测

MiniCPM 4.0 推出端侧 8B、0.5B 两种参数规模版本,均在同级别模型中实现了最佳性能表现。在多种评测任务中,MiniCPM 4.0 的表现优于或接近其他同参数量级别的模型。

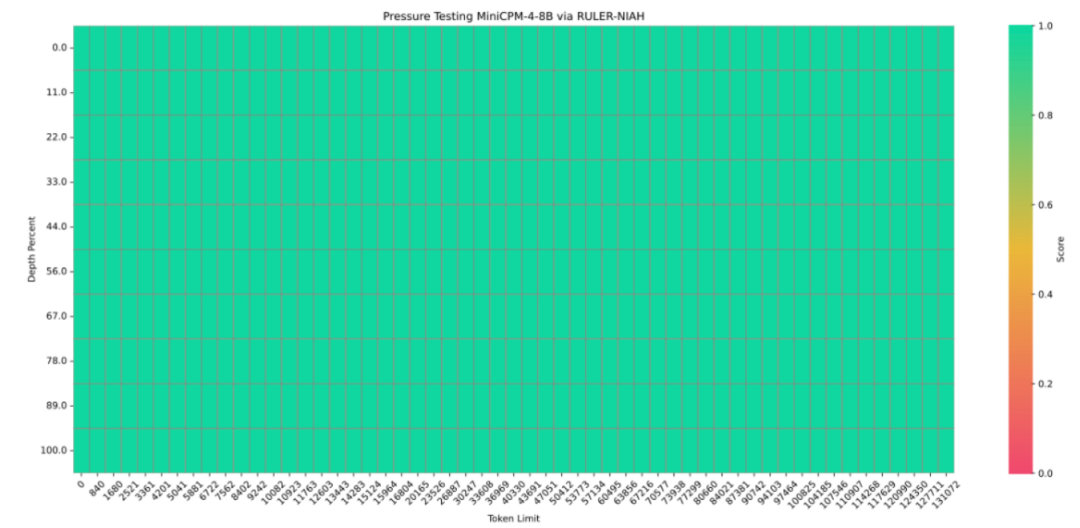

(三)长文本评测

MiniCPM 4.0 基于 32K 长文本进行预训练,并通过 YaRN 技术实现长度扩展。在 128K 长文本的大海捞针任务中,MiniCPM 4.0 展现出卓越的性能表现,能够高效处理超长文本内容。

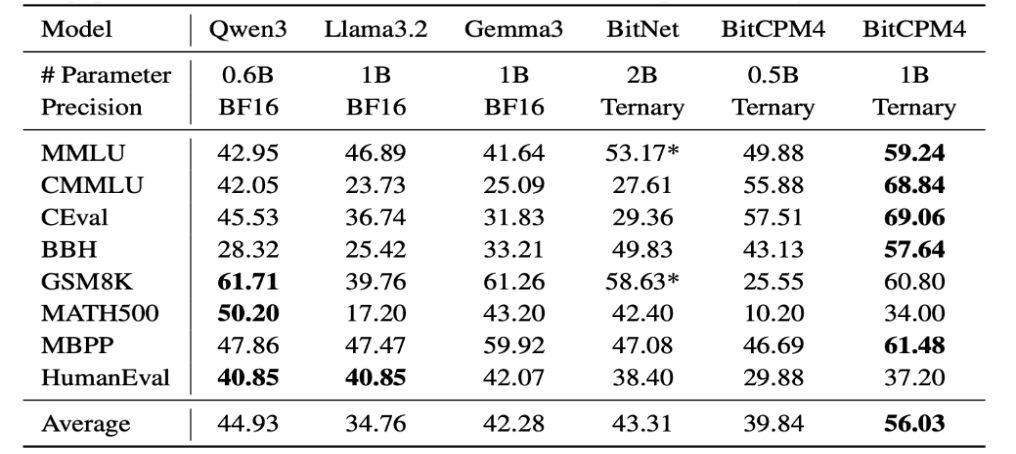

(四)量化版本评测

BitCPM4 是基于 MiniCPM 系列模型进行量化感知训练(QAT)后得到的三值量化模型。在训练效率和模型参数效率方面实现了有效的提升,模型使用 1.58Bit 的位宽达到的性能对标与同参数量级别的全精度模型,模型参数效率高。

五、应用场景

(一)智能辅导系统

MiniCPM 4.0 可以作为智能辅导系统的核心,通过自然语言处理技术理解学生的问题并提供详细的解答和解释,帮助学生更好地理解和掌握知识。

(二)病例分析与诊断辅助

MiniCPM 4.0 可以辅助医生进行病例分析,通过自然语言处理技术理解病历内容,为医生提供诊断建议和参考信息,提高诊断的准确性和效率。

(三)医学文献检索

MiniCPM 4.0 能够帮助医生和研究人员快速检索相关的医学文献和研究成果,提供精准的文献推荐和摘要,节省时间和精力。

(四)智能客服

MiniCPM 4.0 可以作为金融客服的核心,快速准确地回答客户的咨询问题,提供个性化的服务和解决方案,提高客户满意度。

(五)游戏剧情生成

MiniCPM 4.0 可以根据游戏设定和玩家行为,自动生成丰富多样的游戏剧情和任务,增加游戏的趣味性和可玩性。

六、快速使用

(一)环境准备

1. 确保安装了 Python 3.8 及以上版本。

2. 安装必要的依赖库,如 `transformers` 和 `torch`。

pip install transformerspip install torchpip install modelscope

(二)模型下载

从HuggingFace 或 ModelScope 下载 MiniCPM 4.0 模型文件:

modelscope download --model OpenBMB/MiniCPM4-8B README.md --local_dir ./dir(三)transformers 推理示例

以下是一个使用HuggingFace 推理 MiniCPM 4.0 的示例代码:

from transformers import AutoModelForCausalLM, AutoTokenizerimport torchtorch.manual_seed(0)path = 'openbmb/MiniCPM4-8B'device = "cuda"tokenizer = AutoTokenizer.from_pretrained(path)model = AutoModelForCausalLM.from_pretrained(path, torch_dtype=torch.bfloat16, device_map=device, trust_remote_code=True)# User can directly use the chat interface# responds, history = model.chat(tokenizer, "Write an article about Artificial Intelligence.", temperature=0.7, top_p=0.7)# print(responds)# User can also use the generate interfacemessages = [{"role": "user", "content": "Write an article about Artificial Intelligence."},]prompt_text = tokenizer.apply_chat_template(messages,tokenize=False,add_generation_prompt=True,)model_inputs = tokenizer([prompt_text], return_tensors="pt").to(device)model_outputs = model.generate(**model_inputs,max_new_tokens=1024,top_p=0.7,temperature=0.7)output_token_ids = [model_outputs[i][len(model_inputs[i]):] for i in range(len(model_inputs['input_ids']))]responses = tokenizer.batch_decode(output_token_ids, skip_special_tokens=True)[0]print(responses)

(四)CPM.cu推理

我们推荐使用CPM.cu 对 MiniCPM4 模型进行推理。CPM.cu 是面壁开发的一个集合了高效稀疏、投机采样、量化等技术的 CUDA 推理框架,能够完全发挥 MiniCPM4 的效率优势。

你可以通过以下脚本安装CPM.cu 并进行推理:

git clone https://github.com/OpenBMB/CPM.cu.git --recursivecd CPM.cupython3 setup.py install

你可以通过以下命令进行推理并查看模型的运行速度。

python3 tests/long_prompt_gen.py # 生成 prompt.txtpython3 tests/test_generate.py --prompt-file prompt.txt

更多关于CPM.cu 的细节,请参考 CPM.cu 仓库(https://github.com/OpenBMB/CPM.cu)。

七、结语

MiniCPM 4.0 作为面壁智能推出的一款极致高效的端侧大模型,凭借其创新的技术原理、卓越的性能表现和广泛的应用场景,为端侧设备的语言模型应用提供了一个极具吸引力的解决方案。通过本文的介绍,相信大家对 MiniCPM 4.0 有了全面的了解。感兴趣的读者可以进一步探索其在实际项目中的应用,以充分发挥其潜力。

八、项目资料

GitHub 仓库:https://github.com/OpenBMB/MiniCPM

HuggingFace 模型库:https://huggingface.co/collections/openbmb/minicpm4

ModelScope 模型文件:https://www.modelscope.cn/models/OpenBMB/MiniCPM4-8B

💘

(文:小兵的AI视界)