「新锐论前沿」第四期线上分享活动邀请到了普渡大学三年级博士生徐政通。

由具身触觉主办、HyperAI超神经协办的「新锐论前沿」第四期线上分享活动,将于 12 月 18 日(周三)20:30 正式上线。本次活动邀请到了普渡大学三年级博士生徐政通,他将围绕「面向机器人学习的数据高效触觉表征」带来技术分享。

扫描下方二维码即可报名参与线上分享!

🎁 本次活动还设立了抽奖环节,参与线上分享的小伙伴有机会获得由 OpenBayes贝式计算赞助的算力福利——60 小时 NVIDIA RTX 4090 算力资源使用市场(资源有效期 1 个月),价值 160 元。

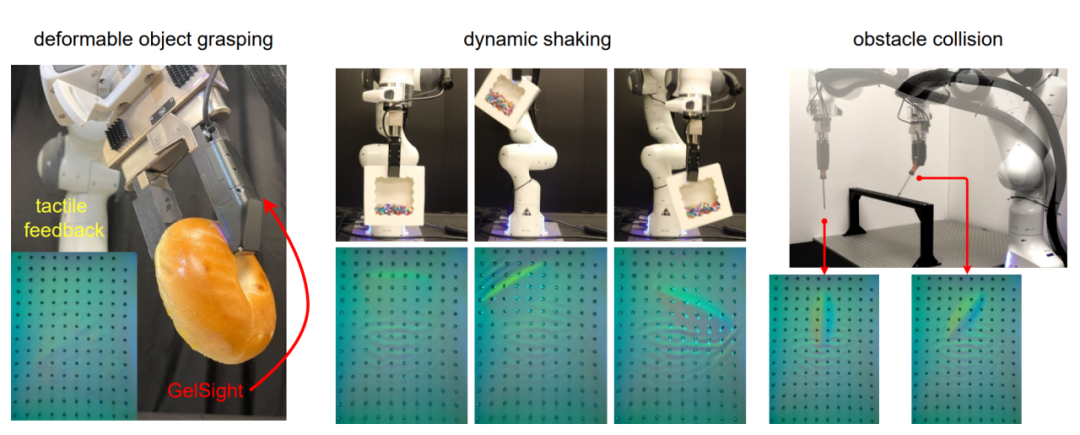

在本次讲座中,徐政通博士将介绍把 GelSight 应用于端到端机器人学习中的两项研究工作,重点探讨如何通过简单物体集的少量样本学习到可泛化的触觉表征,并将其应用于感知、控制和策略学习等下游任务。

嘉宾介绍

徐政通

普渡大学

博士生

徐政通是普渡大学三年级博士生,导师为佘宇教授,研究方向为机器人学习与触觉感知。在加入普渡大学之前,他于华中科技大学机械科学与工程学院获得学士学位,并在本科期间获得国家奖学金。博士阶段,他曾获普渡大学 Dr. Theodore J. and Isabel M. Williams fellowship。

个人主页:

https://zhengtongxu.github.io/website/

分享内容简介

基于 GelSight 的触觉图像与传统相机获取的视觉图像存在显著差异。触觉图像具有其独特的特点,例如,它主要展示接触物体的几何特征和接触信息,而不会存在前景与背景的概念。此外,由于其基于 RGB 三色光散射的成像原理,其颜色分布相较于视觉图像更加紧凑。我们认为,触觉图像的这些特性为数据高效的触觉表征学习提供了可能,从而显著降低了触觉在端到端机器人学习中对繁琐数据采集过程的依赖。

本次报告将介绍我们在将 GelSight 应用于端到端机器人学习中的两项研究工作,重点探讨如何通过简单物体集的少量样本学习到可泛化的触觉表征,并将其应用于感知、控制和策略学习等下游任务。

在第一项研究 LeTac-MPC 中,我们将展示如何从传统控制方法出发并受到启发,通过学习物理驱动的触觉表征,并设计可微分的模型预测控制器,从而实现能够泛化到广泛日常物体的响应式抓取。

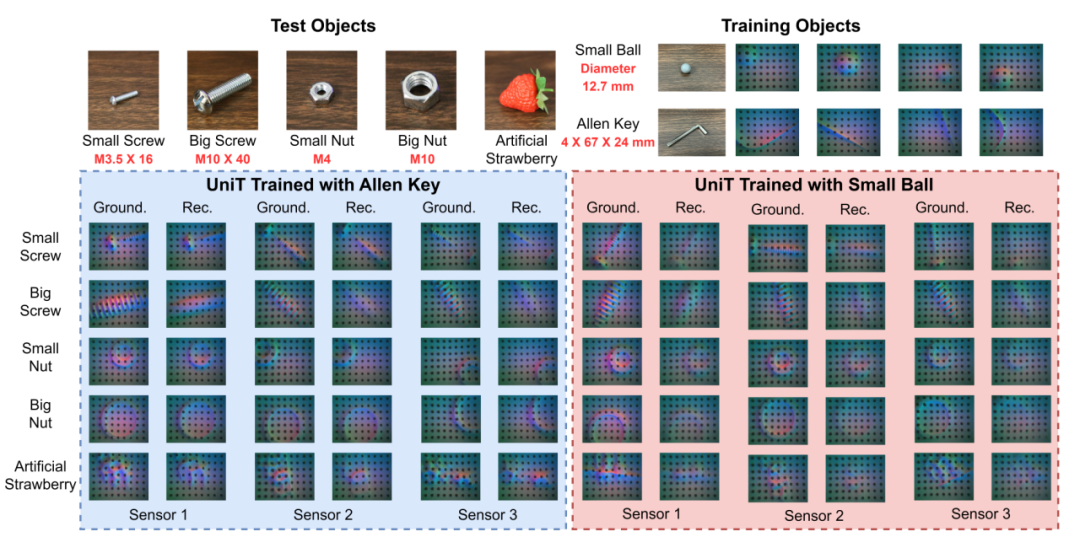

在第二项研究 UniT 中,我们将探讨如何通过少量单一物体的数据学习出能够泛化至广泛未见物体的触觉表征,以及如何利用这种数据高效的触觉表征来促进下游任务中的感知与策略学习。

戳“阅读原文”,免费获取海量数据集资源!

(文:HyperAI超神经)