前几天,朋友跟我报了个猛料:

而另一位朋友,则带来了更为准确的消息:M2 Ultra 版本的 Mac Studio,已原生适配阶跃星辰模型全家桶,这应该是第一个全面适配苹果 Mac 设备的中国大模型厂商。

这事儿,在线下也看到了实物:上周五的阶跃星辰生态开放日中,我在一个罕有人注意的角落,体验上了这套端侧模型:一台 Mac 上,跑着阶跃的图像、音乐生成的端侧模型。

这似乎表明,面对中国市场特有的数据合规要求,苹果正探索端侧 AI 的本地化路径。而阶跃星辰的技术方案,已具备在苹果的 Mac 设备中,实现全栈 AI 功能的技术适配能力。

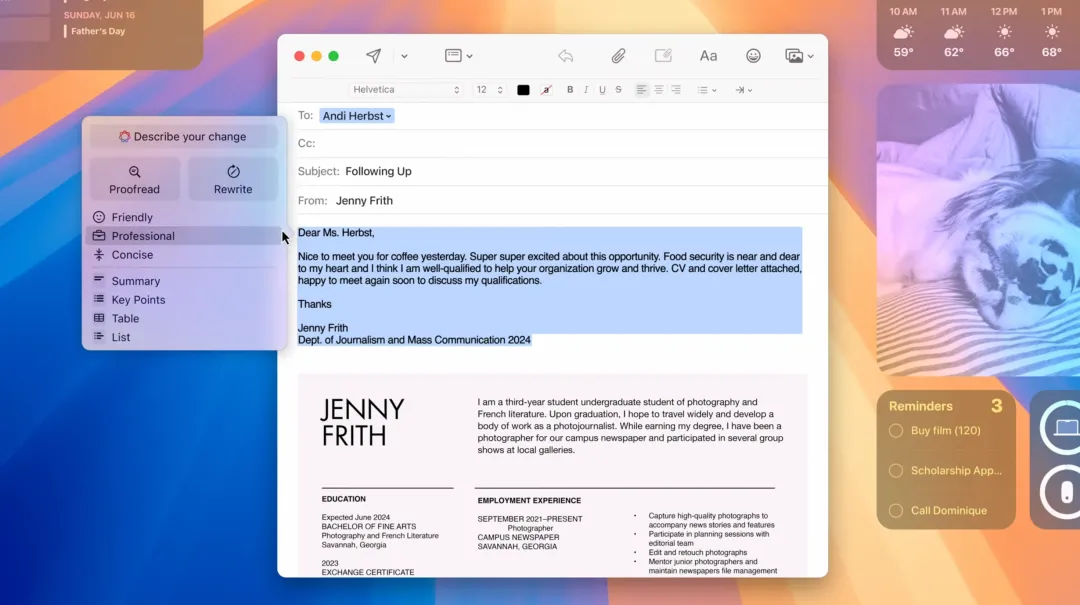

与 Google、Meta 等科技巨头在 AI 领域的 “高调炫技” 不同,苹果在 AI 叙事上始终保持着异乎寻常的克制:它从未公开标榜自研大模型,亦未正式宣布与任何 AI 厂商的深度合作。即便是近期备受瞩目的 “Apple Intelligence”,宣传口径上也只是 AI 能力在日常生活中的渗透,而非声势浩大的技术革命。

这种克制,在与 OpenAI 的合作传闻中可见一斑。OpenAI 方面高调宣称参与了 “Apple Intelligence”,用户将能在苹果设备上更便捷地唤起 ChatGPT。然而,苹果在发布会上,对 OpenAI 却只字未提,个中意味引人深思。

在中国市场,苹果面临的挑战更为特殊。严苛的法规与复杂的网络环境,使得 ChatGPT、Claude 等海外 AI 服务难以合规接入。面对巨大的市场需求和本土 AI 服务空白,苹果亟需可靠的国内伙伴,一起提供服务。

据 The Information 消息:苹果会与阿里一起,共同为中国的 iPhone 用户,提供 AI 服务。这一信息,也得到了蔡崇信的证实。

但 Mac 端在中国本土市场的合作方还虚位以待。

再回头看看开始的爆料:苹果的 Mac Studio 已原生适配了阶跃星辰模型全家桶——这在业内是独一份的,此前未有模型厂商完成过如此多模态的模型在 Mac 端侧适配。可以推测:阶跃或将是首个和 Mac 合作的中国模型厂商。

苹果对用户隐私与本地数据保护的执着,几乎已成为其品牌基因。其核心逻辑在于:个人或企业数据应尽可能存储于本地设备,常用 AI 功能应基于端侧实时推理或轻量化训练完成,而非将数据上传至云端 GPU 集群。这种 “数据不出终端” 的理念,与当前全球范围内对数据安全的日益重视不谋而合。

海外已有分析指出,苹果与 OpenAI 的合作,或仅限于处理高复杂度任务场景下的云端模型调用。在日常应用场景中,苹果更倾向于依赖自研的 Apple Intelligence 或其他本地组件完成 AI 计算。对于中国用户和企业而言,由于 ChatGPT 等海外服务的不可用性,对本地化 AI 解决方案的需求更为迫切。这使得兼具技术实力与本土优势的阶跃星辰,进入苹果的视野几乎成为必然。

我实际上手体验了「搭载了阶跃全家桶的 Mac Studio」,印象深刻:多模态理解、文生图、离线音乐生成等功能均流畅自如。用户只需输入文本指令或上传图像文件,即可与模型进行互动处理;只需简单描述中文需求,即可生成高质量图像;甚至可以离线创作旋律与节奏伴奏。所有生成过程均在本地完成,无需联网,也未访问任何外部云服务。

Mac 上的「阶跃星辰工程版」模型演示:文生图

这无疑对高度重视数据闭环与隐私保护的用户,尤其是企业级用户,构成了巨大的吸引力。端侧 AI 对苹果而言,或许是其全球 AI 战略的 “Plan B” 或 “保留选项”,但在中国市场,考虑到政策法规、数据安全以及用户习惯等因素,端侧 AI 几乎已成为苹果的 “最优解” 甚至是 “刚需”。

毕竟:但真正生意场上,国内老板更倾向于「买一个自己的」。

Mac 上的「阶跃星辰工程版」模型演示:音乐生成

我相信很多人会对 “Mac 本地化大模型” 的前景,并未抱持过高的期待:毕竟算力就那么点。

但你要知道,在很多行业中,比如政务、医疗、金融等关键行业对数据安全与合规有着极为严苛的要求,核心数据 “上云” 面临重重阻碍。Mac Studio 若能成功转型为 “离线大模型工作站”,无疑将为这些行业用户,提供一条 “低门槛、高安全、易部署” 的 AI 落地路径。

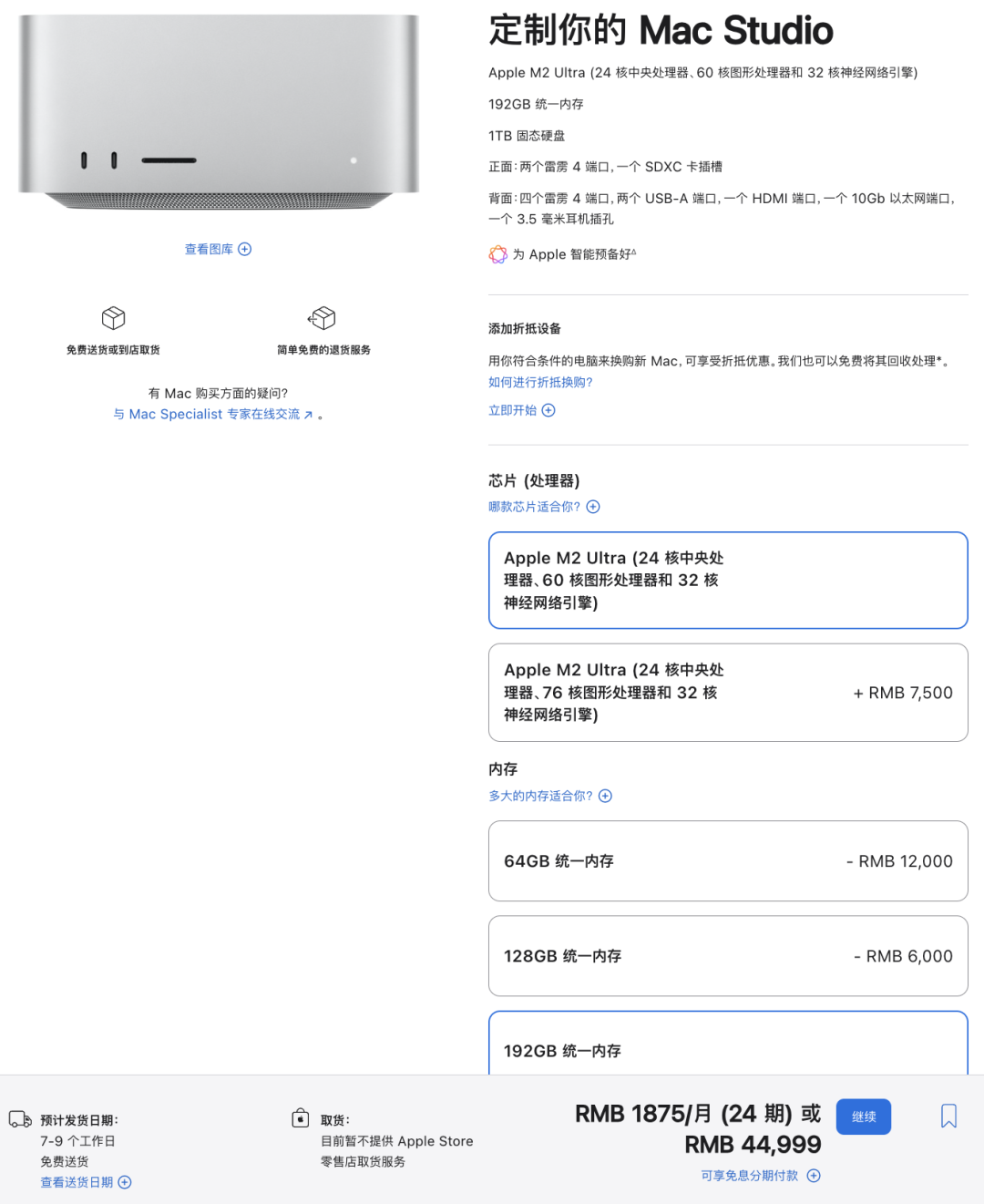

这里我还得说个反直觉的事:Mac 设备作为算力方案,性价比非常优秀。

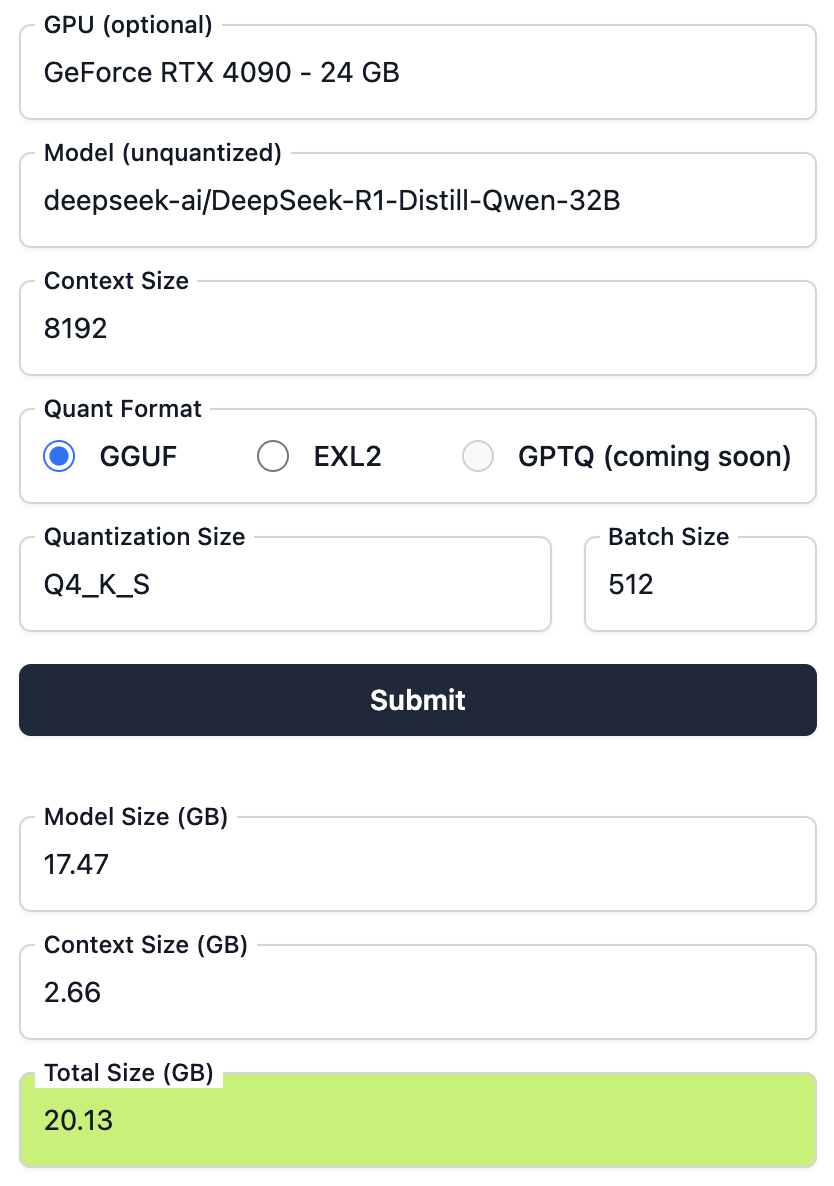

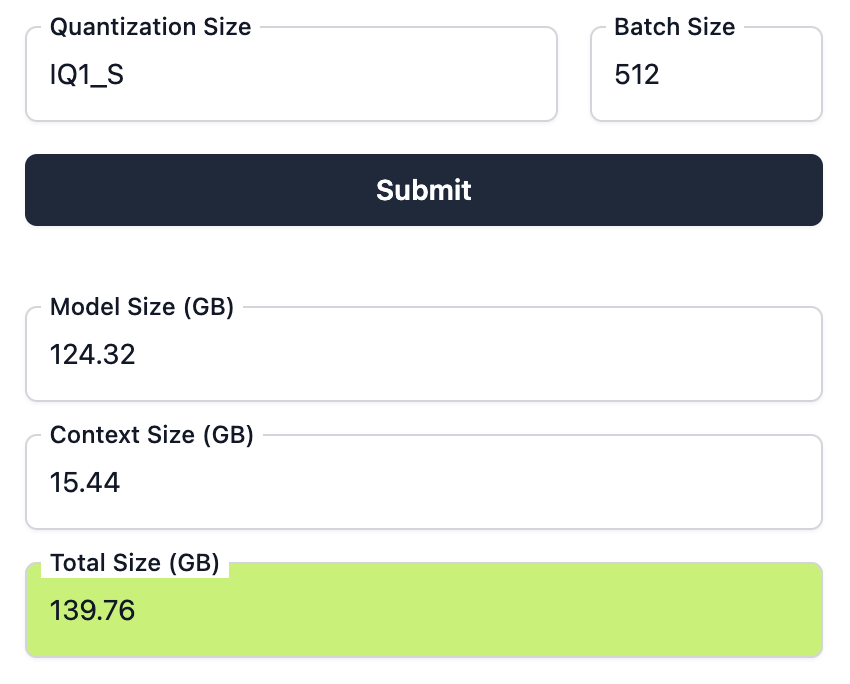

这里补充一个小的信息:跑模型的时候,能不能跑,由显卡内存决定。但具体需要多少显存,可以在 Hugging Face 上搜一下 LLM Model VRAM Calculator,一键计算。

比如…如果我想跑一个 DeepSeek R1,32B 蒸馏版,8k 上下文&int4,大概需要 20G 的显存:自己玩的话,一张 4090 就够了,大概 2 万块。

但如果模型大一点,比如是 671B 的 DeepSeek,其他保持不变,并且需要对外提供服务的话,就需要用专业卡组个柜子,大概需要 5 张 A100(一点都不整数),成本大概 50 万人民币

而 M 芯片的 Mac,有一个很妖的特点:CPU & GPU 共用一个高速显存,单个机器最高 192 G。换句话说:用两台 Mac,就可以跑满血 DeepSeek R1 671B 的模型了。每台4万5,总计9万。

当然了…如果你比较狠,多上一点量化,比如像这样,单台 Mac 就能跑

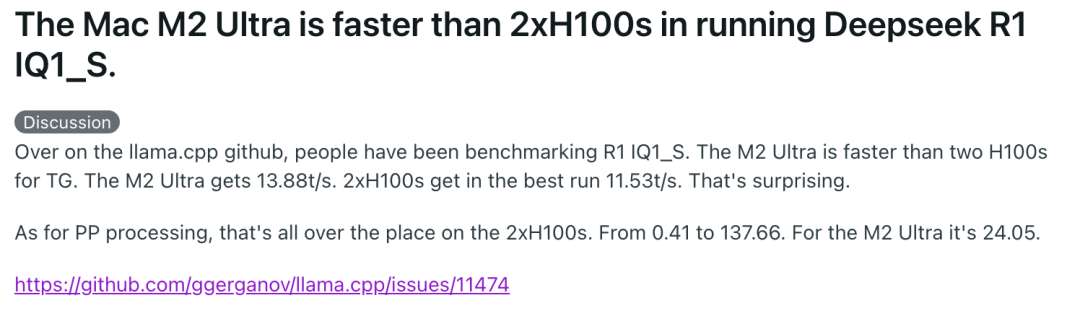

实测结果是…比 2*H100s 还快…

所以啊,如果一定需要「私有化部署一个模型」,你会有以下方案:

-

云租 GPU 的话,每个月几千块 -

弄个物理的 8 卡柜子,大概几十万 -

整个 Mac,随便丢哪,总成本 5 万不到

很显然… Mac 极具性价比

说回本次的主角「阶跃星辰」,也是「AI 六小虎」之一,之前有详细的报道:六虎中的「多模态狂魔」:阶跃星辰|江湖录

「阶跃星辰」的能力非常全面:在文字、图像、视频、语音、音乐等多模态表现出色,亦在公开评测中多次名列前茅。

更值得称道的是,阶跃星辰对开源和技术社区共建的重视。在上周的生态开放日上,阶跃星辰展示了一系列面向汽车、IoT 设备、手机等嵌入式场景的 Agent 方案,旨在推动大模型在更广泛的终端设备上运行,大幅降低对云端算力的依赖。这与苹果的端侧 AI 战略高度契合。

当然了,也要知道,端侧 AI 并非要完全取代云端 AI,而是将数据存储与实时推理 尽可能留在终端侧,最大限度降低隐私风险,仅将极少数高算力需求任务转移至云端,最终形成 “端云协同” 的 AI 使用模式:来满足中国市场中那些不愿或不便上云的企业用户的迫切需求。

苹果向来对合作细节讳莫如深,但这次的 Mac 适配,或反映出其的 AI 策略调整。阶跃星辰模型的本地化多模态部署,既验证了国产大模型的工程适配能力,也是中国企业对隐私优先的独特洞察。

技术浪潮奔涌向前,端云协同正在重塑全球产业格局。那些在终端侧实现技术突破的实践者,不仅为行业树立了新标杆,更让我们看到——在智能化转型的赛道上,中国方案正在赢得主动权。

(文:赛博禅心)