日期: 2025 年 2 月 3 日

电子书《统计计算》,北京大学统计科学中心李东风老师的作品

统计学是一门研究数据搜集、整理和分析的学科,并涉及编程实现相关算法。本书涵盖传统统计计算概念与算法,如误差分析、矩阵计算等,以及现代计算机技术在统计推断中的应用方法,如自助法、MCMC方法等。

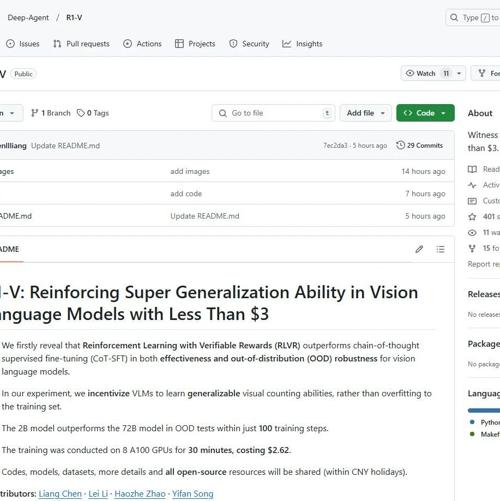

R1-V项目:将DeepSeek R1的训练方法用在视觉语言模型上

R1-V项目展示了DeepSeek RRP在视觉语言模型上的效果,仅需30分钟和不到3美元的训练成本,在100个步骤内超越了72B模型的OOD测试表现。

Deep Research的开源实现版:node-DeepResearch

Jina AI发布Node.js版DeepResearch实现,使用Gemini、Brave和Jina Reader进行搜索、阅读和推理。

华为突围:910C芯片性能达H100的60%!DeepSeek 已验证

华为Ascend 910C芯片性能达到NVIDIA H100的60%,展示了中国在AI芯片制造上的实力。尽管面临重重限制,华为仍能突破重围,预示着未来AI芯片格局或将发生重大变化。