研究方向 | 多模态大语言模型

主页地址:

代码地址:

数据集地址:

大语言模型(LLMs)中链式思维(Chain-of-Thought, CoT)的出现展示了超强的推理能力,这一点在最近的 OpenAI o1 和 DeepSeek-R1 中都得到了充分体现。然而,这一能力能多大程度地帮助视觉推理,并且我们又应该如何细粒度地评估视觉推理呢?

为此,来自港中文 MMLab 的研究者们提出了 MME-CoT。这是一个全面且专门用于评估 LMMs 中视觉推理能力的 Benchmark,包括了数学、科学、OCR、逻辑、时空和通用场景。

MME-CoT 与之前的 LMM 的 Benchmark 最大的区别在于,提出了一个严格且多方面的评估框架,细粒度地研究视觉 CoT 的不同方面,评估其推理的质量、鲁棒性和效率。

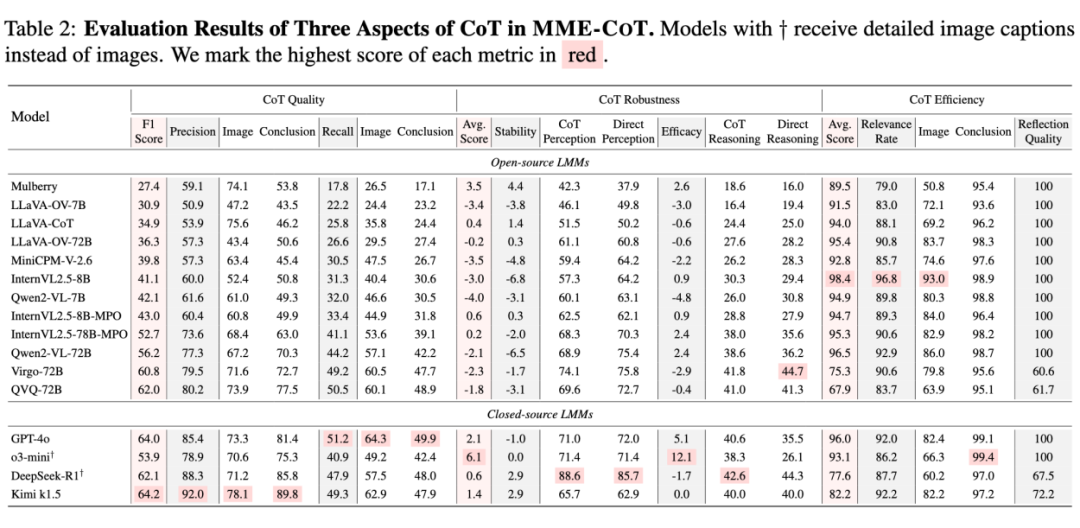

各种最新推出的 LMM,包括 Kimi k1.5,GPT-4o,QVQ 等等都在 MME-CoT 上进行了测试。同时,研究者们还把图片转成 caption 之后测试了最近爆火的 DeepSeek-R1 以及 o3-mini。

根据实验结果,文章中得到了如下有价值的结论:

1. CoT质量:Kimi k1.5 > DeepSeek-R1 >> o3-mini

CoT鲁棒性:o3-mini > Kimi k1.5 > DeepSeek-R1

CoT效率:o3-mini > Kimi k1.5 > DeepSeek-R1

值得一提的是,DeepSeek-R1 的文本推理能力非常出众。仅仅使用图片的 caption 就可以在 precision 上超过真实看到图片的 GPT-4o。最后的 CoT 质量也与 GPT-4o 仅有 1.9% 之差。

2. 其次,反思能力的引入显著提升了 CoT 质量,所有具备反思能力的 LMM 都实现了较高的 CoT 质量表现。例如 QVQ 达到了 62.0% 的 F1 分数,大幅超过 Qwen2-VL-72B 6.8%。而 Kimi k1.5 更是超越 GPT-4o 达到最佳质量。

3. 在鲁棒性方面,我们发现大多数早期模型在感知任务中都受到 CoT 的负面影响,表现出有害的过度思考行为,其中最显著的案例是 InternVL2.5-8B,在感知任务中应用 CoT 后性能下降了 6.8%,这严重制约了将 CoT 推理作为默认操作的可行性。

4. 最后,关于 CoT 效率,我们观察到输出长 CoT 的模型普遍存在步骤的相关性不足的问题。模型容易被图像内容分散注意力,过度关注图像而忽视了对题目的解答,尤其是在处理通用场景、时空和 OCR 任务时。实验结果显示,约 30% 到 40% 的反思步骤未能有效协助问题解答,这暴露出当前模型反思能力的重要缺陷。

测评指标设计与数据组成

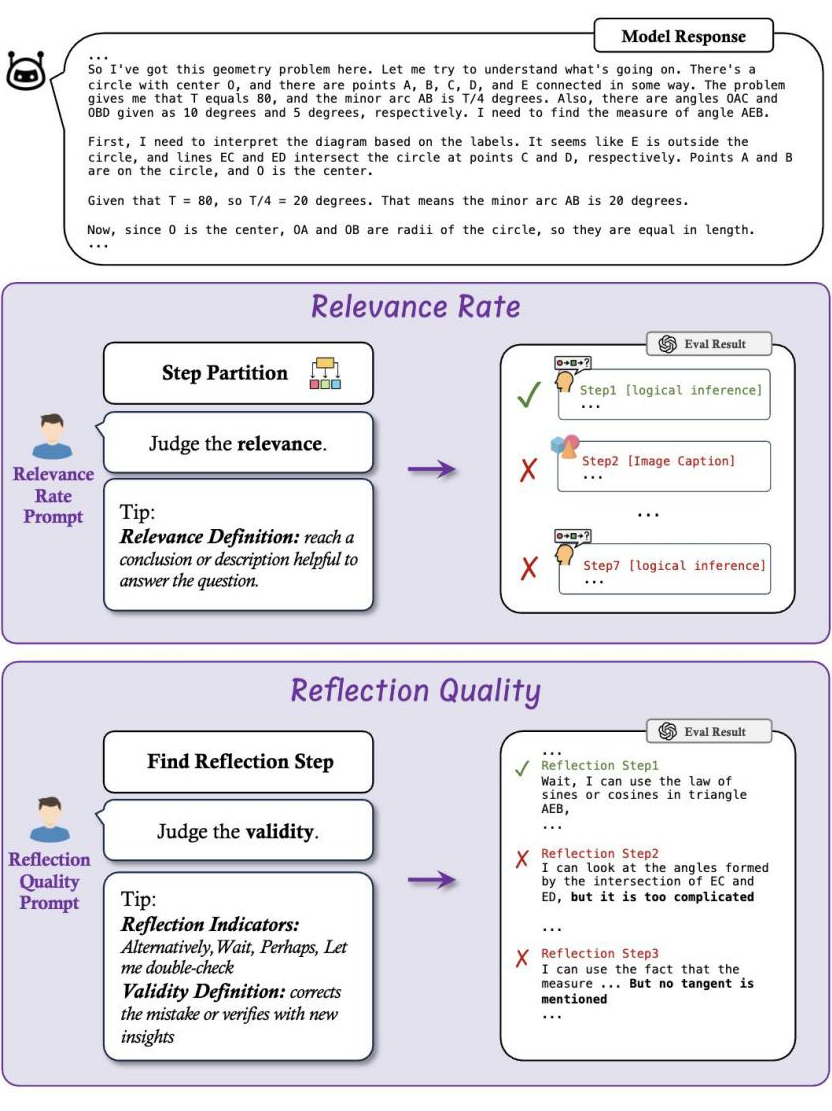

目前绝大多数的 LMM 的 Benchmark 都只评估最终答案的正确性,忽视了 LMM 整个的 CoT 的推理过程。为了能全面地了解视觉 CoT 的各个属性,研究者们提出了三个不同的评估方向,每个方向致力于回答一个关键的问题:

1. CoT 的质量:每个 CoT 步骤是否有用且准确,不存在幻觉?

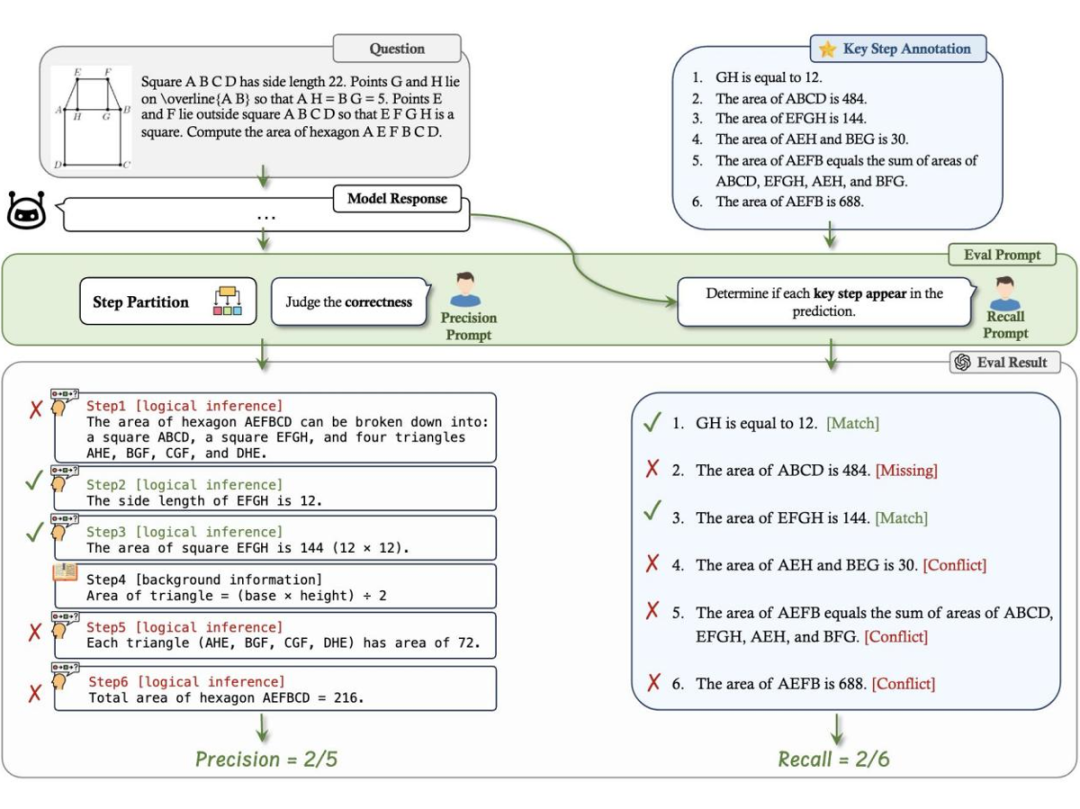

只评估回答的结果忽略了模型通过错误的逻辑或随机猜测得出正确答案的情况。这往往造成了模型推理能力被夸大的假象。为了深入研究推理过程,研究者们引入了两个可解释的指标来评估 CoT 的质量:

-

召回率(Recall):评估模型的回答有多少能与正确解题的必要步骤匹配。这个指标是用来量化推理的步骤是否能对于得到正确答案有帮助,以及推理链是否完整。匹配的过程由 GPT-4o 完成。

-

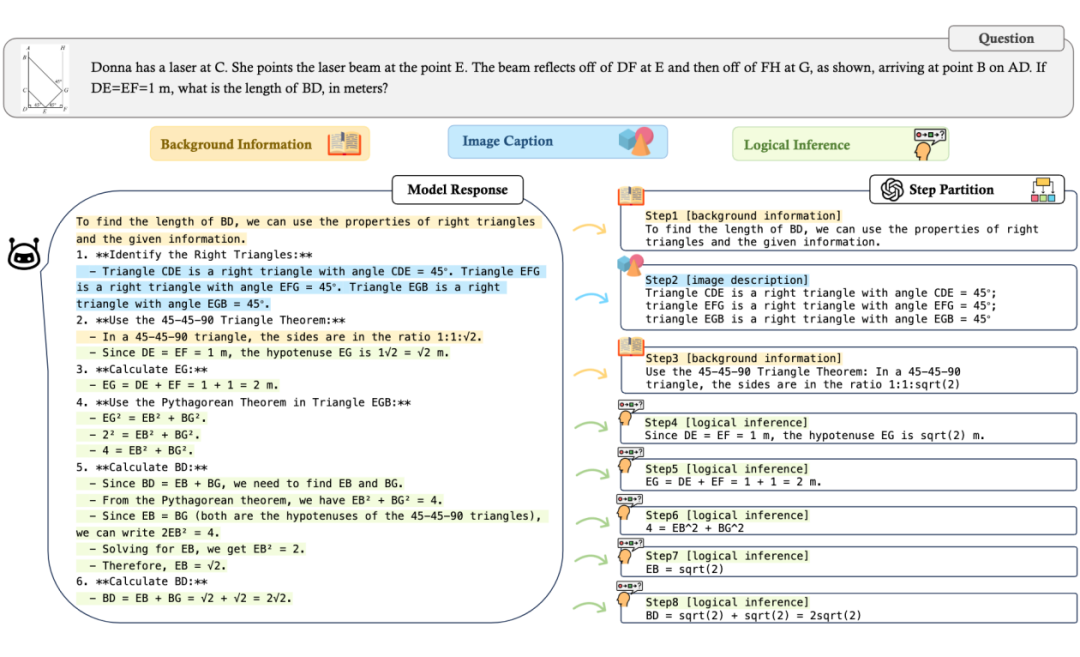

精确率(Precision):评估模型回答的每一步的准确程度来考查模型的幻觉以及逻辑的准确性。为了评估这一指标,研究者们首先使用 GPT-4o 将模型的回复切分成不同类型的步骤:背景知识、图片描述以及逻辑推理。然后继续对图片描述以及逻辑推理步骤判定每步是否正确。

2. CoT 的鲁棒性:CoT 是否干扰感知任务,它在多大程度上增强了推理任务?

-

稳定性(Stability):检查 CoT 是否对模型在感知任务上的表现产生负面影响

-

有效性(Efficacy):检查 CoT 是否真的帮助模型提高在复杂推理任务上的表现

3. CoT 的效率:使用 CoT 的推理效率是怎么样的?

-

相关比例(Relevance Rate):评估模型回答中与解决问题有关的比例。

-

反思质量(Reflection Quality):分析每个反思步骤是否更正了推理中的错误或者从新的角度验证了目前结论的正确性。

与纯文本推理问题不同,额外的视觉输入显著丰富了视觉推理问题的范围。有了图像输入,模型需要根据当前的推理进度频繁查看图像以获取相关信息。描述感兴趣的图像区域成为了思维链(CoT)过程中的关键部分。因此,除了需要严格逻辑的复杂问题外,通用场景中的许多问题也构成了具有挑战性的推理问题。

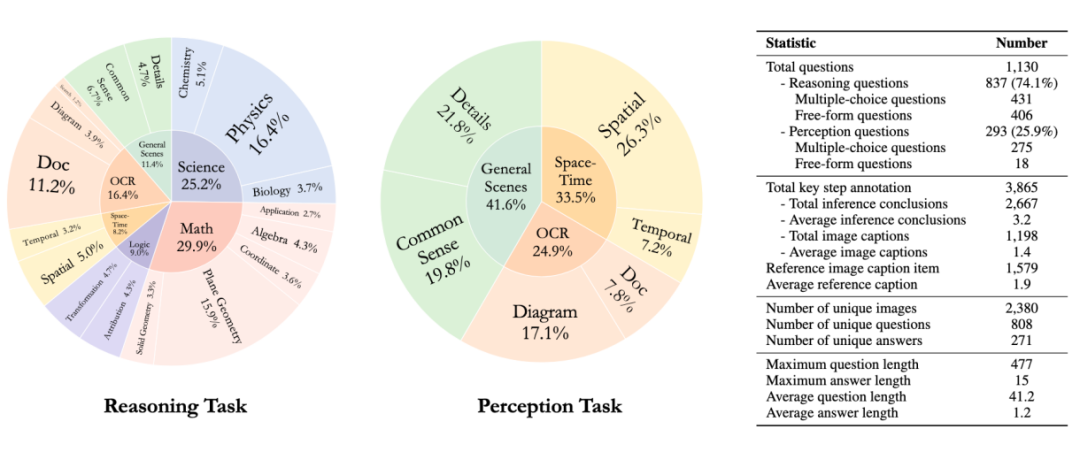

考虑到这一点,MME-CoT 测试集构建起了一个覆盖专业领域与常识场景的全景视觉推理评估体系,共包括 6 大领域以及 17 个子类。为了保持对推理过程的关注,研究者们排除了需要复杂领域特定定理或专业知识的问题。

MME-CoT 中分为感知任务以及推理任务,现有的 Benchmark 往往混淆这两类任务,使得这两类经常出现在相同类别中。为了解决这个问题,研究者们首先使用 GPT-4o 以及 Qwen2-VL 来进行预判,通过对比直接作答与 CoT 作答的表现差异,初步划分这两种不同类型的任务。接着,专业的标注团队逐题审核,确保分类的准确性。

为了便于 CoT 的评估,标注团队为所有推理问题都给出了必要的推理步骤的 Ground Truth 标注。对于多解的问题,标注者被要求给出了每种可能的解法。最后,MME-CoT 得到了 1130 道精选的问题以及 3865 个关键步骤标注。

实验分析与结论

研究者们在 MME-CoT Benchmark 上测评了 13 个现有的 LMM 以及 2 个最先进的具有超强推理能力的 LLM:DeepSeek-R1 以及 o3-mini。对于 LLM,研究者们将图片转化为详细的 caption 之后再输入到模型。

实验结果如下:

基于测评,还得到了如下的发现与结论:

尽管长思维链模型具有更高的精确率,但每个步骤的信息量并不能得到保证。我们观察到 GPT-4o、QVQ 和 Virgo 之间的召回率的趋势和它们最终能否正确解答推理任务的表现(即在使用 CoT 的 prompt 时,模型在推理任务的最终答案准确率,对应表格中的 CoT Reasoning 列)不一致。

具体来说,虽然 Virgo 和 QVQ 在仅评估最终答案的正确性上都优于 GPT-4o,但它们在召回率上落后。这表明长 CoT 模型有时会在跳过中间步骤的情况下得出正确答案,这与 CoT 本身奉行的 Think step by step 的原则相矛盾,值得进一步研究。

2. 更多参数使模型更好地掌握推理能力

我们发现参数量更大的模型往往获得更高的有效性 (Efficacy) 分数。这种模式在 LLaVA-OV、InternVL2.5-MPO 和 Qwen2-VL 中都很明显。例如,虽然 Qwen2-VL-7B 在将 CoT 应用于推理任务时显示出 4.8% 的性能下降,但其更大的对应模型 Qwen2-VL-72B 展示出 2.4% 的改进。

这种差异表明,在相同的训练范式下,具有更多参数的模型能够更好地掌握推理能力。

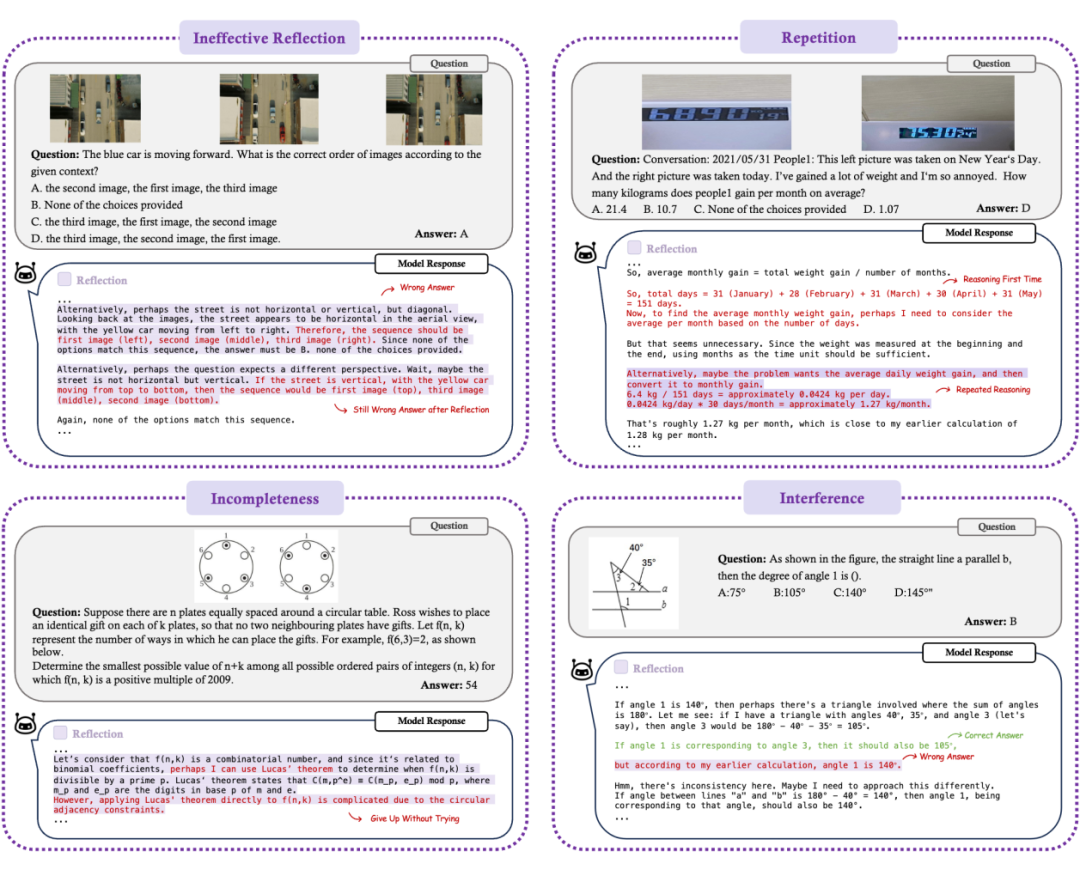

3. 模型的反思的错误涵盖多种类型

-

无效反思:模型得出错误结论,在反思时,继续做出错误的调整。这是最常见的错误类型,也是最频繁出现的。

-

不完整:模型提出新的分析方法但未执行它们,仅停留在初始想法阶段。模型的反思只是在空想。

-

重复:模型重述先前的内容或方法,没有引入新的见解。

-

干扰:模型最初达到正确结论,但反思却引入了错误。

理解和消除反思中的这些错误对于提高 LMM 的推理效率以及可靠性是至关重要的。

展望未来,MME-CoT 不仅为评估 LMM 的推理能力提供了系统化的基准,更为该领域的研究指明了关键发展方向。通过揭示现有模型在推理质量、鲁棒性和计算效率等方面的不足,这项工作为后续研究奠定了重要基础。这些发现将推动 LMM 实现更强大以及可靠的视觉推理能力。

(文:PaperWeekly)