在人工智能领域,大模型的发展一直是技术前沿的热点话题。2025 年 3 月 6 日,阿里巴巴 Qwen 团队正式开源了其最新研发的推理大模型 QwQ-32B,这无疑为全球开发者带来了一股强劲的创新动力。这款拥有 320 亿参数的模型,在数学推理、代码生成和逻辑分析等关键领域展现出了卓越的性能,迅速吸引了众多目光。令人惊叹的是,其性能不仅能够与参数规模高达 6710 亿的 DeepSeek-R1 相媲美,更凭借开源免费、轻量化部署的特性,极大地降低了技术门槛,成为了中小团队和学术研究的理想选择。

一、项目概述

QwQ-32B 是阿里云通义千问系列中的专精推理型 AI 模型,它并非一款普通的通用大模型,而是专注于解决复杂逻辑问题与长文本分析任务。在设计上,它更加注重数学推导、编程辅助和动态环境决策能力,这使得它在对逻辑严谨性要求极高的场景中表现出色,能够为企业和研究机构提供精准高效的解决方案。

1. 架构设计

QwQ-32B 基于 Qwen2.5-32B + 强化学习框架,融合了多项前沿技术,构建了一个高效且强大的推理架构。

-

RoPE(旋转位置编码):这一技术能够显著增强模型对长文本的位置感知能力,使得模型在处理长篇幅文本时,能够更好地理解文本的结构和逻辑关系,从而提高推理的准确性和效率。

-

SwiGLU 激活函数:通过优化激活函数的设计,提升了模型的非线性建模效率,使得模型能够更好地捕捉复杂的模式和关系,进一步增强了其推理能力。

-

自反思推理机制:这是 QwQ-32B 的一大亮点,模型能够通过动态调整推理路径,不断优化问题解决流程。这种自反思机制使得模型在面对复杂的推理任务时,能够像人类一样进行思考和调整,从而更加高效地找到解决方案。

2. 训练策略

QwQ-32B 采用了三阶段混合训练法,这一训练策略充分结合了多种训练方法的优势,使得模型在不同方面都得到了充分的锻炼和优化。

-

预训练:基于万亿Token 的高质量多语言语料,让模型在海量的数据中学习语言的规律和模式,为后续的推理任务打下坚实的基础。

-

监督微调:聚焦数学证明、代码生成等专项任务,通过针对性的训练,让模型在这些关键领域具备更强的专业能力,能够更加精准地完成复杂的推理任务。

-

强化学习对齐:通过人类反馈(RLHF)优化输出逻辑性,这一阶段的训练使得模型能够更好地理解人类的逻辑和思维方式,从而生成更加符合人类需求的推理结果。

三、功能特点

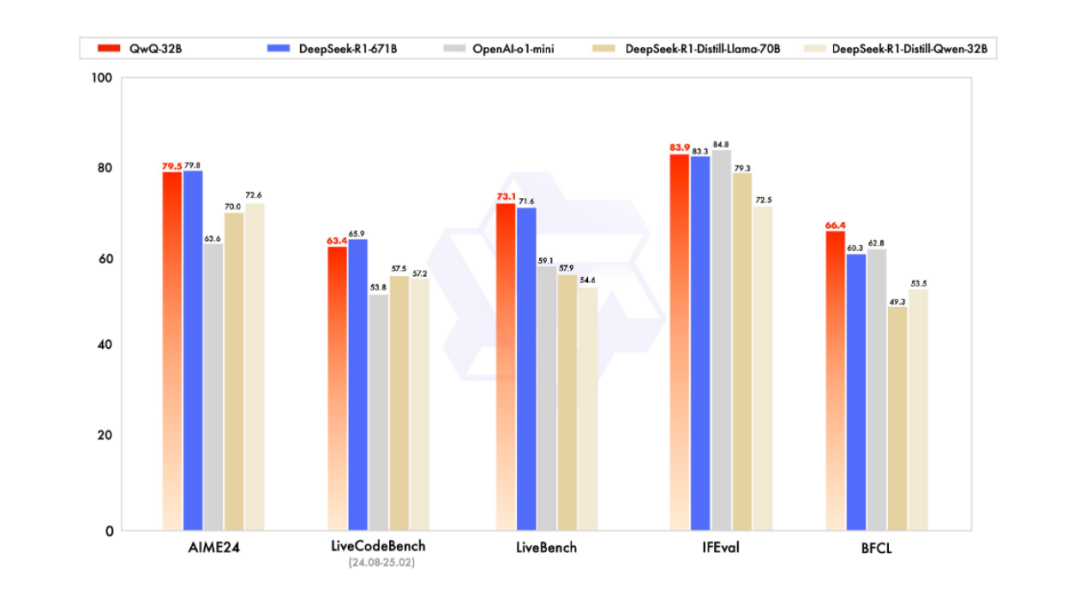

1. 数学推理:在 AIME24 评测集上得分超越 GPT-4,复杂方程求解准确率高达 90.6%,这表明 QwQ-32B 在数学推理方面已经达到了一个非常高的水平,能够为数学研究和教育等领域提供强大的支持。

2.代码生成:在 LiveCodeBench 测试中与 DeepSeek-R1 持平,错误率低于同类模型 30%,这使得 QwQ-32B 成为编程辅助领域的有力竞争者,能够帮助开发者快速生成高质量的代码,提高开发效率。

3.长文本处理:能够完整解析 50 页学术论文并生成结构化摘要,这一能力使得 QwQ-32B 在学术研究、金融分析等领域具有广泛的应用前景,能够帮助研究人员和分析师快速提取关键信息,提高工作效率。

四、评测结果

在多个权威评测集上,QwQ-32B 的表现都非常出色,与 DeepSeek-R1 和 GPT-4 等顶尖模型相比也毫不逊色。

从这些数据可以看出,QwQ-32B 在数学推理、代码生成和逻辑推理等方面都展现出了强大的竞争力,其性能已经达到了行业领先水平。

五、应用场景

QwQ-32B 的强大性能使其在多个领域都有广泛的应用前景,以下是一些典型的应用场景:

1. 教育领域

-

解题辅导:能够分步拆解高等数学证明题,为学生提供详细的解题思路和步骤,帮助他们更好地理解和掌握数学知识。

-

代码教学:实时检测编程作业逻辑漏洞,为学生提供及时的反馈和指导,提高他们的编程能力和代码质量。

2. 金融分析

-

研报解读:从百页财报中提取关键财务指标,帮助分析师快速获取重要信息,提高工作效率。

-

量化策略:基于历史数据生成交易规则,为金融机构提供科学的决策支持,降低投资风险。

3. 科研辅助

-

论文评审:验证数理推导过程一致性,确保论文的科学性和准确性。

-

实验设计:优化生物医药测试方案,提高实验效率和成功率,为科研工作提供有力支持。

六、快速使用指南

为了让开发者能够快速上手使用 QwQ-32B,这里提供了一些简单的使用指南。

1. 在线体验

访问https://huggingface.co/spaces/Qwen/QwQ-32B-Demo,即可在线体验 QwQ-32B 的强大功能,感受其推理能力。

2. 本地部署

from modelscope import AutoModelForCausalLM, AutoTokenizermodel_name = "Qwen/QwQ-32B"model = AutoModelForCausalLM.from_pretrained(model_name,torch_dtype="auto",device_map="auto")tokenizer = AutoTokenizer.from_pretrained(model_name)prompt = "How many r's are in the word \"strawberry\""messages = [{"role": "user", "content": prompt}]text = tokenizer.apply_chat_template(messages,tokenize=False,add_generation_prompt=True)model_inputs = tokenizer([text], return_tensors="pt").to(model.device)generated_ids = model.generate(**model_inputs,max_new_tokens=32768)generated_ids = [output_ids[len(input_ids):] for input_ids, output_ids in zip(model_inputs.input_ids, generated_ids)]response = tokenizer.batch_decode(generated_ids, skip_special_tokens=True)[0]print(response)

通过上面的代码,你就可以在本地部署体验 QwQ-32B 模型,开始你的推理之旅。

3. 硬件建议

显存:至少 24GB(FP16 精度),这是运行 QwQ-32B 的最低要求,如果需要更高的性能,建议使用更大显存的设备。

推荐配置:NVIDIA RTX 4090 或 A100 显卡,这些高性能显卡能够为 QwQ-32B 提供强大的计算支持,进一步提高推理速度和效率。

七、结语

QwQ-32B 的开源是中国 AI 产业在高效推理模型领域的一次重大突破。它以 1/20 的参数量实现了匹敌 DeepSeek-R1 的性能,充分验证了强化学习技术在大模型开发中的巨大潜力。开源免费、轻量化部署的特性,更是为中小开发者提供了低成本高性能的落地方案,极大地推动了 AI 技术的普及和应用。

项目地址

ModelScope:https://modelscope.cn/models/Qwen/QwQ-32B

Hugging Face:https://huggingface.co/Qwen/QwQ-32B

官方文档:https://qwen.readthedocs.io

(文:小兵的AI视界)