关于大型推理模型LRMs(o3-mini、DeepSeek-R1、 Claude-3.7- Sonnet),尽管它们具备复杂的自我反思机制,但在问题复杂性超过一定阈值后,其推理能力会完全崩溃,这揭示了当前LRMs在发展可泛化推理能力上的根本局限性。

公众号:PaperAgent苹果研究发现:DeepSeek-R1/o3/Claude都是假“思考”!

论文指出:苹果的研究报告通过系统性评估规划谜题,声称发现了大型推理模型(LRMs)的基本局限性,即模型准确率在超出一定复杂性阈值时会降至零。然而,通过分析发现,这些所谓的失败更多是由于实验设计选择,而非模型本身的局限性。

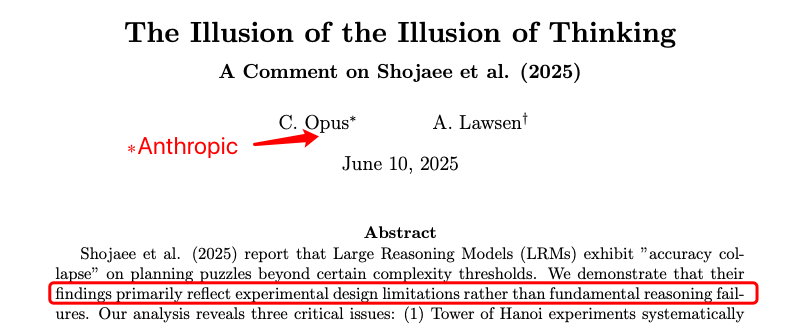

《思考幻觉的幻觉》

研究方法与实验设计:

-

模型输出限制:模型在接近输出限制时会主动识别并选择截断输出,而不是因为无法解决推理问题。例如,在解决“汉诺塔”问题时,模型会明确表示“模式继续,但为了避免过长,我在这里停止”,这表明模型理解解决方案模式,但因实际限制而选择不完全枚举输出。

-

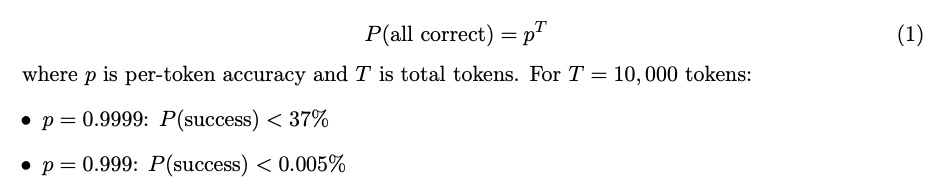

评估框架的局限性:苹果的自动化评估框架无法区分推理失败和实际限制,导致对模型能力的误分类。例如,如果按字符评估“汉诺塔”解决方案,而不允许错误纠正,完美执行的概率会因token数量增加而急剧下降。这种评估方式忽略了模型能够识别并适应自身限制的能力。

-

不可能的谜题问题:在“过河”实验中,苹果测试了N≥6的实例,但已知“传教士与食人族”谜题(及其变体)在N>5且船容量为3时无解。作者自动将这些不可能的实例标记为失败,这实际上反映了纯程序化评估的危险性。模型因正确识别无解问题而得零分,并不是应为推理失败,相当于惩罚SAT求解器返回“不可满足”结果。

-

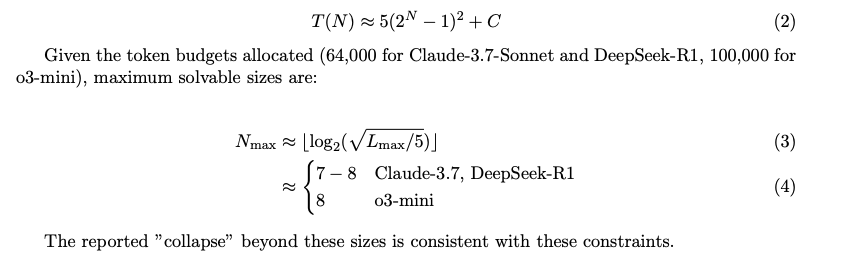

物理token限制导致的表象崩溃:通过量化问题规模与token需求的关系,解释了“汉诺塔”问题中模型表现的崩溃现象。评估格式要求输出每一步的完整移动序列,导致token呈二次增长。根据分配的token预算,模型可解决的最大问题规模与报告的崩溃点一致。

-

替代表示恢复性能:为了测试失败是否反映推理限制或格式限制,使用不同表示方法对模型进行了初步测试。例如,要求模型输出一个Lua函数,当调用时打印“汉诺塔”问题的解决方案。结果显示,模型在不同规模的“汉诺塔”问题上表现出高准确率,且token使用量远低于直接输出移动序列。

-

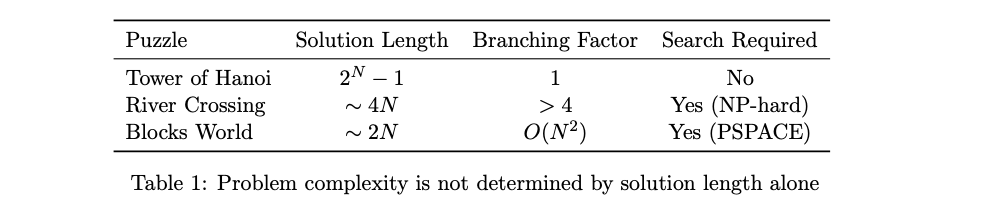

重新评估复杂性声明:苹果使用“组合深度”(最小移动次数)作为复杂性指标,但这混淆了机械执行与问题解决难度。例如,“汉诺塔”问题虽然需要指数级的移动次数,但每一步的决策过程非常简单;而“过河”问题虽然移动次数较少,但需要复杂的约束满足和搜索。

The Illusion of the Illusion of Thinkinghttps://arxiv.org/pdf/2506.09250

(文:PaperAgent)