360 度视角 × 双目第一视角 × 多模态感知,欢迎大家参加BinEgo‑360Workshop及 挑战赛,共同探索多视角场景理解的边界!

BinEgo‑360° 挑战赛:融合全景与双目第一视角的多模态场景理解

主页:https://x360dataset.github.io/BinEgo-360/

赛道1:复杂场景理解挑战赛(Scene Classification Challenge)

参赛:

https://www.kaggle.com/competitions/bin-ego-360-challenge-classification

数据集下载:

https://huggingface.co/datasets/quchenyuan/360x_dataset_HR

赛道2:时序动作定位挑战赛(Temporal Action Localization Challenge)

参赛:

https://www.kaggle.com/competitions/bin-ego-360-challenge-tal

数据集下载:

https://huggingface.co/datasets/quchenyuan/360x_dataset_HR

大赛简介

第 1 届 融合全景与双目第一视角的多模态场景理解挑战赛(BinEgo‑360°: Binocular Egocentric‑360° Multi‑modal Scene Understanding in the Wild) 将于 ICCV 2025 期间在美国夏威夷举办。

现实世界中的人类感知不仅依赖静态图像,更需要融合来自不同视角与模态的连续视频、空间音频与环境上下文信息。为推动人工智能向类人感知系统迈进,我们组织了 BinEgo‑360° 挑战,探索在360° 全景视角与双目第一视角融合下的多模态视频理解任务。

本次挑战基于我们在 CVPR 2024中发布的 360+x 数据集 [1],该数据集包含丰富的视觉、多模态、空间和语义信息,是目前首个面向第一人称与全景融合视角的大规模视频理解数据集之一。

为了更系统地推动对现实世界感知的研究,本次 BinEgo‑360° 挑战设置了两个具有代表性的赛道:复杂场景理解(Scene Classification)和时序动作定位(Temporal Action Localization)。

两个任务聚焦于现实生活中高频、连续、多模态交互的视觉理解场景,挑战参赛者在跨模态信息建模、空间感知融合、时间动态建模等方面的综合能力。

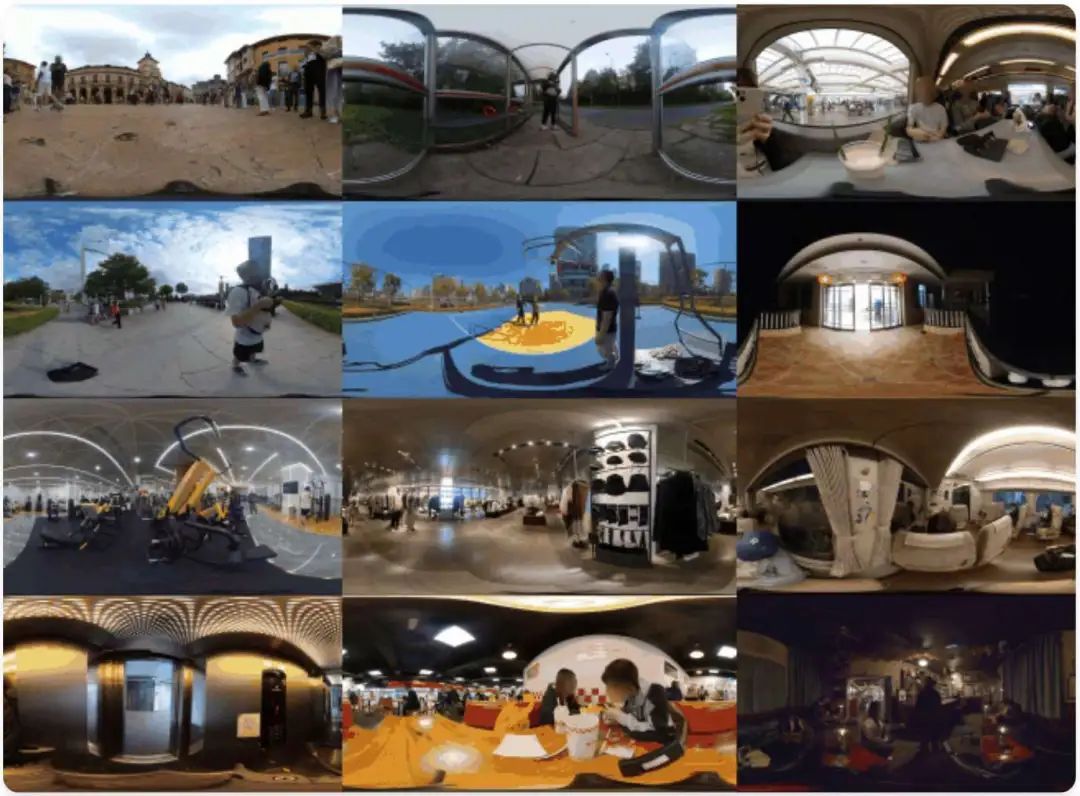

数据集中的视频来自真实生活场景,涵盖多种地理位置、天气、场景类型、交互行为等因素。视频中包含 360° 全景视频、双目第一视角、单目视角、多通道空间音频、地理位置 、 时间戳、 以及 自然语言场景描述,高度还原人类在复杂现实环境中的知觉与行为基础。

BinEgo‑360° 挑战不仅关注算法性能,也关注方法的泛化能力和跨模态鲁棒性,鼓励来自学术界与工业界的研究者提出创新性方法,提升 AI 在真实复杂世界下的理解与决策能力。

在挑战赛的同时,我们将邀请 ICCV 2025中与本 Workshop 研究主题密切相关的论文进行Oral报告。如果您有兴趣在 BinEgo‑360° Workshop 上展示您的工作,请在挑战赛主页填写申请表格。

目前,两个挑战赛的数据集均已开放下载,欢迎参赛者自由尝试各种方法!

赛道1:复杂场景理解挑战赛(Scene Classification Challenge)

本赛道关注在多模态视角下对整段视频片段的场景类别进行分类,旨在推动跨视角融合下的复杂场景语义理解研究。

该任务基于360+x数据集 [1],涵盖真实世界中多种环境(如厨房、客厅、办公室、超市等),并提供标准化的多模态输入和场景标签。

输入模态:

360° 全景 RGB + 双目第一视角 RGB + 空间音频

输出格式:

单一场景标签(单标签分类任务)

评估指标:

Top‑1 分类准确率(在挑战赛测试集上评估)

赛道2:时序动作定位挑战赛(Temporal Action Localization Challenge)

本赛道关注视频中动作的时序识别任务,要求检测出视频片段中每一个动作的起止时间和类别。该任务在 360° 与第一视角融合场景下极具挑战性,强调对时间、空间和语义的综合建模能力。

输入模态:

360° 全景 RGB + 双目第一视角 RGB + 空间音频

输出格式:

每条动作检测需提交 JSON 格式,包含视频编号、起止时间和动作标签

参赛信息

两个挑战赛均在平台Kaggle上举办。参赛者可以下载数据集至本地,训练测试后将结果提交至赛事平台进行评估。目前,两个挑战赛的数据集均已开放下载,欢迎个人和团队自由尝试各种方法。

时间安排:

2025年6月1日:数据集与基线方法正式发布,Kaggle 平台开放参赛提交

2025年7月6日:提交截止,Kaggle 榜单锁定

2025年9月中旬:获奖团队提交展示幻灯片 / 海报

2025年10月19日至20日:在 ICCV 2025 Workshop 现场颁奖与成果展示

奖品设置:

Insta360 X5 全景相机

Amazon / 淘宝购物礼品卡

Workshop论文展示申请入口即将开放,请关注官方网站获取地址

https://x360dataset.github.io/BinEgo-360/

[1] Chen, H., Hou, Y., Qu, C., Testini, I., Hong, X., & Jiao, J. (2024). 360+ x: A Panoptic Multi-modal Scene Understanding Dataset. In Proceedings of the IEEE/CVF Conference on Computer Vision and Pattern Recognition (pp. 19373-19382).

(文:极市干货)