今天是2025年6月15日,星期日,北京,晴

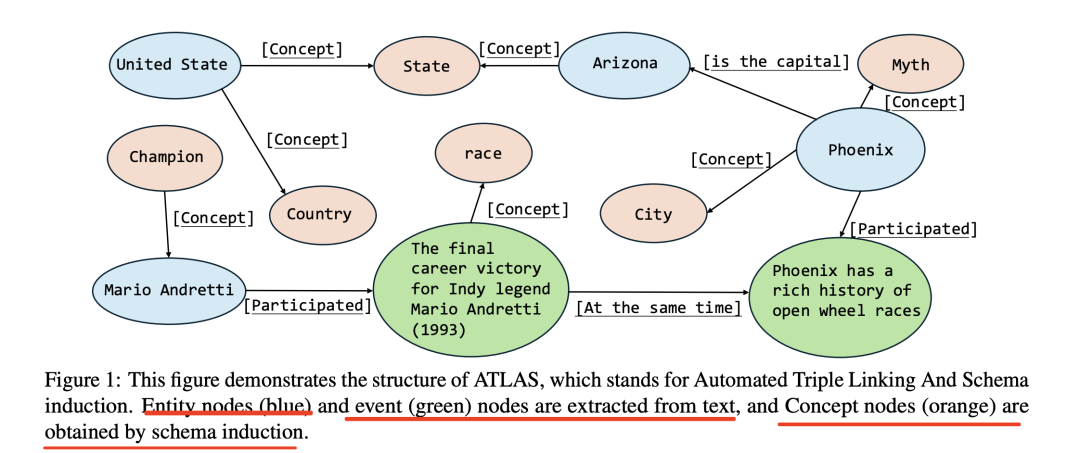

我们来看看一个纯LLM驱动的知识图谱三元组及Schema提取方案,例如图中的实体节点(蓝色)和事件节点(绿色)是从文本中提取的,而概念节点(橙色)则是通过模式归纳获得。

方法来自于《AutoSchemaKG: Autonomous Knowledge Graph Construction through Dynamic Schema Induction from Web-Scale Corpora》,https://arxiv.org/pdf/2505.23628,其思路很粗暴,就是完全基于LLM来构建图谱,并且不预先指定schema,而是从提取的三元组出发,归纳出实体类型、关系类型和事件类型,地址在https://github.com/HKUST-KnowComp/AutoSchemaKG,核心的核心就是一堆prompt,多阶段,很工程化。

一、纯Prompt提示LLM的知识图谱三元组及Schema生成方式

为了形成上述图谱,看提取方式,可以当作纯LLM驱动的方式去做,为了得到上述节点,可以采用以下提示来获取:

1、Triple Extraction三元组抽取

依次通过三个阶段,分别抽取EntityEntity, Entity-Event, and Event-Event relationships。

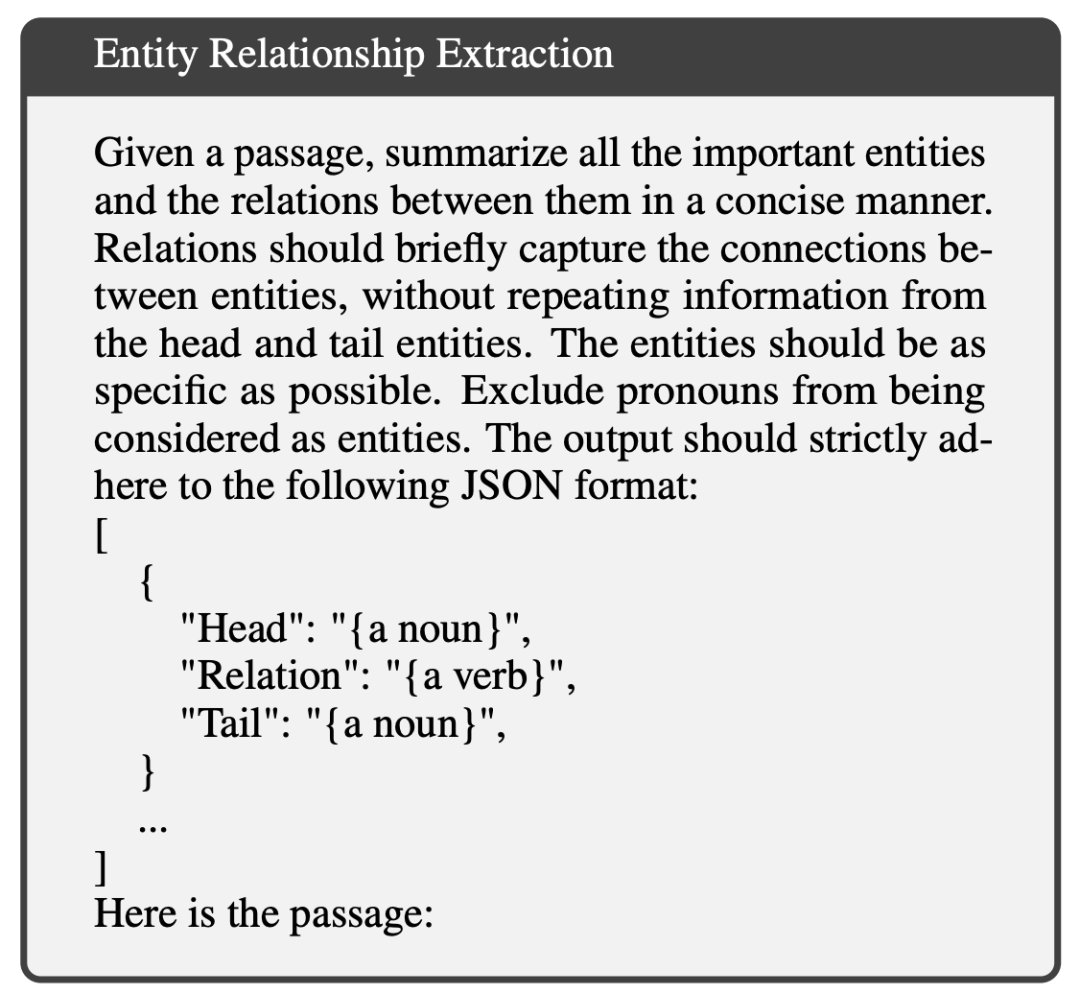

1)实体关系抽取,生成实体之间关系的文本三元组

识别实体与实体之间的关系,输出被解析为三元组(e1, r, e2),其中e1和e2属于实体节点集合VN,r属于关系类型集合R。

2)事件和实体三元组抽取,生成实体和事件之间关系的文本三元组*

识别实体与事件之间的关系,生成三元组(e, r, v)或(v, r, e),其中e属于实体节点集合VN,v属于事件节点集合VE,r属于关系类型集合R。

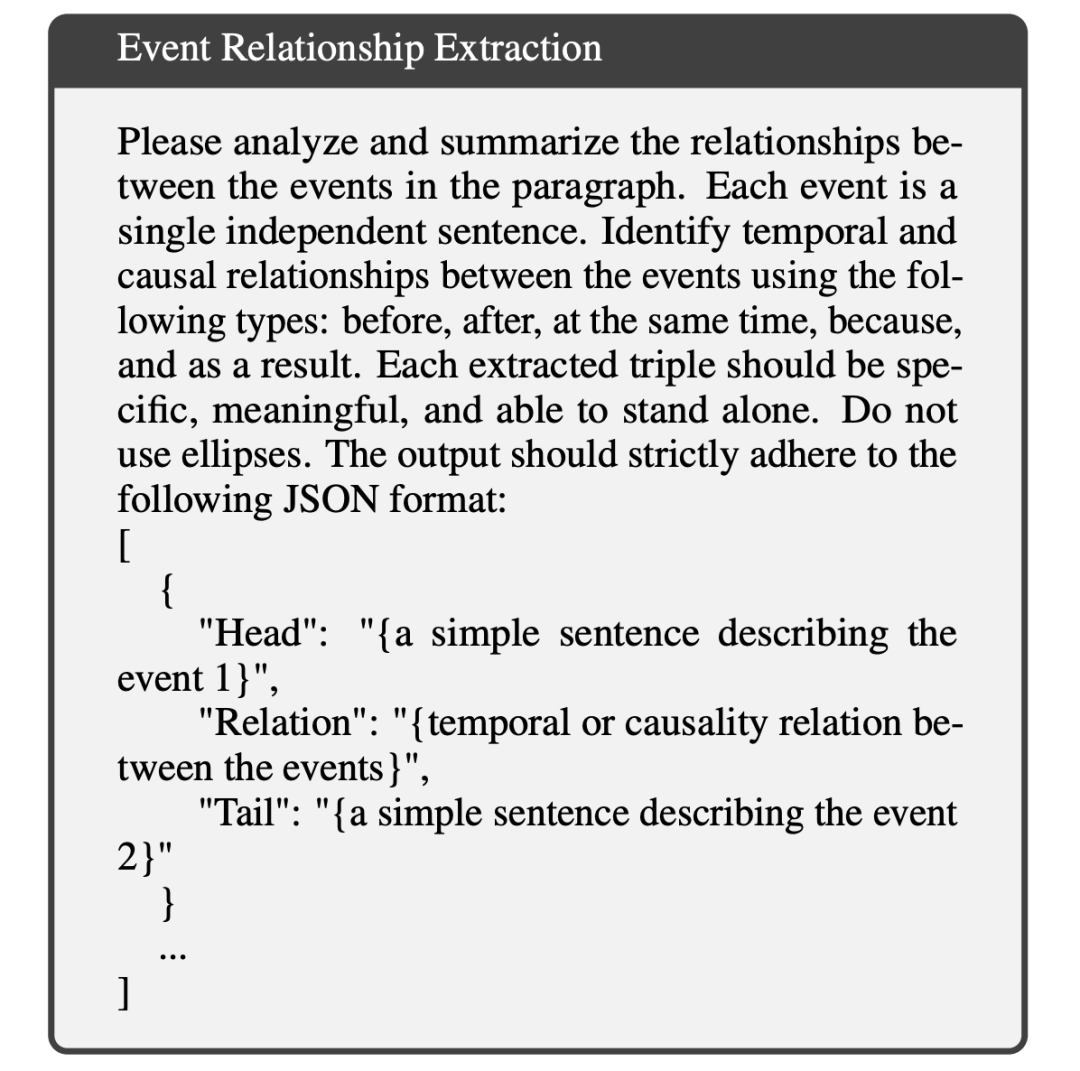

3、事件关系抽取,生成事件和事件之间关系的三元组

识别事件与事件之间的关系,生成三元组(v1, r, v2),其中v1和v2属于事件节点集合VE,r属于关系类型集合R。

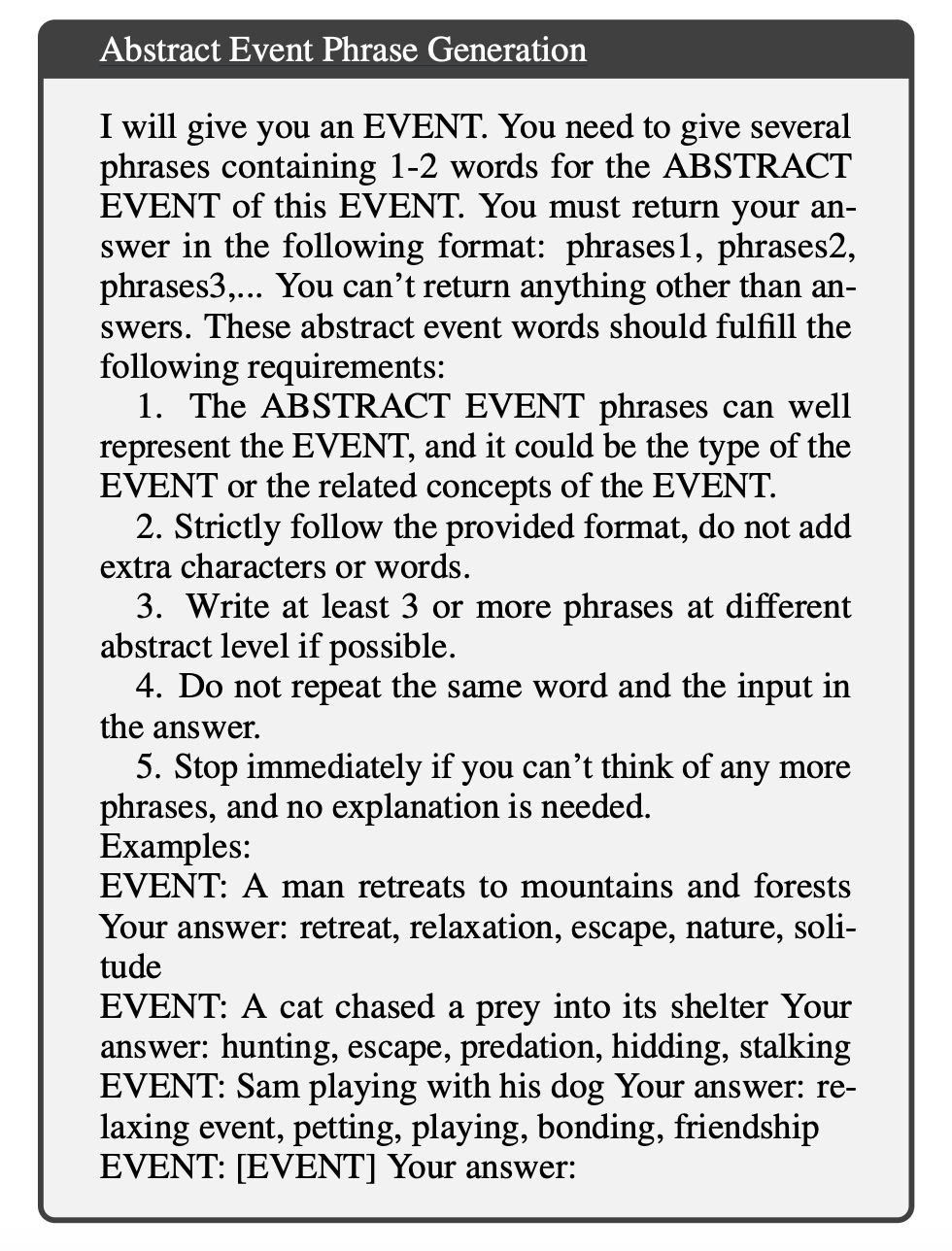

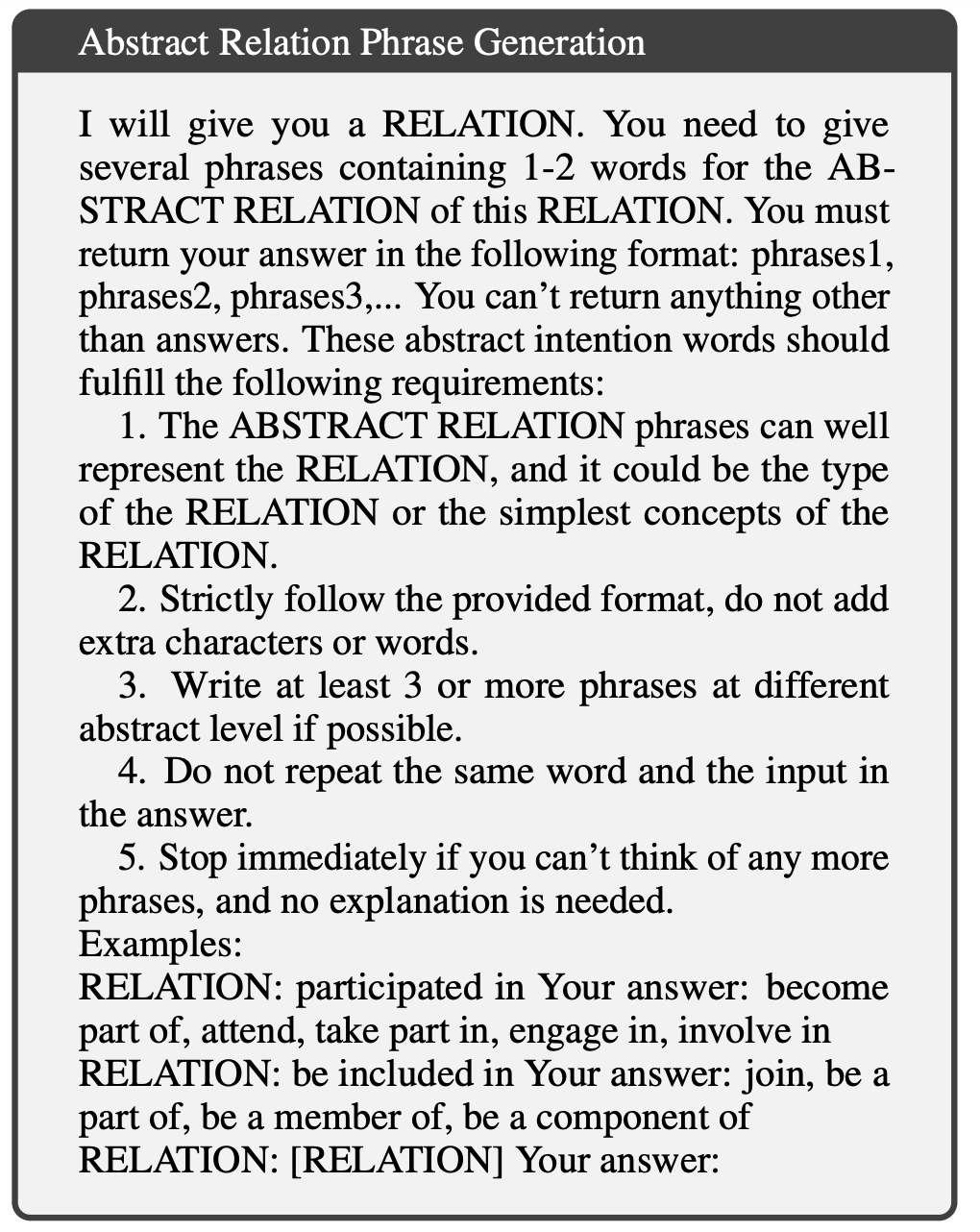

2、Schema Induction图谱Schema生成

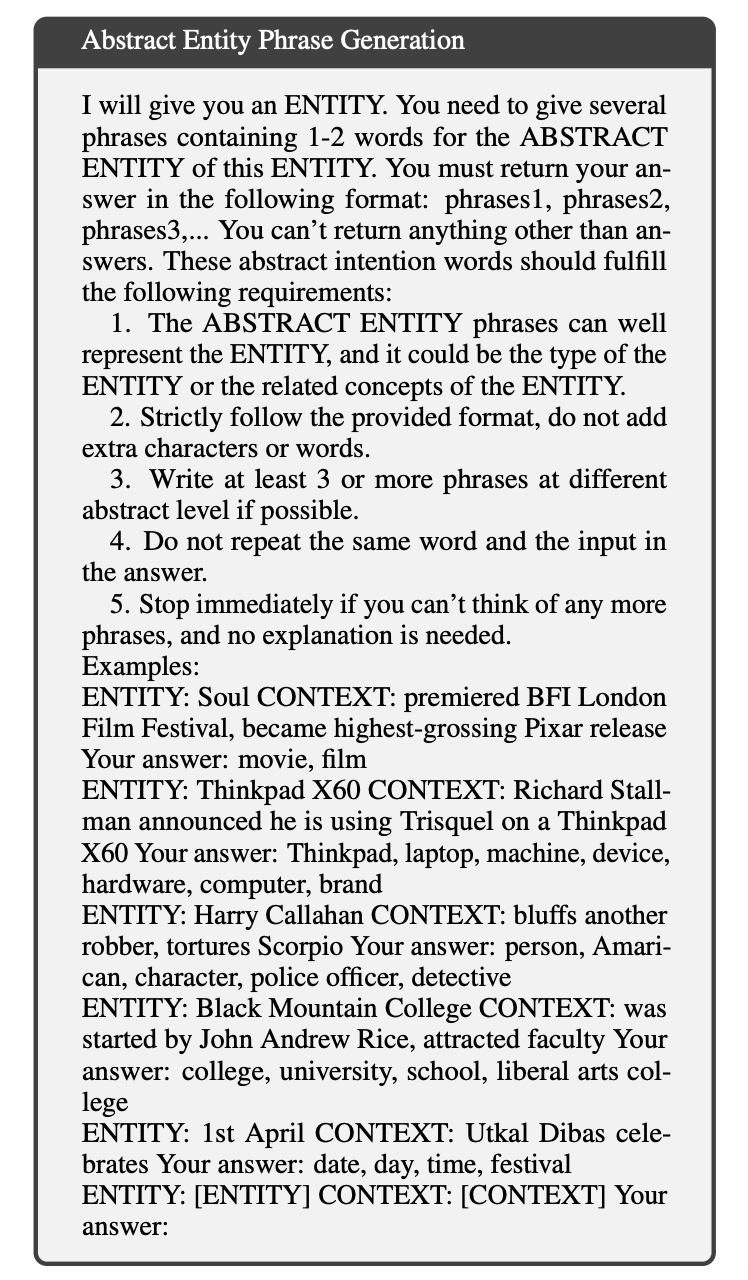

将具体的实体、事件和关系抽象化为一般化的类型。这一过程利用大模型生成代表每种这些类型的抽象概念短语。

1)抽象事件短语生成,生成事件概念

2)抽象实体短语生成,生成实体概念

3)抽象关系短语生成,生成关系类型

为每个元素生成至少三个短语,这些短语在不同的抽象层次上封装了其类型或相关概念。

二、AutoSchemaKG的实验成本及存在问题

卡看具体的实验数据和成本:

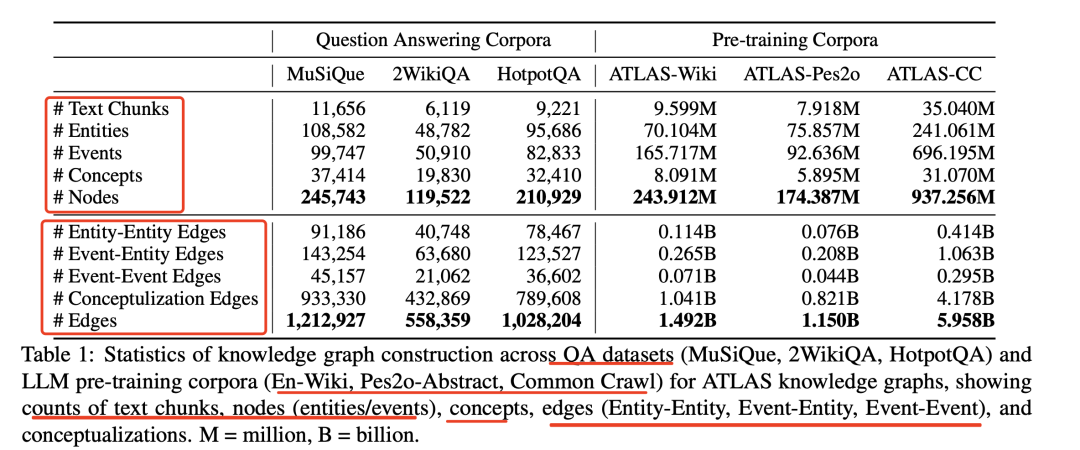

整个代价并不低,80GB的GPU(具备1,513TFLOPS的FP16计算能力),运行带有FlashAttention的Llama-3-8B-instruct模型来构建知识图谱。

1、处理英文维基百科(En-Wiki,包含2.439亿个节点和14.9亿条边)耗费了14,300个GPU小时;处理Pes2o-Abstract(包含1.744亿个节点和11.5亿条边)耗费了11,800个GPU小时;

2、处理CommonCrawl(包含9.373亿个节点和59.6亿条边)则耗费了52,300个GPU小时。

3、以批处理的方式处理每段1,024个token的文本,总共投入了约78,400个GPU小时,用于提取数十亿条语义关系。

但是,这个工作的工作量是很大的,但是这种方式很粗暴,有些问题还是不能回避,因为除了提取之后,还涉及到实体消歧、对齐、关系对齐、事件对齐以及概念消歧、概念层级等工作,这些往往是保证知识图谱可用性的前提。

参考文献

1、https://arxiv.org/pdf/2505.23628

(文:老刘说NLP)