这回,上海交通大学的研究人员在机器人手领域整了个大活!

他们开发出一种叫TacPalm-SoRoHand的机器人手,不仅把视觉和触觉感知塞进了手掌,还配上了超灵活的软体手指,以及手掌-手指协作策略。

机器人手掌和手指配合有多默契?抓东西稳得很,还能”摸”出物体3D外形,甚至区分不同物体。更厉害的是,它能完成一些相当精细的动作:从桌面上捡起卡片、检测布料瑕疵、实时调整姿势防止茶水洒出来等等。研究团队还给它加了AI,让它能跟人类更好地互动。这波操作,为人机协作开了个新思路!

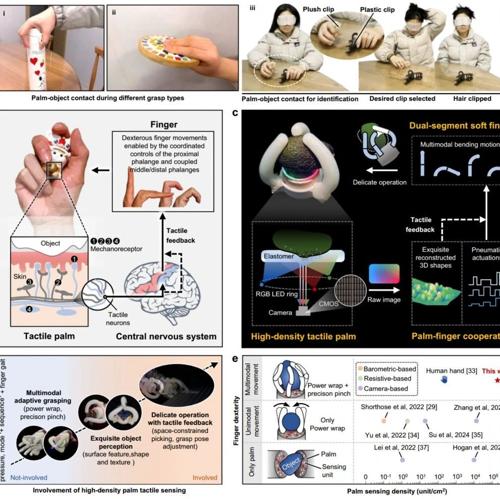

图1 TacPalm-SoRoHand的总体概念

这项研究日前发表在Nature Communications上。

▍结构设计:让机器人手掌既能看又能摸

说到机器人手,大家可能会想到工业机器人那种”铁爪子”。但随着应用场景越来越复杂,研究者们开始追求更高端的功能:既要动作灵巧,还得有丰富的触觉感知。

不过目前的研究主要把注意力放在手指和指尖上。手掌这个重要的”触觉区域”反而被忽视了 —— 感知密度不够高,跟手指配合也不够默契。

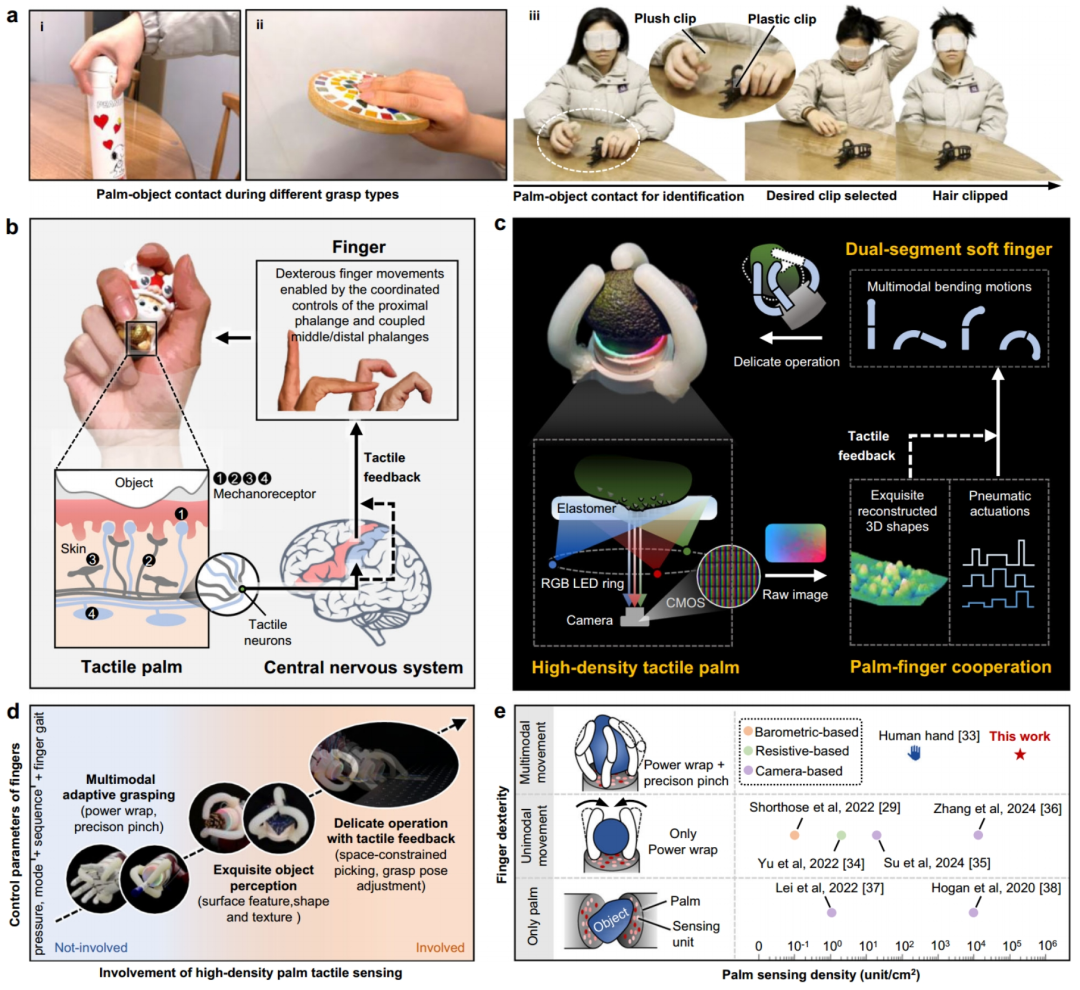

图2 TacPalm-SoRoHand的结构

这只机器人手最大的特点就在于它那个能看能摸的手掌。研究团队把它设计成了一个紧凑的视触觉系统,主要由这几部分组成:

-

微型摄像头

-

多层感知弹性体

-

发光二极管环

-

其他辅助组件

其中,感知弹性体分为三层:

-

覆盖灰色膜的弹性体层

-

透明亚克力层

-

用于扩散光线的漫射层

当物体接触手掌时,弹性体会变形,摄像头就能捕捉到这些变形信息。为了获取深度信息,发光二极管环被编程为红、绿、蓝三组,能产生不同深度的彩色光梯度。

手指部分也很有讲究。由两段纤维增强弹性体腔室、附着在弹性体腔室底部的高模量聚乙烯片,以及由低模量弹性体外皮组成。

在气动驱动过程中,弹性体腔室的顶部伸长,而聚乙烯片限制了底部的伸长。顶部和底部伸长差导致手指段的弯曲运动。近端段和远端段可以独立或统一驱动,使手指能够实现强力包络和精确捏取,适用于大多数抓取任务。

▍性能表征:远超人手的触觉密度

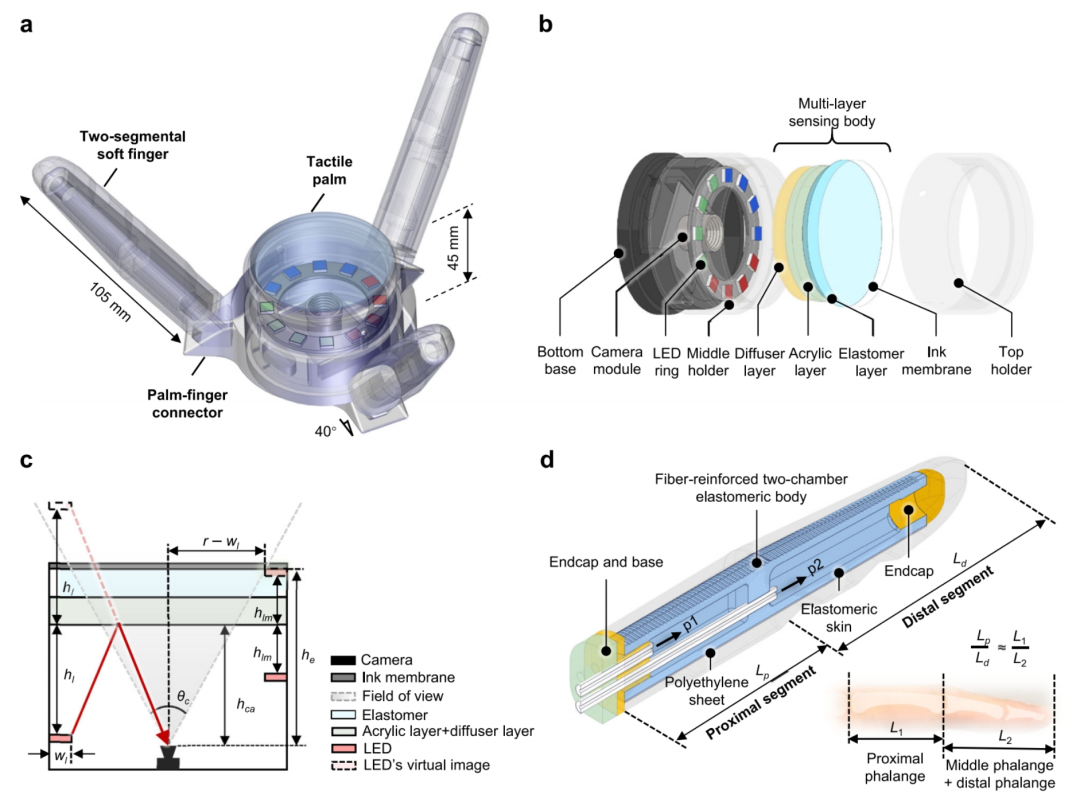

图3 掌部触觉感知性能

这只机器人手的性能有多强?来看看具体数据。

先看手掌的触觉密度:1280×800个感知单元,分布在30.08×18.80mm的矩形区域内。算下来感知密度高达181000单元/cm²!要知道,人手的触觉密度只有240单元/cm²,这个差距简直不是一个量级的。

灵敏度也相当可观。最小能感知1 kPa的压力,压痕尺寸随法向压力增加而增大,能够通过几何模型和压痕变化来估计法向压力。法向压力响应较稳定,超5000次加载-卸载循环未出现明显衰减。

通过分析触觉图像和RGB强度分布,研究团队发现手掌内部的光照很均匀。借助快速泊松算法,还能重建表面形貌。测试结果显示:

-

平面方向重建精度:92.3%

-

垂直方向重建精度:81%

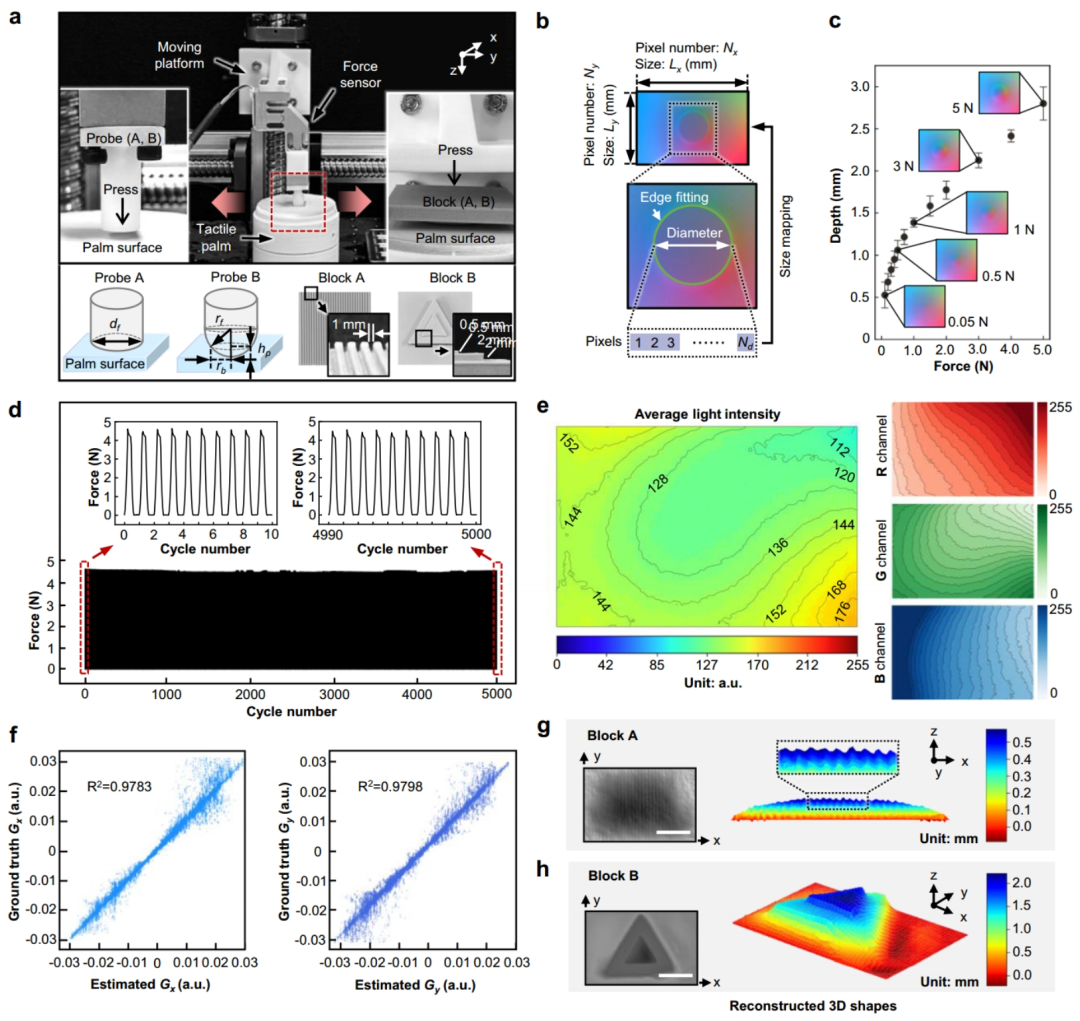

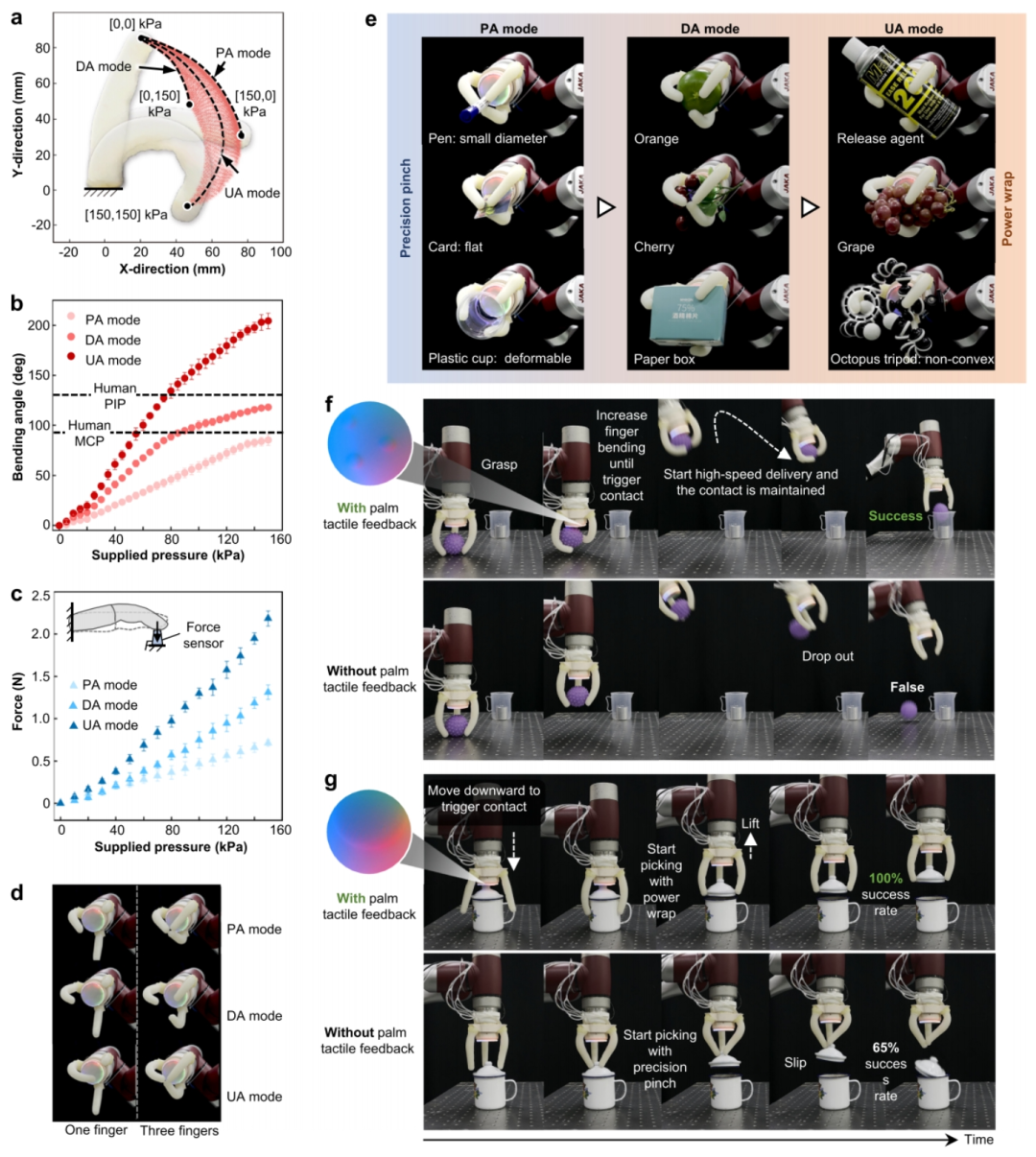

图4 软体手指的性能及抓取能力

再来看看手指的表现。它的工作空间呈新月形,是三种驱动模式组合的结果:

-

近端驱动

-

远端驱动

-

两段共享压力的均匀驱动

手指最大弯曲角度能达到204.3±7.6度,和人手差不多。整只手的最大抓取力是14.6±0.6N,足够应付大多数日常物品。

最厉害的是手掌增强了抓取可靠性:通过与细长/扁平物体的尖端/边缘接触来保持物体稳定;其表面柔顺性能与易碎变形物体安全交互;阻挡了松散物体,并能够被动适应大型非凸面物体。

实验证明,这种配合确实很给力。比如在高速递送任务中,有触觉反馈的机器人手能稳稳抓住物体,没有触觉反馈的就容易”掉链子”。

拿杯盖拾取实验来说:

-

有触觉反馈:20次实验全部成功

-

无触觉反馈:成功率只有65%

为什么会有这么大差距?因为有触觉反馈时,手掌能感知到杯盖,提示手指去包络杯盖边缘。而没有反馈的话,手指就只能盲目捏取,容易让杯盖滑掉。

▍应用验证:从精细触觉到实时交互

研究团队设计了一系列实验,展示这只机器人手的实战能力。

一、抓取过程中的精准感知与识别

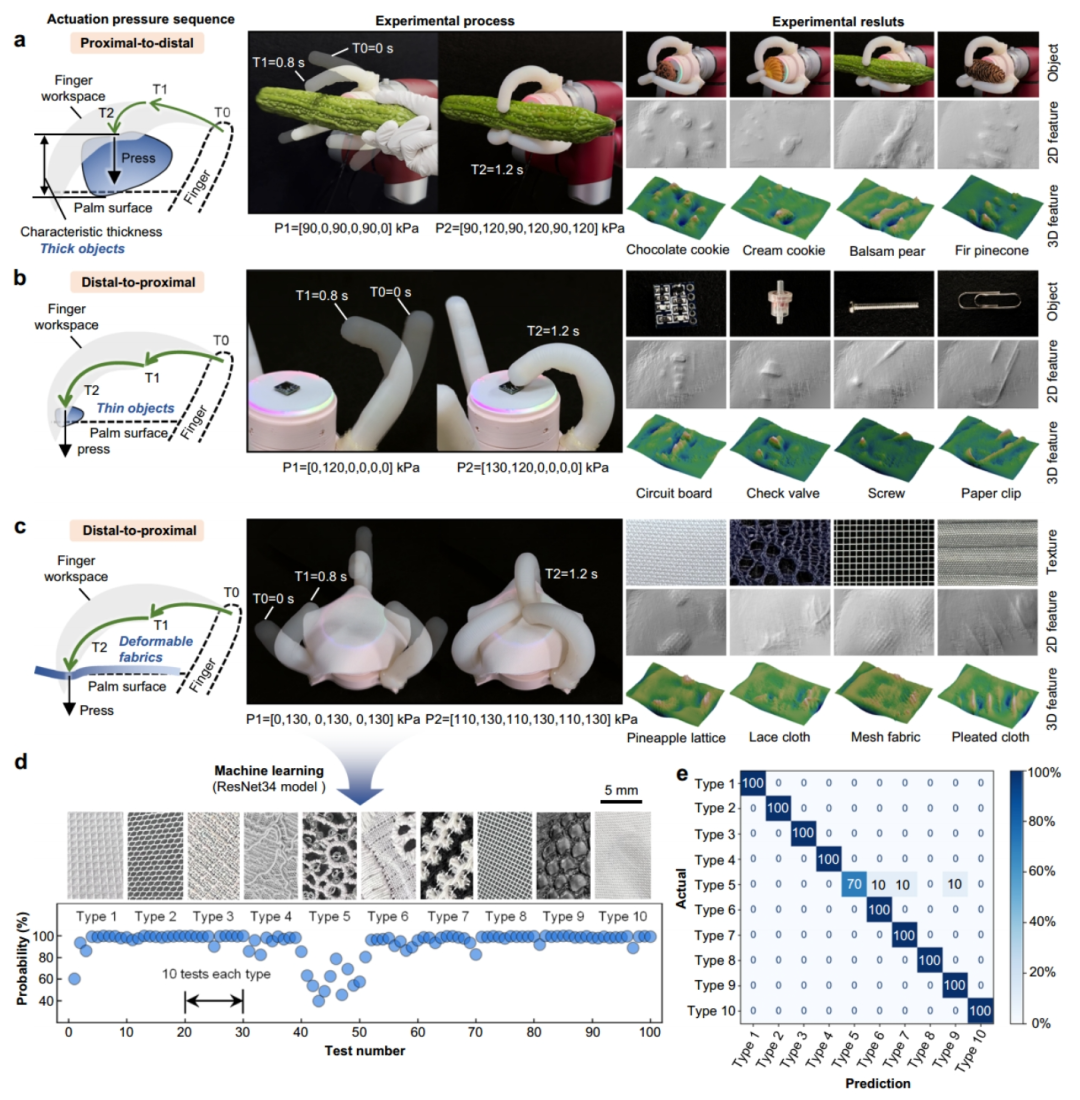

图5 对不同抓取物品的精细感知和分类

团队测试了TacPalm-SoRoHand对三类物体的感知能力:

1.尺寸较大且具有不规则脆弱表面纹理的自然物体:对于苦瓜、饼干、松果等不规则表面纹理的脆弱物体,采用”先近端-再远端”驱动顺序,可使物体几乎垂直地按压在手掌上而不受损,精确重建三维表面形状。

2.具有明显几何特征的小型工业部件:对电路板、止回阀、螺丝等薄型部件,采用”先远端-再近端”顺序驱动,可实现精准抓取和将其垂直按压,并重建其细微几何特征。

3. 易起皱的薄织物:对厚度仅0.5mm的织物,采用“先远端-后近端”的顺序驱动,经算法去除手指压痕干扰后,可成功重建织物纹理并通过快速傅里叶变换以频谱图方式分析纹理的周期性和方向特征。

在此基础上,研究人员对10种不同织物进行分类。实验前,通过AI算法构建了不同织物类型触觉图像的数据集和学习模型,实时计算效率高,处理时间<0.01s。

实验结果表明,该系统对织物的平均分类准确率达97%,误分类发生在织物类型5上,原因是按压过程中获取的触觉图像未能完全反映其大孔状图案。同时,可构建分类准确率矩阵,获得最佳的(准确率>90%)的手指力和驱动气压设置区间。

二、基于手掌触觉反馈的精细操作

利用手掌触觉反馈与手指步态抓取卡片

软体手采用两段式循环手指步态策略(起始-接触-拉动-抬起-恢复)从桌面拾取卡片。当卡片移至手掌时,触觉手掌通过边缘检测算法识别卡片侧边产生的线状压痕,触发手指驱动系统进行自适应抓取。此方法不仅适用于实心卡片,还能处理传统真空吸附难以应对的多孔扁平物体。

连续瑕疵检测

掌指协作实现了对杂色布料的连续瑕疵检测。软体手通过手指步态控制布料定向移动,使触觉手掌能持续检测表面瑕疵,而不局限于固定位置。结合颜色差异图像算法,系统能区分有瑕疵和无瑕疵区域。这种方法突破了手掌物理尺寸限制,无需额外装置即可实现大面积自动感知。

基于掌部触觉反馈的动态姿态调整

在茶壶倒水实验中,软体手通过手掌触觉反馈动态调整抓取姿态。系统监测压痕轮廓区域值(ICA),当水流导致茶壶重心偏移使ICA低于阈值时,气动系统自动增加手指弯曲度以调整姿态。在随后倒水过程中,ICA升至阈值以上,确保任务完成。与传统方法(手指同时处理反馈和执行)不同,本方法中的手掌提供稳定支撑和触觉反馈,而手指则作为专用末端执行器。这种功能分离在涉及人类参与的场景中尤其有益,因为传统方法不仅需要复杂的手指接触控制,还可能引入安全风险。

人机交互中的物品自动识别和递送

臂手系统结合AI技术实现了”盲袋”物品识别。实验中,五种物体(螺母、豌豆、螺栓、瓜子、西米)分别装入黑袋。志愿者指定目标物品后,系统能在多个盲袋中识别目标并安全递送。平均识别准确率达88%,其中瓜子识别率100%。形状相似的物体(螺母与西米,螺栓与豌豆)存在约15%混淆率,这主要由它们相似的尺寸、几何形状和袋子模糊效应所致。

视频5 人机交互应用中的物品自动识别和递送

▍总结与展望:一场机器人手的创新探索

上交大这项研究最大的亮点,就是无缝集成了高密度视触觉手掌、两段式气动软手指及其协调策略。这种设计让手掌和手指互相成就:

-

手掌通过各种反馈策略,帮助手指更好地抓取和操作

-

手指通过灵活运动,让物体能更好地与手掌接触,提升触觉感知效果

比起传统机器人手,这种手掌-手指协作展现了巨大的应用潜力,例如高分辨率三维表面重建、物体分类、以及动态精细操作,这些突破性进展为智能灵巧手技术推向新高度提供了可能,同时为人机协作领域开创了全新应用前景。

上海交通大学博士后张宁斌与任杰骥为论文共同第一作者,谷国迎教授与朱向阳教授为论文共同通讯作者。该研究得到了国家自然科学基金、上海市科委基金、国家博士后创新人才计划、国家博士后面上项目、上海市超级博士后激励计划、腾讯科学探索奖的资助。

论文链接

https://www.nature.com/articles/s41467-025-57741-6

(文:机器人大讲堂)