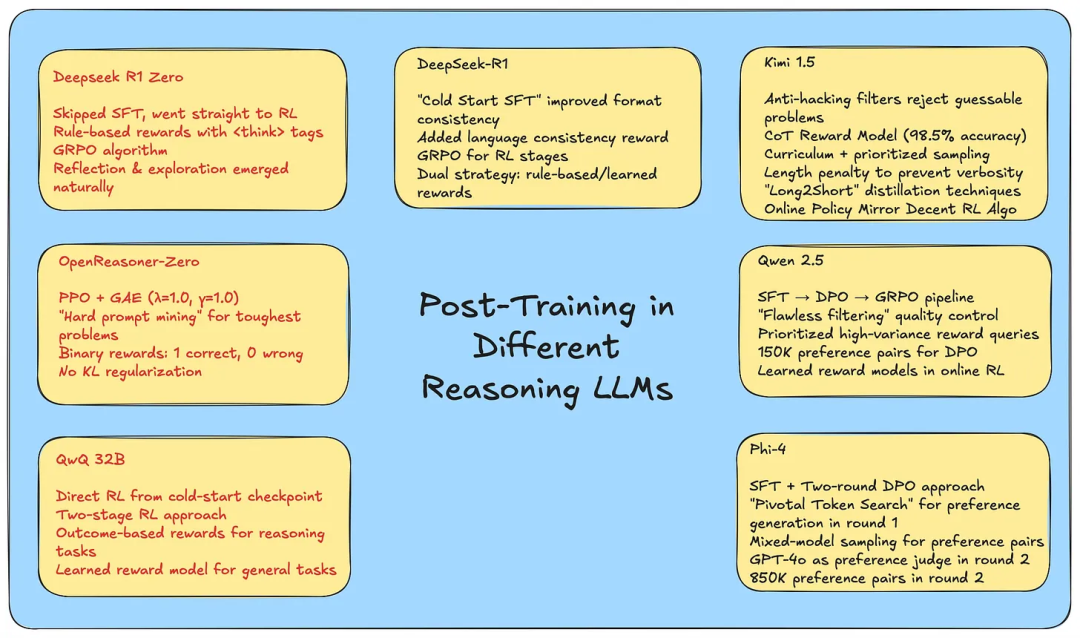

这篇文章深入探讨了大型语言模型(LLM)在后训练阶段如何学会推理。作者分析并比较了Kimi 1.5、Qwen 2.5、DeepSeek R1/Zero、OpenReasoner-Zero、QwQ 32B和Phi-4等顶级推理模型的后训练策略,涵盖监督微调(SFT)、奖励建模(规则基础与学习型)、强化学习(设计选择、目标、算法)和数据策划(来源、质量过滤和控制)等方面。文章详细介绍了每个模型的训练方法、创新点以及关键策略。

参考文献:

[1] https://meghanaarakkalrajeev.substack.com/p/how-llms-learn-to-reason-a-deep-dive

知识星球服务内容:Dify源码剖析及答疑,Dify对话系统源码,NLP电子书籍报告下载,公众号所有付费资料。加微信buxingtianxia21进NLP工程化资料群。

(文:NLP工程化)