从“单科专家”到“全能通才”:多模态统一的挑战与必要性

在人工智能领域,当前许多多模态大模型(MLLM)涌现,成为 AI 社区最重要的研究领域之一。我们见证着 MLLM 从“单科专家”向“全能通才”的演化过程。

但是,可别被那些看起来“无所不能”的 MLLM 迷惑了——虽然它们号称能同时处理图像、文本、视频、音频等多种信息,但实际上,这些模型的“智能核心”可能依然严重依赖于背后的语言大模型(LLM)。

当前,常见的讨论是把一个预训练好的视觉编码器、音频编码器,用“胶水”接到 LLM 头上,让语言模型学会“看图说话”“听音答题”。

这种架构本质上是一种松耦合的“模块堆叠+任务微调”,更像是多个专才模型的拼盘组合,而非一个从底层就深度融合、跨模态通透理解的“通才 AI”。视觉模块干视觉的,语言模块干语言的,各自为政,缺乏真正的知识融合与迁移。

换句话说,现有大多数 MLLM 都是基于 LLM 构建出来的“语言智能驱动的多模态拼盘”,而非真正意义上的原生多模态智能。虽然能在多个模态任务上拿到不错的单项成绩,但它们无法像人类一样在视觉、语言、听觉等不同模态之间实现举一反三、类比推理。

也正因如此,当前许多 MLLM 看似全能,实则只是表面的“伪通才”,距离真正的人类级通用智能(AGI)还有很远的距离。

然而,要实现类似人类的通用智能(AGI),模型必须像人一样融会贯通各领域知识,在不同模态和任务间举一反三。

当前 AI 研究的一个共识是:更高的任务成绩并不直接等于更强的智能。真正重要的是模型在各模态/任务间的“协同效应”:即从一种技能或模态中学得的知识能否举一反三,用于提升另一种技能或模态的表现。

例如,一个真正通用的 AI 如果能看懂一幅画,那么当把同样的信息改用文字描述时它也应该懂;反之亦然。这种跨任务、跨模态的一致表现,才是逼近通用智能的关键指标。

这就好比,在多模态领域上实现了 GPT 对语言模态的(几乎)完全的泛化推理能力。Multimodal Generalist(多模态通才)正是未来 AI 的发展方向。

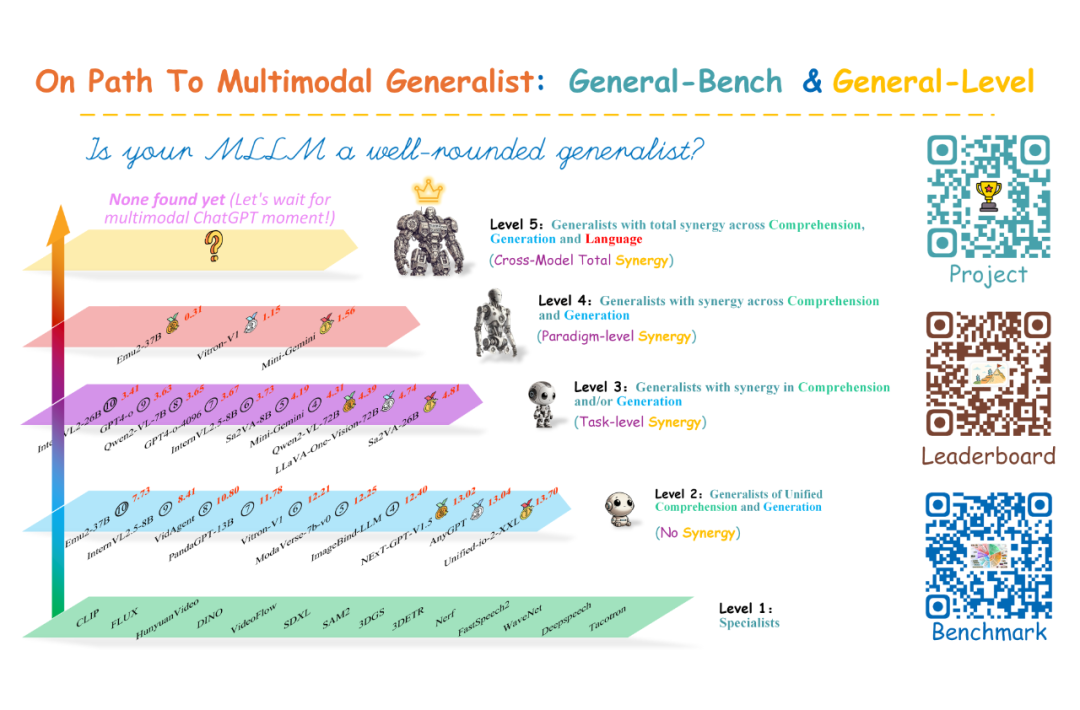

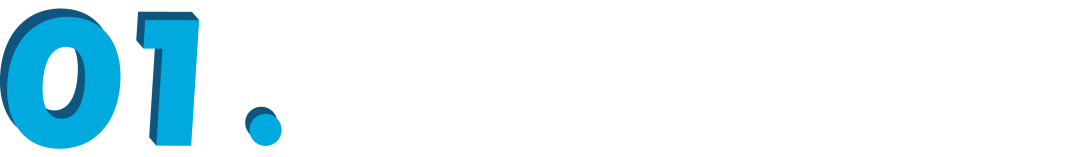

围绕这一理念,最近,来自新加坡国立大学和南洋理工大学所领衔的研究团队在一项大规模的研究论文中提出了 “General-Level” 能力评估框架和 “General-Bench” 基准测试集。

该框架旨在系统性衡量多模态模型从专业单项选手进化为全能通才的进展,为实现任务、模态、范式的统一指明一条可行的道路。

论文标题:

On Path to Multimodal Generalist: General-Level and General-Bench

录用位置:

ICML’25 Spotlight

论文地址:

https://arxiv.org/abs/2505.04620

项目主页:

https://generalist.top/

Leaderboard:

https://generalist.top/leaderboard

Benchmark:

https://huggingface.co/General-Level

Huggingface Paper:

https://huggingface.co/papers/2505.04620

General-Level 五级能力体系:协同泛化效应才是评估核心

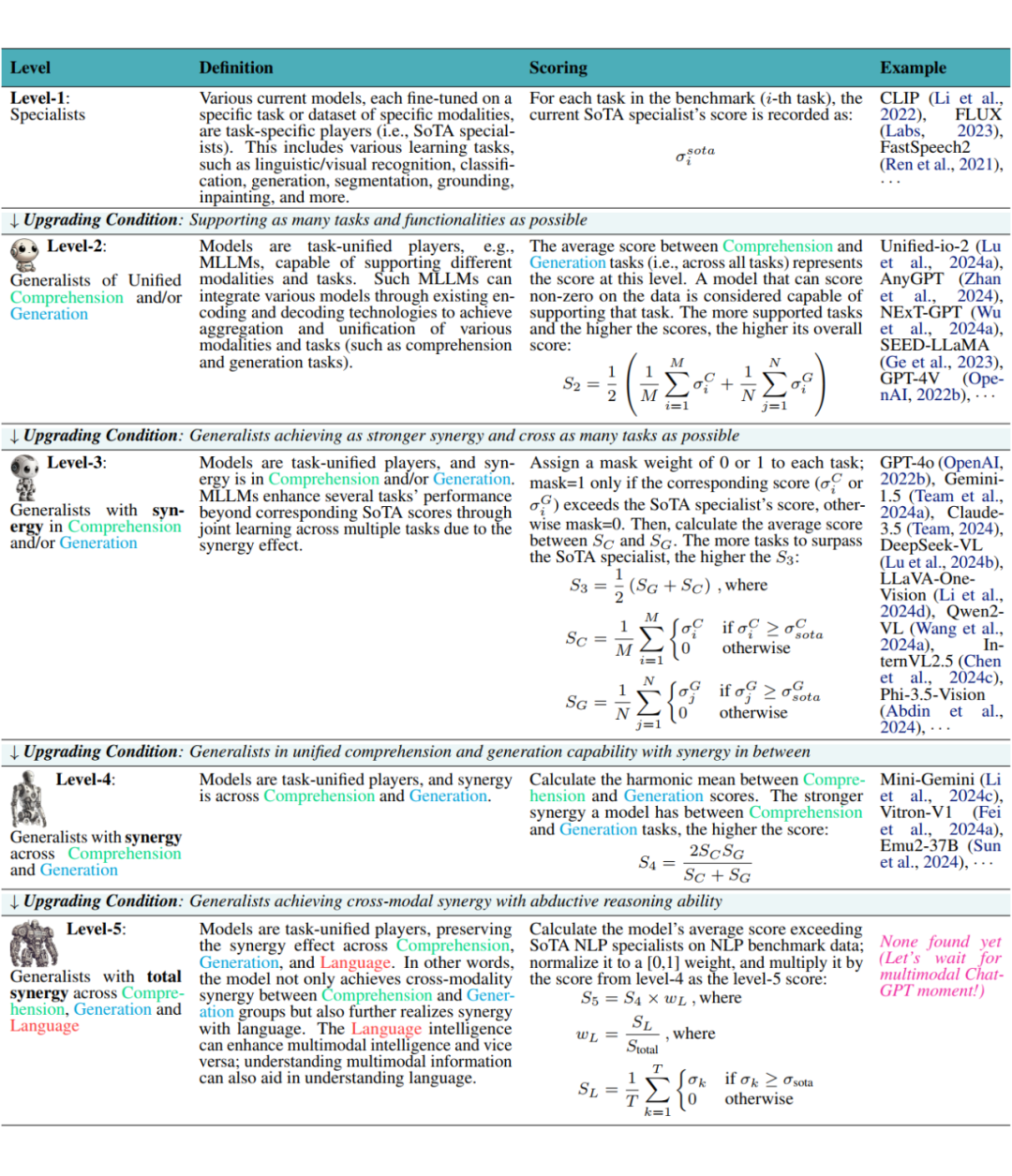

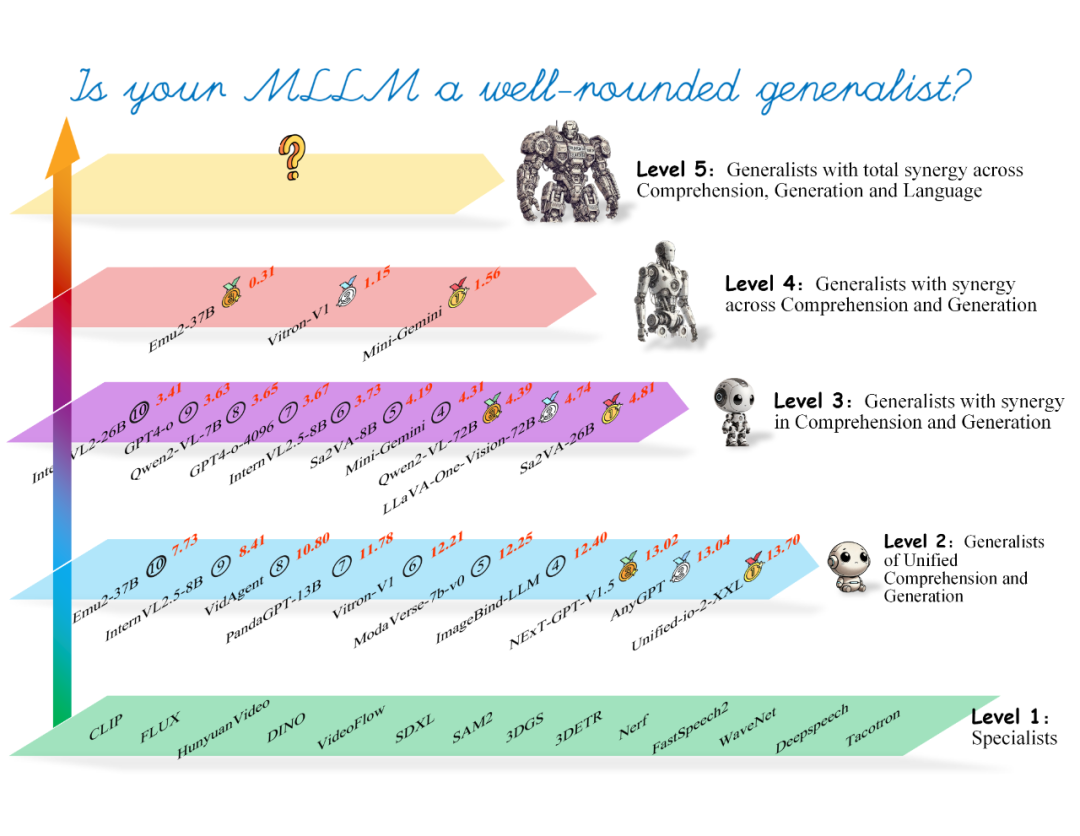

为评估多模态通才模型的智能水平,作者借鉴了自动驾驶技术分级的思路,构建了一个五级能力体系 General-Level。General-Level 将当前多模态模型按能力划分为五个等级,每提升一个等级都意味着模型在协同能力上取得了新的突破。

这个体系以“协同泛化效应(synergy)”为核心评估标准,也就是模型是否能在理解与生成两种范式,以及跨多模态的场景中都保持稳定且互相提升的能力。简单来说,协同效应就是让模型实现 1+1>2 的效果:各模态和任务间互相借力,使整体能力超过各部分简单相加。

不同等级的多模态模型具备不同范围的协同能力。从 Level-2 的无协同能力(仅具备基本多任务能力),到 Level-3 实现任务间的协同提升,再到 Level-4 在理解与生成范式间取得协同,最终 Level-5 达成跨模态的全方位协同。

根据 General-Level 框架,研究团队形象地将这五个等级比作“段位”等级,从低到高依次为青铜、白银、黄金、铂金和王者。下面我们逐级介绍各等级的含义:

Level-1 青铜级(单模态专家):模型只在单一任务或单一模态上表现突出,相当于某领域的专业选手,但缺乏多任务能力。例如只会修图的 AI 或只会语音识别的模型都属于此级别。这类模型并非真正的通才,没有任何协同效应可言。

Level-2 白银级(多任务整合,无协同):模型能够支持不同模态和任务的统一处理,相当于具备多才多艺的“多面手”,但各项能力彼此独立。

换言之,这类 MLLM 可以看图说话、回答问题等,但还不会以一种技能提升另一种(没有协同效应)。它们常通过编解码架构将多模态功能简单组合在一起,能力评分取理解类任务和生成类任务的平均值。

Level-3 黄金级(跨任务协同):模型在多个任务上实现了协同增益,即通过联合学习,不仅掌握多种任务,更能够利用学到的知识让某些任务表现超过各该任务单独训练的专业模型(超过单项 SoTA)。

这一等级要求模型出现“任务级协同效应”。例如,模型学会了给图像上色或修图后,反过来让它对黑白照片的识别更加准确(因为生成技能的提升协助了理解能力)。技术上,作者采用了一种掩膜评估方法:统计模型在多少比例的任务上超越了相应的专业模型,将其计入协同得分。

Level-4 铂金级(理解-生成协同):模型在理解(Comprehension)和生成(Generation)两大范式之间达到协同平衡。也就是说,它不仅能看图又能画图,而且两种能力相辅相成、均衡发展。

这被称作“范式级协同效应”。例如,一个模型既能准确描述一部电影的内容,又能续写剧情创作结局,两方面能力相互促进。技术上,作者采用调和平均数来衡量模型理解和生成能力的平衡程度,从而计算 Level-4 的得分。

Level-5 王者级(全模态互促):这是理想中的终极通才水平,要求模型在跨所有模态上都实现协同,并具备更高的推理能力(包括纯语言智能的提升)。通俗地说,模型的多模态技能与语言能力相互增强:视觉、音频等多模态的学习可以提升它的语言理解/生成水平,反过来语言能力又进一步增强多模态表现。

例如,看过大量名画的 AI 诗人能写出更好的诗歌,听过旋律后能用文字描绘出相应意境。这一等级要求模型在纯语言任务上也要超过单模态 NLP 专家的表现。目前没有任何现有模型达到该级别,正如作者所言:“让我们期待多模态版的 ChatGPT 横空出世!”。

值得注意的是,General-Level 体系采用了分层的评分机制:模型会在它所达到的最高非零等级获得归类。

换言之,模型可能在低等级和更高等级上都有一定得分,但最终只认定其最高段位。这种设计就像游戏中的晋级制度——只有在满足了当前等级的升级条件后,模型才能晋升到下一等级。

例如,只有当模型在若干任务上成绩超越单项专家(出现协同增益)时,才算真正迈入 Level-3;只有当模型理解与生成能力均衡且都很强时,才能评为 Level-4;而要登顶 Level-5,则必须在 NLP 纯语言任务上也达到顶尖水准。

通过这种层层递进的评价体系,General-Level 为业界提供了一把标尺,来衡量一个多模态模型距离“全能通才”还有多远。

General-Bench 通用基准:700+ 任务覆盖,全方位考验模型

要准确评估模型的“段位”,光有理念还不够,还需要一套全面而严苛的考题。为此,研究团队构建了大规模多模态基准测试集 General-Bench。

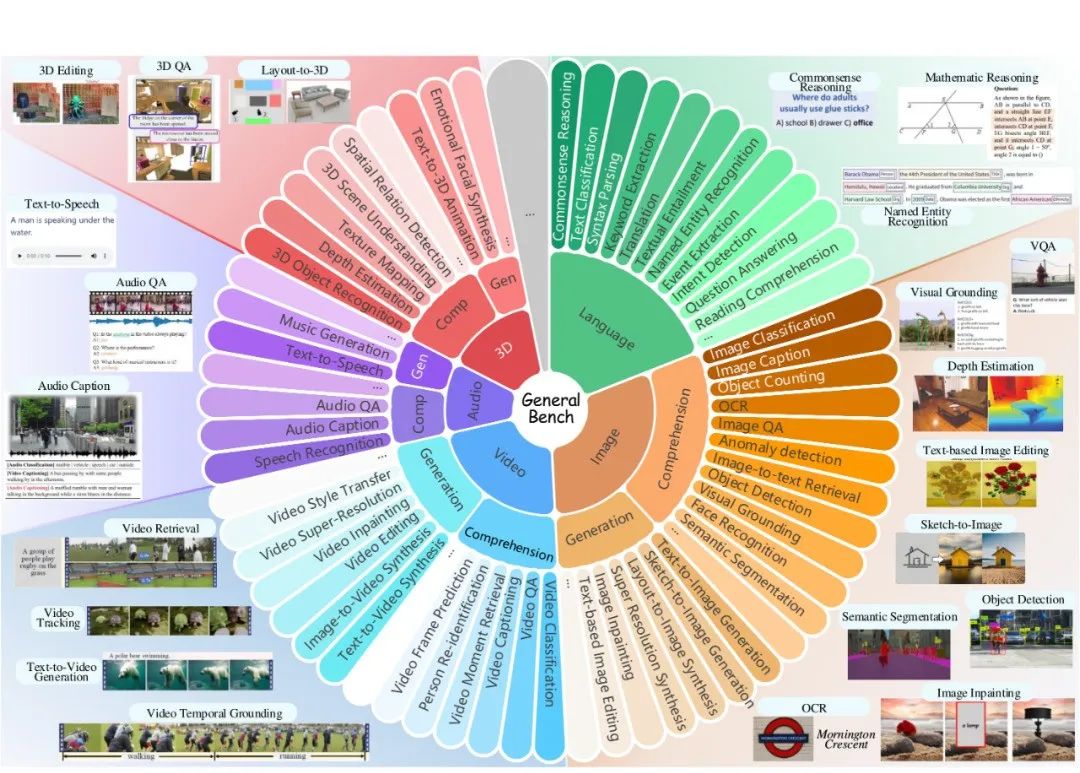

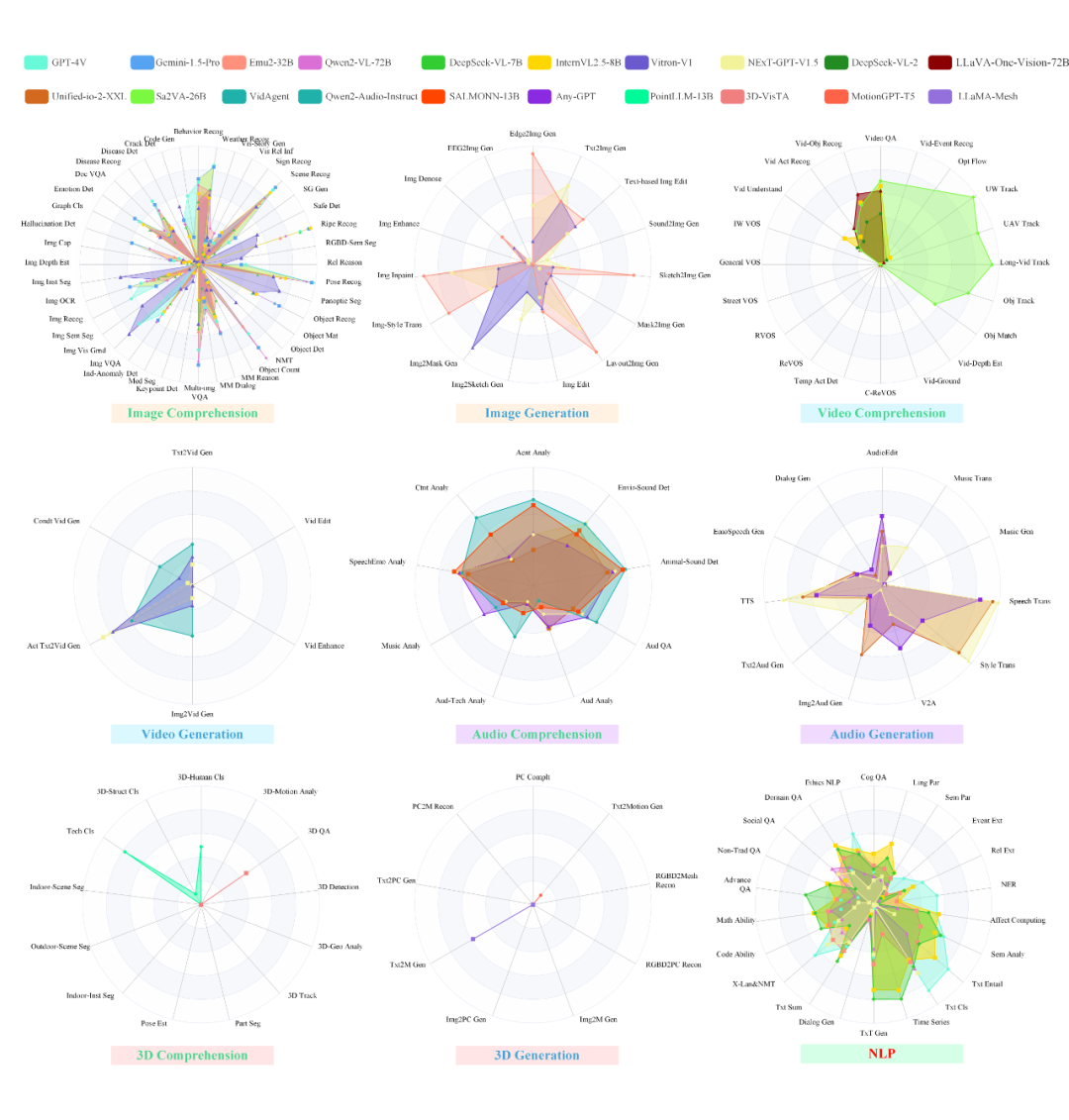

General-Bench 汇集了 700 多种任务,325,000 多个样本,涵盖图像、视频、音频、3D、语言五大模态,及其交叉形式,囊括了 30 多种技能领域的考查。可以说,这是目前覆盖范围最广、难度最大的多模态 AI “综合性考试”之一。

基准涵盖语言(如常识问答、数学推理、阅读理解、代码能力等绿色部分)、图像(分类、检测、字幕、编辑、生成等棕色部分)、视频(检索、时序定位、生成等蓝色部分)、音频(语音识别、音乐生成等紫色部分)以及 3D(三维识别、三维问答、三维生成等红色部分)等领域的大量任务。

为了保证 General-Bench 的广度和质量,作者精心设计了五步构建流程。General-Bench 得到了一套覆盖广(模态全覆盖、任务类型丰富)且精(题目质量高、格式一致)的测试集。与以往的多模态评测相比,General-Bench 有几大创新之处:

-

拒绝选择题:传统基准里许多是多项选择或判断题,而 General-Bench 要求模型自由作答。例如,不再问“这张图片里有几只猫?A.2 只 / B.3 只”,而是给图片直接让模型输出数字。这避免了模型侥幸猜对的情况,更加严格考察生成能力和准确性。

-

加入创作任务:不仅考查模型对多模态内容的理解,还要求模型具备生成创造能力。例如,除了“看图说话”(图像描述)这样的理解类任务,还增加了“看图画画”“听音生成图像”这类跨模态生成题,以及文本续写、图像编辑等创造性任务。这使测试不再局限于被动回答问题,而是主动考验模型的创意和表达。

-

跨模态综合:很多题目涉及多种模态的融合,需要模型综合运用不同模态信息。例如,有些物理常识题配有示意图表,需要同时阅读文字和图表才能回答;历史题可能附带文物的 3D 模型或图像;甚至有“听声音作画”这样跨越听觉与视觉的挑战。这些题型大大超出了单一模态评测的范围,旨在检验模型是否真正做到了模态与模态之间的互相赋能。

此外,General-Bench 按照用途提供了两种版本的数据集:开放集(Open-Set)的题目和答案完全公开,方便研究者自由下载用于非官方测试或模型训练;封闭集(Close-Set)则仅提供题目不公开答案,专用于排行榜评测,参与者需提交模型对这些题目的回答,由官方统一评估得分。

开放集相当于自助练习卷,而封闭集才是计入正式排名的考试卷。这种设置在保证公平性的同时,也鼓励社区广泛使用开放数据进行研究实验。

值得一提的是,General-Bench 还是一个动态开放的项目。作者设计了可扩展的排行榜体系和数据收集机制,允许持续增加新题型、新模态。例如,未来可能纳入代码生成、触觉感知等更新颖的任务。数据集也欢迎社区贡献新的数据。

这种与时俱进的设计,确保 General-Bench 能不断跟进行业前沿,避免快速过时。正如作者在论文中展望的那样:当某天 AI 模型真的通过了“王者段位”的考核,也意味着通用人工智能的曙光已经到来。

技术亮点:协同能力度量与动态排行榜

除了提出新的评估框架和基准数据,本项目在技术细节上也有多项创新亮点,为多模态通才评测树立了新标杆:

协同能力的定义与测量:过去评测多模态模型,通常是看它在各个单项任务上的准确率、得分是否高于现有模型。然而 General-Level 引入了“协同效应”这一全新指标。作者明确定义了协同效应的三种范围,并据此设计了分级的量化方法:

-

任务级协同(Level-3)通过统计模型在哪些任务上超越了对应的单模态 SoTA 模型来衡量;

-

范式级协同(Level-4)通过理解与生成成绩的调和平均来衡量模型两种能力的均衡程度;

-

跨模态总协同(Level-5)则进一步考虑模型在纯语言 NLP 任务上的提升,将其作为权重乘入总体评分。

这种多层次协同评分体系,精确捕捉了“通才”模型所具备的独特优势——即是否真的实现了“1+1>2”的效果。如果模型只是简单堆叠功能而无协同增益,那再多才多艺也只能停留在 Level-2,不会被误评为更高段位。

通过协同效应的度量,General-Level 找到了评估多模态智能的新维度,为今后的模型改进指明了方向。

分层晋级的评分机制:General-Level 框架巧妙地将模型评估转化为类似晋级打怪的过程。每个等级都有清晰的升级条件(如超越专家数目、理解/生成均衡性、语言成绩权重等),模型只有满足当前等级要求才能冲击更高等级。

这种分层机制保证了评分的公平和稳定:模型在低层级的基础能力没打牢之前,不可能因为个别高分项就被拔高评价。

例如,一些视觉问答模型在图像理解上性能卓越,但是在图像生成上几乎为零分,那么它只能停留在白银级,而不会因理解强项而被误评为黄金级。同样,如果一个模型大部分任务表现一般,但极个别任务超过了专家,它也不会立刻获得高段位,除非它在多项任务上广泛出现协同增益。

这种严谨的分层评分避免了简单拼分数排行的弊端,确保了只有真正全面发展的模型才能位居高段。这对引导研究方向也有积极意义:鼓励开发者全面提升模型的平衡能力,而不是为了单点突破而“偏科”。

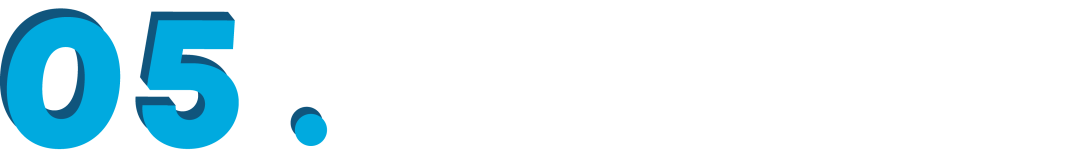

多维度动态排行榜:为了直观展示各模型的段位水平,作者搭建了公开的项目排行榜。与传统排行榜不同的是,General-Level 的排行榜具有动态多层次结构。具体来说,包含:

-

全局总榜(Scope A):覆盖所有模态和任务的综合排行榜,也是最核心的“通才榜”,按照 General-Level 综合得分排名。

-

单模态榜(Scope B):分别就图像、视频、音频、3D、语言五种模态各自列榜,衡量模型在单一模态下的能力高低。比如一个擅长视觉的模型可以在图像榜上名列前茅,但在综合榜不一定领先。

-

范式榜(Scope C):针对理解类任务和生成类任务各自排序。这允许对比模型在感知理解 versus 内容生成两种范式上的相对强项。例如有的模型理解优秀但生成较弱,在理解榜高分而在生成榜落后,从而暴露短板。

-

技能细分榜(Scope D):在每个模态内部进一步按技能类别划分排名。比如图像模态下细分出分类、检测、描述、编辑等能力榜单;音频模态下有语音识别、音频问答等榜单。这样一些部分通才(partial generalist)模型也能找到自己的定位——例如专精于“视觉+文本”的模型可以在图像和语言相关榜上看到自己的水平,而不是淹没在综合榜中。

多层次排行榜的设计,使得评测体系既严格又灵活:一方面,全能模型追逐综合榜桂冠,促进全面发展;另一方面,研究者也可以聚焦某一子榜,专攻提升某方面能力,再逐步向综合通才迈进。

排行榜还通过动态更新的方式,持续接纳新模型的提交。每当有团队在封闭测试集上提交了他们模型的答案,主办方会计算其各项得分并更新排行榜,使社区可以实时了解最新的状态和顶尖模型进展。

欢迎参与 Leaderboard:

https://generalist.top/leaderboard

社区反响:开放合作,共迎“通才”时代

为了方便社区参与,作者提供了完备的在线项目平台和开源资源。项目官网提供了论文、数据、文档和排行榜入口。研究者可以方便地下载开放集数据在自己的模型上试跑,或通过提交封闭集结果来参与官方排名。

排行榜页面直观展示了不同模型在 General-Level 各级别的得分,哪些模型达到了 Level-3、Level-4 一目了然。截至目前,团队已经呈现出了超过 100 多个现有模型在 General-Bench 上的评测排位。

从排行榜结果看,当前绝大多数模型还停留在白银段位(Level-2)以及部分的黄金段位(Level-3),仅具备基础的多任务能力;只有极少数模型(例如 Mini-Gemini 等)达到了铂金段位,而且主要局限在图文领域的协同。尚没有模型能够问鼎王者段位,这也印证了语言智能尚未从多模态融合中显著受益这一挑战。

这样的结果在社区引发了强烈反响。许多研究者惊讶地发现,即使最强大的 GPT4 系列的旗舰模型,在 General-Bench 上也被考得“一身冷汗”:它只答对了约 65% 的图像相关问题,面对视频相关任务更是有大量空白无解。开源的中型模型 Unified-io-2-XXL 在 Level-2上的总和得分竟然比 GPT4-V、GPT4-o 还高。

但整个行业在音频和 3D 任务上表现普遍惨淡——所有模型的音频题平均得分不到 30/100,3D 任务几乎全军覆没,最好的正确率也只有 6.7%。这些发现引发了业内对于多模态模型痛点的感叹:“原来大家的模型还有这么多短板!”。

尤其值得关注的是,General-Level 评测揭示出的三大致命短板:

其一,“偏科”现象严重,大多数模型只擅长视觉问答这类单一任务,一遇到跨模态组合的挑战(如“听音乐画画”或“看视频续写剧本”)就不知所措;

其二,生成能力薄弱,很多模型擅长描述已有内容,但让它创造内容就无从下手——GPT-4 系列可以精准描述《蒙娜丽莎》的细节,却画不出哪怕简单的草图(站在 24 年年底时间节点的评测结论);

其三,协同效应单向,语言智能在帮助图像理解上效果明显,但反过来视觉等模态的学习并没有提升模型的语言表达能力。

这些洞见直接指出了通往多模态通才道路上的艰难挑战,也为下一步的研究指明了发力方向。

整篇来看,《On Path to Multimodal Generalist: General-Level and General-Bench》为多模态大模型迈向“全能通才”树立了重要里程碑。它不仅提供了评估通才 AI 的方法论框架和数据基准,更引发了业界对多模态智能本质的重新思考。

展望未来,作者也提出了让多模态模型实现“通感”学习的一些设想,例如改进模型架构实现深度融合、丰富测试内容引入更多模态、新颖的训练策略模仿人类跨感官认知等。

可以预见,在 General-Level 指标和 General-Bench 基准的推动下,AI 研究社区将加速探索让模型在任意模态、任意任务上相互协作的通用智能方案。当未来某一天,我们真正迎来“多模态版的 ChatGPT 时刻”——也就是模型达到了 General-Level 的王者级别 —— 那将标志着通用人工智能的时代正大步走来。

(文:PaperWeekly)