Datawhale干货

干货作者:ALme,编辑:青稞AI

原文链接:https://zhuanlan.zhihu.com/p/1916994928132751692

断断续续学了大半年的强化学习了,终于有勇气写一个核心总结啦(实在太难理解了),这是这个系列第一篇,尝试对RL for LLM进行从最高层次出发且通俗易懂的总结,希望能让RL的学习曲线更加平易近人

一. 监督学习范式的固有局限性

大型语言模型的演进,长期以来依赖于标准的监督学习(Supervised Learning)范式,主要体现在预训练(Pretrain)和指令微调(SFT)两个阶段。该范式的核心在于,模型需要依赖人类给出的、从输入到输出的完整监督信号进行学习。

若要仅凭此路径达到通用人工智能(AGI)的高度,必须满足两个近乎理想化的前提条件:

-

• 监督数据的无限性与完备性:数据量级需趋于无穷,且其分布能覆盖所有可能遇到的问题,以确保模型的全知性。 -

• 监督信号的绝对完美性:所有监督数据必须准确无误,不存在任何错误或偏见,以确保模型的正确性。

然而,在现实中,这两点均难以实现。一方面,高质量的人类标注数据已出现“数据瓶颈”,其生产成本高昂且效率有限。另一方面,人类知识本身存在边界(如许多科学未解之谜),且在标注过程中不可避免地会引入错误和主观偏见。

因此,探索一种能够突破上述局限性的新扩展方法(scaling method)势在必行。这种新方法需要满足:

-

• 数据能够以更高效、低成本的方式进行规模化扩展。 -

• 对监督信号的依赖可以放宽,不再要求“专家级别”的完美答案。

强化学习(RL)为此提供了可能的解决方案。

二. RL:应对挑战的新范式

RL之所以被视为LLM持续进化的关键,源于其两个显著特征:

-

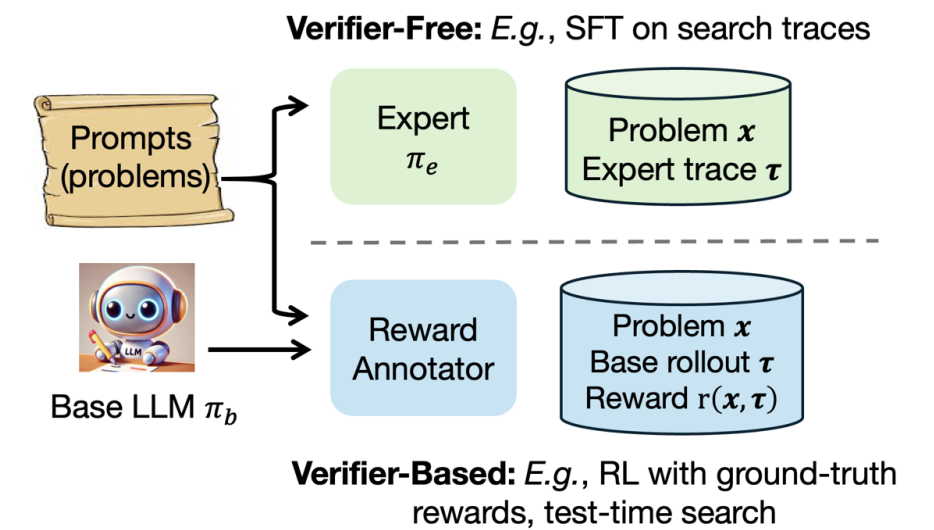

• 数据由模型与环境交互自发生成:这从根本上解决了数据来源的限制,为模型的持续学习提供了近乎无限的原材料。 -

• 监督信息从“生成式”退化为“验证式”:RL的核心是奖励信号(reward),它不要求监督者提供完美的“专家答案”,而只需对模型生成的答案进行有效性或质量的“验证”。基于“验证答案的难度远低于生成答案”这一基本事实[1],RL大幅降低了对监督信息质量和标注难度的要求

三. RL的简洁定义与核心机制

为更清晰地理解RL,我们可以从它与监督学习的联系入手。

监督学习(SFT)的损失函数可以表达为:

其中, 是提示(prompt), 是模型的生成内容, 是代表人类专家答案的真实分布, 是模型的输出策略分布。其目标是最小化模型分布与专家分布之间的差异。

RL的损失函数则可视为一种加权监督学习:

核心区别在于

-

• 引入了权重项 -

• 代表人类专家答案的真实分布被替换为模型自己的输出策略分布

可能有人想说,既然只是加权的监督学习,那RL有什么特别的呢?

四. RL与普通加权监督学习的本质区别

RL的特殊性在于其权重 的设计以及训练数据的来源,这使其区别于旨在调整样本重要性的传统加权学习:

权重可为负值,实现“趋利避害”:传统加权学习的权重通常为非负,用于强调重要样本。而RL中的权重可以为负。负权重指导模型“避免”生成特定的行为,而不仅仅是“模仿”期望的行为。这种“惩罚”机制是模型能够快速抛弃失败策略、探索未知但可能更优策略空间(Exploration)的关键[2][3],也是其能力超越训练数据限制的根本原因。

数据来源与权重结合,形成自洽的优化闭环:RL用于学习的数据由模型自身生成。这一特点与上述的奖惩机制相结合,形成了一个强大的自优化循环:模型生成行为 -> 获得带有正或负权重的反馈 -> 调整策略以增加高权重行为、减少低权重行为 -> 生成更高质量的新行为。通过这一循环,只要权重(以及背后的reward)设计得当,模型便有潜力实现持续的自我迭代与能力攀升,最终达到超越人类的性能水平。

五. RL for LLM的核心研究问题

在上述框架下,当前RL for LLM的研究主要围绕以下几个核心问题展开:

如何从“用于验证的弱监督信号(reward)”推导出每个样本的权重 ? 例如,ReST[4]方法中的0-1过滤、PPO[5]中学习的价值函数(value function),以及DeepSeek GRPO[6]中从批次数据中估计的优势函数(advantage function),都是对该问题的不同解法。

承接上一点,如何高效、准确地获取“用于验证的弱监督信号(reward)”? 从RLHF可学习的reward model[7],到DeepSeek的rule-based reward,都是在解决这个问题

RL的两个核心步骤 ——a.基于加权监督学习的模型更新 与 b.新样本的生成——二者的交互节奏是怎样的? 是生成一个样本就更新一次(完全在线),还是生成N个样本后更新一次或N次?先前批次生成的样本在后续迭代中是否应该被舍弃(on-policy vs. off-policy的权衡)?PPO/GRPO算法中的修正比值、clip参数、生成批次大小、更新的epoch数目等,都与这个核心节奏问题紧密相关。

RL训练应选择怎样的提示(prompt)分布 p(x)? 以数学问题为例,如何设计一个问题序列(课程),才能最大化模型的学习效率?[8]

进行RL训练前,基础模型(base model)需要具备哪些先决能力,才能有效支撑后续的强化学习过程?[9]

以上几点构成了当前RL for LLM研究的基本蓝图。对这些问题的不断探索和解答,将持续推动大型语言模型向着更高级的智能形态迈进。这一篇的总结暂告一段落,后续的文章将进行更深入的探讨。

欢迎大家留言讨论!

参考

[1]All Roads Lead to Likelihood: The Value of Reinforcement Learning in Fine-Tuning

https://arxiv.org/abs/2503.01067

[2]e3: Learning to Explore Enables Extrapolation of Test-Time Compute for LLMs

https://arxiv.org/pdf/2506.09026

[3]Preference Fine-Tuning of LLMs Should Leverage Suboptimal, On-Policy Data

https://arxiv.org/abs/2404.14367

[4]Reinforced Self-Training (ReST) for Language Modeling

https://arxiv.org/abs/2308.08998

[5]Proximal Policy Optimization Algorithms

https://arxiv.org/abs/1707.06347

[6]DeepSeekMath: Pushing the Limits of Mathematical Reasoning in Open Language Models

https://arxiv.org/abs/2402.03300

[7]Training language models to follow instructions with human feedback

https://arxiv.org/abs/2203.02155

[8]SPEED-RL: Faster Training of Reasoning Models via Online Curriculum Learning

https://arxiv.org/abs/2506.09016

[9]Scaling Test-Time Compute Without Verification or RL is Suboptimal

https://arxiv.org/abs/2502.12118

(文:Datawhale)