项目简介

架构

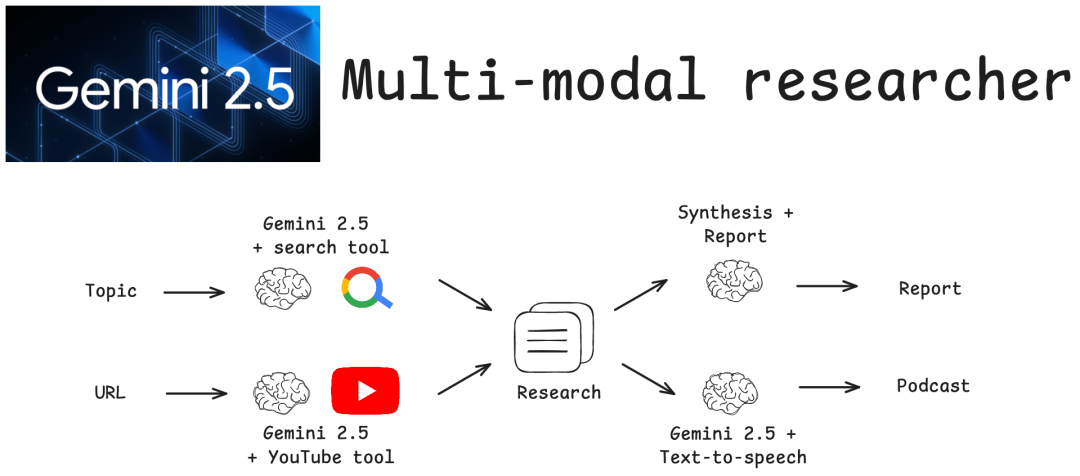

该系统实现了一个 LangGraph 工作流,包含以下节点:

-

搜索研究节点:使用 Gemini 的 Google 搜索集成执行网络搜索 -

分析视频节点:在提供时分析 YouTube 视频(有条件) -

创建报告节点:将研究发现综合为一份全面的 markdown 报告 -

创建播客节点:生成一个双主持人的播客讨论,配有 TTS 音频

工作流

START → search_research → [analyze_video?] → create_report → create_podcast → END工作流在提供 YouTube URL 时会条件性地包含视频分析,否则将直接进行报告生成。

输出

系统生成:

-

研究报告:包含执行摘要和来源的全面 markdown 报告 -

播客脚本:Sarah 博士(专家)和 Mike(采访者)之间的自然对话 -

音频文件:多说话人语音合成音频文件( research_podcast_*.wav)

快速入门

前置条件

-

Python 3.11+ -

uv package manager uv 包管理器 -

Google Gemini API key

安装

-

克隆并导航到项目:

git clone https://github.com/langchain-ai/multi-modal-researchercd mutli-modal-researcher

cp .env.example .env编辑 .env 并添加您的 Google Gemini API 密钥:

# Install uv package managercurl -LsSf https://astral.sh/uv/install.sh | sh# Install dependencies and start the LangGraph serveruvx --refresh --from "langgraph-cli[inmem]" --with-editable . --python 3.11 langgraph dev --allow-blocking

LangGraph 将在您的浏览器中打开。

╦ ┌─┐┌┐┌┌─┐╔═╗┬─┐┌─┐┌─┐┬ ┬║ ├─┤││││ ┬║ ╦├┬┘├─┤├─┘├─┤╩═╝┴ ┴┘└┘└─┘╚═╝┴└─┴ ┴┴ ┴ ┴- 🚀 API: http://127.0.0.1:2024- 🎨 Studio UI: https://smith.langchain.com/studio/?baseUrl=http://127.0.0.1:2024- 📚 API Docs: http://127.0.0.1:2024/docs

topic ,可选地传递一个 video_url 。-

topic :给我概述一下 LLMs 像是一种新型操作系统的想法。 -

video_url :https://youtu.be/LCEmiRjPEtQ?si=raeMN2Roy5pESNG2

项目地址

https://github.com/langchain-ai/multi-modal-researcher

扫码加入技术交流群,备注「开发语言-城市-昵称」

(文:GitHubStore)