AIxiv专栏是机器之心发布学术、技术内容的栏目。过去数年,机器之心AIxiv专栏接收报道了2000多篇内容,覆盖全球各大高校与企业的顶级实验室,有效促进了学术交流与传播。如果您有优秀的工作想要分享,欢迎投稿或者联系报道。投稿邮箱:liyazhou@jiqizhixin.com;zhaoyunfeng@jiqizhixin.com

如何让机器人在任务指引和实时观测的基础上规划未来动作,一直是具身智能领域的核心科学问题。然而,这一目标的实现受两大关键挑战制约:

-

模态对齐:需在语言、视觉和动作等多模态空间中建立精确的对齐机制。

-

数据稀缺:缺乏规模化、多模态且具备动作标签的数据集。

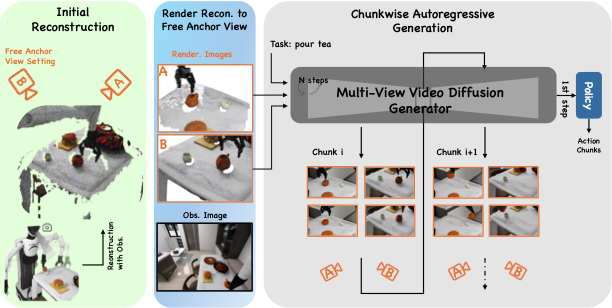

针对上述难题,智元机器人团队提出了 EnerVerse 架构,通过自回归扩散模型(autoregressive diffusion),在生成未来具身空间的同时引导机器人完成复杂任务。不同于现有方法简单应用视频生成模型,EnerVerse 深度结合具身任务需求,创新性地引入稀疏记忆机制(Sparse Memory)与自由锚定视角(Free Anchor View, FAV),在提升 4D 生成能力的同时,实现了动作规划性能的显著突破。实验结果表明,EnerVerse 不仅具备卓越的未来空间生成能力,更在机器人动作规划任务中实现了当前最优(SOTA)表现。

-

主页地址:https://sites.google.com/view/enerverse/home

-

论文地址:https://arxiv.org/abs/2501.01895

机器人动作规划的核心在于基于实时观测和任务指令,预测并完成一系列复杂的未来操作。然而,现有方法在应对复杂具身任务时存在如下局限:

-

通用模型局限性:当前通用视频生成模型缺乏对具身场景的针对性优化,无法适应具身任务中的特殊需求。

-

视觉记忆泛化能力不足:现有方法依赖稠密连续的视觉记忆,容易导致生成长程任务序列时逻辑不连贯,动作预测性能下降。

为此,EnerVerse 通过逐块生成的自回归扩散框架,结合创新的稀疏记忆机制与自由锚定视角(FAV)方法,解决了上述瓶颈问题。

逐块扩散生成:Next Chunk Diffusion

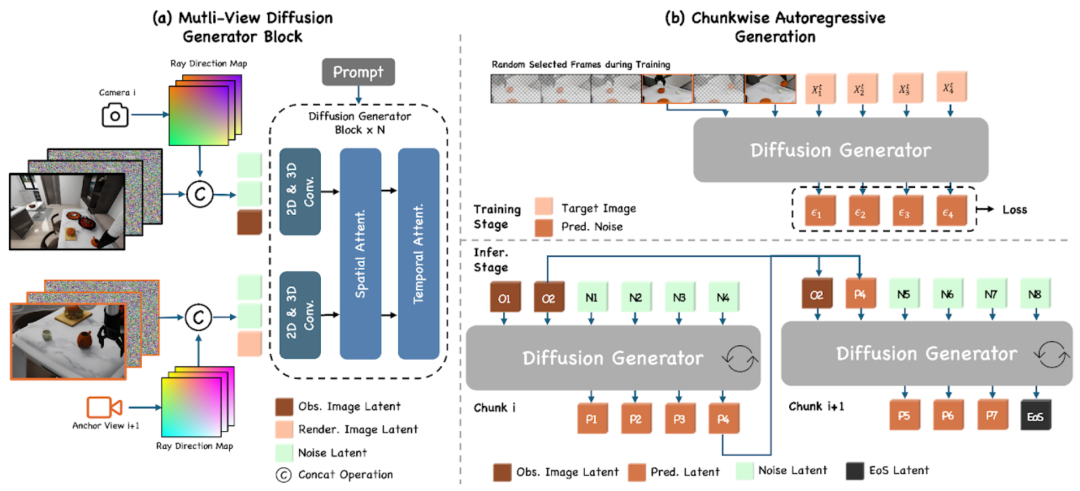

EnerVerse 采用逐块生成的自回归扩散模型,通过逐步生成未来具身空间来引导机器人动作规划。其关键设计包括:

-

扩散模型架构:基于结合时空注意力的 UNet 结构,每个空间块内部通过卷积与双向注意力建模;块与块之间通过单向因果逻辑(causal logic)保持时间一致性,从而确保生成序列的逻辑合理性。

-

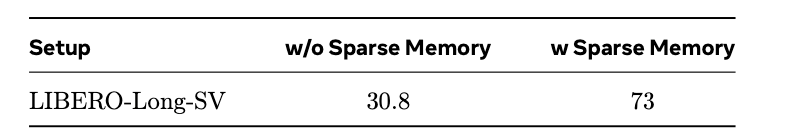

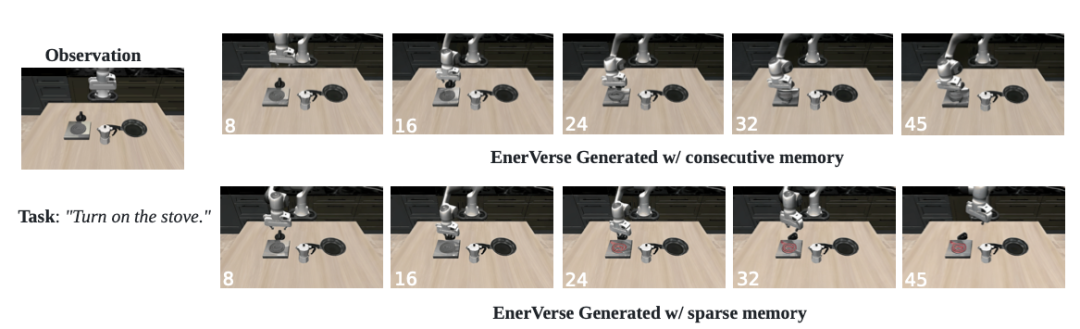

稀疏记忆机制:借鉴大语言模型(LLM)的上下文记忆,EnerVerse 在训练阶段对历史帧进行高比例随机掩码(mask),推理阶段以较大时间间隔更新记忆队列,有效降低计算开销,同时显著提升长程任务的生成能力。

-

任务结束逻辑:通过特殊的结束帧(EOS frame),实现对任务结束时机的精准监督,确保生成过程在合适节点终止。

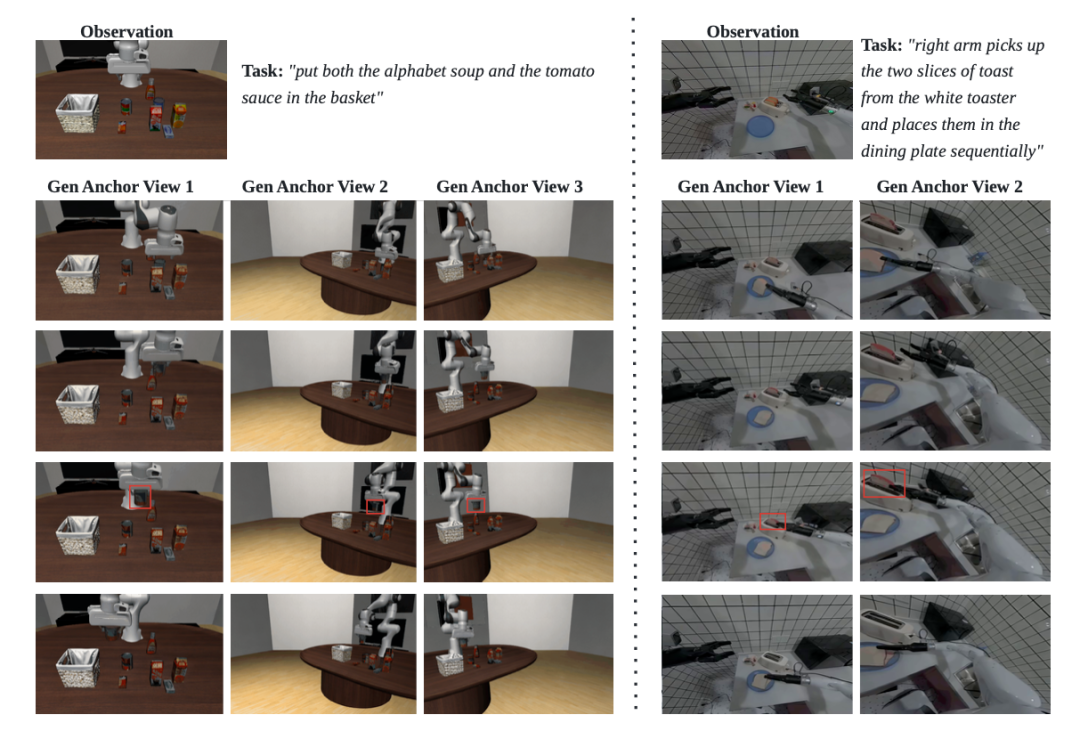

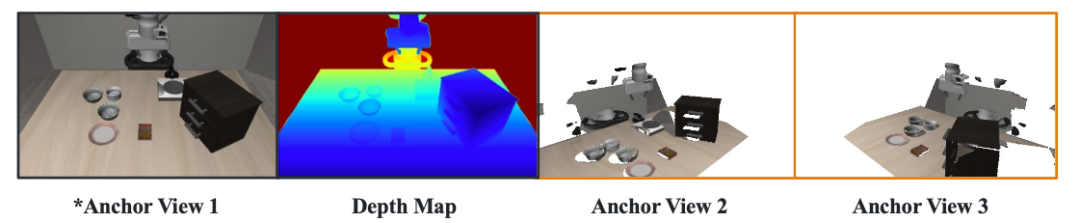

灵活的 4D 生成:Free Anchor View (FAV)

针对具身操作中复杂遮挡环境和多视角需求,EnerVerse 提出了自由锚定视角(FAV)方法,以灵活表达 4D 空间。其核心优势包括:

-

自由设定视角:FAV 支持动态调整锚定视角,克服固定多视角(fixed multi-anchor view)在狭窄场景中的局限性。例如,在厨房等场景中,FAV 可轻松适应动态遮挡关系。

-

跨视角空间一致性:基于光线投射原理(ray casting),EnerVerse 通过视线方向图(ray direction map)作为视角控制条件,并将 2D 空间注意力扩展为跨视角的 3D 空间注意力(cross-view spatial attention),确保生成视频的几何一致性。

-

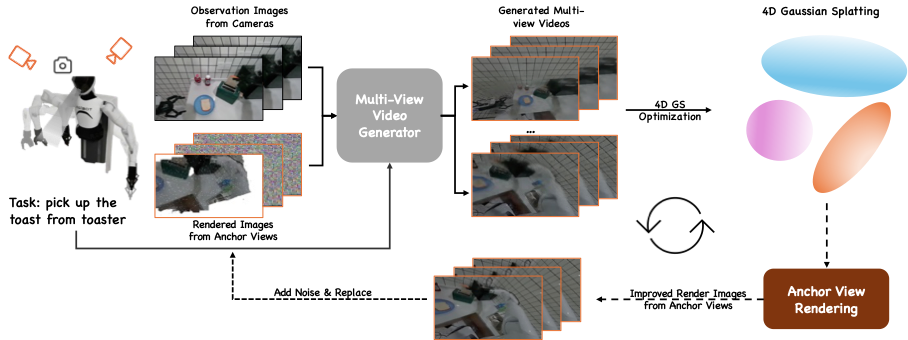

Sim2Real 适配:通过在仿真数据上训练的 4D 生成模型(EnerVerse-D)与 4D 高斯泼溅 (4D Gaussian Splatting) 交替迭代,EnerVerse 构建了一个数据飞轮,为真实场景下的 FAV 生成提供伪真值支持。

高效动作规划:Diffusion Policy Head

EnerVerse 通过在生成网络下游集成 Diffusion 策略头(Diffusion Policy Head),打通未来空间生成与机器人动作规划的全链条。其关键设计包括:

-

高效动作预测:生成网络在逆扩散的第一步即可输出未来动作序列,无需等待完整的空间生成过程,确保动作预测的实时性。

-

稀疏记忆支持:在动作预测推理中,稀疏记忆队列存储真实或重建的 FAV 观测结果,有效提升长程任务规划能力。

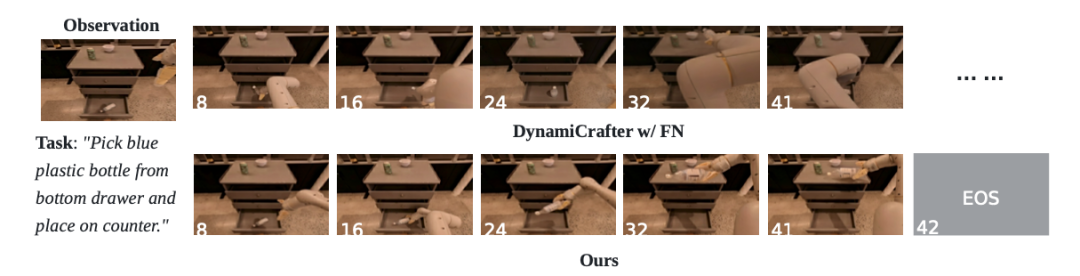

在短程与长程任务视频生成中,EnerVerse 均展现出卓越的性能:

-

在短程生成任务中,EnerVerse 表现优于现有微调视频生成模型,如基于 DynamiCrafter 与 FreeNoise 的扩散模型。

-

在长程生成任务中,EnerVerse 展现出更强的逻辑一致性与连续生成能力,这是现有模型无法实现的。

此外,EnerVerse 在 LIBERO 仿真场景和 AgiBot World 真实场景中生成的多视角视频质量也得到了充分验证。

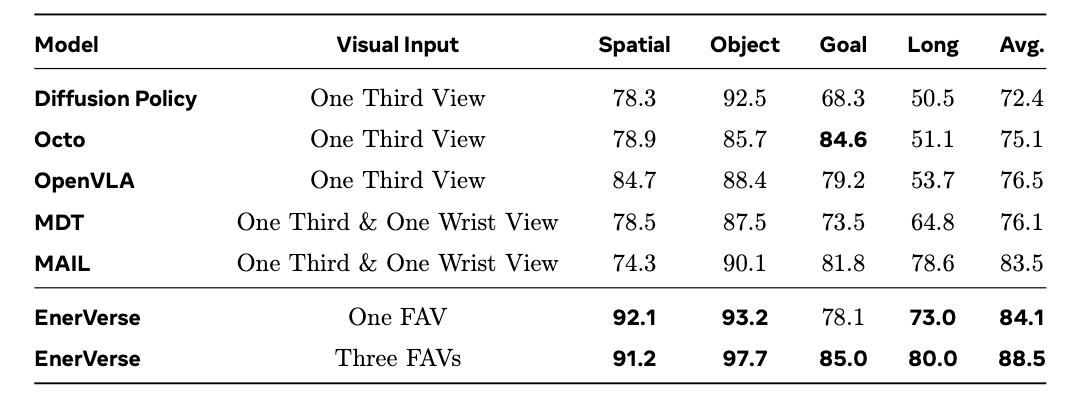

在 LIBERO 基准测试中,EnerVerse 在机器人动作规划任务中取得显著优势:

-

单视角(one FAV)设定:EnerVerse 在 LIBERO 四类任务中的平均成功率已超过现有方法。

-

多视角(three FAV)设定:进一步提升任务成功率,在每一类任务上均超越当前最佳方法。

值得注意的是,LIBERO-Long上均为需要机器多步执行的任务,如下视频所示:

稀疏记忆机制:消融实验表明,稀疏记忆对长程序列生成的逻辑合理性及长程动作预测精度至关重要。

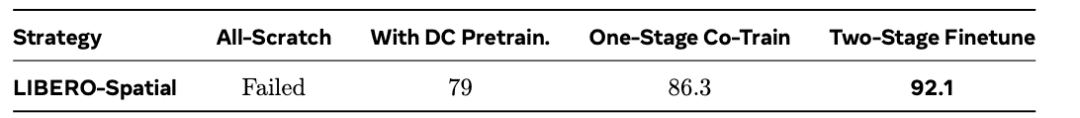

二阶段训练策略:先进行未来空间生成训练,再进行动作预测训练的二阶段策略,可显著提升动作规划性能。

通过可视化 Diffusion 策略头中的交叉注意力模块,研究发现 EnerVerse 生成的未来空间与预测的动作空间具有较强的时序一致性。这直观体现了 EnerVerse 在未来空间生成与动作规划任务中的相关性与优势。

智元机器人通过 EnerVerse 架构开创了未来具身智能的新方向。通过未来空间生成引导动作规划,EnerVerse 不仅突破了机器人任务规划的技术瓶颈,还为多模态、长程任务的研究提供了全新范式。

EnerVerse 主要科研成员来自智元机器人研究院具身算法团队。论文共同一作黄思渊是上海交通大学与上海人工智能实验室的联培博士生,师从 CUHK-MMLab 的李鸿升教授。博士期间的研究课题为基于多模态大模型的具身智能以及高效智能体的研究。在 CoRL、MM、 IROS、ECCV 等顶级会议上,以第一作者或共同第一作者身份发表多篇论文。另一位共同一作陈立梁是智元机器人的具身算法专家,主要负责具身空间智能与世界模型的研究。

(文:机器之心)