克雷西 发自 凹非寺

量子位 | 公众号 QbitAI

现在,打个游戏都用上Transformer了?!

老黄的DLSS进行了一波大升级,换上了基于Transformer的新大脑。

用上新模型之后,光线重建和超分辨率,效果都变得更细腻了。

而且DLSS 3中的帧生成功能也升级到了DLSS 4多帧生成,一次性就能生成最多3帧画面,把《黑神话:悟空》的帧率拉升到200+。

同时,英伟达还上新了一大批AI渲染技术,像画面渲染中的重要部件——着色器,里面也有了AI的一席之地。

这波也算是给游戏开发者和玩家们送上了一份“新年大礼包”了。

英伟达这样做的目的,当然有给50系显卡带货的成分,但有了这些黑科技,游戏玩家们的体验也确实能有所提升。

“大力水手”全面“换脑”

就像开头说的,被游戏玩家们称为“大力水手”的DLSS,迎来了一次全面更新。

(注:DLSS全称Deep Learning Super Sampling,即深度学习超级采样)

DLSS的核心思想,就是用AI运算来取代一部分的渲染计算,从而在加快画面产生速度的同时提升画质。

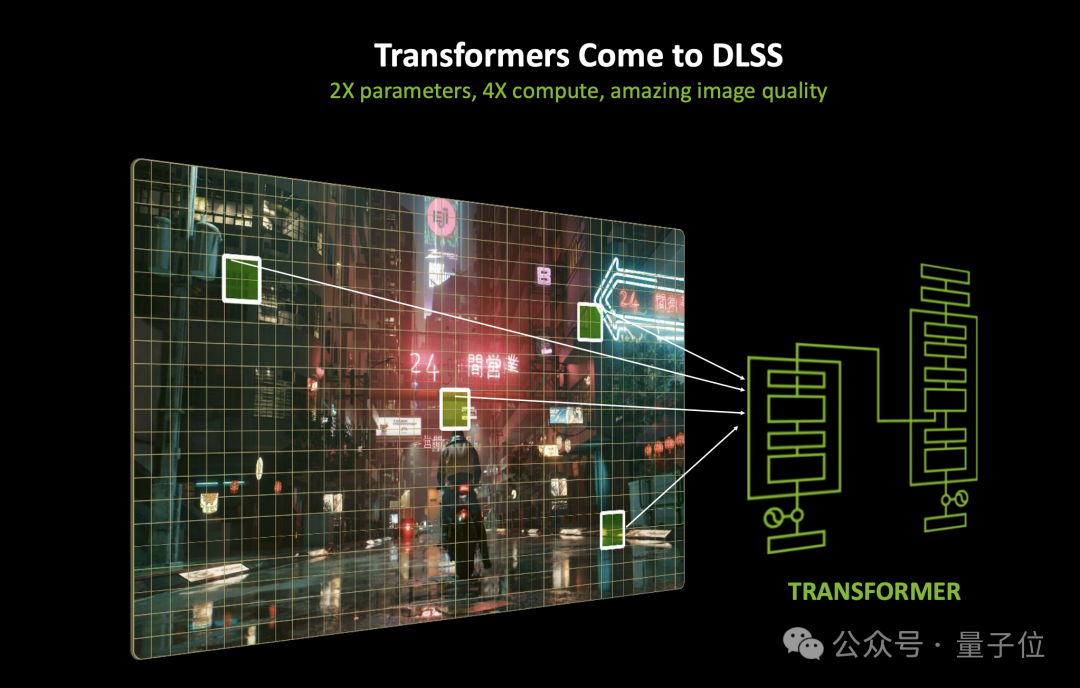

之前的DLSS,主要是通过卷积神经网络(CNN)来实现,现在随着50系显卡的上线,“大力水手”也进行了“换脑”,CNN的工作被Transformer取代了。

据介绍,这是Transformer模型首次在图形领域的实时应用。

相比于过去的CNN,新的Transformer模型拥有两倍的参数量,生成的像素稳定性更强、重影更少,还拥有更高的运动细节以及更平滑的边缘。

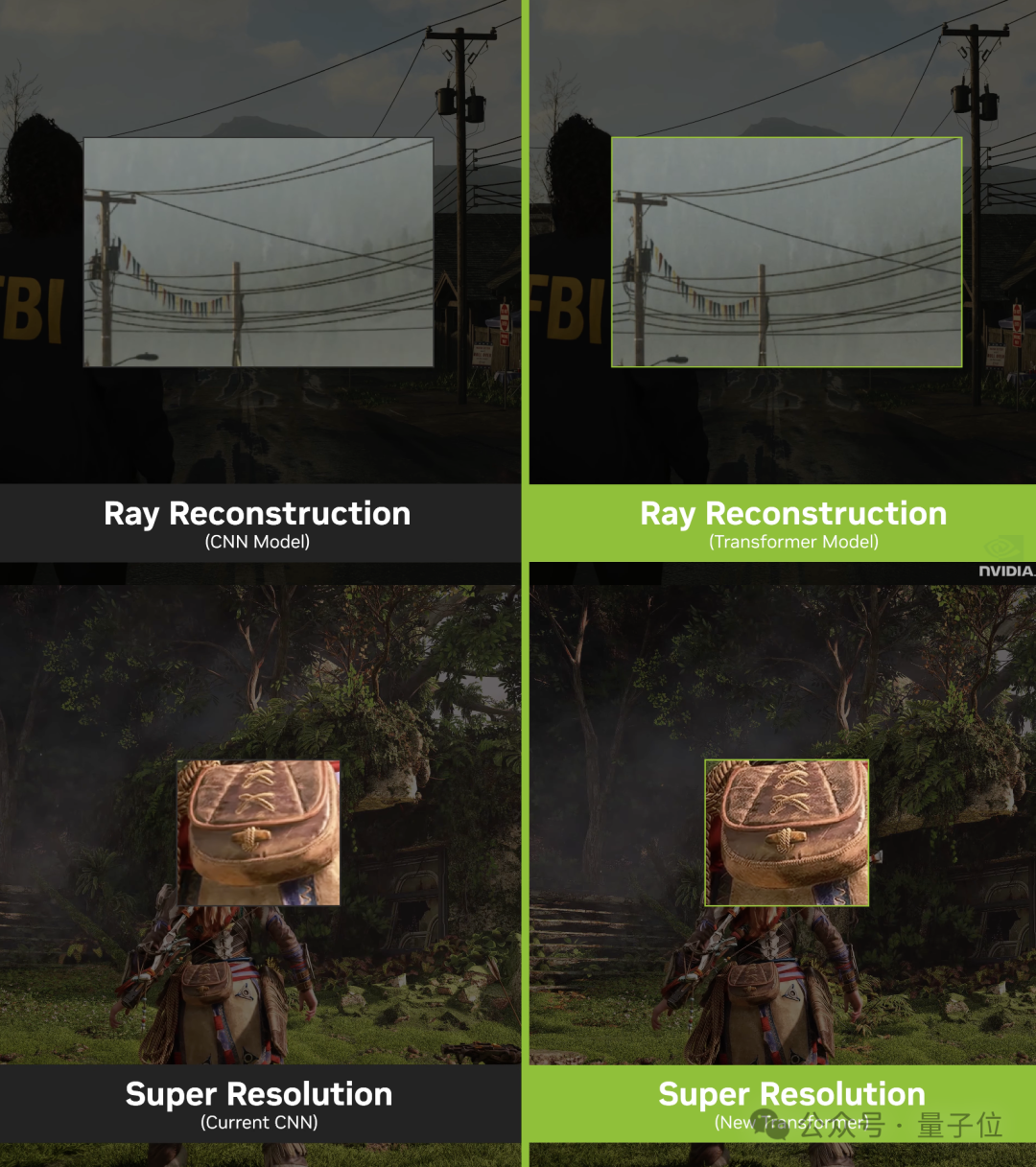

DLSS的两个主要功能——光线重建和超分辨率,都已经用上了Transformer。

比如在《心灵杀手2》的光线重建场景,全新的DLSS4相比于上一代基于CNN的算法,栅栏呈现出的连续性明显更强,两个场景下的光线也更加真实了。

如果感觉变化不明显,可以看下静态画面的对比:

在超分辨率功能当中,画面细节相比之前的CNN也变得更加细腻。

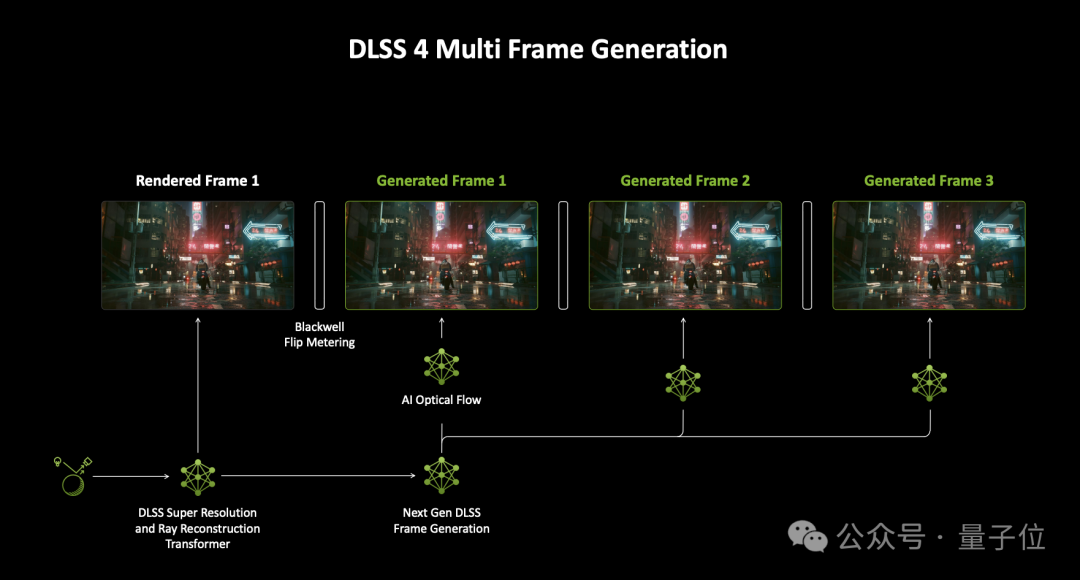

另外新一代的帧生成功能也不再局限于单帧,支持一次生成最多3帧画面。

比如在《赛博朋克2077》的场景中,相比于不开启DLSS,DLSS 4的多帧生成可以在延迟降低超过一半的情况下将帧率从27提升到248,比例将近8倍。

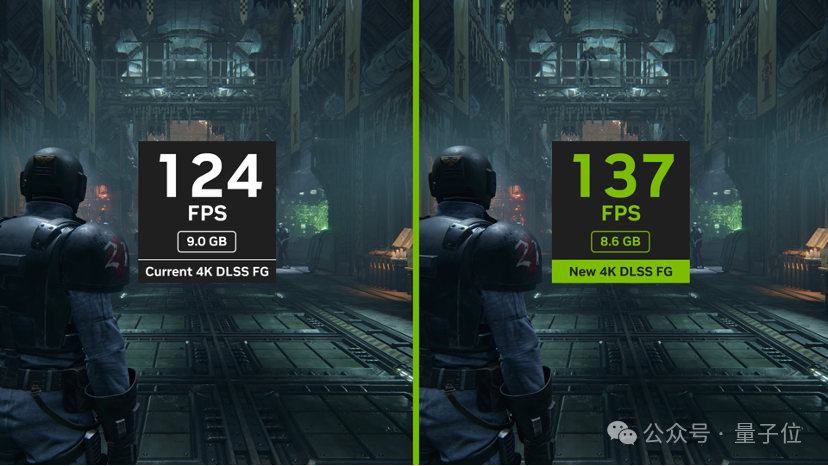

另外,新模型速度提高了40%,使用的VRAM减少了 30%,例如在《战锤40K:暗潮》中,帧速率提高了10%,同时在4K最大设置下减少了400MB显存占用。

另外40系显卡中的帧生成功能也进行了升级,同样是在提高性能的同时减少了VRAM的使用。

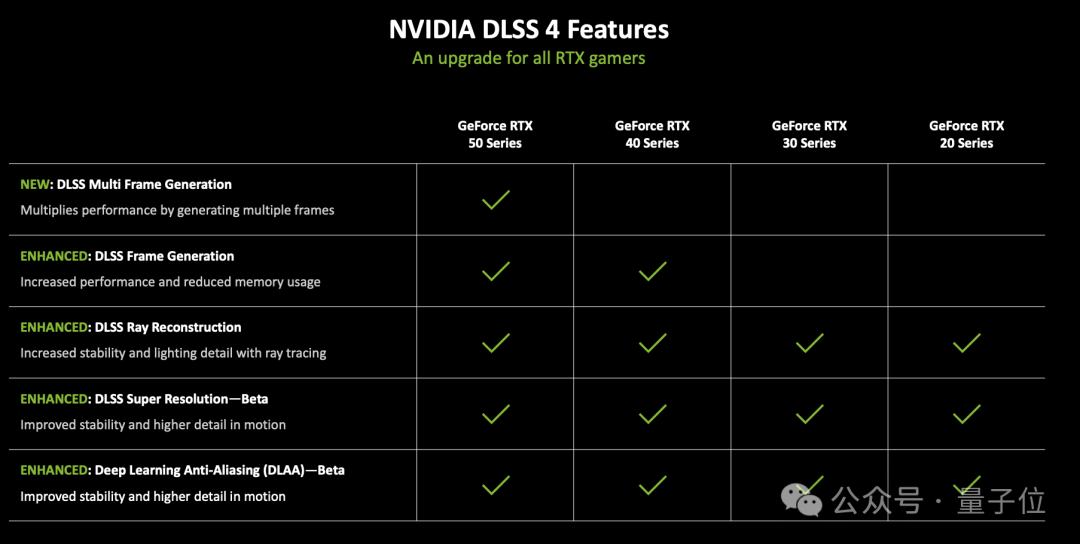

目前DLSS 4已经提供了对75款游戏和应用的Day 0支持,除了多帧生成是50系独占之外,基于Transformer的光线重建、超分辨率等功能同时还可以给40、30甚至20系显卡带来性能提升。

随便剧透一下,《黑神话:悟空》也将在Day-0支持DLSS 4多帧生成。

图形渲染也用上AI了

与新版DLSS一起,英伟达还推出了一套神经渲染技术——NVIDIA RTX Kit。

它可利用GPU中的Tensor Core,通过AI完成游戏中的光线追踪,并渲染具有复杂几何形状的场景,可以用高保真度渲染出复杂的开放世界,同时减少伪影、不稳定性并降低VRAM使用。

首先是RTX神经网络着色器(Neural Shader),它把AI引入到了可编程着色器当中,包含了三大关键技术:

-

神经网络纹理压缩(Neural Texture Compression ):用AI快速压缩纹理,在相同视觉质量下消耗的VRAM或系统内存只有1/7;

-

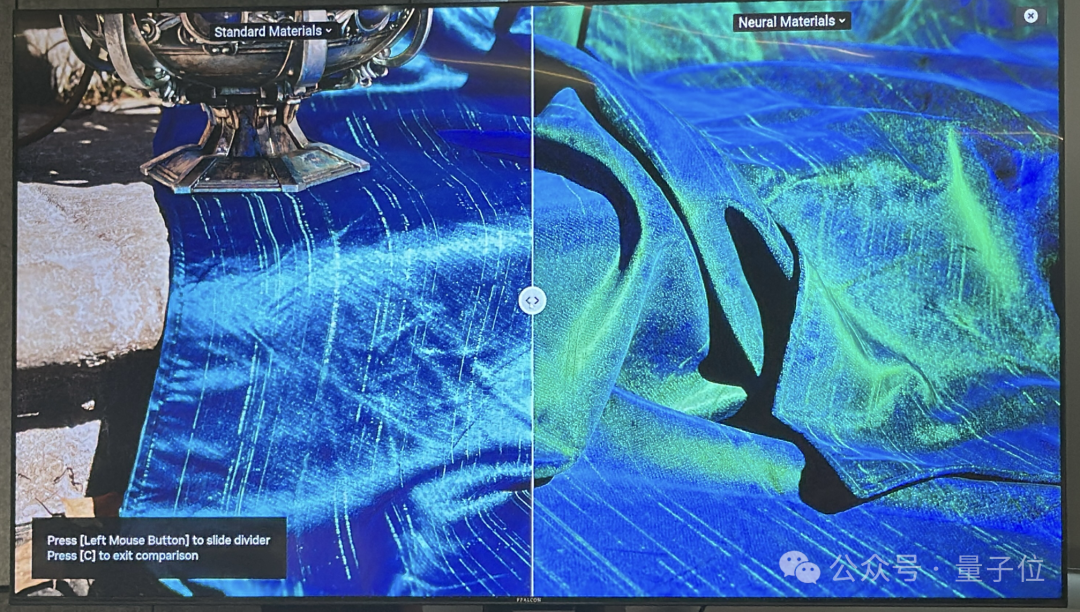

神经网络材质(Neural Materials):用AI压缩复杂着色器代码,材质处理速度提高了5倍,可以以游戏画面的帧速率渲染电影质量的资源;

-

神经网络辐射缓存(Neural Radiance Cache):用AI学习多次反射间接照明,利用最初的一到两次反射即可推断出无限多次的反射,从而提升了路径追踪性能。

来看一组开启Neural Materials前后的效果对比,开启之后(分割线右侧)画面中的材质以及蓝宝石的反光效果都变得更加真实。

还有像这样的丝绸材质,Neural Materials开启后丝绸的光泽被更好地展现,画面也更细腻了。

对比确实很明显,不过对于实时画面渲染来讲,这些还算是洒洒水,真正具有挑战的,是人脸的渲染。

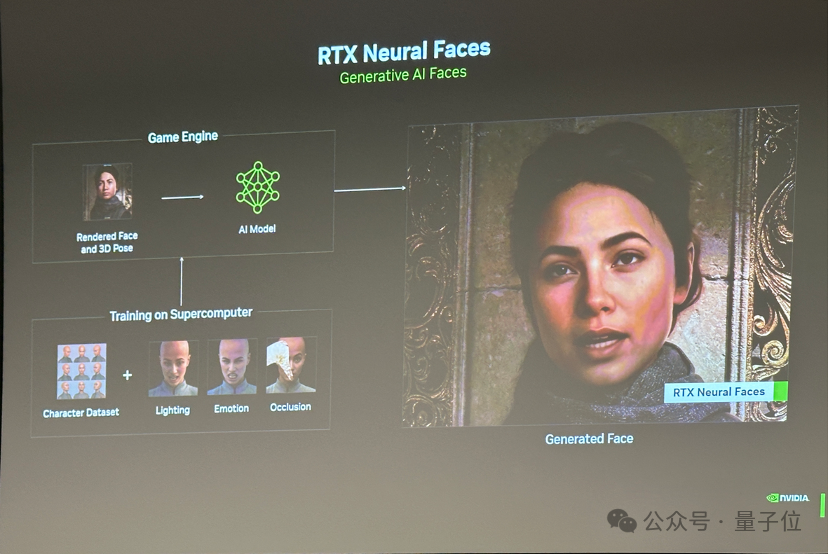

这就涉及到了RTX Kit中的另一个组件——RTX Neural Faces,它利用生成式AI来提高人脸的渲染质量。

Neural Faces采用简单的光栅化脸部加上3D姿势数据作为输入,用AI模型来推断脸部(而不是蛮力渲染)。

Neural Faces背后的训练数据包含了不同的角度、光照、情绪和遮挡条件下的数千个脸部图像,可以创造出更柔和、更自然的外观。

Neural Faces还专门针对皮肤和头发专门设计了补充SDK。

其中应用了次表面散射(SSS)技术,可以模拟光线穿透半透明材料表面并在内部散射的过程,从而更好地呈现皮肤质感。

还有线性扫描球体(LSS)加速基元,可以减少渲染头发所需的几何体数量,并使用球体代替三角形来更准确地适应头发形状。

用英伟达的话说,Neural Faces这项技术“跨越了人像渲染的恐怖谷”。

还有针对三角形光线追踪的RTX Mega Geometry。

在游戏当中,三角形是构成画面的重要元素,其数量也随时间呈现出指数级增长,特别是虚幻引擎5推出新的几何系统以来,游戏中的三角形数量已经数以亿计。

这对于帧画面的构建而言是一大噩梦,想要保持足够的帧速率更是难上加难。

Mega Geometry可以在GPU上批量智能更新三角形簇,从而减少CPU开销并提高光线追踪场景中的性能和图像质量,可处理的三角形数量是之前的100倍。

据英伟达介绍,Mega Geometry可以“对项目中的每个三角形进行完全光线追踪”。

眼见为实,一开始分割线左侧的藤蔓未开启Mega Geometry,非常没有立体感,景深关系不对,光影也不符合物理规律,看上去就是一个字——假。

但开启之后,藤蔓的立体感一下子就增强了,并且光影也更加真实,“贴图感”消失了一大半。

Two More Things

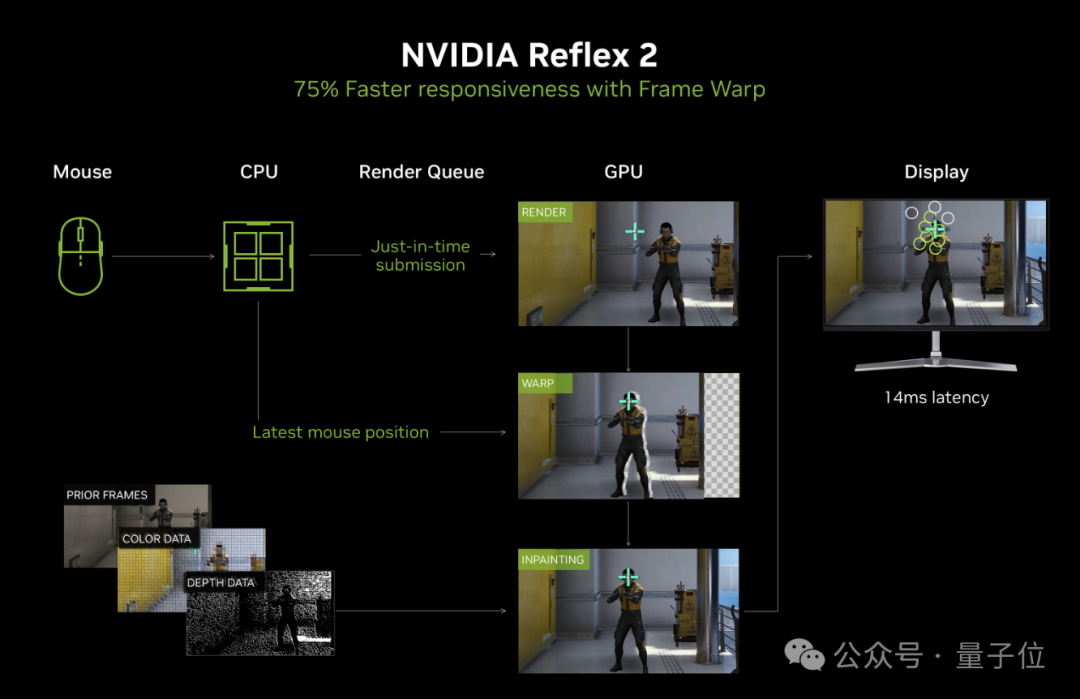

除了画面质量,延迟也是游戏玩家们关心的重要参数,特别是在竞技游戏中,几毫秒的输入延迟可能就会决定胜负。

为此英伟达推出了Reflex 2,将上一代Reflex的低延迟模式与全新Frame Warp技术相结合,在将渲染帧发送至显示器前,根据最新的鼠标输入信号对其进行更新,可将PC延迟降低高达 75%。

为了解决Frame Warp过程中的图像撕裂问题,英伟达还开发了一种优化了延迟的预测渲染算法,该算法使用来自先前帧的视角、颜色和深度数据,对这些撕裂进行准确的图像修复。

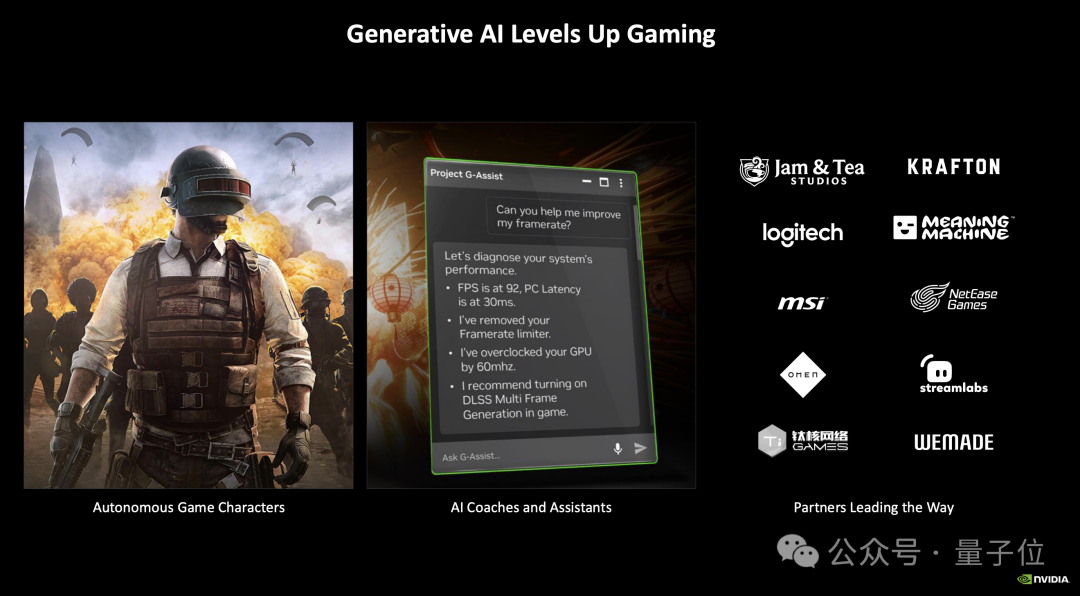

在上一届CES上,英伟达展示的AI NPC技术(基于NVIDIA ACE实现)也吸引了不少眼球。

通过ACE,不需要事先准备剧本,就能让游戏中的人物像真人一样与玩家语音对话。

现在这项技术也迎来了升级,应用范围扩展到了拥有自主意识的游戏角色,比如AI队友。

并且能力也更丰富,可以利用AI让这些角色像真人玩家一样感知、计划和行动。

另外,去年的AI NPC的对话内容需要传输到云端处理;

现在50系显卡运算能力大幅提升,同时英伟达还推出了小语言模型,在算法和算力同时升级之后,对话内容的处理在本地也能完成了。

《绝地求生 (PUBG: BATTLEGROUNDS)》中就会通过Ace服务和定制版Mistral小模型,在游戏中提供一个像真人一样的虚拟队友。

它可以和你对话并密切配合你的动作,帮助标记出物品,甚至开车过来和你汇合。

国产游戏方面,网易的《永劫无间 (NARAKA: BLADEPOINT)》PC版也将在今年年内发布类似功能。

总之,工具老黄都已经给大家准备好,接下来的压力给到游戏公司这边了。

—

(文:量子位)