CES大会上,黄皮衣称,AI下一个前沿就是物理AI。

为此,英伟达重磅官宣了世界基础模型开发平台——Cosmos,其模型基于在200万小时视频上完成训练。

它一共包含了四大功能模块:扩散模型、自回归模型、视频分词器,以及视频处理与编辑流程。

用英伟达高级科学家Jim Fan的话来总结:

两种形式:扩散模型(生成连续的token);自回归模型(生成离散的token)

两种生成模式:文本->视频;文本+视频->视频

Cosmos诞生就是为了拯救物理AI数据不够的问题!现如今,开发者们可以直接生成合成数据,将其用于自动驾驶和机器人研究中。

它一共包含了三种规格的模型:Nano、Super、Ultra。

与VideoLDM基准相比,Cosmos世界模型在几何准确性方面表现更优,而且在视觉一致性方面持续超越VLDM,姿态估计成功率最高飙升14倍。

这个模型有望用在工业生产上,不过在那之前,AI爱好者们首先会拿来画妹子和二次元。

ComfyUI几乎是第一时间就适配了Cosmos,只需要把ComfyUI升级到最新版即可使用Cosmos的工作流跑视频。

从我实测的效果来看,这个模型最低可以跑在12G显存的3060上,但体验并不太好,24帧、5秒的视频,跑了接近两小时。

要么升级显卡到5090,要么等各路赛博大神们对模型持续优化。

一、模型的下载和安装

官方(需梯子)

https://comfyanonymous.github.io/ComfyUI_examples/cosmos/

网盘

https://pan.quark.cn/s/356517481eb6

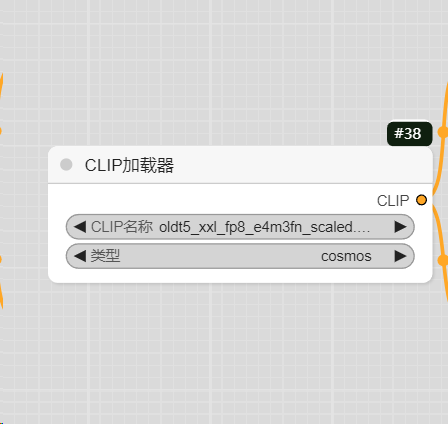

1、Clip和 VAE:

oldt5_xxl_fp8_e4m3fn_scaled.safetensors

(上传了fp8和fp16两个版本,小显存建议用fp8)

安装路径:ComfyUI\models\clip

cosmos_cv8x8x8_1.0.safetensors

安装路径:ComfyUI\models\vae

注意:oldt5_xxl与flux等型号中使用的t5xxl不一样。oldt5_xxl 是 t5xxl 1.0,而 Flux 等中使用的则是 t5xxl 1.1

2、视频模型

共有两个,一个是文生视频(Text2World),一个是图生视频(Video2World)

Cosmos-1_0-Diffusion-7B-Text2World.safetensors

Cosmos-1_0-Diffusion-7B-Video2World.safetensors

安装路径:ComfyUI\models\diffusion_models

二、节点介绍

先说文生视频

1、clip加载器,加载专用的clip模型即可

2、UNET加载器,加载文生视频模型

3、VAE加载器,加载专用VAE模型

图生视频类似,只是多了一个上传图片的节点。

生成视频测试(6500秒)

模型和工作流下载:

官方(需梯子)

https://comfyanonymous.github.io/ComfyUI_examples/cosmos/

网盘

https://pan.quark.cn/s/356517481eb6

(文:路过银河AI)