~

~

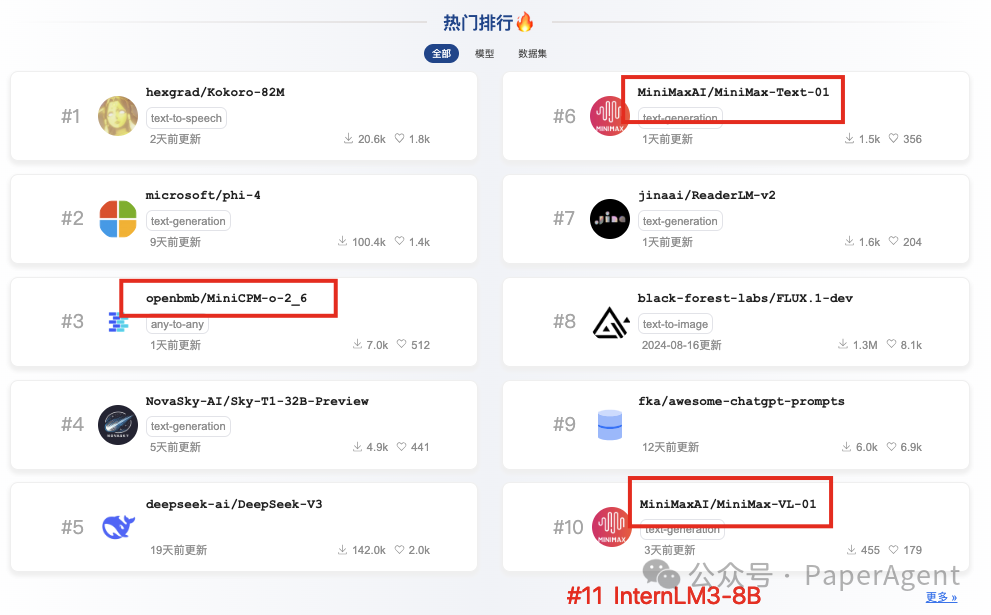

书生InternLM3-8B

https://hf-mirror.com/internlm/internlm3-8b-instruct多模态小钢炮MiniCPM-o 2.6

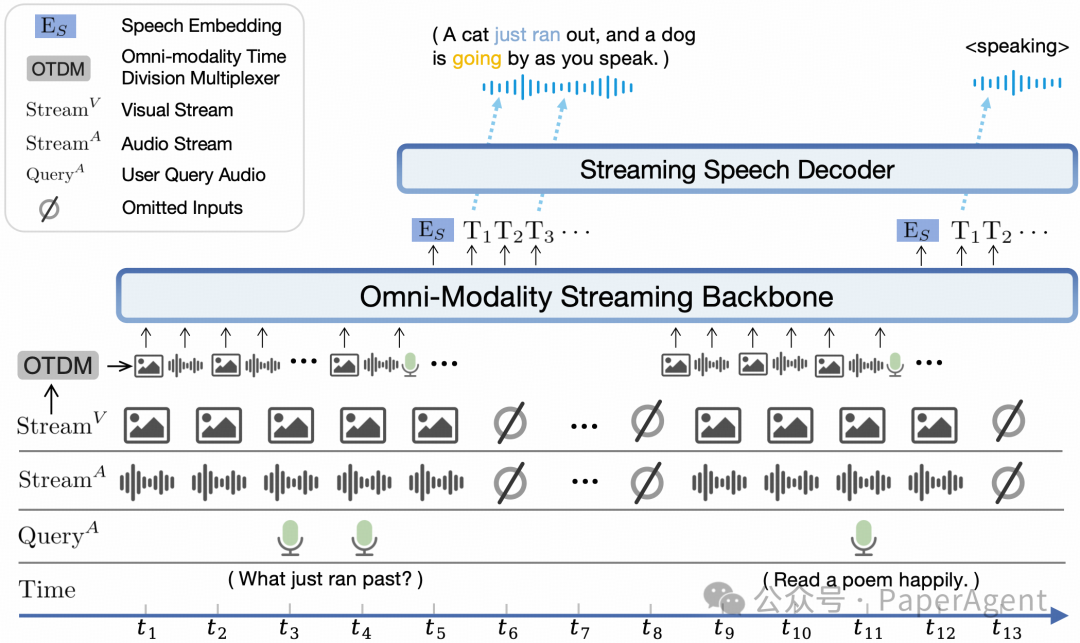

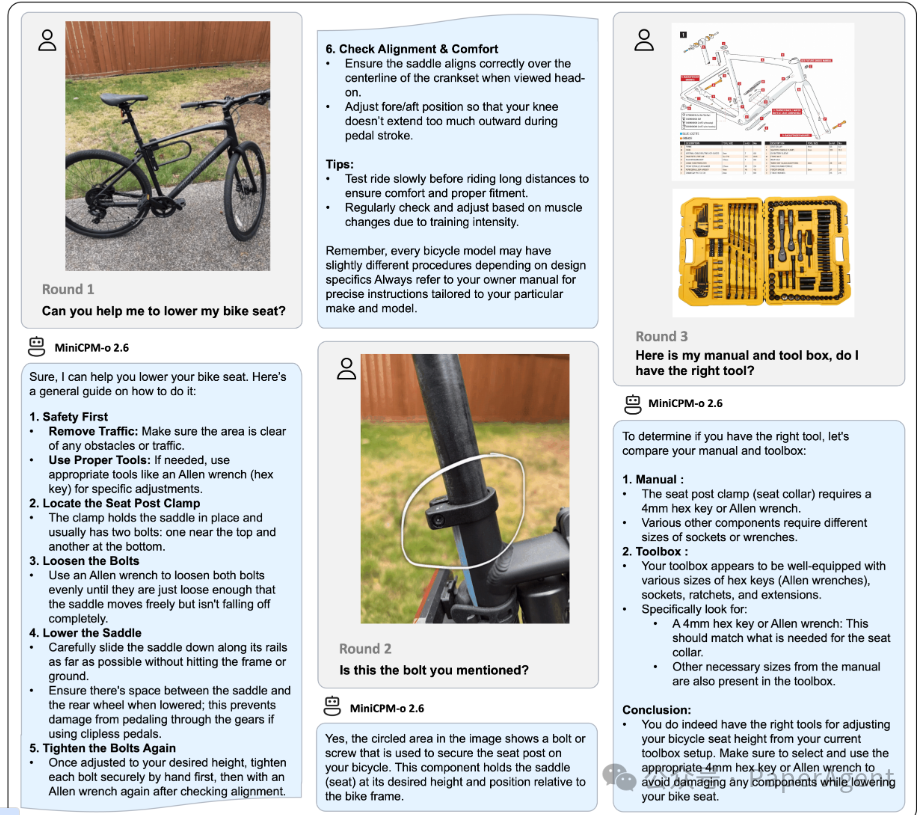

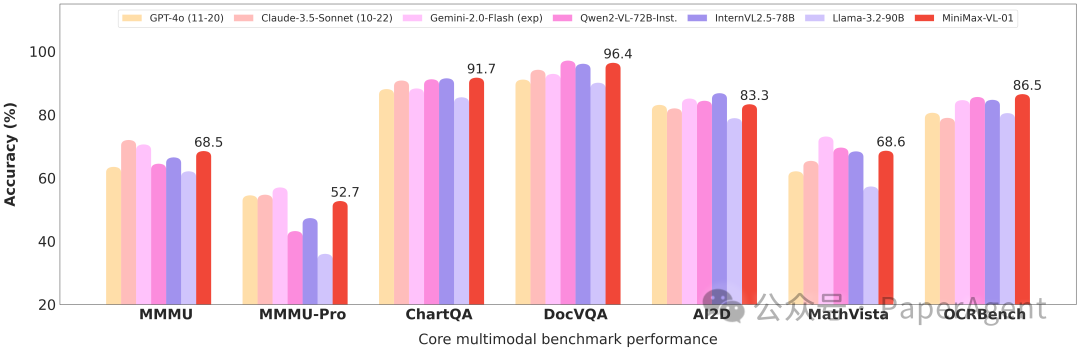

面壁智能开源新一代多模态小钢炮MiniCPM-o 2.6,该模型视觉、语音和多模态流式能力达到了 GPT-4o-202405 级别,进一步优化了 MiniCPM-V 2.6 的众多亮点能力。MiniCPM-o 2.6 支持可配置声音的中英双语语音对话,还具备情感/语速/风格控制、端到端声音克隆、角色扮演等进阶能力

模型架构:端到端全模态架构、全模态流式机制、可配置的声音方案

https://github.com/OpenBMB/MiniCPM-o/tree/mainMiniMax-01系列模型

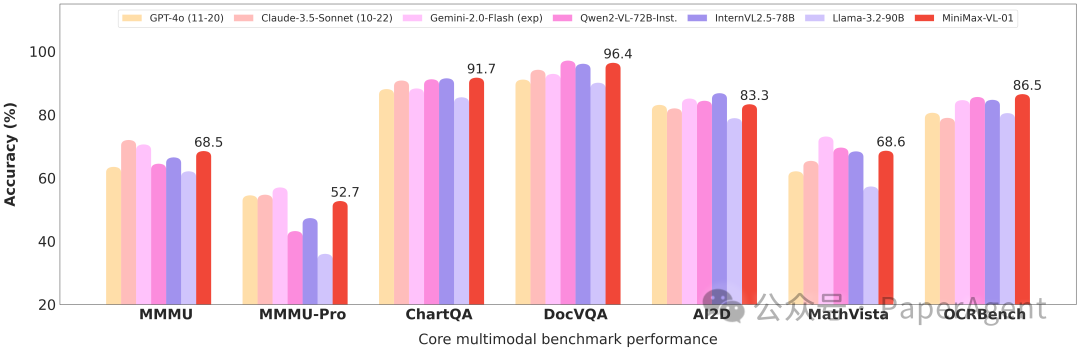

https://hf-mirror.com/MiniMaxAI/MiniMax-Text-01https://hf-mirror.com/MiniMaxAI/MiniMax-VL-01

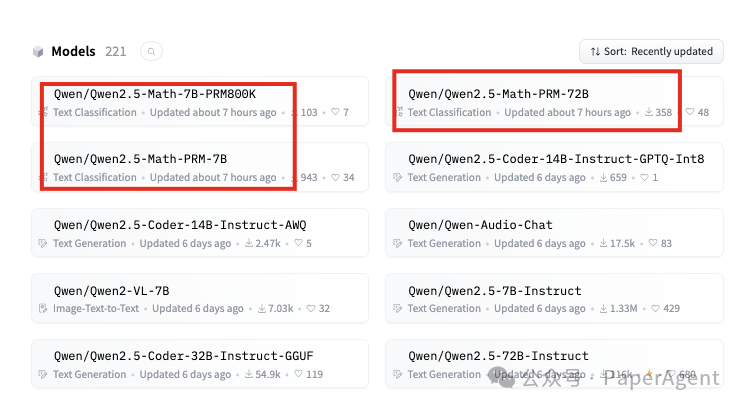

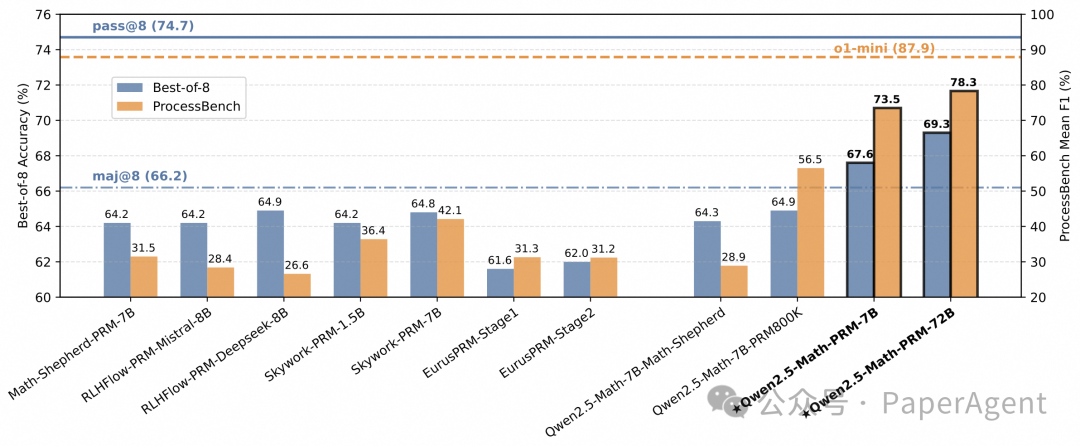

Qwen2.5-Math-PRM/RM

此次阿里千问开源的有三个模型,除了数学结果奖励模型(ORM)Qwen2.5-Math-RM-72B之外,还发布了过程奖励模型(PRM),即Qwen2.5-Math-PRM-7B和Qwen2.5-Math-PRM-72B。PRM作为一种有前景的方法,用于大型语言模型(LLM)数学推理中的过程监督,旨在识别并减少推理过程中的中间错误。

https://hf-mirror.com/Qwen/Qwen2.5-Math-PRM-72Bhttps://arxiv.org/pdf/2501.07301

Qwen2.5-VL也发布在即

(文:PaperAgent)

国产大模型简直太强了!参数高达72B,性能吊打全球顶尖!

国货大模型 week 发布多款重量级模型