1

项目动机

项目动机

原项目地址:https://github.com/rasbt/LLMs-from-scratch.git

本项目是对 GitHub 项目 《LLMs-from-scratch》的中文翻译,包括详细的 Markdown 笔记和相关的 Jupyter 代码。翻译过程中,我们尽量保持原意的准确性,同时优化了部分语序和表达方式,以更贴合中文学习者的阅读习惯。需要特别说明的是,原作者为该项目的主要贡献者,本汉化版本仅作为学习辅助资料,未对原内容进行修改或延伸。

由于个人能力有限,翻译中可能存在不足之处,欢迎提出宝贵意见并多多包涵。希望通过这一翻译项目,能帮助更多中文学习者受益,同时为国内社区的 LLM 学习和研究贡献一份力量。

本项目的特色:

详细的 Jupyter 代码注释:帮助学习者快速上手实践。

精准的术语翻译:译者结合实际交流中的常用术语,提供更贴近实际应用的表达。

丰富的附加材料:包含拓展知识的资源,并对部分关键内容提供了原论文索引,便于快速理解与深入学习。

本项目所用的徽章来自互联网,如有侵犯您的图片版权,请联系我们删除。

课程简介

提到大型语言模型(LLMs),我们可能会将其视为独立于传统机器学习的领域,但实际上,LLMs 是机器学习的一个重要分支。在深度学习尚未广泛应用之前,许多领域(如语音识别、自然语言处理、计算机视觉等)因需要大量专业知识应对复杂问题,机器学习的作用相对有限。然而,近年来深度学习的快速发展彻底改变了这一状况,LLMs 成为推动人工智能技术革命的关键力量。

在 《LLMs-from-scratch》项目中,不仅关注 LLMs 的基础构建(如 Transformer 架构、序列建模等),还深入探索了 GPT、BERT 等深度学习模型的底层实现。项目的每一部分都配备详细的代码实现和学习资源,帮助学习者从零开始构建 LLMs,全面掌握其核心技术。

课程资源

– 英文原版地址:https://github.com/rasbt/LLMs-from-scratch.git

– 教材网址:https://amzn.to/4fqvn0D

– 汉化地址:https://github.com/MLNLP-World/LLMs-from-scratch-CN.git

此外,本课程还配备相应的代码实现,每章均提供完整的 Python 模型代码的 Jupyter 笔记本,所有资源均可在线免费获取。

笔记目录

笔记预览

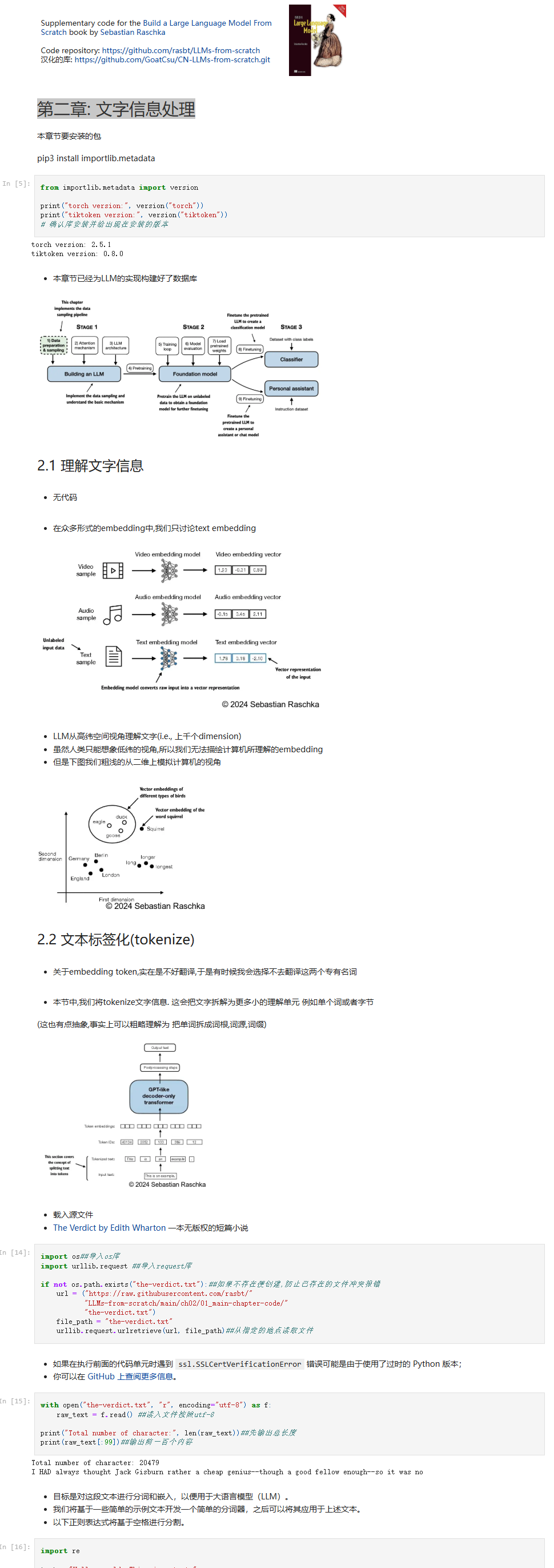

《第二章: 文字信息处理》部分预览

项目地址

关于我们

(文:机器学习算法与自然语言处理)

MLNLP社区简直就是自然语言处理界的香饽饽!LLMs-from-scratch项目简直是入门者的天堂!

MLNLP社区强到离谱!LLMs-from-scratch翻译得太棒了! Months of effort, 精通技术细节,分享资源也无保留。适合入门和进阶的好资料!