出品丨AI 科技大本营(ID:rgznai100)

还记得前年 ChatGPT 刷屏的时候吗?

全球科技圈疯狂吹捧,但问问身边的普通人,十个里有八个都在说“太难用了”:注册要国外手机号,充值要美国信用卡,界面全是英文,想用还得翻墙……后来的 Claude、Gemini 和 Llama,都是“只在新闻标题见过”的名字。

这两年来,整个 AI 界的酸甜苦辣和风云变幻,在真正的蓝海市场面前,都像是一场自嗨。大家都在头疼同样的问题:怎么推广出去?怎么让普通人知道 AI 有什么用?反过来再问问自己——现在的 AI 应用真的有用吗?

但这个春节,情况突然不一样了。

打开微信,朋友圈被 DeepSeek 的对话截图刷屏。服务器从年前就在崩溃的边缘反复横跳。打开界面永远都是:“不好意思,和 DeepSeek 聊天的人有点太多了,请过一会儿再提问吧。”

不再是科技圈的自嗨,而是 AI 真正第一次走进了中国普通人的生活。

突如其来的“全民 AI 狂欢”背后,是一家中国团队完成的惊人技术突破。1 月 20 日,DeepSeek 发布了推理模型 DeepSeek-R1,这款完全开源的模型在多项第三方测试中超越了 OpenAI 最新的 o1 模型,同时 API 价格仅为后者的 3.7%。

这几乎相当于免费送你一个顶配版 ChatGPT。用户疯狂涌入,直接把 DeepSeek 送上了中美应用商店双榜第一。更刺激的是,这个“低成本平替”的玩法直接把华尔街也干懵了。英伟达一夜暴跌 6000 亿,创下史上最大单日跌幅,股民们人都看傻了:原来 AI 不一定要堆算力?

紧接着在除夕夜,他们又推出了多模态大一统开源模型 Janus-Pro(目前还没上网页端)。仅用 16 个计算节点(每节点 8 张 A100)训练一周,1.5B 版本就达到了惊人的效果。而配备 32 个节点训练两周的 7B 版本,更是在多模态理解基准 MMBench 上拿下 79.2 分,超越了包括 TokenFlow(68.9 分)和 MetaMorph(75.2 分)在内的所有现有统一多模态模型。

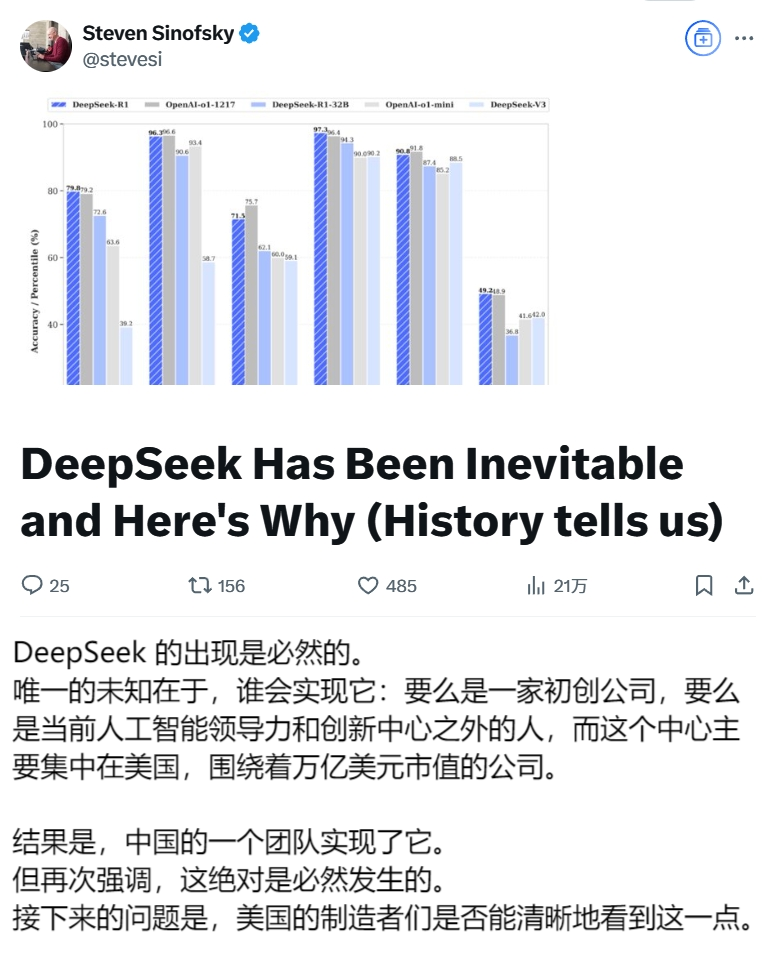

这一系列事件背后,折射出的是整个 AI 行业面临的根本性问题:技术发展究竟是否一定要与巨额投入挂钩?Windows 部门前总裁 Steven Sinofsky 在最新发布的分析中指出,当前 AI 行业的发展高度依赖资本投入。

OpenAI 每年支出 50 亿美元,Google 在 2024 年的 AI 预期支出更是将超过 500 亿美元,而微软对 OpenAI 的投资已达到 130 亿美元。这种发展模式形成了一个看似合理但可能存在隐患的逻辑:砸钱就能搞出好 AI。更多的投入必然带来更强的算力,进而产出更好的模型。

而 DeepSeek 走出了一条截然不同的道路。他们的发展轨迹令人惊叹:2023 年 7 月 17 日成立,2024 年 1 月 5 日发布第一个 AI 大模型 DeepSeek LLM,5 月 7 日发布 DeepSeek-V2 正式打响中国大模型价格战,12 月 26 日开源 DeepSeek-V3。

我们 CSDN 编辑部其实也是从 DeepSeek-V2 时期就开始买他们家的 API 了,不为其他原因:当时送了 500 万 tokens,到过期了也没用完;后面充了 10 块钱又买了几百万 tokens,到现在 R1 出来了还是没用完。

在训练成本方面,DeepSeek-V3 仅用了 557.6 万美元就完成了训练。这个投入对比一下 Meta 的数据就格外刺眼:Llama 3 系列的计算预算高达 3930 万 H100 GPU Hours,这样的算力足够训练 15 个 DeepSeek-V3。

这一下子问题就来了:Meta 的员工要咋跟领导解释呢?就在模型发布后不久,一位 Meta 员工在美国匿名职场社区 teamblind 爆料:整个生成式 AI 团队已经陷入恐慌。“工程师们正在疯狂地分析 DeepSeek,试图从中复制任何可能的东西。这一点都不夸张。”

更让管理层头疼的是,当生成式 AI 组织中每一位“领导”的薪资都比训练整个 DeepSeek-V3 的成本还要高,而公司有好几十个这样的“领导”时,他们要如何向高层解释这些开支?

在算法层面,DeepSeek 在混合专家模型(Mixture of Experts)训练中解决了不规则损失峰值问题,实现了 8 位浮点训练以显著降低内存占用。这些创新使他们将通常需要数月的训练时间缩短到了 60 天。这些成就甚至得到了 OpenAI 首席研究官 Mark Chen 的认可,他承认 DeepSeek 独立发现了一些与 o1 相同的核心理念。

而 OpenAI 首席执行官 Sam Altman 终于没憋住气,正式回复并承认了 DeepSeek 的成功,重点感叹了它的便宜。

这里可以回顾一下 DeepSeek-V3 刚发布时 Sam Altman 的反应,态度可谓是 180 度大转弯了:

我们可以简单地把 Sam 对一件事的态度分为三级:

-

释然了:不藏着掖着,正面坦然回应各种事情;

-

破防了:连名字都不提,阴阳怪气一波;(对谷歌经常这么干)

-

高度重视:规范大小写,不再打全小写的英文;

当然,对于 DeepSeek,硅谷也存在各种不同的声音。图灵奖得主、Meta AI 首席科学家 Yann LeCun(杨立昆)指出,人们常常误解了 AI 基础设施投资的重点。他认为大部分资金其实用于推理而非训练,随着 AI 能力的增强,维持服务运行的成本会变得更高。

立昆还发表了一个更具全局视野的观点:“与其说是中国在人工智能上超越美国,正确的看法应该是开源代码正在超越私有模式。”

这句话倒不一定需要过度解读,因为我们往期整理的数篇杨立昆采访都显示,他其实就是想借着这个机会再次拉踩一下 OpenAI,醉翁之意不在中美,而在于开源闭源之争:《图灵奖得主杨立昆:统治欲望源于生存需求,而非智能水平,AI 不会有这种想法 | AI 2025》

总之,如今这场风波背后的核心问题在于:DeepSeek 展示的高效路线是否预示着 AI 发展的新范式?砸钱买显卡以后还会管用吗?

美国科技巨头们的担忧显然不是没有根据的。近日,美国财经媒体 CNBC 推出了一期长达 40 分钟的专题节目,深入探讨 DeepSeek 对美国 AI 主导地位可能带来的冲击。

CNBC 邀请了硅谷新锐 AI 创业公司 Perplexity 的 CEO Aravind Srinivas 进行深度对谈,此人相当能侃,AI 科技大本营上一次整理他的文章还是一篇四万字的采访,尽显他对于拿下谷歌的决心:《Perplexity CEO 最新四万字访谈:杀死谷歌,成为 AI 时代的搜索皇帝!》

以下是访谈全文,由 CSDN 精编整理:

主持人:请跟我们描述一下中美之间的 AI 竞赛,以及其中的利害关系。

Aravind Srinivas:首先要说明,中国在与美国的竞争中面临很多不利因素。最主要的是他们无法获得我们这里能用的所有硬件资源。他们基本上在使用比我们低端的 GPU,几乎就是在用上一代的设备。由于更大的模型通常意味着更强的智能,这自然让他们处于劣势。

但另一方面,这些限制反而成就了创新。因为他们必须寻找变通方案,最终反而打造出了更高效的解决方案。这就像是在说:“嘿,你们必须开发一个顶级模型,但我不给你们资源,你们得自己想办法。”

除非从数学上能证明这是不可能的,否则你总能找到更高效的解决方案。这可能会让他们比美国找到更高效的方法。当然,他们已经开源了模型,所以我们也可以采用类似的技术,但他们培养的这种人才和能力将逐渐成为他们的优势。

目前,美国最好的开源模型是 Meta 推出的 Llama 系列。它非常出色,基本可以在普通电脑上运行。虽然它在发布时声称自己接近 GPT-4 性能,但事实上只有那个巨大的 405B 参数模型才符合宣传水平,而不是你能在电脑上运行的 70B 模型。所以,此前一直没有一个既小巧便宜,又快速高效的开源模型能与最强大的闭源模型相媲美。

然后这些中国团队突然推出了一个令人震惊的模型,API 价格比 GPT-4 便宜十倍,比 Claude 便宜十五倍。速度极快,而且在某些基准测试中与 GPT-4 不相上下,有些甚至更好。他们只用了大约 2048 个 H800 GPU,相当于 1500 到 2000 个 H100 GPU,这比 GPT-4 通常训练时用的 GPU 数量少了二三十倍。总共只花了 500 万美元的计算预算,就做出了这么惊人的模型,还完全开源并发布了技术论文。

主持人:当你理解他们所做的一切时,最让你惊讶的是什么?

Aravind Srinivas:我的惊讶在于,当我阅读他们的技术论文时,发现他们提出了很多聪明的解决方案。

首先,他们成功训练了一个混合专家模型(Mixture of Experts),这本身就不容易。人们之所以很难跟上 OpenAI 的步伐,特别是在 MoE 架构上,主要是因为存在很多不规则的损失峰值。数值不稳定,经常需要重新启动训练检查点。他们提出了非常巧妙的解决方案来平衡这个问题,而且没有使用额外的技巧。

他们还实现了 8 位浮点训练,至少在部分数值计算上做到了。他们巧妙地确定了哪些部分需要高精度,哪些部分可以用低精度。据我所知,8 位浮点训练在美国并不普遍,大多数训练仍然在用 16 位精度,虽然有些人在探索这个方向,但很难做到正确。正是因为他们没有那么多内存和 GPU,所以他们找到了很多数值稳定性的方法,使他们的训练能够顺利进行。他们在论文中说,大部分训练都很稳定,这意味着他们可以随时重新运行这些训练,用更多或更好的数据。整个训练只用了 60 天,这真的非常惊人。

主持人:你最惊讶的是哪个部分?

Aravind Srinivas:通常人们认为中国人只会复制,认为只要在美国停止发表研究论文,停止描述基础设施架构的细节,停止开源,他们就追不上来。但事实是,DeepSeek V3 中的创新确实令人惊艳。我相信 Meta 在开发下一代 Llama 模型时,一定会借鉴他们的一些技术突破。DeepSeek 是真正的创新 —— 而一旦你做出了真正的突破,其他人自然会跟进。

主持人:我们并不完全了解他们训练用的数据是什么。虽然它是开源的,我们知道一些训练方式,但不是全部。有观点认为它是基于公开的 ChatGPT 输出训练的,这意味着只是复制品,但你说它超越了这一点,有真正的创新。

Aravind Srinivas:没错。他们训练了 14.8 万亿个 token。互联网上确实有大量 ChatGPT 生成的内容,如果你现在去看任何 LinkedIn 帖子或 X 帖子,大多数评论都是 AI 写的。就连 X 上都有 Grok 推文增强器,LinkedIn 上有 AI 增强器,Google Docs 和 Word 里也有 AI 工具来重写内容。

如果你用 AI 写了点什么然后复制到网上,自然会带有一些 ChatGPT 式的训练痕迹。很多人甚至在复制的时候懒得删掉“我是一个语言模型”这样的字眼。在这个领域很难控制这些。所以我不会因为它对某些提示(比如“你是谁”或“你是哪个模型”)的回应而否定他们的技术成就。在我看来,这根本不重要。

主持人:长期以来,我们认为中国在 AI 领域落后。这场竞赛现在情况如何?我们能说中国正在赶上,还是已经赶上了?

Aravind Srinivas:如果我们说 Meta 正在赶上 OpenAI 和 Anthropic,那么同样的说法也适用于中国赶上美国。实际上,在 o1 发布后,我看到中国出现了比美国更多试图复制它的论文。值得注意的是,DeepSeek 能使用的计算资源大概和美国的博士生差不多。顺便说一句,这不是在批评其他人。就拿我们 Perplexity 来说,我们决定不训练模型是因为觉得这太贵了,而且我们认为不可能追上其他人。

主持人:你会将 DeepSeek 整合到 Perplexity 中吗?

Aravind Srinivas:我们已经开始使用它了。他们有 API,而且开源了,所以我们也可以自己部署。使用它很有意义,因为它实际上让我们能以更低成本做很多事情。但我在想的不止这些。这些人真的能用一个好团队训练出如此优秀的模型,这意味着美国公司,包括我们在内,已经没有借口不去尝试类似的事情了。

主持人:在公共场合,我们经常能够听到很多生成式 AI 领域的意见领袖,无论是研究还是创业方面,比如 Elon Musk 等人都说中国追不上。

Aravind Srinivas:首先,我不确定 Elon 是否说过中国追不上。我不了解这一点。

主持人:Sam Altman 也说过类似的话。

Aravind Srinivas:你必须区分开像 Sam 这样的人说的话和他自身的利益关系。我的观点是,无论你做什么来阻止他们追赶都无关紧要。他们最终还是追上来了。需求是发明之母,就是这样。

更危险的是,他们现在拥有最好的开源模型,而所有美国开发者都在基于此构建。这才是更危险的,因为这样他们就能掌握开发者心智和生态系统。一般来说,历史已经证明,一旦开源赶上或超越了闭源软件,所有开发者都会转向开源。这是历史规律。

主持人:当 Llama 被开发并广泛使用时,人们在问“我们应该信任扎克伯格吗?”但现在的问题变成了“我们应该信任中国吗?”

所以,“开源的是谁”这件事,本身重要吗?

Aravind Srinivas:从某种意义上说这并不重要,因为你仍然可以完全控制它。你可以在自己的计算机上运行自己的权重,你来掌控模型。但是,让我们自己的人才依赖别人开发的软件看起来并不太好,即使它是开源的。开源模型也有一天可能不再开源。对吧?现在的许可证很宽松,但是随着时间推移,他们随时可能改变许可证。

所以我们在美国也需要有人在建设,这就是为什么 Meta 如此重要。我认为 Meta 最终会建造出比 DeepSeek-V3 更好的模型并开源它,不管他们叫它 Llama 4 还是 3 点几都不重要。我认为关键是我们不要把所有精力都放在禁止他们、阻止他们上面。相反,应该努力竞争并战胜他们。这才是美国的方式。做得更好。

主持人:看起来我们现在听到越来越多关于这些中国公司的消息,他们正在以更高效、更低成本的方式开发类似的技术,对吗?

Aravind Srinivas:如果你筹集了 100 亿美元,并决定将其中 80% 用于计算集群,那么你很难去想出和那些只有 500 万美元的人一样的解决方案。而且也没必要去批评那些投入更多的人。他们只是在试图尽快完成目标。

主持人:当我们说开源时,有很多不同的版本。有些人批评 Meta 没有公布所有内容,就连 DeepSeek 本身也不是完全透明的。

Aravind Srinivas:当然。你可以把开源的定义推到极致,说我应该能完全复制你的训练过程。但首先,有多少人真的有资源去做这件事?而且,比较一下,他们在技术报告中分享的细节已经比其他公司多得多了。顺便说一句,Meta 也是这样,他们的 Llama 3.3 技术报告非常详细,对科学非常有价值。他们分享的细节已经比其他公司现在做的要多得多了。

主持人:当你想到 DeepSeek 只花了不到 600 万美元就做到这一点,再想想 OpenAI 在开发 GPT 模型上花了多少钱,这对闭源模型生态系统的轨迹、发展势头意味着什么?对 OpenAI 意味着什么?

Aravind Srinivas:很明显,我们会在今年看到一个开源版本的 GPT-4,甚至比它更好、更便宜的版本。完全开源。

主持人:由 OpenAI 开发的?

Aravind Srinivas:很可能不是。我不认为他们会在意是不是由他们开发的。我认为他们已经转向了新的范式,就是 o1 系列模型。Ilya Sutskever 已经说了,预训练正在遇到瓶颈,他明确表示预训练时代已经结束。很多人都这么说。这并不意味着 Scaling Law 遇到了瓶颈。我认为我们现在正在不同维度上进行扩展。模型在测试时花在思考上的时间、强化学习,就像是在尝试让模型在遇到新提示时,能够进行推理、收集数据并与世界互动,使用各种工具。我认为发展正朝着这个方向前进,我感觉 OpenAI 现在更专注于这方面。

主持人:那我的问题是,现在 OpenAI 的护城河在哪里?

Aravind Srinivas:嗯,我仍然认为,目前还没有其他人做出类似 o1 那样的系统。我知道有人在争论 o1 是否真的值得,可能在一些提示词上它确实更好,但大多数时候它的输出并没有比 Claude 好多少。但至少他们在 o3 中展示的结果,比如在竞争性编程方面的表现,已经接近 AI 软件工程师的水平了。

主持人:但这不就是时间问题吗?互联网上很快就会充满推理数据。

Aravind Srinivas:确实有可能。现在还没人知道。所以在它真正实现之前,这种不确定性就是他们的护城河。就是说,还没有其他人拥有同样的推理能力。但到今年年底,推理领域会有多个玩家吗?我绝对认为会的。

主持人:所以我们正在看到大语言模型及其能力的商业化吗?

Aravind Srinivas:我认为我们会看到类似的轨迹。就像在预训练和后训练那种系统中,今年会有更多商业化的类 GPT-4 模型。我觉得推理类模型也会经历类似的轨迹,一开始只有一两个玩家知道怎么做,但随着时间推移……(可能越来越多)因为 OpenAI 可能会在另一个方向取得突破。现在推理是他们的护城河。但如果突破一直在发生,一次又一次,那么“突破”这个词本身可能也会失去一些价值。

主持人:说得对。即使现在也很难区分,对吧?因为有预训练的突破,然后我们又进入了不同的阶段。

Aravind Srinivas:是的。可以肯定的是,今天存在的任何模型,无论是这种程度的推理还是多模态能力,都会出现成本降低 5 到 10 倍的开源版本。这只是时间问题。不确定的是,像在测试时进行推理的模型,是否能便宜到我们都能在手机上运行。我觉得这一点还不清楚。

主持人:DeepSeek 展示的这些能力,你觉得可以称之为中国的 ChatGPT 时刻吗?

Aravind Srinivas:有可能。我是说,这肯定给了他们很大的信心,让他们意识到自己并没有落后,而且无论你如何限制他们的计算资源,他们总能找到解决方案。我相信团队对他们的成果感到非常兴奋。

主持人:这如何改变投资格局?那些每年在基础设施上花费数百亿美元的超大规模公司,还有为了 GPU 筹集数十亿美元的 OpenAI 和 Anthropic,但 DeepSeek 告诉我们,你不一定需要这些。

Aravind Srinivas:是的。我认为很明显,他们会在推理方面投入更多,因为他们明白,他们在过去两年构建的东西现在变得如此便宜,已经很难证明继续投入那么多资金的合理性了。

主持人:推理的成本主张还一样吗?他们需要同样数量的高端 GPU,还是可以像 DeepSeek 那样用低端的?

Aravind Srinivas:再说一次,除非被证明不行,否则很难说不可能。但我猜想,为了快速前进,你会想用高端芯片,想比竞争对手走得更快。我认为最优秀的人才仍然想在率先实现突破的团队工作。总是会有一些荣誉属于真正的先驱者,而不是快速跟随者。

主持人:这有点像 Sam Altman 的推文,他曾经暗示说 DeepSeek-V3 只是在复制,任何人都能复制,对吧?

Aravind Srinivas:但在这个领域,每个人都在复制别人。你可以说 Google 最先提出了 Transformer,不是 OpenAI,OpenAI 只是复制了它。Google 构建了第一个大语言模型,他们没有产品化,但 OpenAI 以产品的方式做到了。所以你可以从很多角度来说这个问题。这都不重要。

杨立昆:统治欲望源于生存需求,AI 不会有这种想法

库兹韦尔:科技每年为人类加一岁寿命,2032 实现倒流

施密特:AI 今年会获得永久记忆,2028 美国耗尽能源储备

IBM:现代语言是为人类设计的,AI 需要汇编这种原生语言

年度盘点:99% 不懂 AI 的人和剩下 1 % 产生了鸿沟

奥特曼:很快搞定核聚变,第一批智能体在今年开始劳动

黄仁勋:英伟达引领机器人行业革命,未来人人都能有超算

罗素:AGI 让地球上所有人达到西方中产阶级的生活水平

马斯克:三年造 50 万机器人,让金钱彻底失去意义

扎克伯格:今年 AI 将能替代中级工程师

(文:AI科技大本营)