传统大语言模型或遭遇最强挑战!

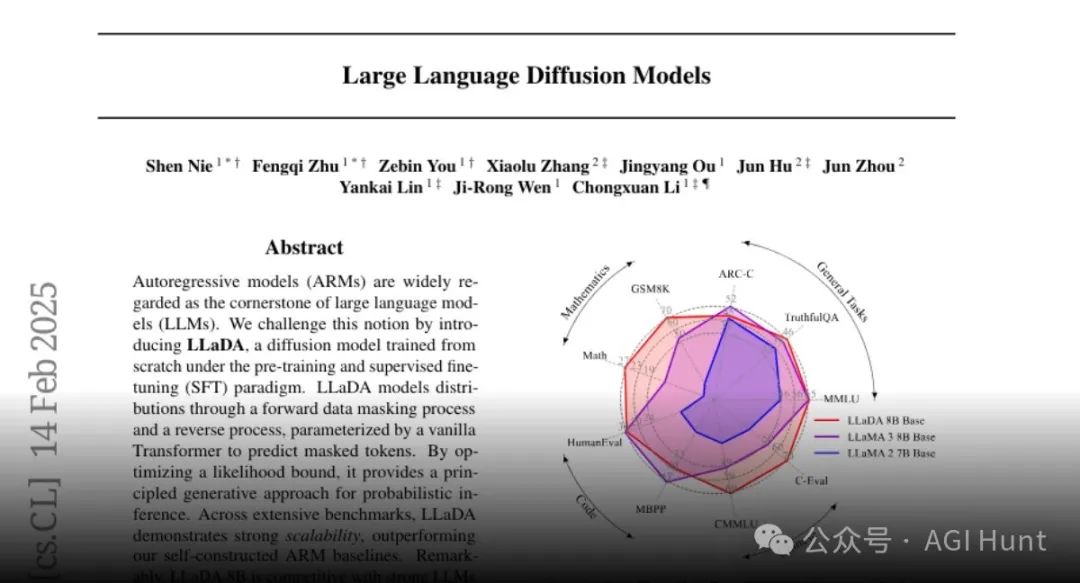

由清华、中国人民大学和蚂蚁集团联合发布的LLaDA模型,竟然用「扩散」方式打破了自回归的垄断地位,性能直逼同规模的Llama 3 8B!

这不是简单的模型迭代,而是或将彻底颠覆我们对大语言模型的认知。

告别「迈克尔·斯科特综合症」

传统大模型就像《办公室》里的迈克尔·斯科特,只能一个词一个词地往下看,永远看不到全局。

但LLaDA模型却另辟蹊径:

通过研究人员的深入探索,他们发现大模型的智能——无论是扩展性、指令遵循、上下文学习、对话能力还是信息压缩,其实都不一定要依赖自回归机制。

关键在于一个核心原则:通过最大似然估计来逼近真实的语言分布。

颠覆性的架构创新

研究团队采用了一种全新的训练范式,将掩码扩散模型应用到大语言模型领域:

-

预训练阶段:随机掩码比例t~U[0,1],对所有token进行掩码

-

监督微调阶段:只对响应部分进行掩码处理

-

采样过程:从完全掩码(t=1)到完全恢复(t=0),每一步都能同时预测所有掩码位置

这种方法让模型摆脱了传统的从左到右生成方式,实现了真正的全局视角。

来看一个实际例子,当让模型解释「什么是人工智能」时:

实力对标

相比于Next Token Prediction 的LLM,LLaDA在实际应用中展现出了惊人的能力:

1. 数学问题处理

问题:Emma每周跑4次冲刺,每次5组,每组75米。她一周总共跑多远?LLaDA回答:Emma每次跑4次冲刺,所以一周总共跑4 x 5 = 20次。每次跑75米,所以一周总共跑20 x 75 = 1500米。最终结果是1500米。

2. 多语言翻译

英文:What is now proved was once only imagined中文:现在被证明的曾经只是想象德文:Wer heute bestätigt ist, war einst nur immaginiert

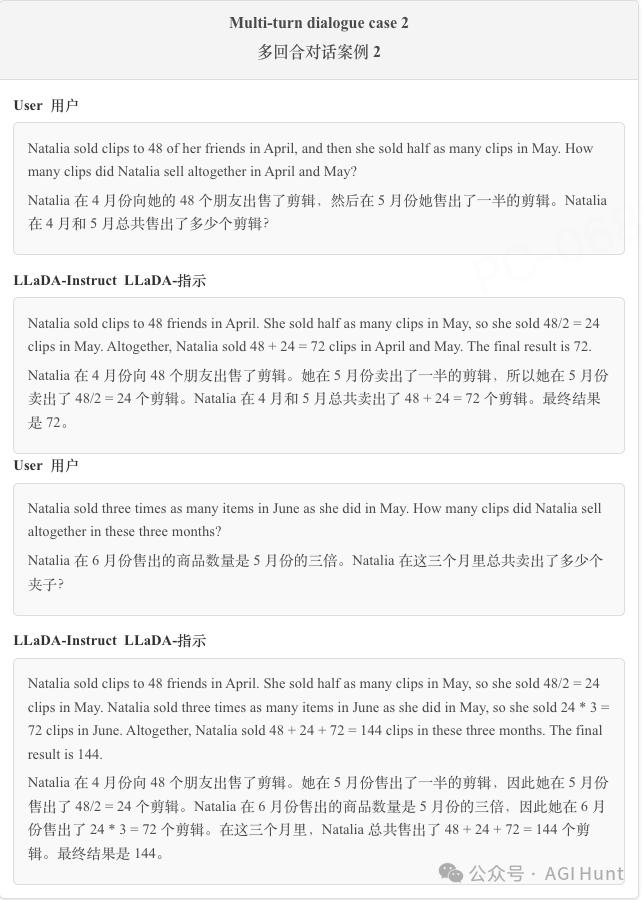

3. 多轮对话

在电影推荐、诗歌创作等任务中,LLaDA展现出了出色的理解力和创造力。

4. 代码生成

LLaDA 写起代码来,也是不在话下:

技术实现的关键突破

研究团队通过标准的预训练和SFT流程,让LLaDA实现了:

-

强大的扩展性:在相同数据规模下与自回归基线模型竞争

-

出色的指令遵循能力:通过SFT展现优秀的多轮对话能力

-

解决反转诅咒:在逆序诗词补全任务上超越GPT-4

这些成果都证明:扩散模型完全可以成为大语言模型的另一个可行选择。

值得期待的是,研究团队表示基础模型和推理代码将在两周内开源。

这或将给本就足够火热的AI 领域带来新的机遇和挑战!

相关资源

-

论文地址:arxiv.org/abs/2502.09992

-

项目主页:ml-gsai.github.io/LLaDA-demo

(文:AGI Hunt)