遗传算法、粒子群算法等作为经典的群体智能方法,自诞生以来便在优化问题领域得到广泛应用。然而,这类传统方法在大模型时代中是否仍然适用?上海人工智能实验室 OpenAGCI Team 联合东北大学数据挖掘实验室最近的研究成果重新证明了这类方法在大模型时代仍然拥有潜力。

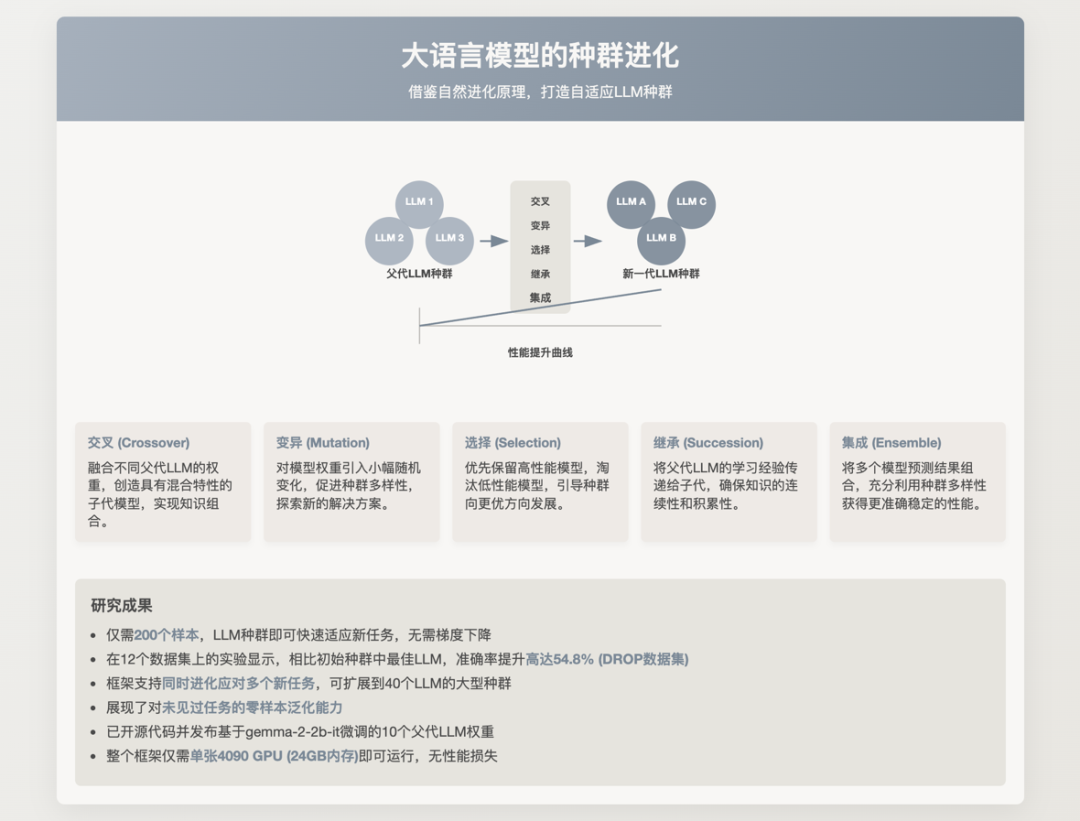

他们提出了名为 GENOME(+)的大语言模型优化框架,以创新性的视角系统地将进化算法引入到大语言模型的种群优化问题中,无需梯度优化,让大语言模型种群经过交叉、变异、选择、继承以及集成等经典进化操作,仅用极少的样本即可提高模型性能。

在涵盖了数学、推理、代码、常识问答以及情感分析的 12 个数据集的实验中,相较于现有的模型融合和优化算法,表现出稳定且明显的性能优势,最高性能提升达到 54.8%。目前已全面开源了相关代码和模型,使用单张 4090 显卡即可轻松运行该框架。

Nature-Inspired Population-Based Evolution of Large Language Models

https://github.com/ZhangYiqun018/GENOME

https://huggingface.co/Estwld/GENOME-gemma-2b-it

研究亮点

-

创新性框架:首次清晰定义了大语言模型群体进化问题,采用遗传算法的核心思想——模型权重为“基因”,性能表现为“适应度”,引入交叉(crossover)、变异(mutation)、选择(selection)、继承(succession)以及群体决策(ensemble)进化机制,实现模型群体动态优化;

-

无需梯度传播:完全摒弃了传统的梯度优化流程,每个新任务只需 200 个样本即可快速完成模型适应过程,大幅降低计算资源消耗与成本;

-

明显性能优势:在广泛的任务评测中(包括数学推理、逻辑推理、编程等领域共计 12 个数据集),GENOME 方法相较于现有模型融合和优化方法,表现出稳定且明显的性能优势,最高性能提升达到 54.8%;

-

泛化与扩展性:所提出的 GENOME+ 方法进一步通过群体决策(ensemble)机制提升泛化能力,成功实现跨任务泛化,零样本情况下性能平均提升 11.79%,并支持模型群体扩展至 40 个规模;

-

硬件需求低、开源共享:方法实现简单高效,在单个 24GB GPU 即可运行完整优化流程,代码和模型已全部开源,推动社区快速复现与后续创新。

研究背景与动机

近年来,大量经过专门微调的专家模型逐渐兴起,这些专家模型在特定任务中表现优异,但如何高效地融合并利用这些专家模型以适应多样的新任务仍然面临巨大挑战。

当前针对多个 LLM 的模型融合方法(如路由机制和参数融合)存在明显局限性:路由机制方法通常需要大量的监督数据且难以扩展到新专家模型;静态参数融合方法虽然不需额外数据,但依赖预定义规则,泛化性有限;动态参数融合方法往往聚焦于通过某个特定指标(比如准确率,困惑度等)将多个模型融合成一个多才多艺的模型,无法充分利用模型的群体智能。

另一方面,传统的进化算法(如遗传算法)虽被广泛应用于优化问题,但在大模型优化中由于收敛速度慢、参数空间过于庞大等原因逐渐被边缘化,未能充分发挥其潜在价值。

因此,上海 AI Lab 与东北大学的研究团队提出一种创新的视角:既然生物进化能够以高效的群体优化方式适应复杂且多变的环境,能否将这一进化机制引入到大语言模型的优化中,以解决现有方法存在的不足?

基于这种动机,他们提出了 GENOME(+)框架,期望通过群体进化快速高效地实现大语言模型群的优化和泛化。

GENOME(+)框架细节

-

初始化(Initialization):通过专家模型权重随机组合生成初始群体;

-

交叉(Crossover):融合父代模型权重产生新个体,增强群体多样性;

-

变异(Mutation):随机调整模型参数,持续探索优化潜力;

-

选择(Selection):根据模型表现选择性能更优的个体保留,提升整体性能;

-

继承(Succession):通过经验共享与最佳模型学习,提升群体整体质量;

-

群体决策(Ensemble):聚合多个最优模型输出结果,提高最终决策质量。

实验设置与详细结果

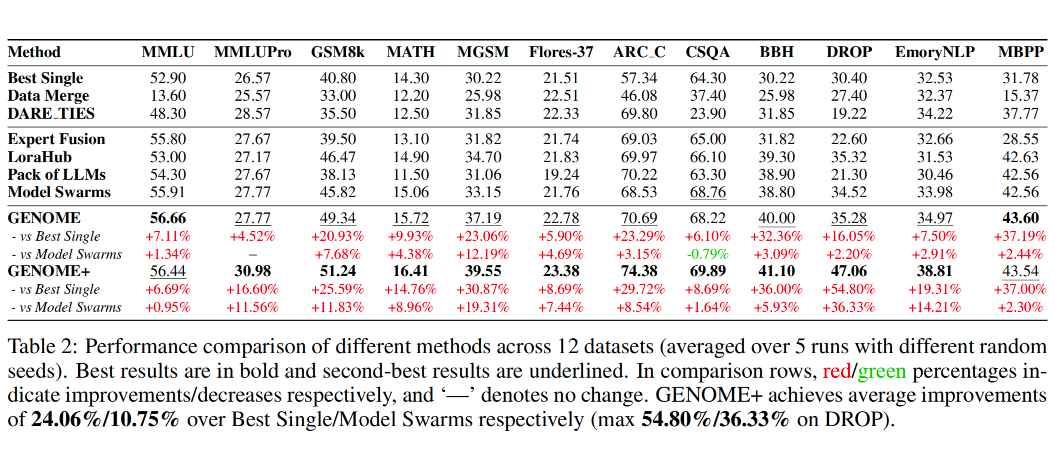

研究团队使用 gemma-2-2b-it 作为基础模型,针对 12 个涵盖数学、逻辑推理、编程、多语言处理和情感分析等领域的数据集展开详细实验。

4.1 单任务适应测试

研究团队在多个单任务数据集上评测了 GENOME(+)框架的表现。在 DROP 逻辑推理任务中,GENOME 方法相比现有方法性能提高了 54.8%。在 GSM8k 和 MATH 两个数学数据集中,GENOME 的性能平均提升达到 25.6%。

4.2 多任务同时适应测试

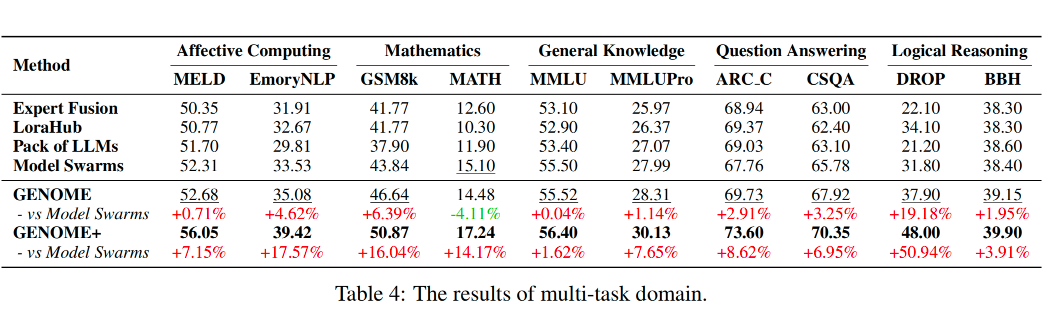

在同时针对逻辑推理(DROP、BBH)、数学推理(GSM8k、MATH)等的多任务优化中,GENOME(+)框架表现稳定,可以同时提升同领域的两个任务的性能。

4.3 零样本跨任务泛化测试

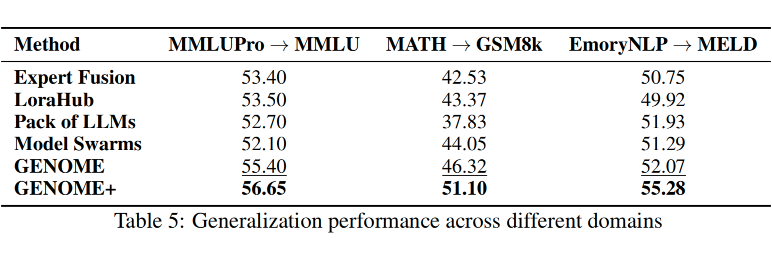

研究团队还评估了 GENOME+ 在未见任务上的泛化能力,例如先在 MMLUPro 任务适应,然后在 MMLU 任务上直接测试。

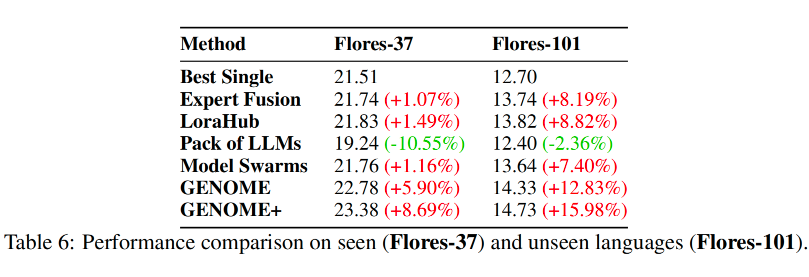

实验结果显示,GENOME+ 在这种零样本泛化任务上性能平均提升 11.79%,超过了其他现有方法。此外,GENOME(+)还能勾提升模型在未见语言上的表现,研究团队在 gemma2 模型未见语言的翻译任务上进行了实验,性能平均最高提升 15.98%。

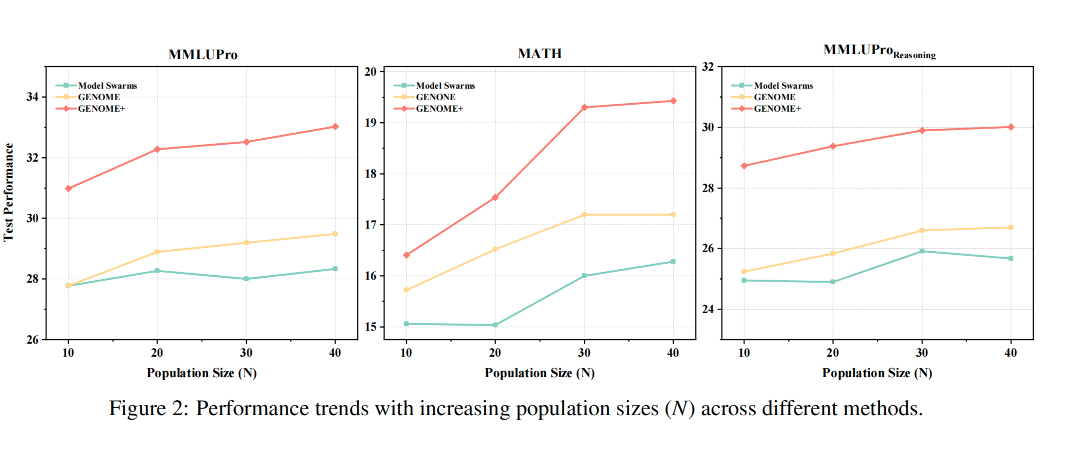

4.4 扩展性测试

研究人员分别测试了模型群体从 10 个扩展到 40 个的情况,GENOME+ 在这种扩展条件下依然保持稳定的性能优势,表现出良好的扩展性。

4.5 硬件适应性测试

在 NVIDIA RTX 4090(24GB)与 A100(80GB)显卡平台上进行性能测试。结果显示,在较低显存条件(24GB)下,虽然优化时间变长,但 GENOME(+)框架依然保持性能稳定。该实验证明 GENOME(+)在单个 24GB GPU 即可运行完整优化流程。

4.6 消融实验

研究团队进一步通过消融实验分别去除交叉、变异、选择、继承和群体决策等关键操作,分析每个进化机制的具体贡献。实验结果表明,每个操作对整体性能都有重要贡献,强调了框架中各进化机制的重要性。

(文:PaperWeekly)