在当今人工智能蓬勃发展的时代,大语言模型(LLM)如雨后春笋般涌现,它们在自然语言处理的各个领域大显身手,从文本生成到智能问答,从机器翻译到情感分析。然而,众多的模型也带来了新的挑战。不同厂商的模型API格式千差万别,开发人员在集成多种模型时,需要花费大量时间和精力去学习和适配不同的接口,这无疑增加了开发的复杂性与成本。litellm这一开源项目应运而生,它旨在为开发人员搭建一座统一的桥梁,跨越不同大语言模型API之间的鸿沟,让模型的调用变得轻松而高效。

一、项目概述

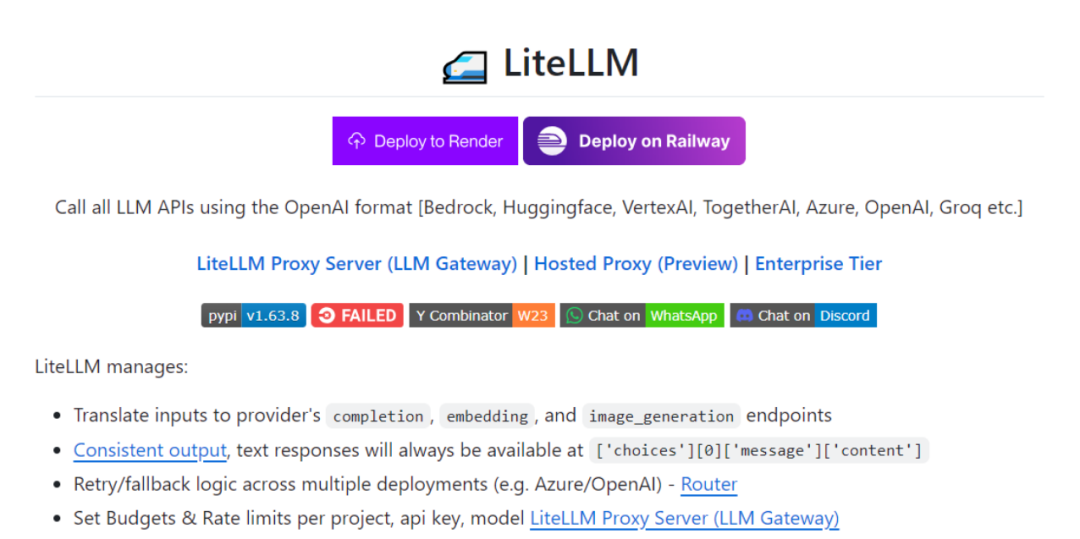

litellm是由BerriAI团队精心打造的一款开源的LLM调用框架。其核心使命是解决在大语言模型应用开发中,因调用不同厂商模型API所面临的格式不一致难题。通过创新的设计,litellm实现用统一的OpenAI格式来调用超过100种不同的大语言模型,这其中涵盖了Bedrock、Azure、OpenAI、Cohere、Anthropic、Ollama、Sagemaker、HuggingFace、Replicate等众多知名厂商的模型 。这种统一的调用方式,极大地简化了开发流程,开发人员无需再为每种模型单独编写适配代码,大大提升了开发效率。

二、核心功能

(一)统一输入输出格式

litellm以OpenAI的API格式作为标准,对所有支持的大语言模型进行统一封装。开发人员在调用不同模型时,只需按照OpenAI格式构建请求,无需关心每个模型独特的输入要求。在生成文本时,无论是调用OpenAI的GPT – 3.5 – Turbo,还是Anthropic的Claude,请求格式都保持一致。在响应方面,litellm也确保所有模型的文本响应以统一、易于访问的格式呈现。

(二)自动请求转换

当开发人员发送基于统一OpenAI格式的请求后,litellm会在幕后自动将其转换为各个厂商模型API所需要的特定格式。这一过程对开发人员完全透明,他们无需了解每个模型API的细节。可以用一套代码轻松适配多种模型。

(三)多模型间故障转移和负载均衡

在实际应用中,模型可能会出现故障、维护或因高并发导致响应缓慢的情况。litellm提供了强大的故障转移和负载均衡功能。

-

故障转移:开发人员可以设置多个模型作为备用选项。当主模型出现错误时,litellm会自动尝试使用备用模型来处理请求,确保服务的连续性。

-

负载均衡:litellm支持先进的路由策略,如“least – busy”策略。该策略会实时跟踪每个模型当前处理的请求数量,当有新请求到来时,将其分配给当前处理请求最少的模型,从而实现负载的均衡分布,提高整体系统的性能和响应速度。

(四)花费追踪与预算控制

使用多种大语言模型往往伴随着成本问题,尤其是对于企业用户而言,控制成本至关重要。litellm提供了全面的花费追踪和预算控制功能。

-

花费追踪:通过内置的追踪机制,litellm可以详细记录每次模型调用的费用,包括使用的令牌数量、单价等信息,让用户清楚了解每一次操作的成本。

-

预算控制:用户可以为每个项目、API密钥或模型设置预算限制,当使用量接近或超出预算时,litellm可以发出警报或自动停止相关请求,帮助用户有效管理成本,避免不必要的费用支出。

(五)日志监控与可观测性

litellm支持与主流的日志监控和可观测性平台集成,如Lunary、Langfuse、Helicone等。通过简单的配置,litellm能够记录模型调用的详细信息,包括请求参数、响应结果、调用时间、响应时间、错误信息等。这些日志数据对于开发人员进行故障排查、性能优化以及了解系统运行状况非常有帮助。

三、优势特点

(一)开发效率大幅提升

一套代码即可调用所有支持的模型,开发人员无需为不同模型编写不同的接口代码。在开发一个智能客服系统时,原本可能需要为不同模型分别编写适配代码,现在借助litellm,只需要按照统一格式编写一次代码,就可以轻松切换使用不同的模型,极大地缩短了开发周期。并且,异常处理也统一采用OpenAI的格式,使得错误处理逻辑更加一致和简洁,进一步提升了开发效率。

(二)运维管理更加便捷

-

自动重试和故障转移:减少了因模型故障导致的服务中断风险,确保系统的高可用性。

-

完整的监控和日志:让运维人员能够实时了解系统运行状态,快速定位和解决问题。

-

细粒度的成本控制:使得企业可以更好地管理资源和预算,优化成本结构。通过litellm代理服务,企业还可以统一管理多个模型的访问,设置访问控制和速率限制,保障系统的安全性和稳定性。

(三)功能丰富且灵活

-

流式输出支持:litellm支持流式输出,这在一些对实时性要求较高的场景,如聊天机器人中非常实用,用户可以在模型生成文本的同时逐步接收并展示内容,提升交互体验。

-

自定义回调:提供自定义回调功能,开发人员可以根据自己的需求,在模型调用的不同阶段插入自定义代码逻辑,实现更灵活的业务需求。

-

可观测性平台支持:litellm还支持主流的可观测性平台,方便与企业现有的监控和管理体系集成,增强系统的可管理性和可扩展性。

四、应用场景

(一)应用开发领域

在各类应用开发中,无论是Web应用、移动应用还是桌面应用,都可能需要集成大语言模型来实现智能功能。在应用开发过程中,如果需要测试不同模型对应用性能和功能的影响,使用litellm可以快速切换模型,而无需对大量代码进行修改,大大提高了开发和测试效率。

(二)企业服务场景

对于企业来说,litellm具有广泛的应用价值:

-

客户服务:企业可以使用litellm集成多个模型来构建智能客服系统,通过负载均衡将客户咨询请求分配到不同模型进行处理,提高响应速度和服务质量。

-

数据分析与处理:企业可以利用litellm调用不同模型对大量文本数据进行分析,如情感分析、主题分类等,并且通过花费追踪和预算控制功能,合理控制成本。

-

数字化转型:企业在进行数字化转型过程中,可能需要将不同的业务流程与大语言模型相结合,litellm可以作为统一的模型调用接口,简化系统架构,提高开发和部署效率。

(三)科研探索场景

科研人员在进行自然语言处理相关研究时,往往需要对比和测试多种大语言模型,以寻找最适合特定研究任务的模型或组合。litellm为科研人员提供了便利,他们可以通过统一接口快速调用不同模型进行实验,减少了因模型接口不同带来的操作复杂性。在研究新型文本生成算法时,科研人员可以利用litellm轻松切换不同的基础模型进行实验,观察不同模型对算法效果的影响,加速研究进程,提高研究效率。

五、快速使用

(一)安装

litellm的安装非常简便,使用pip包管理器即可完成安装。在命令行中输入以下命令:

pip install litellm安装过程中,pip会自动下载并安装litellm及其依赖库。安装完成后,就可以在Python项目中引入并使用litellm了。

(二)基础调用示例

下面通过一个简单的代码示例来展示如何使用litellm进行模型调用。假设我们要使用GPT – 3.5 – Turbo模型生成一段文本:

from litellm import completionimport os# 设置api密钥,这里以OpenAI的API密钥为例os.environ["openai_api_key"] = "your_openai_api_key"# 调用模型response = completion(model="gpt-3.5-turbo",messages=[{"content": "请介绍一下人工智能在医疗领域的应用", "role": "user"}])print(response.choices[0].message.content)

在上述代码中,首先导入了litellm的completion函数,然后设置了OpenAI的API密钥(实际使用时需替换为真实密钥)。接着,通过completion函数调用GPT – 3.5 – Turbo模型,传入包含用户问题的消息列表。模型返回的响应中,我们提取并打印生成的文本内容。

(三)使用代理服务器

如果以团队形式使用,并且希望搭建中心化的LLM网关来统一管理多个模型的访问,可以使用litellm的代理服务器功能。

1. 启动代理服务器:首先,启动代理服务器,例如要使用Hugging Face的模型:

litellm --model huggingface/bigcode/starcoder启动成功后,代理服务器会监听特定端口(默认为4000)。

2. 代码调用设置:然后,在代码中使用OpenAI客户端调用时,设置好api_key(这里可以设置为任意值,因为代理服务器不依赖此密钥验证)和base_url为代理服务器的地址:

import openaiclient = openai.OpenAI(api_key="anything",base_url="http://0.0.0.0:4000")response = client.chat.completions.create(model="huggingface/bigcode/starcoder",messages=[{"content": "写一个简单的Python函数", "role": "user"}])print(response.choices[0].message.content)

通过这种方式,团队可以方便地统一管理模型访问、追踪使用量和成本,并设置访问控制和速率限制等。

六、结语

litellm作为一款创新的大语言模型调用框架,为开发人员、企业和科研人员等带来了诸多便利。它有效解决了多模型调用的复杂性问题,显著提升了开发效率,优化了运维管理,拓展了大语言模型在不同场景下的应用。无论是个人开发者快速构建AI应用,还是企业大规模集成和管理多种模型,litellm都能成为得力助手。

七、相关资源

GitHub仓库:https://github.com/BerriAI/litellm

官方文档:https://docs.litellm.ai/

(文:小兵的AI视界)